在《如何制造一个垂直领域大模型》一文中我们列举了几种开发垂直领域模型的方法。其中医疗、法律等专业是比较能体现模型垂直行业能力的,因此也深受各大厂商的重视。

五一小长假的第一天,Google在Arxiv上发布了《Capabilities of Gemini Models in Medicine 》 ( https://arxiv.org/abs/2404.18416 ) 的论文。说明了微调Gemini模型在医学领域获得多项任务SoTA的成果和方法。论文全文长达58页,作者有30多号人,引用的文献列了10页。让人觉得是个大手笔之作,难免想一探究竟。一些新闻稿更是冠以《医疗AI的一大步》《Med-Gemini :医学大模型里程碑之作,Google今天发布,医学航母正式起航》等等标题。

受此吸引,花了一天时间认真读了论文。读完之后有些失落,总体感觉上是花了很多力气,具体的成果是为了体现Gemini模型自身能力而做的Demo。这时候才理解了论文题目的真正意思 。Capabilities of Gemini Models in Medicine ,注意Capabilities和Models是复数形式,主要研究的是Gemini这一系列模型在医学上的各种能力,并非是训练出了一个在医疗领域专门的模型。另外,可能是Google在开源方面吃亏吃得比较多,这个项目本身没有开源。不过不重要了,思路是比较关键的。

下面是对这篇论文的解读。水平所限,只能尽力而为。

论文的大体意思是这样的,如果AI想要医学应用中能够表现好,有几个方面的关键能力:

长上下文能力,因为医学诊断要看很多病史数据,因此长文本很关键

恰好, Goolge的Gemini某些模型的长文本(Long Context)和多模态能力很不错,所以这个团队就利用这些基础能力,加上一些微调和Agent技术,开发了一系列针对医学领域应用的模型,统称为Med-Gemini。它的能力特点就是上面提到了几条,推理、多模态和长文本/网络检索能力。

这些能力是怎么得到检验的呢,目前有各种针对医学模型的评测(比如参加医生资格考试),Med-Gemini在14个医学基准测试中,有10个基准测试中达到了SoTA,并在每个可以直接比较的基准测试中超过了GPT-4模型家族,而且强调差的不是一点半点,通常领先好几个身位。

除了评测,Med-Gemini的还在医学文本总结和转诊信生成等任务中超越人类专家。(感觉这好像没啥值得一提的啊,换任何一个模型来都可以做到)。

重点需要说明的是, Med-Gemini不是一个模型,是一系列的模型。也就是说,不是在一个模型里实现了既有高级推理能力,又有多模态能力,而是在不同的模型里做到的。不过,正如我们在《如何制造一个垂直领域大模型》里讲过的,是不是一个模型也没那么关键,需要的是一个垂直系统,不是一个垂直模型。

那么是提升基础Gemini模型的能力,让它在医学领域的推理、多模态和长文本能力得到增强呢?不同的方面用了不同的方法:

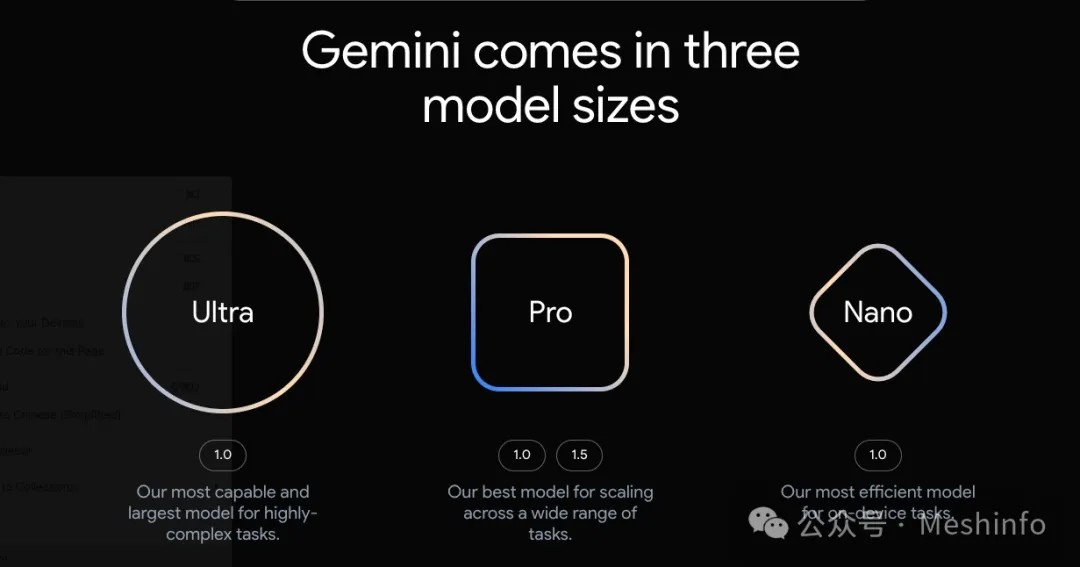

因为所有的工作都是基于Google的Gemini基础模型之上的,因此先看看Gemini的模型列表。Gemini模型有1.0和1.5两个版本,每一个版本的模型里根据参数量的不同又分为Ultra,Pro和Nano三个档次,但是目前1.5还只有Pro版本。另外Nano是面向移动设备的。

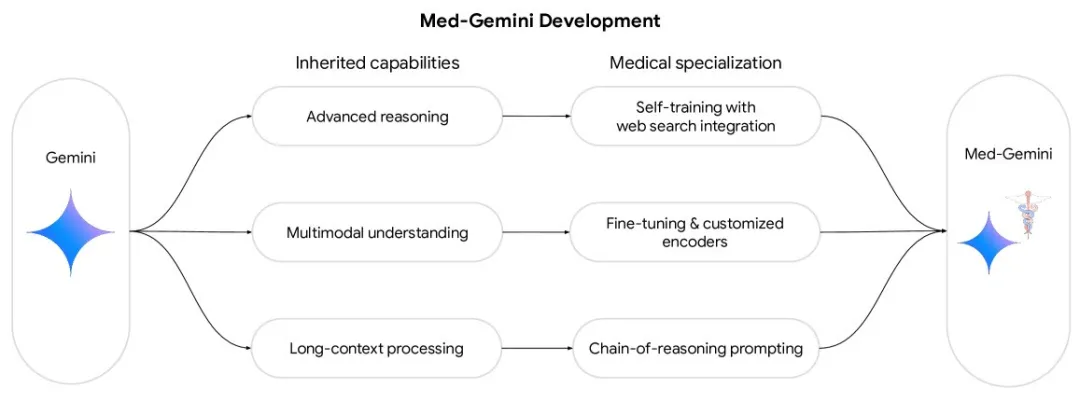

下面是论文中的原图,说明了Med-Gemini是在Gemini模型的基础上,分别通过不同的技术手段增强了高级推理能力,多模态和长上下文处理能力而得到的。

但是图上没有说明的是,其实是分别对好几个不同的模型进行了微调,根据文中描述,Med-Gemini和Gemini的对应关系如下:

前面提过,其实多模态和长上下文部分没什么特别的东西,有点价值的地方就是第2条,如何把Gemini 1.0 Ultra 训练到Med-Gemini-L 1.0。

把Gemini 1.0 Ultra训练成为Med-Gemini-L 1.0的方法被作者称为Advanced reasoning via self-training and web search integration (通过自训练及Web搜索的高级推理)。

这里解释一下自训练,自训练是一个种模型的训练方法,主要用于在标注数据比较少的情况。

假设我们想要训练一个模型来识别猫和狗的图片,但是我们只有少量的标注数据(例如,1000张标注过的猫和狗的图片)。我们希望模型能够泛化到更多的数据上,但是我们没有足够的资源来手动标注更多的图片。

自训练的过程有点武侠小说里左右脚互相踩,然后飞到高处的意思。过程如下:

在论文中就采用这种方法来解决医学领域数据较少的问题。

训练目标是增强基础模型在医学领域的推理能力,同时还需要能够在必要时通过网络搜索信息来支持自己的判断(实验中应该是指定了搜索的专业网站)。

因为临床诊断需要大量的复杂的推理过程,医生可能会对许多不同的输入进行推理,例如患者症状、医疗和活动史、实验室诊断、先前对治疗的反应以及其他更广泛的因素,例如流行病学数据。同时由于医学知识不断更新,理想情况下,医学大模型不仅需要具有强大的推理能力,而且还能够整合最新信息,例如来自权威网络的信息。

其实现在模型利用搜索工具已经没什么特别的了,大量的模型都能够集成搜索工具,关键是让模型准确的模仿医生的决策过程,知道什么时候该去搜索,搜索之后如何使用搜到的信息来支持决策。这需要进行微调。

如果需要微调训练就需要准备数据,最好是医生针对病例诊断的思考过程,但是收集这些数据非常困难。医生平时写个病历都是用画符的方式,更别提让他/她来告诉你诊断是怎么下的了。而且训练大模型需要大量的数据,因此训练数据的收集是比较困难的过程。

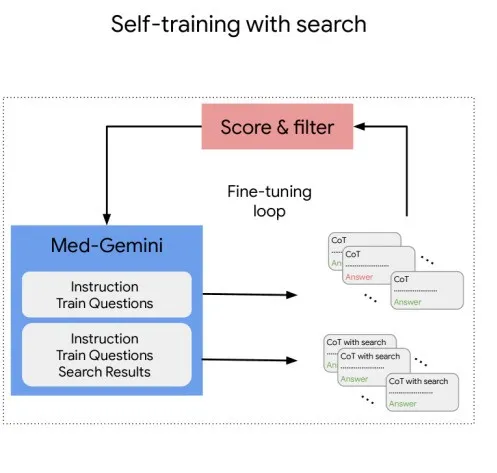

作者利用MedQA数据集进行了扩展,这个数据集里是一些医生资格考试的选择题。先让一些专家针对数据集里的问题写下自己推理的过程和依据,然后利用这些数据作为示例(应该就是few shot prompt),让模型模仿着去做题,并且要求它把推理过程写下来,如果选择题做错了,那么就把数据过滤掉,如果做对了就保留推理过程。这样就得到了大量可以用于训练的数据。

在生成数据的过程中,会提示模型生成两种数据,一种是不利用搜索,一种是利用搜索,两种方法得到了两种数据集MedQA-R 和 MedQA-RS。你可能会疑惑为什么要生成两种数据类型,没关系,到后面就明白了。

在生成的数据上微调Med-Gemini-L 1.0之后,模型遵循few shot prompt中的推理风格和搜索整合的能力得到提升。然后,使用改进的模型重新生成新的合成数据,并迭代重复这个自训练过程,直到模型的性能达到饱和。

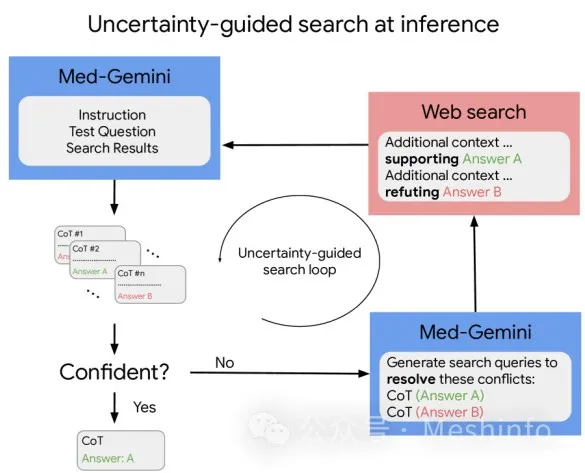

在推理过程中,作者用了一种叫Uncertainty-guided search at inference (不确定性引导搜索的推理)的方法来让模型决定什么时候应该去搜索网络内容来支持推理。

推理过程分成四个步骤:

到这里可能你就明白为什么要生成两种推理数据里,第一次推理的时候是不用外部搜索引擎的数据的,只有生成的答案不确定性比较高的时候,才会补充进搜索引擎的额外信息,这时候就需要综合搜索引擎的信息进行推理了。

这种方法是不是有效需要通过测试来决定,至少在论文里,去刷MedQA和其他题目还是挺有效的,达到了SoTA。

其他多模态和长上下文的部分就不解释了。说一说对这篇论文的看法。

论文主要是Google为了展现Gemini模型的一些能力,从实际医学应用上面来看意义不是那么大,至少个人是这么感觉的。但是对于想要自己做垂直大模型的企业来说,还是可以有一些可以参考的地方。

总体来看,这篇文章学术意义有限,绝对不是很多营销号上吹得什么了不得的突破,但是有一定的实际参考意义。

本文来自微信公众号”Meshinfo“

【免费】cursor-auto-free是一个能够让你无限免费使用cursor的项目。该项目通过cloudflare进行托管实现,请参考教程进行配置。

视频教程:https://www.bilibili.com/video/BV1WTKge6E7u/

项目地址:https://github.com/chengazhen/cursor-auto-free?tab=readme-ov-file

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0