挤爆了,简直要被大模型公司们给挤爆了。

来感受一下这个feel:

毫不夸张地说,国内外叫得上来的大模型公司基本上都来了——

Anthropic、Meta、Mistral.AI、Stability.ai、月之暗面、智谱AI、百川、MiniMax……

到底是什么样的事情能让它们纷纷聚集到了一起?

不卖关子,这正是“云计算一哥”亚马逊云科技所举办的中国峰会,整场活动的关键词就是大热的生成式AI。

不过有一说一,自打AIGC大战开局以来,全球科技巨头如谷歌、微软、OpenAI等一直呈现出你追我赶的态势。

而亚马逊云科技的“出镜率”似乎并没有它们那么高,但这场活动又为何会引来如此多的厂商和围观群众?

其实在深入了解和体验一番之后,我们不难发现,亚马逊云科技在AIGC这件事上已然是“全栈+全能”的状态了。

之所以说是全栈,是因为亚马逊云科技的能力已经覆盖到了生成式AI最为关键的三大层面,即:

至于能力如何,我们直接来看下最为直观的效果。

在生成式AI应用方面,亚马逊云科技面向企业和开发人员所推出的是生成式AI助手——Amazon Q。

它相当于给企业配备了一个量身定制的AI专家,可以根据企业既有的人员、角色和权限对每个用户交互进行个性化的定制。

例如用上Amazon Q Developer(开发者版),编程这件事就只需简单的“点点点”和“提要求”。

以功能开发和代码转换为例,开发者只需要向Amazon Q描述想要的新功能即可,然后它就能自己进行规划、执行和迭代:

而且Amazon Q还会根据任务的内容,动态地分配最合适的大模型,让性能做到Pro Max。

再如Amazon Q Business(企业版),同样也是只需要简单的语言输入,就能帮助员工简化任务、加速决策。

例如员工可以根据公司已有但分散的数据信息,让Amazon Q来做整理和分析的工作,从而给员工答疑解惑、增加工作效率:

诸如整合分析、撰写报告和制作PPT文稿等工作也是不在话下:

除此之外,亚马逊云科技为了让提高效率这事更上一层楼,还推出了Amazon Q Apps,它是Amazon Q Business中的一项功能,可以让员工能够迅速且安全的基于企业信息创建、分享应用程序。

而且Amazon Q Apps是无需任何编程经验、可以基于历史对话、自动化的那种。

例如一个HR如果要创建一个新人的入职30天计划,就只需要向Amazon Q Apps“喂”员工姓名和工号即可。

而整个过程,也只需要短短几秒钟的时间!

在数据分析处理方面,亚马逊云科技则是将Amazon Q集成到了QuickSight中。

以往生成一个商业智能仪表盘可能需要数个小时的时间,但现在,几分钟就可以搞定了。

而且所有员工都可以根据这样可视化的数据内容,向Amazon Q提出自己的问题,让复杂的数据分析任务变得简单且高效。

总而言之,纵观Amazon Q的效果和能力,亚马逊云科技主打的就是用生成式AI的力量把繁琐复杂的工作任务变得简单,简单,再简单。

但Amazon Q之所以能在企业场景做到如此方方面面且丝滑,离不开背后大模型的能力。

亚马逊云科技的大模型能力对外输出,主要依靠处于模型层的Amazon Bedrock。

它是亚马逊云科技正式加入大模型浪潮竞争的标志,也是亚马逊云科技和微软OpenAI正面硬刚的关键。

基于Bedrock打造的生成式AI应用,已经多达数十种,让人看得眼花缭乱。

简单理解,Bedrock是一个集成了多种先进AI大模型的平台,只需单个API,就可以提供包括Claude、Mistral、Llama、Stable Diffusion、自研Titan系列在内30个模型的能力。通过提供预训练、微调、知识库、RAG、模型评估等功能,能够灵活定制大模型或应用。

亚马逊全球副总裁、亚马逊云科技大中华区总裁储瑞松在峰会上表示,亚马逊云科技一直认为“不会有一个模型一统天下”,企业有从多个大模型中做选择的权力。

因此,在Bedrock上被放置了数十个业界领先的大模型供企业选择。包括和GPT-4并驾齐驱的Claude 3、主打开源的Llama系列和Mistral AI、以及图像生成方面的Stable Diffusion。

同时还包括亚马逊云科技自研的Titan系列,目前已陆续推出7个模型,能力范围包括文本摘要检索生成、图像生成、RAG、思维链、问答、搜索、个性化、推荐等。

具体能力上,Bedrock重点关注4个方面:

最首要的,构建生成式AI应用关键的一步是找到合适的模型。

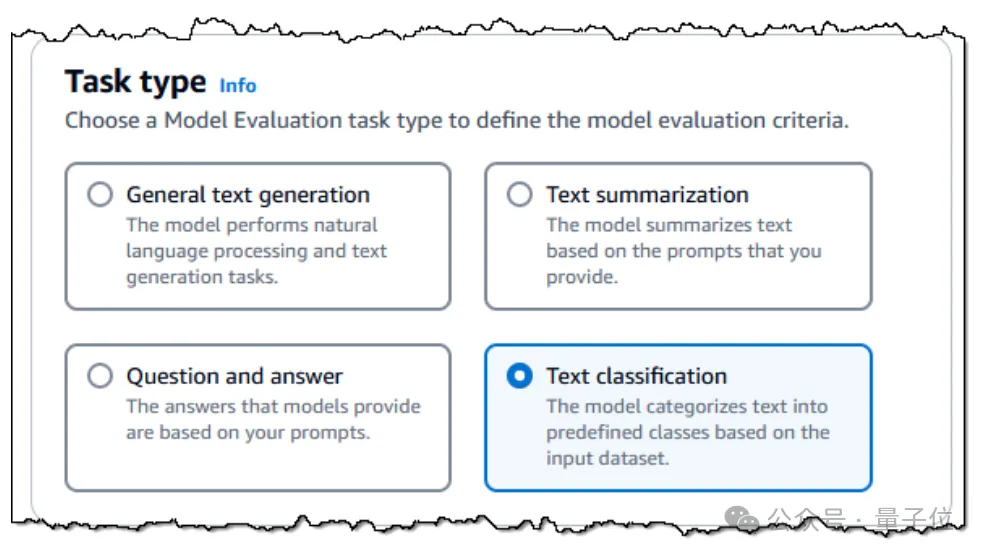

Bedrock提供了业内最广泛的模型选择,并推出Model Evaluation功能,支持企业快速分析和比较不同模型。

一般需要企业先给出评估标准,比如对准确性、鲁棒性的要求,并上传自有数据集/提示词库,或者从Bedrock内置的、公开可用的资源中选择。一些主观或需要细致判断的的评判内容,平台会引入人工审核,根据特定应用场景的指标进行评估。

完成设置后,Bedrock便可开始评估并生成报告,最短仅需几个小时,企业就能找到适合自己的模型。

在选择好模型后,企业可利用专有数据,通过RAG、提示词工程或微调来定制对应大模型功能,以创建私有模型。

比如针对Command R、Llama 3、Titan Text Lite等模型,只需简单几步即可进行微调。如果选择了Titan Text模型,还能对未标记的数据持续预训练,以更适应对应行业和领域。

Bedrock知识库可自动执行完整的RAG工作流程,包括摄取、检索、提示词增强和引用。

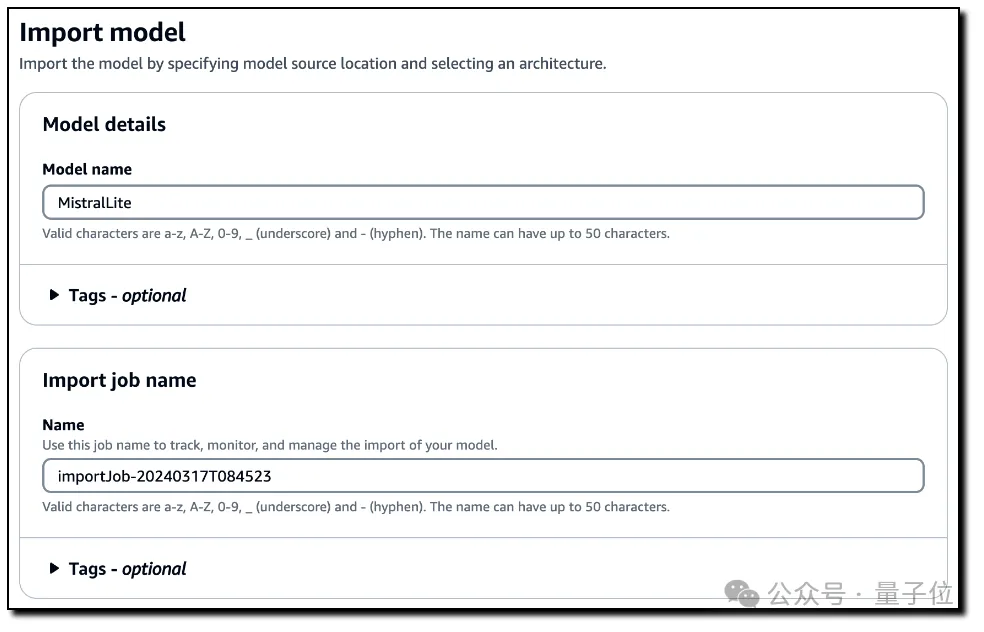

同时,Bedrock还推出了自定义模型导入(Custom Model Import)功能。企业现在能将自己定制模型导入到Bedrock中,以完全托管的API形式进行访问。由此,自定义模型可以方便地被集成到现有应用程序和工作流中,并同样得到隐私安全保护。

目前Bedrock专有模型导入功能已推出预览版并支持Flan-T5、Llama和Mistral三种开放模型架构。

模型推理方面,Bedrock Batch支持有效执行大量数据的模型推理任务,可在大规模推理任务中避免限流问题,无需编写代码即可处理故障并重启,适用于基础模型及用户自定义模型。

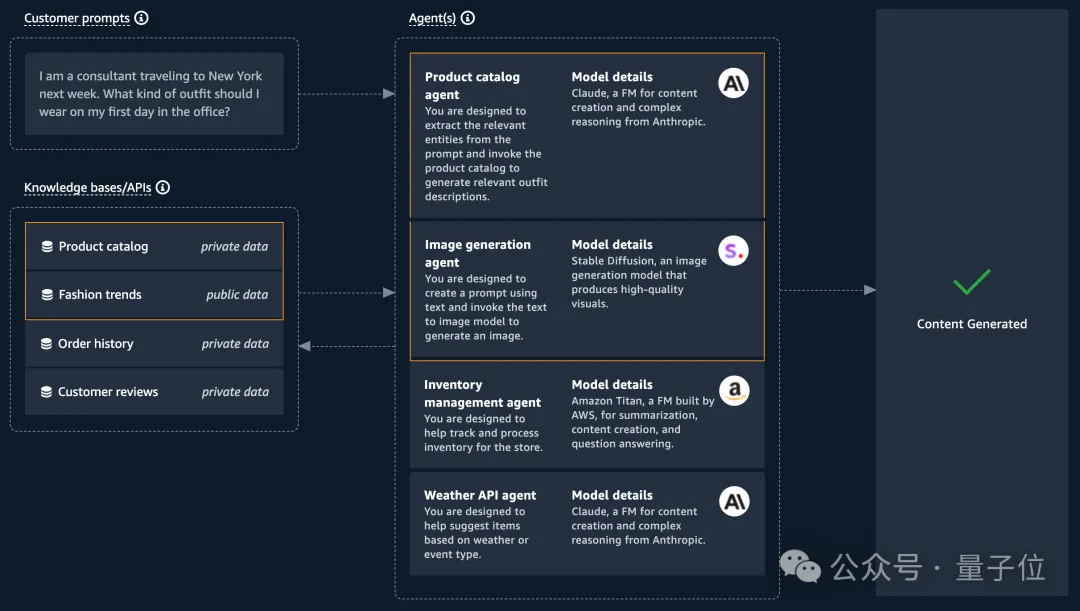

AI应用层面,Bedrock Agents功能支持构建基于企业系统和数据来执行任务的Agent。使生成式AI应用能够使用自然语言来执行多步骤的业务任务。

包括利用LLM使用自然语言进行交互和相应;任务拆分和编排;通过动态调用API完成任务执行;追踪基础大模型思维链流程并优化底层Agent的提示工程。

比如使用Bedrock构建一个AI造型师,效果大概会是酱婶儿的。

最后在安全隐私保障方面。Bedrock的Guardrails功能在基础模型的原生能力之上提供了安全保护,可阻挡85%有害内容。

企业只需通过自然语言来定义不予显示的内容,就能快速创建一个Guardrail。同时还可设置阈值以过滤带有仇恨羞辱、暴力、攻击性等内容,并移除任何个人信息和敏感信息。

这一功能可用于Bedrock上的所有大模型,并且能与微调、Agent功能结合使用。

总结来看,Bedrock以企业定制大模型为出发点,提供模型选择、定制、应用开发、安全保障等一系列功能,使各行各业能更加简单方便用上大模型。

在正式推出1年之后,Bedrock为亚马逊云科技带来的增长和影响已经在具体数据直观体现:

亚马逊2024年第一季度财报显示,亚马逊云科技收入连续两季度加速增长,运营利润率创下历史新高,达到37.6%。

为啥能增长如此迅速?亚马逊云科技的最强基本盘——算力基础设施,为其提供了最关键的保障。

基础设施一直都是亚马逊云科技的强项。

2023年第四季度数据显示,亚马逊云科技依旧是“云市场一哥”,拥有全球31%市场份额。

全球1000家独角兽中,超过80%都使用亚马逊云。目前亚马逊云科技的年化收入已经超过1000亿美元,并且还在以17%的增长率增长。

在前大模型时代,亚马逊云科技构建了服务全球245个国家和地区的基础设施建设、超过200大类的云服务,过去十余年中已服务全球数百万客户。

其底层算力构成主要由两部分构成,可以为企业提供高性能、高性价比、低功耗的算力选择:

一方面,亚马逊云科技和英伟达的合作已经长达13年,二者保持长期的战略合作关系,曾共同推出了世界上第一个GPU Cloud实例。

在披露的最新进展中,亚马逊云科技将推出基于英伟达最新一代Blackwell架构GPU的Amazon EC2(Amazon Elastic Compute Cloud),以加速构建及运行数万亿参数大模型的性能。

同时将提供首款搭载英伟达Grace Hopper超级芯片的云AI超级计算机,以及首款采用英伟达GH200 NVL32的NVIDIA DGX Cloud。

另一方面,在算力瓶颈愈加明显的环境下,亚马逊在很早期便开始自研芯片。

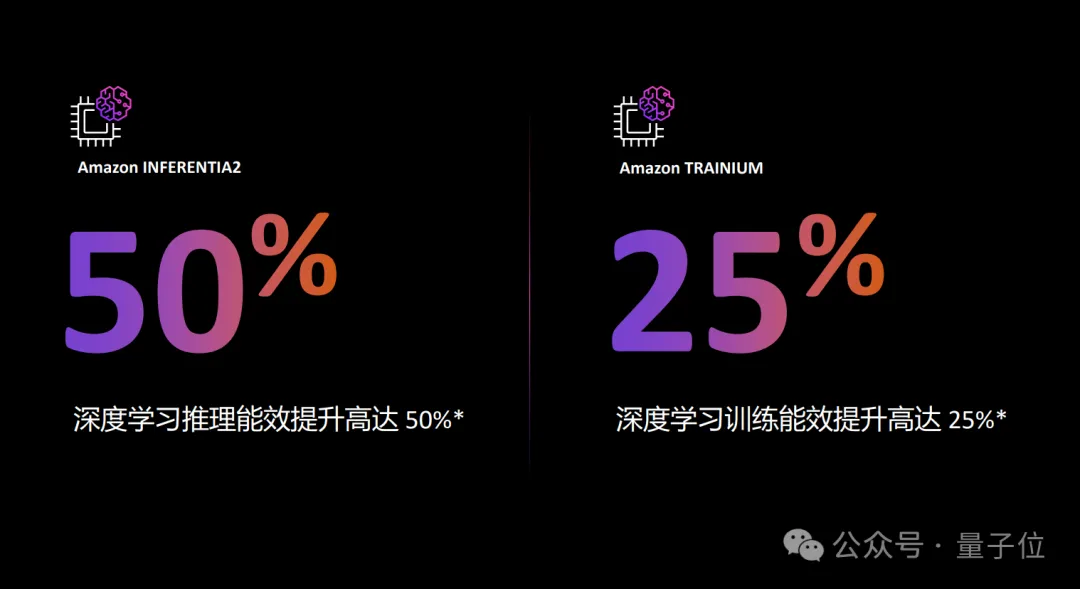

2019年亚马逊云科技推出了高性能机器学习推理芯片Inferentia,2020年底又推出了定制机器学习训练芯片Trainium。

目前最新一代用于AI训练的Trainium 2可支持千亿、万亿级参数大模型训练。与上一代相比,其训练性能提高4倍,能效功耗比提高2倍,内存增加3倍。

一个Amazon EC2可部署多达16个Trainium 2,相较于部署同类芯片的EC2,部署Trainium 2的可节省50%训练成本。

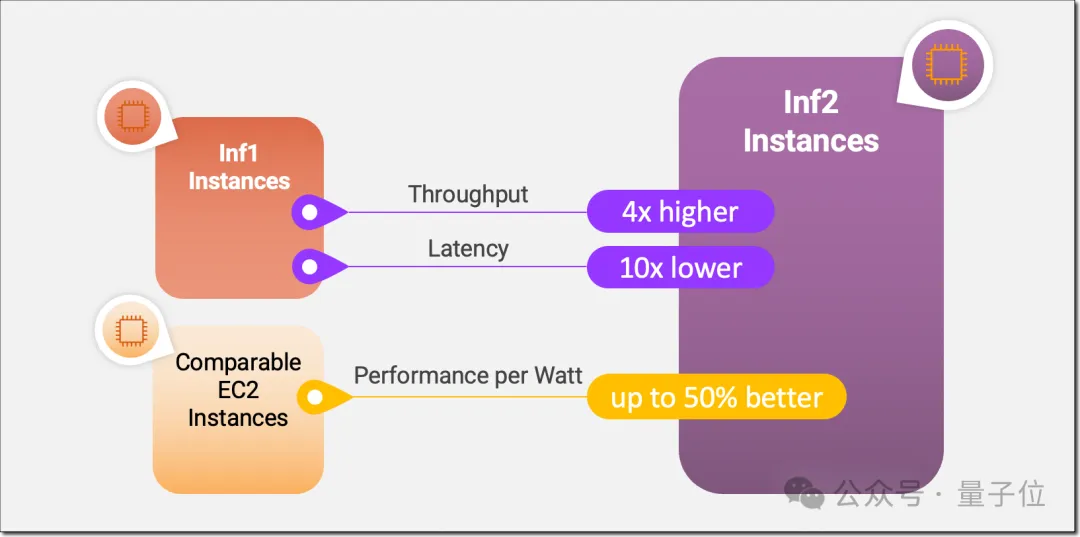

用于AI推理的Inferentia 2专门针对千亿参数大模型进行优化,与上一代相比,计算性能提高3倍,内存扩大4倍,吞吐量提高了4倍,延迟降低至1/10,并可支持大模型分布推理。

Inferentia 2是Amazon EC2中首个推理优化实例,可通过加速器之间的超高速链接支持横向扩展分布式推理。

搭配SageMaker Hyperpod和SageMaker Jumpstart, 可进一步加速基础模型推理与训练。

前者可简化大模型基础训练的过程,后者则提供了一个机器学习中心,通过提供一系列基础模型,让用户无需自己从头构建和训练模型,进行快速训练和部署。

现在亚马逊云科技还在不断拓展中国区域SageMaker Jumpstart中的基础模型种类,引入领先的中文基础模型。亚马逊云科技在中国峰会2024上宣布,由百川智能提供的基础模型Baichuan2-7B即将登陆中国区域SageMaker JumpStart,由零一万物提供的基础模型Yi-1.5 6B/9B/34B正式登陆中国区域SageMaker JumpStart,在为中国企业提供丰富模型选择的同时满足了企业对安全合规、快速扩展、免运维的需求。

作为首批登陆中国区域SageMaker JumpStart的中文基础模型,Baichuan2和Yi-1.5与亚马逊云科技托管服务深度集成,助力中国企业应用一流的生成式AI技术实现本土创新与业务转型。

如上多个方面,共同构成了亚马逊云科技的底层算力建设,更为其生成式AI全栈架构提供扎实底座。

在生成式AI大潮下,亚马逊云科技提出,未来真正能创造最大价值的将是生成式 AI 的行业应用。如金山办公、沐瞳科技、涂鸦智能、礼来科技等拥抱大模型的厂商都选择与亚马逊云科技合作。

其中,礼来制药是一家全球跨国药企。去年开始,他们重点布局打造以生成式AI为核心的AI基础能力。基于亚马逊云科技提供的生成式AI云服务,他们快速打造了员工聊天问答机器人、医学文献引用验证、竞品及市场推广分析、基于医学内容的FAQ生成。

实际上,这也是亚马逊云科技一直以来强调的路线与理念。

他们提出,企业应用是行业应用未被泛化的一个个实例。

而亚马逊云科技当下要做的,就是成为企业构建和应用生成式AI的首选,以推动各个行业真正意义上拥抱生成式AI大潮。

从宏大远景到具体行动,亚马逊云科技的生成式AI战略已然全盘托出。

那么当下,也就到了重新审视亚马逊云科技的时刻。

首先,不论是大模型时代的当下还是此前的传统AI时代,一切的一切都绕不开算力这个核心关键点。

而亚马逊云科技早早发力于云计算领域,已然在全球范围内处于公认的“云计算一哥”的位置。

加之与英伟达的密切合作,亚马逊云科技无疑是在Scaling Law为主旋律的当下妥妥的算力大玩家。

其次,在模型层面上的战略,亚马逊云科技走的是一条“集大成者”的路线——当下每个大模型都各自擅长的能力,将它们集成到一起,方便客户选用。

也正如储瑞松在这次Keynote中所述:

大模型已不再是企业生成式AI创新的唯一要素;企业在确定生成式AI场景之后,需要根据自身的要求选择合适的大模型。

不同的模型在应用过程中所擅长的领域是不同的,要最大发挥生成式AI的能力,需要将它们结合起来产生复合效应,从而提高系统整体的智力水平。

正是基于这样的一个思路,在更上层的应用方面,诸如Amazon Q这样的应用才能做到“多、快、好、省”地上岗诸多领域。

而这也是符合当下“应用为王”的大趋势。

总而言之,有算力、有模型、有应用、有市场,亚马逊云科技绝对是AIGC时代不容小觑的巨头之一。

文章来自于微信公众号量子位,作者金磊 明敏

【开源免费】paperai是一个可以快速通过关键词搜索到真实文献并将其应用到论文写作当用的功能。

项目地址:https://github.com/14790897/paper-ai

在线使用:www.paperai.life

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0