DiT 都能用,生成视频无质量损失,也不需要训练。

实时 AI 视频生成来了!

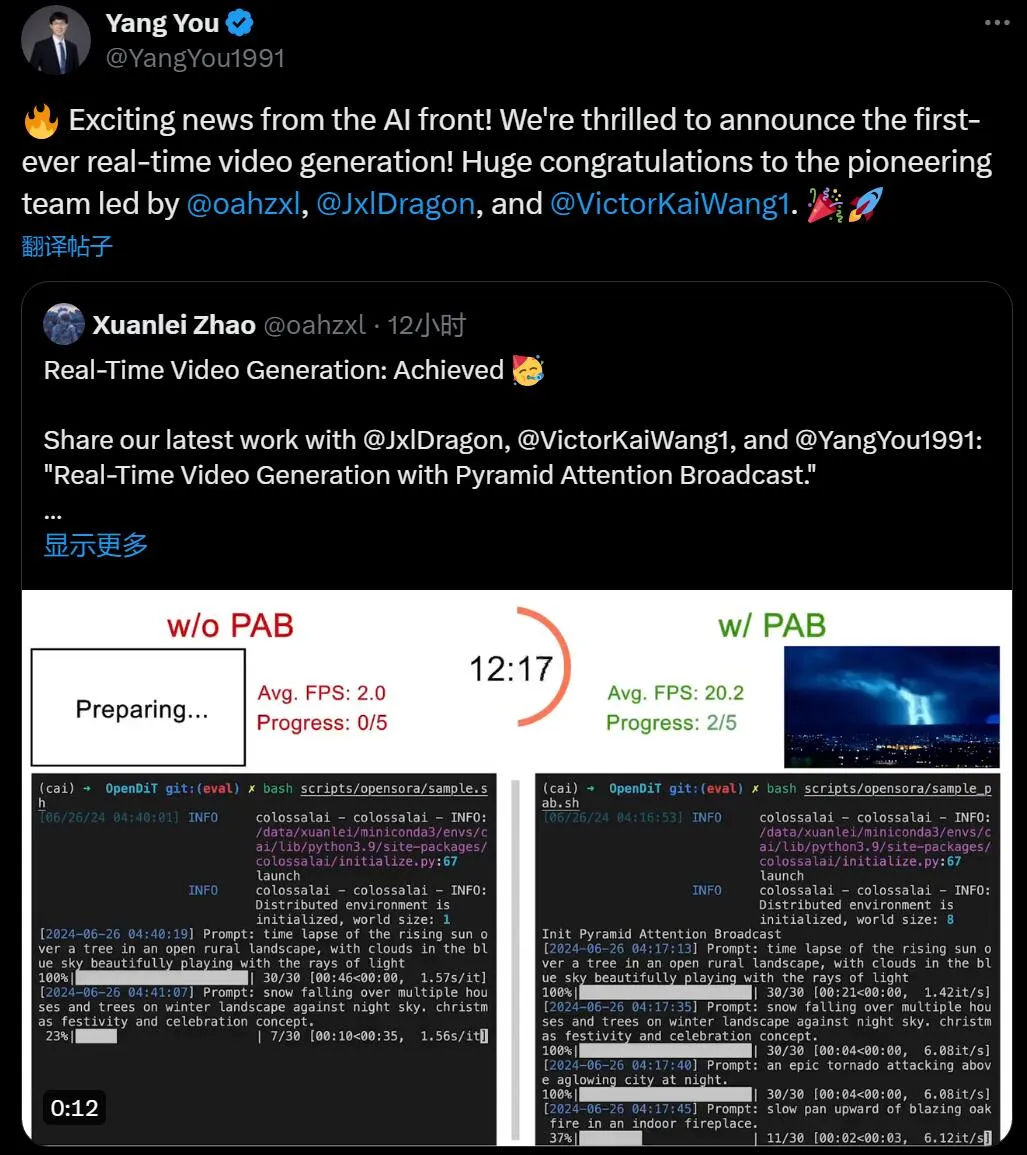

本周三,新加坡国立大学尤洋团队提出了业内第一种可以实时输出的,基于 DiT 的视频生成方法。

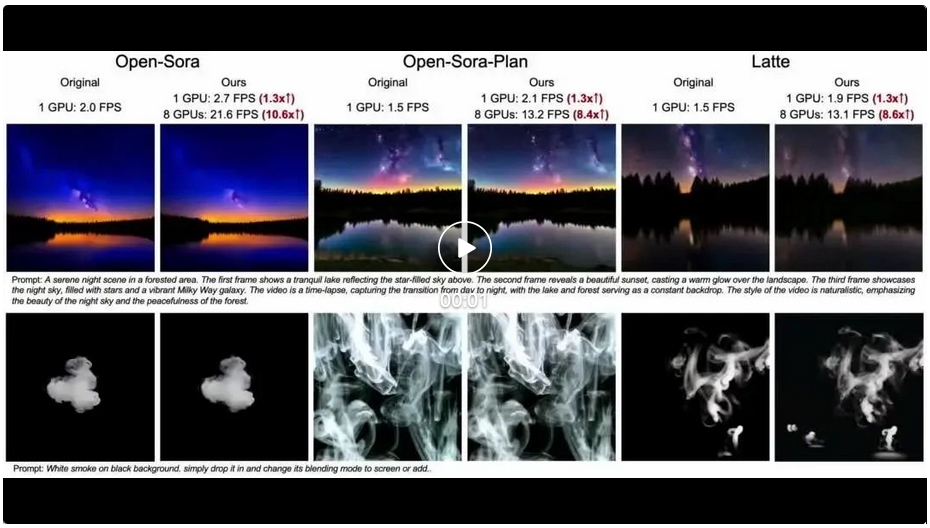

该技术名为 Pyramid Attention Broadcast (PAB)。通过减少冗余注意力计算,PAB 实现了高达 21.6 FPS 的帧率和 10.6 倍的加速,同时不会牺牲包括 Open-Sora、Open-Sora-Plan 和 Latte 在内的流行基于 DiT 的视频生成模型的质量。值得注意的是,作为一种不需要训练的方法,PAB 可以为任何未来基于 DiT 的视频生成模型提供加速,让其具备实时生成的能力。

自今年起,OpenAI 的 Sora 和其他基于 DiT 的视频生成模型引起了 AI 领域的又一波浪潮。然而与图像生成相比,人们对于视频生成的关注点基本都在于质量,很少有研究专注于探索如何加速 DiT 模型推理。加速视频生成模型的推理对于生成式 AI 应用来说已经是当务之急。

PAB 方法的出现,为我们打开了一条路。

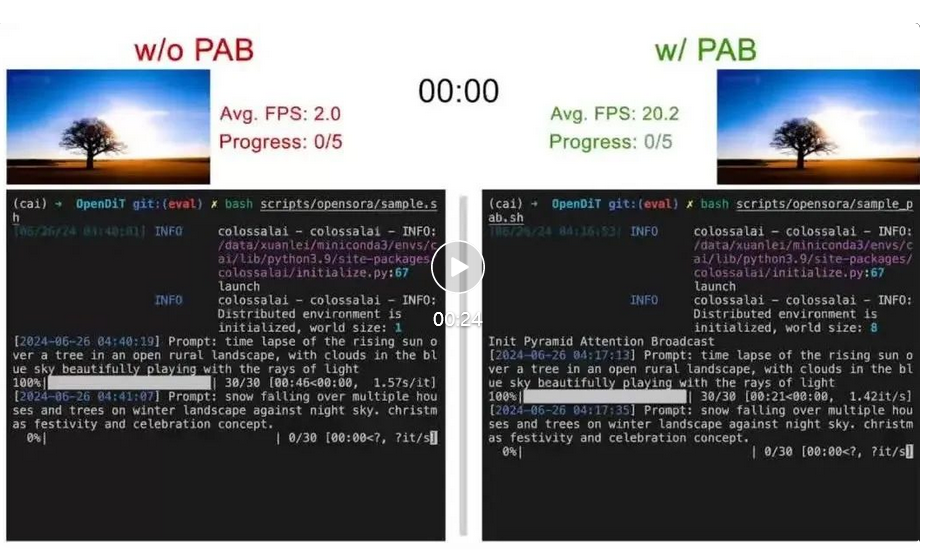

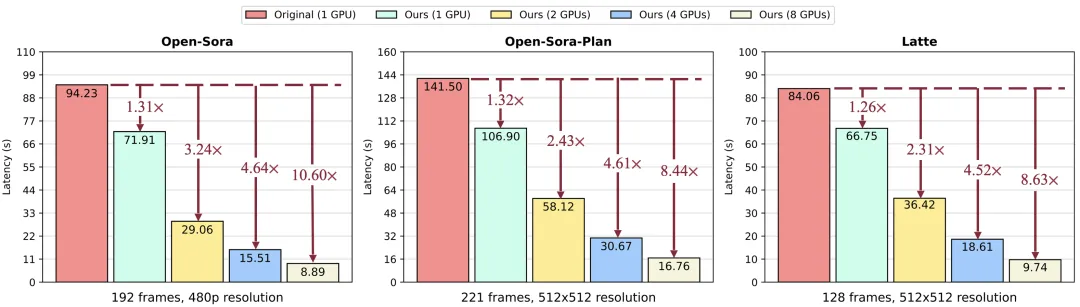

原始方法与 PAB 视频生成速度的比较。作者在 Open-Sora 上测试了 5 个 4s(192 帧)480p 分辨率的视频。

GitHub 链接:https://github.com/NUS-HPC-AI-Lab/OpenDiT?tab=readme-ov-file#pyramid-attention-broadcast-pab-blogdoc

近期,Sora 和其他基于 DiT 的视频生成模型引起了广泛关注。然而,与图像生成相比,很少有研究专注于加速基于 DiT 的视频生成模型的推理。此外,生成单个视频的推理成本可能很高。

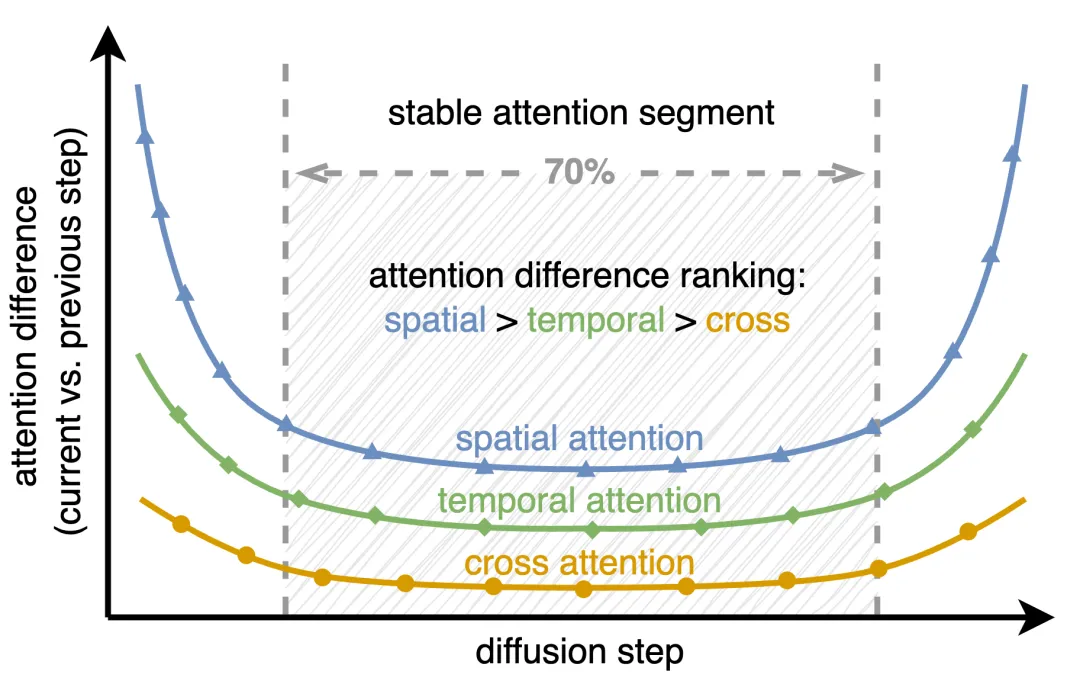

图 1:当前扩散步骤和先前扩散步骤之间的注意力输出差异,使用均方误差 (MSE) 对差异进行量化。

这项研究揭示了视频扩散 transformer 中注意力机制的两个关键观察结果:

首先,不同时间步骤的注意力差异呈现出 U 形模式,在最初和最后 15% 的步骤中发生显著变化,而中间 70% 的步骤则非常稳定,差异很小。

其次,在稳定的中间段内,注意力类型之间存在差异:空间注意力变化最大,涉及边缘、纹理等高频元素;时间注意力表现出与视频中的运动和动态相关的中频变化;跨模态注意力是最稳定的,将文本与视频内容联系起来,类似于反映文本语义的低频信号。

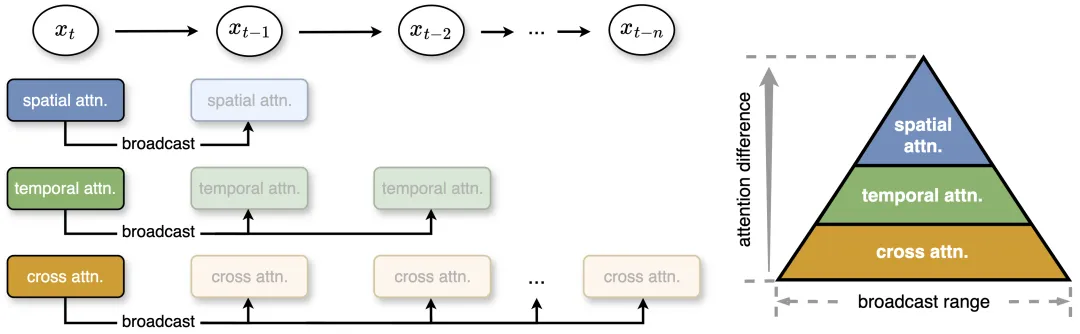

基于此,研究团队提出金字塔式注意力广播来减少不必要的注意力计算。在中间部分,注意力表现出微小的差异,该研究将一个扩散步骤的注意力输出广播到几个后续步骤,从而显著降低计算成本。

此外,为了更有效的计算和最小的质量损失,作者根据不同注意力的稳定性和差异性设置了不同的广播范围。即使没有后期训练,这种简单而有效的策略也能实现高达 35% 的加速,同时生成内容的质量损失可以忽略不计。

图 2:该研究提出了金字塔式注意力广播,其中根据注意力差异为三个注意力设置不同的广播范围。注意力变化越小,广播范围越广。在运行时,该方法将注意力结果广播到接下来的几个步骤,以避免冗余的注意力计算。x_t 指的是时间步 t 的特征。

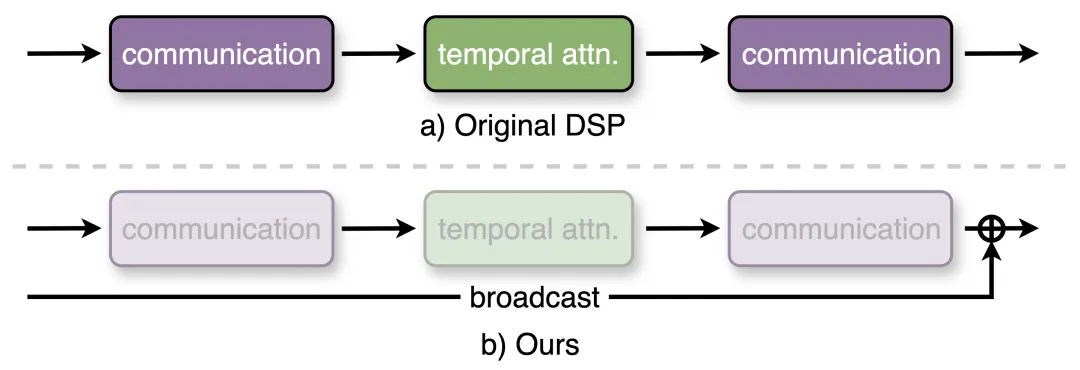

下图 3 为本文方法与原始动态序列并行(Dynamic Sequence Paralle, DSP)之间的比较。当时间注意力得到传播时,则可以避免所有通信。

为了进一步提升视频生成速度,本文基于 DSP 来改进序列并行。序列并行将视频分割为跨多个 GPU 的不同部分,从而减少了每个 GPU 的工作负载并降低了生成延迟。不过,DSP 引入了大量的通信开销,需要为时间注意力准备两个 All to All 通信。

通过在 PAB 中传播时间注意力,本文不再需要对时间注意力进行计算,由此减少了通信。相应地,通信开销大幅降低了 50% 以上,使得实时视频生成可以进行更高效的分布式推理。

加速

下图为不同模型在 8 块英伟达 H100 GPU 上生成单个视频时,测量得到的 PAB 总延迟。当使用单块 GPU 时,作者实现了 1.26 至 1.32 倍的加速,并在不同的调度器中保持稳定。

当扩展到多块 GPU 时,本文方法实现了 10.6 倍的加速,并得益于高效的序列并行改进实现了与 GPU 数量之间的近线性扩展。

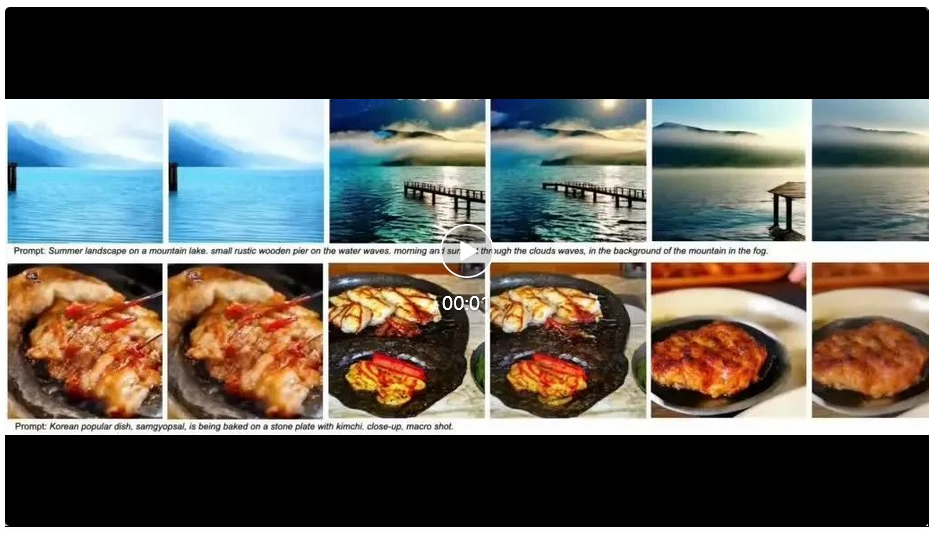

定性结果

以下三个视频分别为 Open-Sora、Open-Sora-Plan 和 Latte 三个不同的模型使用原始方法与本文方法的效果对比。可以看到,本文方法在不同的 GPU 数量下均实现了不同程度的 FPS 加速。

定量结果

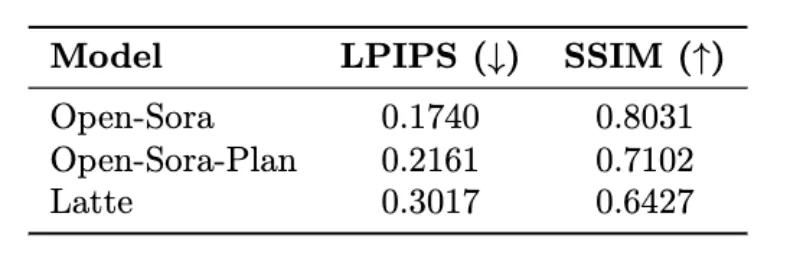

下表为 Open-Sora、Open-Sora-Plan 和 Latte 三个模型的 LPIPS(学习感知图像块相似度)和 SSIM(结构相似度)指标结果。

更多技术细节和评估结果可以查看即将推出的论文。

项目地址:https://oahzxl.github.io/PAB/

参考链接:

https://oahzxl.github.io/PAB/

文章来自于微信公众号“机器之心”,作者 “机器之心”