深度学习三巨头之一Yoshua Bengio的下一步动向公开了,关于AI安全——

加入了一个名为Safeguarded AI(受保护的人工智能)的项目,担任科学总监。

据介绍,Safeguarded AI旨在:

通过结合科学的世界模型和数学证明,构建一个负责理解和降低其它AI Agent风险的AI系统。

主打的就是一个量化安全保障。

该项目由英国高级研究与发明局(ARIA)提供支持,据说未来ARIA将投入共5900万英镑(约合RMB5.37亿)。

Bengio表示:

如果你计划部署某种技术,鉴于AI行为异常或误用可能带来非常严重的后果,你需要提出充分的理由,最好能提供强有力的数学保证,确保你的AI系统将正常运作。

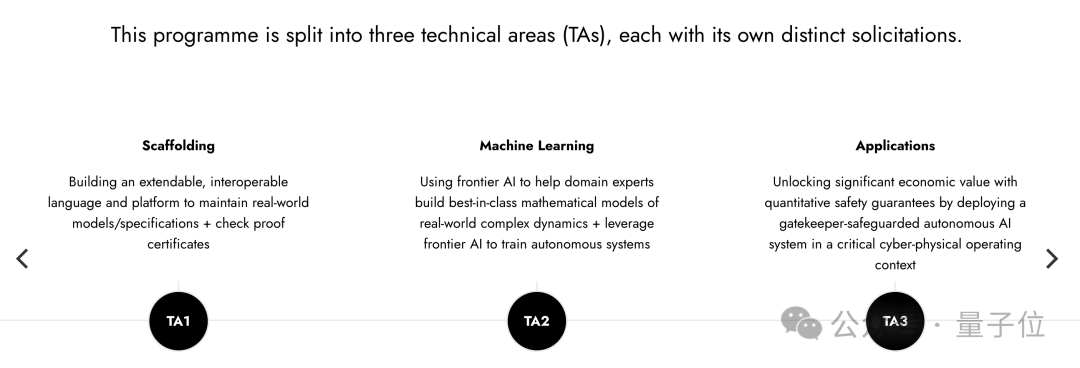

Safeguarded AI项目被划分为三个技术领域,每个领域都有特定的目标和预算:

官方表示,Bengio加入后将特别关注TA3和TA2,在整个计划中提供科学战略建议。

ARIA还计划投入1800万英镑(约合RMB1.64亿)成立一个非营利组织,领导TA2的研发工作。

Safeguarded AI项目总监是前Twitter高级软件工程师David “davidad” Dalrymple,去年9月份加入ARIA。

对于Bengio的到来,Dalrymple还在X(原推特)上传了俩人的合照:

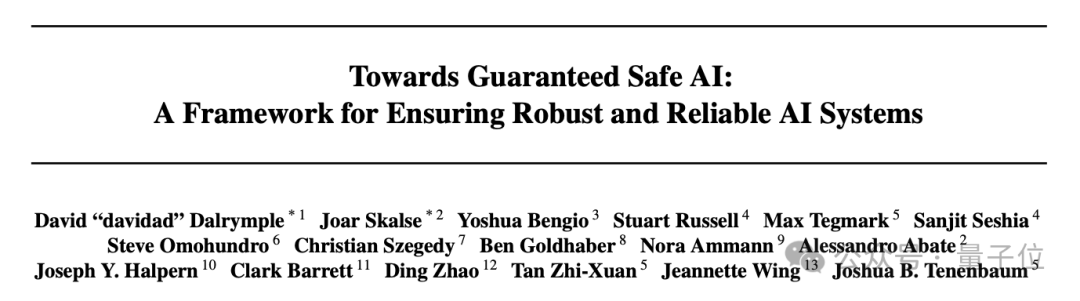

关于“构建一个负责理解和降低其它AI Agent风险的AI系统”的具体方法,David “davidad” Dalrymple、Yoshua Bengio等人写了份文件。

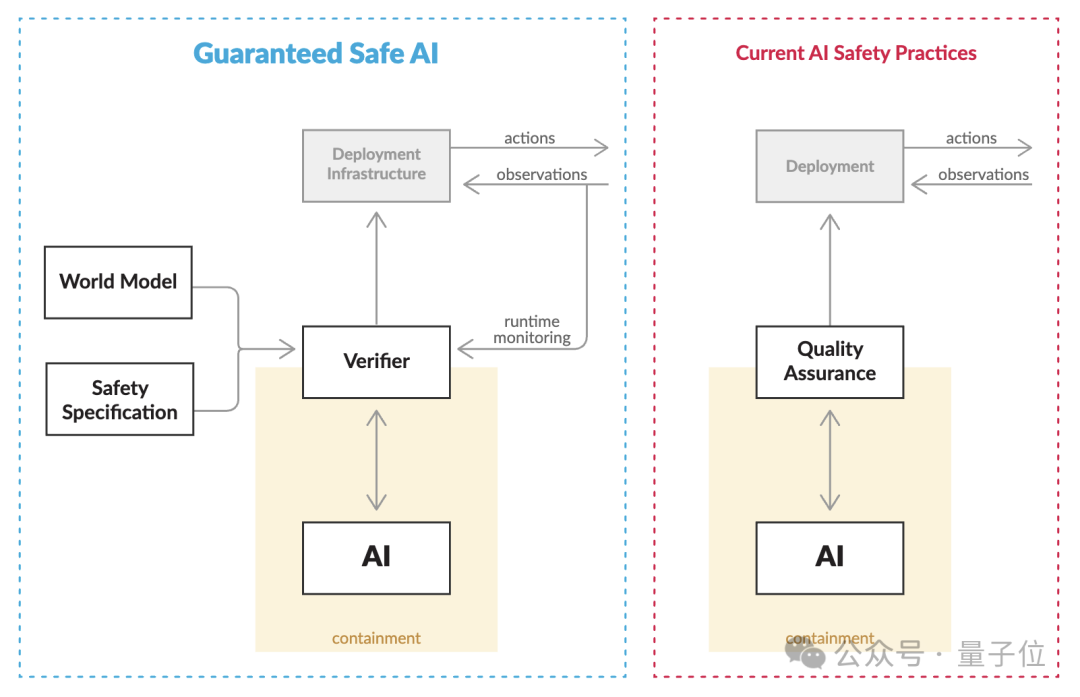

其中提出了一套称为“Guaranteed Safe AI(保证安全的AI)”的模式,主要是通过三个核心相互作用量化AI系统的安全保障:

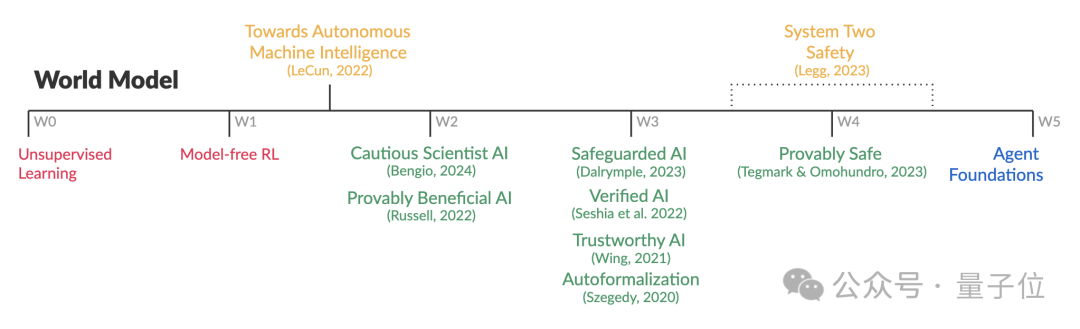

他们还为创建世界模型的策略,划分了L0-L5安全等级:

“AI风险”一直是行业大佬们关注的焦点话题之一。

Hinton离职谷歌,就是为了自由地讨论AI风险问题。

之前,更是有吴恩达、Hinton、LeCun、哈萨比斯等AI巨佬们线上“对喷”的大型场面。

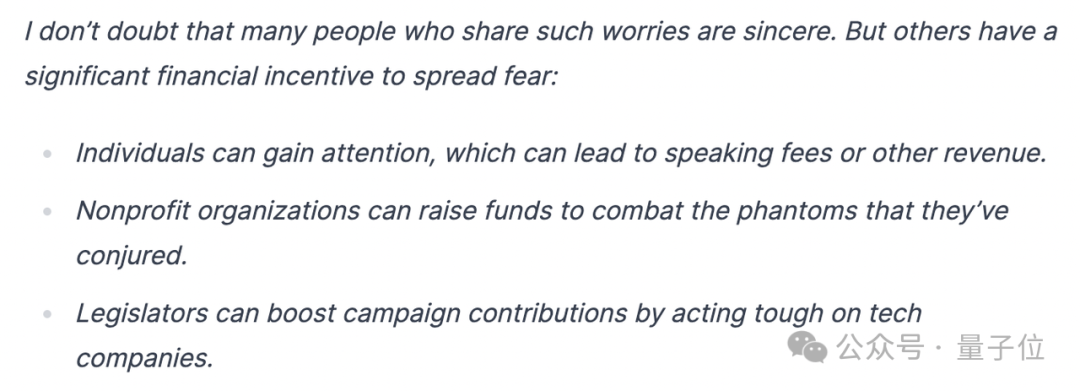

吴恩达曾表示:

对AI的最大担忧其实是,AI风险被过度鼓吹,导致开源和创新被严苛规定所压制。

某些人传播(AI灭绝人类的)恐惧,只是为了搞钱。

DeepMind CEO哈萨比斯则认为:

这不是恐吓。AGI的风险如果不从现在就开始讨论,后果可能会很严重。

我不认为我们会想在危险爆发之前才开始做防范。

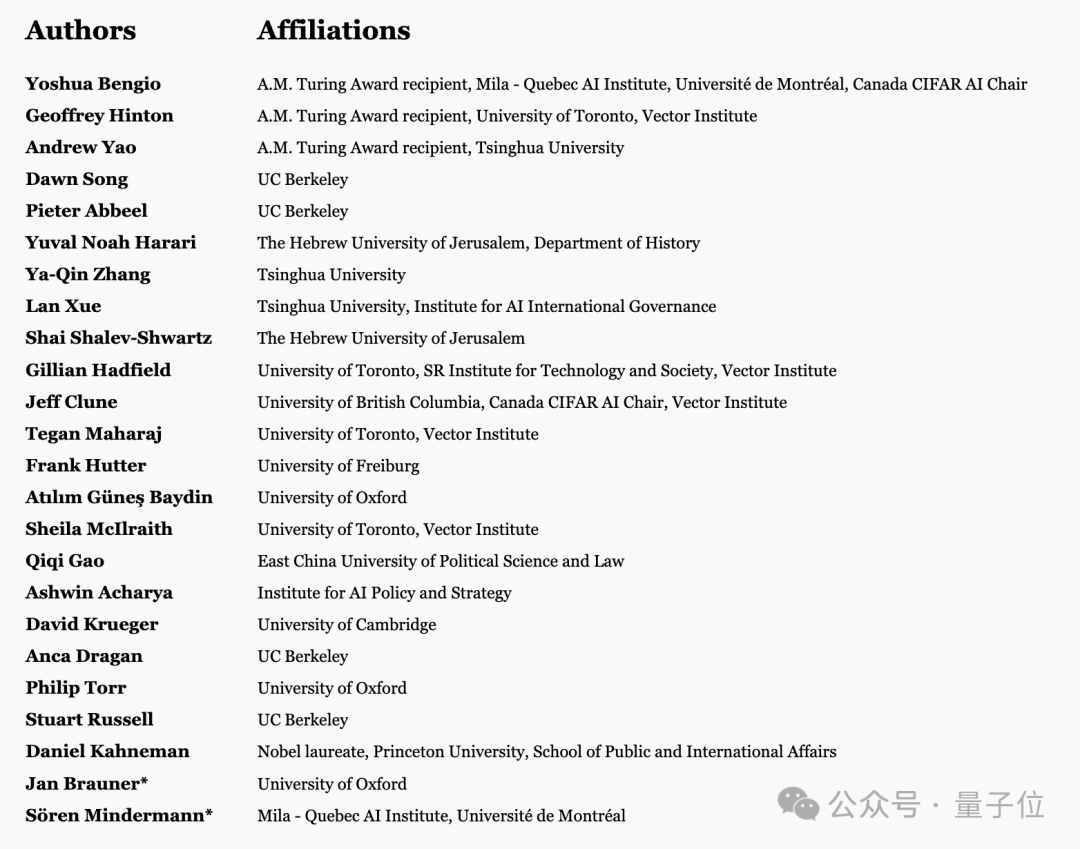

Bengio之前还和Hinton、姚期智、张亚勤等人工智能大拿,发表了一封公开信《在快速进步的时代管理人工智能风险(Managing AI RIsks in an Era of Rapid Progress)》。

其中就指出人类必须认真对待AGI在这10年或下一个10年内在许多关键领域超越人类能力的可能。建议监管机构应该对AI发展全面洞察,尤其警惕那些在价值数十亿美元的超级计算机上训练出来的大模型。

就在一个月前,Bengio还以“Reasoning through arguments against taking AI safety seriously(回应反对认真对待AI安全的观点)”为题写了一篇文章,其中分享了他的最新想法,感兴趣的家人可以康康~

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md