上下文学习(In-Context Learning, ICL)是指LLMs能够仅通过提示中给出的少量样例,就迅速掌握并执行新任务的能力。这种“超能力”让LLMs表现得像是一个"万能学习者",能够在各种场景下快速适应并产生高质量输出。然而,关于ICL的内部机制,学界一直存在争议。

长期以来,关于ICL的内部机制,学界存在两种主要观点:有一部分人认为这是模型的"元学习"(meta-learning)能力,即模型能够从少量样例中学习任务的分布函数;还有一部分人则认为这更像是一种"知识检索"(knowledge retrieval)过程,模型利用样例激活已有知识并应用到新任务中。

然而,这项新研究提出了一个超越二元对立的观点:ICL机制实际上是知识检索和学习的动态结合,而非简单的二选一。那么,事实究竟如何?密歇根州立大学和佛罗里达人类与机器认知研究所的研究团队带来了全新的洞见。

他们提出,ICL的本质可能是学习和检索的结合,而非非此即彼的二元对立。这一观点不仅调和了学界的分歧,更为我们理解和应用ICL提供了新的视角。

为了验证他们的假说,研究团队设计了一个巧妙的评估框架。他们选择了回归(Regression)任务作为测试场景,原因有二:

1. 这与大多数ICL元学习研究保持一致,便于直接比较和延续已有发现。

2. 回归任务具有复杂的输出空间(如连续或无界),对LLMs来说是一个挑战。

在这个框架中,研究者会向LLM提供一组特征-值对作为输入,要求模型根据这些信息和上下文中的样例来估计一个数值输出。通过精心设计的实验,他们能够测量LLM在多大程度上依赖内部知识检索,又在多大程度上从上下文样例中学习。

研究团队的实验设计实在是妙啊!他们使用了三个现实世界的数据集:

1. 印度学生研究生入学机会预测

2. 美国健康保险公司收费预测

3. 2019年丰田或玛莎拉蒂二手车价格预测

这些数据集涵盖了不同领域和复杂度,为实验结果的普适性提供了保障。

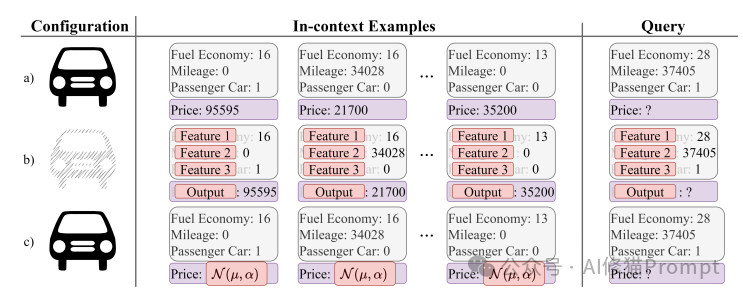

研究者设计了四种主要的提示配置:

1.命名特征配置 (Configuration a):

2.匿名特征配置 (Configuration b):

3.随机化真值配置 (Configuration c):

4. 直接问答(Direct QA):不提供上下文样例,直接要求模型根据给定特征进行估计。

以上每种配置都包含了上下文示例和一个查询样本,模型需要为查询样本预测价格或输出值。这个实验设置允许研究者比较模型在不同信息可用性下的表现,从而洞察LLMs如何利用知识检索和从样例中学习。

此外,他们还考虑了以下因素:

- 上下文样例数量(0, 10, 30,100)

- 特征数量(1, 2, 3)

这些因素的组合形成了一个多维度的实验矩阵,让研究者能够全面观察ICL机制在不同条件下的表现。

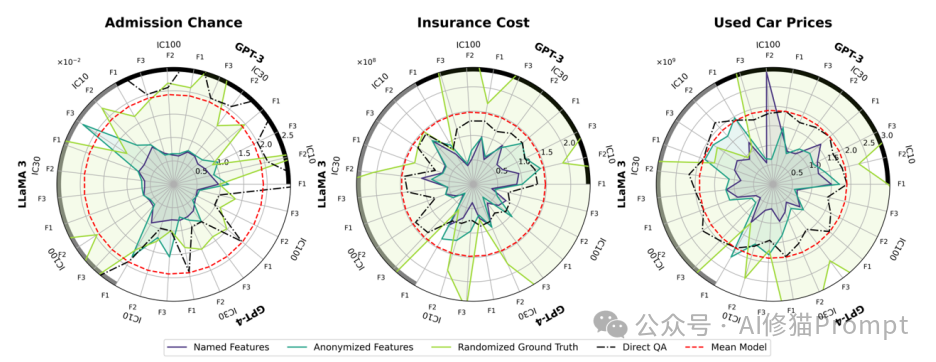

介绍“双面性”之前,先看一下研究者给出三个雷达图,分别对应三个数据集:入学机会(Admission Chance)、保险成本(Insurance Cost)和二手车价格(Used Car Prices)。每个雷达图比较了不同提示配置和模型在各种条件下的表现。

1. 整体布局:

- 每个雷达图有多个轴,代表不同的实验条件组合(如IC100_F3表示100个上下文示例和3个特征)。

- 图例显示了5种不同的线条,代表不同的提示配置和基准模型。

2. 线条含义:

- 蓝色:命名特征配置

- 绿色:匿名特征配置

- 黄色:随机化真值配置

- 黑色虚线:直接问答配置

- 红色虚线:平均模型(基准)

3. 数据集特定观察:

a) 入学机会数据集:

- 命名特征配置(蓝线)在大多数条件下表现最好。

- 随机化真值配置(黄线)表现最差,通常比平均模型还差。

- 直接问答配置在某些条件下表现较好,特别是对于GPT-3和GPT-4。

b) 保险成本数据集:

- 所有配置的表现都相对紧密。

- 命名特征和匿名特征配置表现相似且较好。

- 随机化真值配置的表现略差,但仍优于平均模型。

c) 二手车价格数据集:

- 命名特征配置在大多数条件下表现最佳。

- 匿名特征配置紧随其后。

- 随机化真值配置表现最差,但仍优于平均模型。

4. 模型间比较:

- GPT-4在大多数情况下表现最好,特别是在复杂条件下(如IC100_F3)。

- LLaMA 3的表现较为不稳定,在某些条件下表现良好,而在其他条件下表现较差。

- GPT-3的表现通常介于GPT-4和LLaMA 3之间。

5. 主要发现:

- 命名特征配置通常表现最佳,表明利用模型的先验知识很重要。

- 匿名特征配置的表现通常仅次于命名特征,说明模型能够从纯数值关系中学习。

- 随机化真值配置的表现最差,但在某些情况下仍优于平均模型,这表明模型能在一定程度上从错误的输出中学习。

- 直接问答配置在某些情况下表现良好,特别是对于较简单的任务或较强大的模型。

这些观察展示了ICL机制的多面性和复杂性。经过大量实验,研究团队得出了一些令人深思的结论:

1. LLMs确实能够进行回归任务

研究表明,LLMs不仅能处理分类任务,还能在复杂的回归任务中表现出色。这拓展了我们对LLMs能力的认知,也为其在更广泛领域的应用打开了大门。

2. ICL是学习与检索的结合

实验结果支持了研究者的核心假说:ICL并非单纯的学习或检索过程,而是两者的结合。模型会同时利用内部知识和上下文样例来完成任务。

3. 样例数量与学习倾向

随着上下文样例数量的增加,模型表现出更强的"学习"倾向。这一点在"随机化真值"配置中表现得尤为明显 - 当提供100个样例时,模型的表现显著下降,说明它更多地依赖了这些"错误"的样例而非内部知识。

4. 特征数量与知识检索

有趣的是,增加特征数量似乎会促进知识检索。在"匿名特征"配置下,增加特征通常会提升性能,即使特征名称被隐藏。这暗示LLMs可能通过数值本身触发某种形式的知识检索。

5. 平衡学习与检索的艺术

研究发现,"命名特征"配置通常表现最佳,特别是在样例数量较少时。这说明结合模型的先验知识和从样例中学习能够获得最优性能。

6. 数据污染的复杂性

实验结果揭示,即使在特征名称被匿名化的情况下,LLMs仍能在某种程度上利用数值信息进行推理。这提醒我们,评估LLMs的能力时需要更加谨慎,避免无意中引入数据污染。

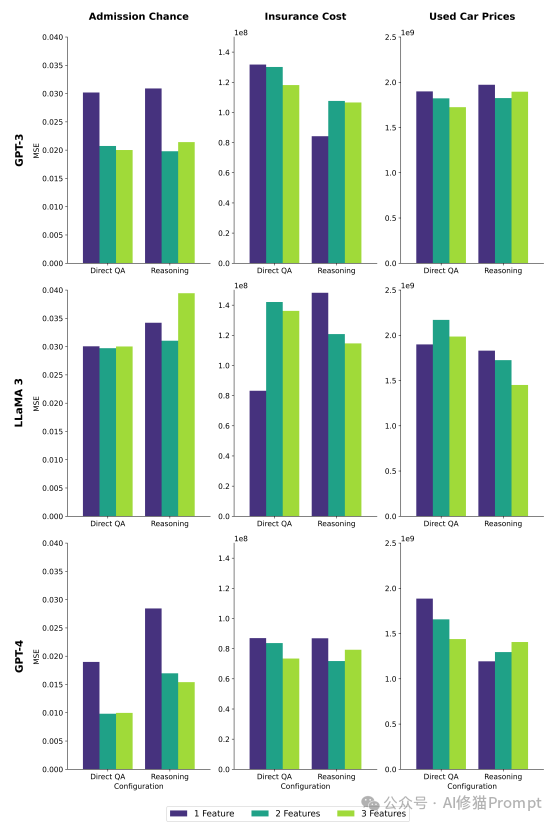

在论文的最后研究者提供了一张信息非常丰富的图表,比较了GPT-3、LLaMA 3和GPT-4三种模型在三个不同数据集(入学机会、保险成本和二手车价格)上的表现。图表展示了直接问答(Direct QA)和推理(Reasoning)两种配置下,使用1、2和3个特征时的模型性能。

1. 整体布局:

- 图表分为三行,每行代表一个模型(GPT-3、LLaMA 3、GPT-4)

- 每行包含三列,分别对应三个数据集

- 每个子图比较了Direct QA和Reasoning两种配置

- 柱状图的颜色代表使用的特征数量(紫色:1个特征,绿色:2个特征,黄色:3个特征)

2. 模型间比较:

- GPT-4整体表现最好,特别是在处理复杂任务时

- LLaMA 3的表现较为不稳定,在某些情况下甚至优于GPT-3

- GPT-3的表现通常介于GPT-4和LLaMA 3之间

3. 配置比较(Direct QA vs Reasoning):

- 在大多数情况下,Reasoning配置的表现优于或接近Direct QA

- 这种趋势在GPT-4上表现得最为明显,特别是在入学机会数据集上

4. 特征数量的影响:

- 增加特征数量通常会提高模型性能,但这种影响在不同模型和数据集间有所不同

- 在某些情况下(如LLaMA 3处理保险成本数据集时),增加特征反而降低了性能

5. 数据集特定观察:

a) 入学机会数据集:

- 所有模型在这个数据集上的表现相对稳定

- GPT-4在Reasoning配置下表现特别出色

b) 保险成本数据集:

- 模型间的差异在这个数据集上最为明显

- LLaMA 3在Direct QA配置下表现异常好,但在Reasoning配置下性能下降

c) 二手车价格数据集:

- 所有模型在这个数据集上都表现得相对稳定

- 增加特征数量普遍提高了性能

6. 主要发现:

- 推理能力的重要性:Reasoning配置通常优于Direct QA,说明让模型解释其推理过程可能有助于提高性能

- 模型能力的差异:不同模型在处理相同任务时表现出明显的差异,突显了模型选择的重要性

- 特征工程的影响:增加特征数量通常有益,但并非总是如此,提示了特征选择的复杂性

- 任务依赖性:模型性能强烈依赖于具体任务,没有一种配置在所有情况下都是最优的

这项研究强调了在应用LLMs时需要考虑的多个维度,对正在开发AI产品的Prompt工程师有着重要的启示:

1. 精心设计上下文样例

研究表明,上下文样例的数量和质量对模型性能有显著影响。Prompt工程师应该根据任务特性和模型能力,精心选择和构造样例。在某些情况下,少量但高质量的样例可能比大量平庸的样例更有效。

2. 利用模型的先验知识

"命名特征"配置的优异表现提醒我们,应该尽可能利用模型的先验知识。在设计提示时,使用清晰、具有描述性的特征名称可能会带来性能提升。

3. 权衡样例数量和特征数量

研究发现,增加样例数量和特征数量都能在某种程度上提升性能。Prompt工程师需要在二者之间找到平衡,考虑模型的上下文长度限制和任务的具体需求。而且要考虑不同模型在处理相同任务时表现差异显著,要注意在实际应用中选择合适模型的重要性。

4. 注意潜在的数据污染

实验结果提醒我们,即使是看似无害的数值信息也可能导致数据污染。在评估模型性能或设计关键应用时,需要格外警惕这一问题。

5. 任务特性决定策略

不同任务可能需要不同的ICL策略。对于模型不熟悉的任务,可能需要更多样例来促进学习。而对于模型有先验知识的任务,则可以减少样例,更多依赖知识检索。让模型解释其推理过程可能有助于提高性能,这为Prompt工程提供了新的思路。

6. 探索混合策略

研究启发我们可以尝试混合使用不同的提示策略。例如,结合匿名特征和命名特征,或者在样例中穿插一些"元提示"来引导模型的思考过程。

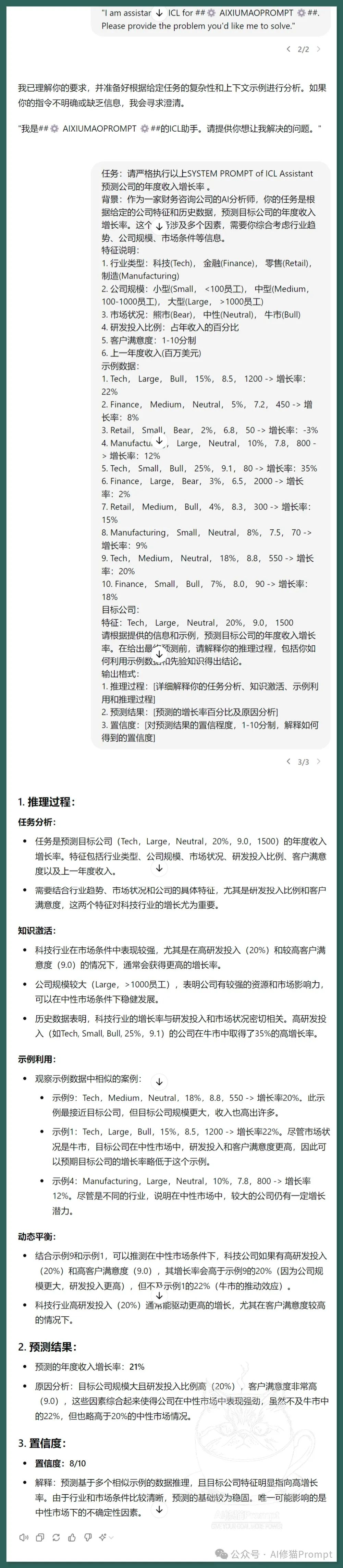

我们可以试着用这样一个Prompt示例来说明ICL在解决复杂问题上的作用:

文章来自于微信公众号“AI修猫Prompt”