今年毫无疑问是AI应用层的创业元年。

在AI应用层,市场上两类玩家:

显然,第一类玩家对于GPU算力的解法就非常简单粗暴,那就是拿钱硬砸;

而占多数的第二类玩家,去年可以说是苦GPU算力久矣。

这里的主要挑战倒不是芯片禁售。而是对于这类AI创业公司来说,资金有限,每一笔“万”这个级别的资金都很慎重。于是从去年开始,大家为了解决算力问题,只能各显神通。

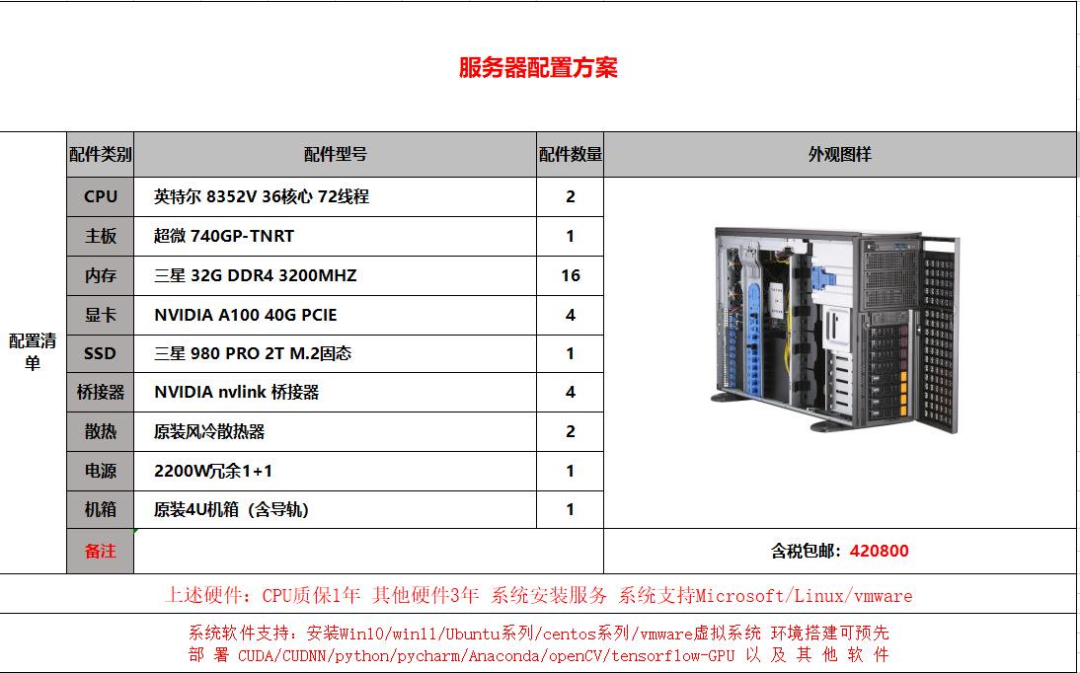

有的创业团队比较极客,本想买一台整机甚至自己组装一台整机,想着做做微调,4卡40GB A100也够用了。嗯,结果一问,发现靠谱点的厂商,市场价也要奔着3、40个w去了。

暂且不说,对于大部分融资有限的创业团队来说,还没pmf就豪掷几十个w买服务器的行为属实风险不小。

更要命的是,这并不是一个“一劳永逸”的选择。

这种服务器噪声是很大的,发热也是很猛的,无法放到办公间或家里,必须要在有制冷设备的专用机房里运维,有专人维护。

结果算了算,租赁机房+人力维护,哪怕去找第三方,每个月还得多5k的固定支出。好家伙,都能招个实习生了。

由于机器是第三方厂家组装的,你要是贪便宜遇到个不靠谱的,那服务器出各种“神器现象”更是常有的事儿。你机房要是租在荒郊野外的,那更难受了。

一不小心,你会发现,虽然自己在AI应用层没做出来啥,但自己在服务器运维方面的行业竞争力越来越强了。嗯,说不定将来还能转行去卖服务器。

看到这儿,你可能会说:

“我没那么极客,我选择成熟的云厂商!”

结果你看了看,国内的云厂商受禁售令的影响,几乎无卡可用。

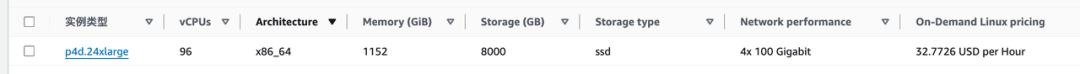

于是你把目光投向了海外云厂商,比如亚马逊云。

然后你成功找到了4卡A100的GPU机器:

算了一下,好家伙,每月的租金高达32*24*30*7=16万RMB。敢情租两个来月都够买台新机器了。

看,由于这个痛点太痛,于是敏锐的你发现,去年诞生了N多家“廉价GPU算力租用”的云平台。

于是你看了下,嗯,看起来确实便宜,一个月才1万?

于是,你大张旗鼓开搞了。但很快,你就会发现,云计算领域的技术壁垒还是蛮高的。为了聚焦核心功能,这类新型GPU算力平台往往在网络、存储、故障检测等其他底层设施方面优化非常有限,导致很容易遇到“神奇现象”。

比如去年我们就遭遇了显卡故障、模型加载过慢、内存不够用、磁盘不够用、网络速率异常、系统环境异常、服务丢包、无法自定义端口等一大堆问题,说多了都是泪。

如果你也混AI创业圈,你会发现,好像今年在为算力头疼的应用层创业者大大减少了。

为啥呢?

可能很多已经出局了

直到上周,我在一个朋友的公司里,无意间发现了一种关于GPU算力的最佳解法:

你可能没法想象,他说他们整个团队的AI模型训练和服务部署都在这上面进行。

我直接满脑子问号??

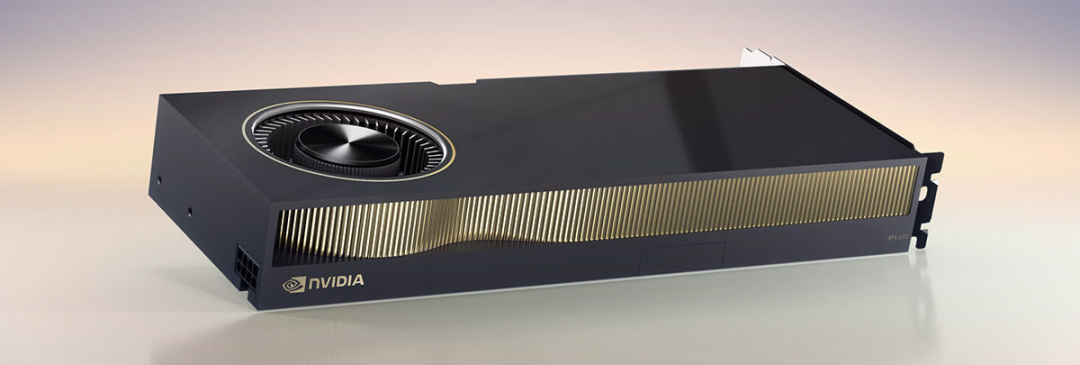

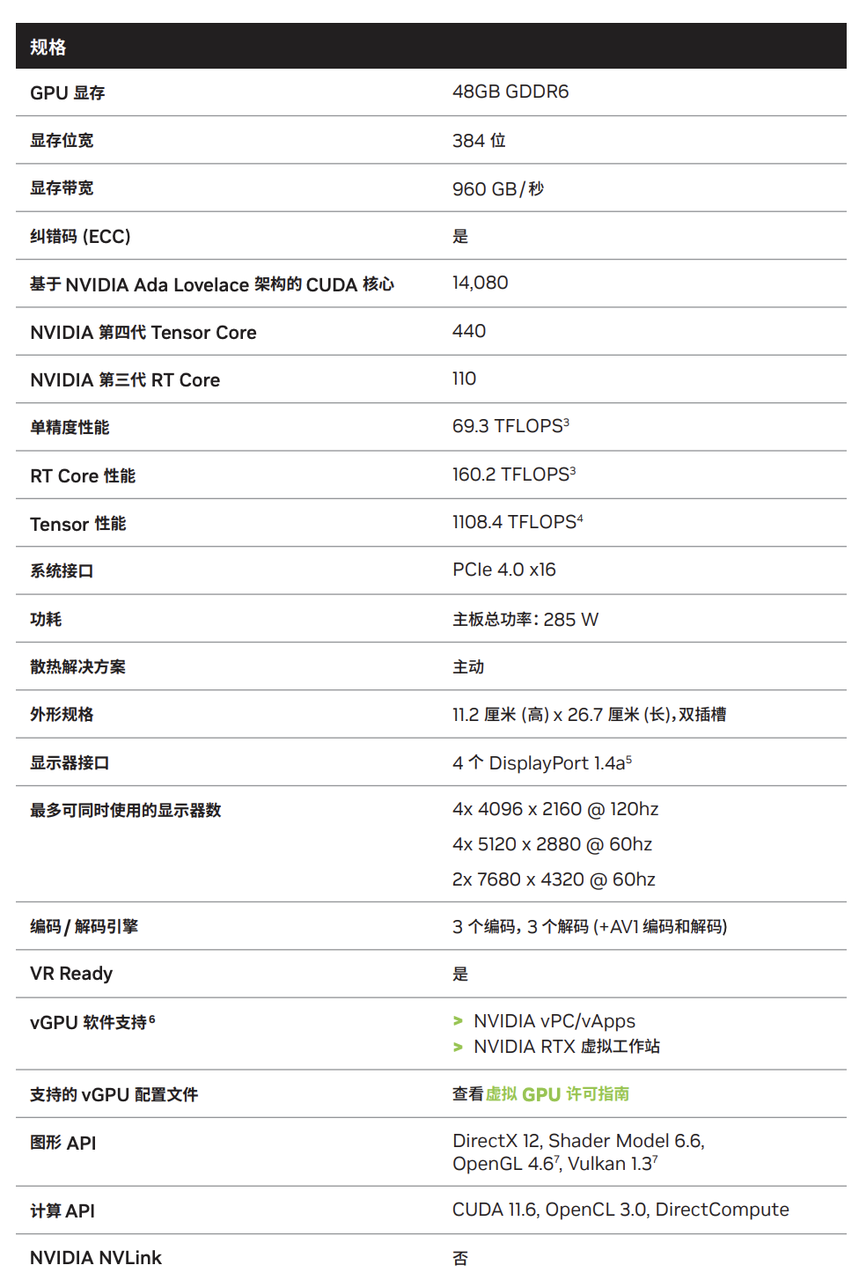

在这个不起眼的机器里,竟然装了4块48GB显存的专业计算卡,而且是为生成式AI而生的RTX 5880 Ada Generation。

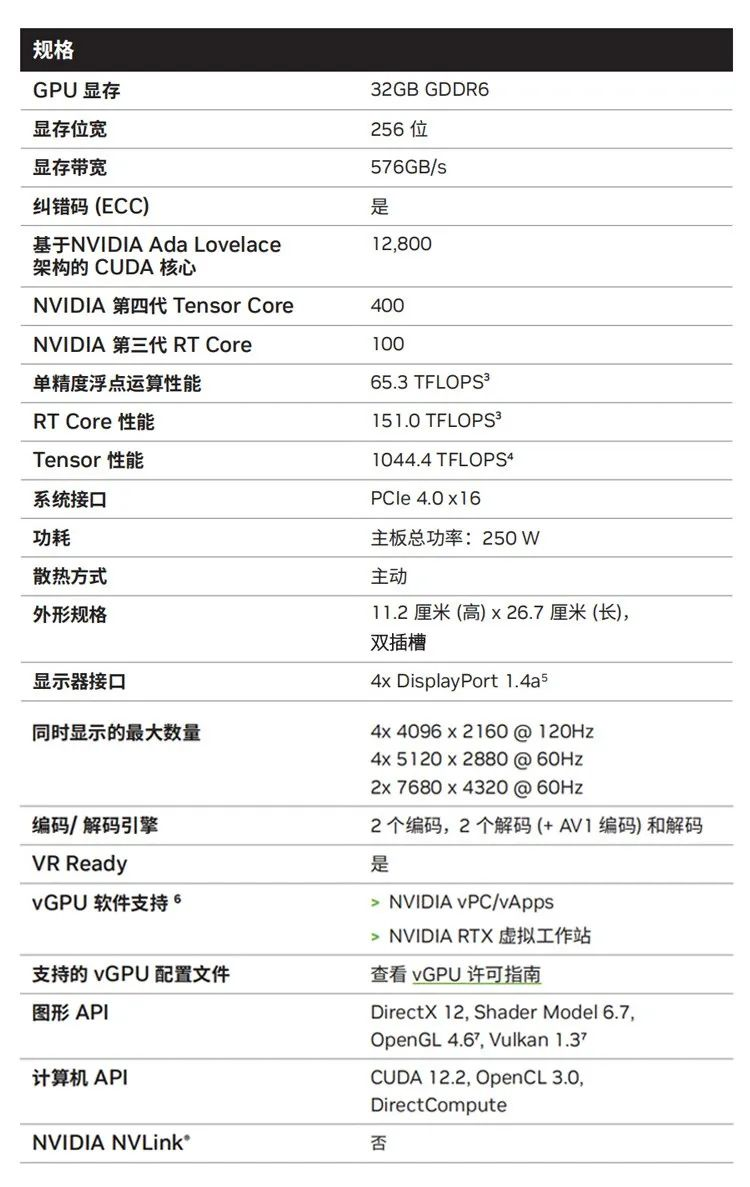

贴下5880 Ada这款卡的技术参数:

需要强调的是,RTX 5880并不是4090这类消费级卡,而是专门为生成式AI打造的专业计算卡,非常的耐造(专业玩家都懂显卡耐造的重要性)

PS:尽管4090在游戏表现上非常出色,一直是市场上的香饽饽儿,但是由于禁令,国内合规渠道下买不到,黑市买的又不放心。年初就被曝出过大量工厂将4090爆改成AI计算卡,转手卖给国内,消费级显卡拿来做AI计算,寿命、稳定性和售后都很难评。而随着《黑神话:悟空》国产3A游戏的全球爆火,40系变得更加紧俏,价格已被炒到翻倍。

还有一个重要的细节是,这机器竟然就放在他们的办公间里,完全不需要机房和制冷。而且噪声很小,完全不会影响办公。

我在想,这种黑科技那不得天价?

结果一问——

竟然才花了20来个w??

小伙伴说,他们买的还是顶配版,如果是选择5000 ada显卡的标准配置,15个w就搞定了。

RTX 5000 ada (32G)和 RTX 5880 ada(48G)都是基于 NVIDIA Ada Lovelace 架构打造的专业计算卡。

RTX 5000 ada 的产品参数如下:

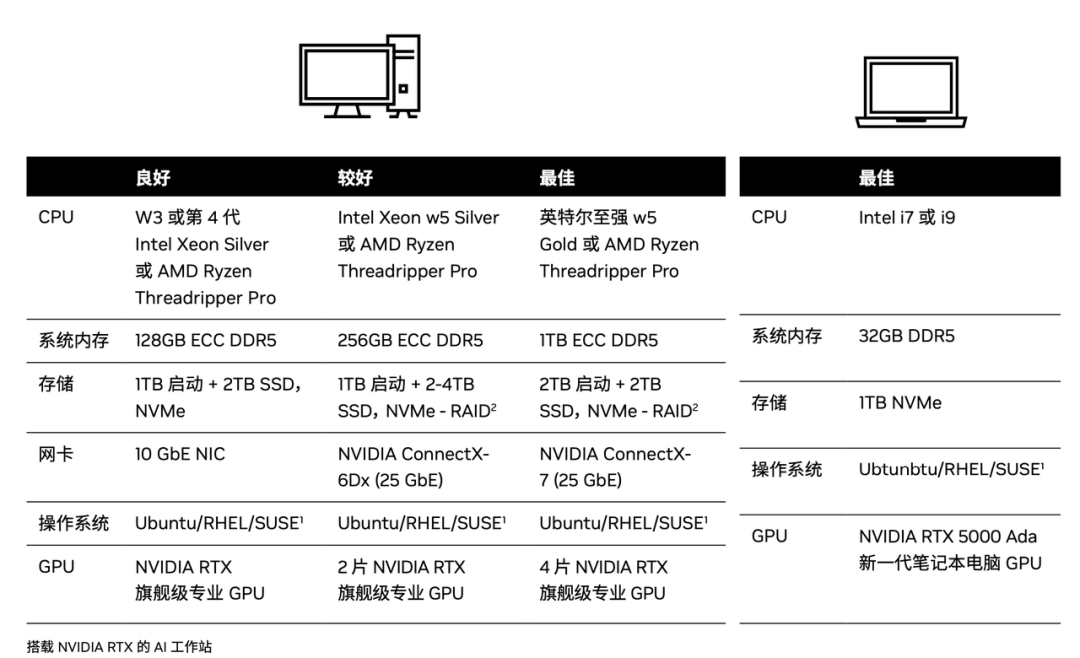

我仔细一问,才知道这竟然就是英伟达 RTX 助力的 AI 工作站:

NVIDIA RTX Ada 系列的显卡的含金量,不必多说,这样就放心多了,再也不用在组装机和二手卡的市场里犯纠结了。

附网页链接:https://www.nvidia.cn/ai-data-science/workstations/

值得一提的是,这个AI工作站还支持免费试用!申请二维码分享给你们了,有需要的抓紧去撩。

这妥妥是今年AI算力的最佳解决方案啊。

这个定价,但凡有点融资的基本都能扛得住。重要的是,这10几个w换来的是硬件资产,就算经营不景气了,还能反手卖掉回血。不像是租赁云算力,钱花了就是没了。

根据朋友的说法,更重要的是,这个AI工作站可以训推一体,非常适合早期的创业公司。

毕竟创业早期,需要非常快速的迭代试错,一年内做死好几个项目是经常有的事情。这个时候AI工作站的优势就来了:

我回家后仔细研究了下这个AI工作站的介绍,发现还有一个很牛逼的地方,在于这东西还可以内置一套模型部署平台,开箱即用。

做模型微调比如Llama 3 70B 妥妥滴没有问题,同时也是提示工程、RAG项目开发的理想平台。

对AI创业公司来说,简直不要太香。这比去外面花两三倍的价钱买个机房供养版的裸GPU服务器舒适多了!

我还找到了关于这个工作站的配置选购图,显卡可以选1卡、2卡、4卡。

买卡是一件需要谨慎再慎重的事,最终还是得从实际需求出发,选出性价比更高的组合方案,才能省钱又出活,尤其是考虑成本、系统稳定性和长期需求。AI 工作站的模式,看到这里的小伙伴,可以去了解一下。

文章来源于“ 夕小瑶科技说”,作者“夕小瑶编辑部”

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner