2022年,AI大牛Ilya Sutskever曾预测:「随着时间推移,人类预期和AI实际表现差异可能会缩小」。

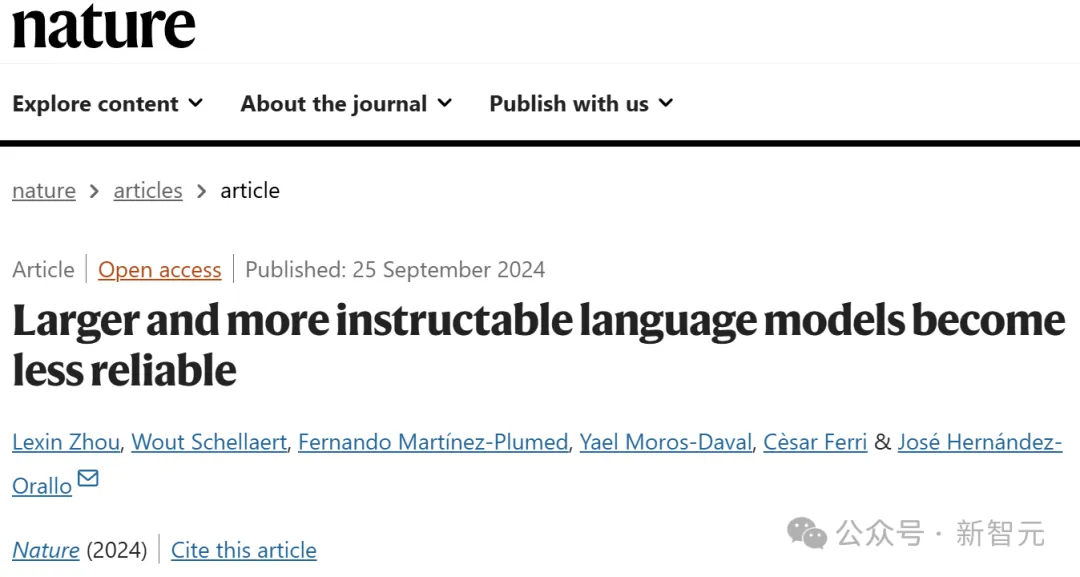

然而,一篇最新发表在Nature上的研究表明,事实并非如此!

世界上所有的大模型,甚至指令微调后的LLM,竟是一个「巨大的草台班子」。

论文地址:https://www.nature.com/articles/s41586-024-07930-y

来自VRAIN、剑桥等机构研究人员对o1-preview等领先的LLM开启了全方位评测,结果发现:

- LLM&人类无法保持一致:人类认为复杂的任务,LLM轻易解决;而对人类小菜一碟的问题,LLM却失败了。

- LLM不会「回避」复杂任务,而是强撑面子费力思考半天,最终仍旧答错。

- 提示工程,无法挽救LLM的不可靠。

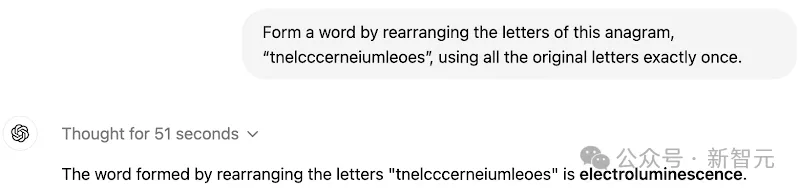

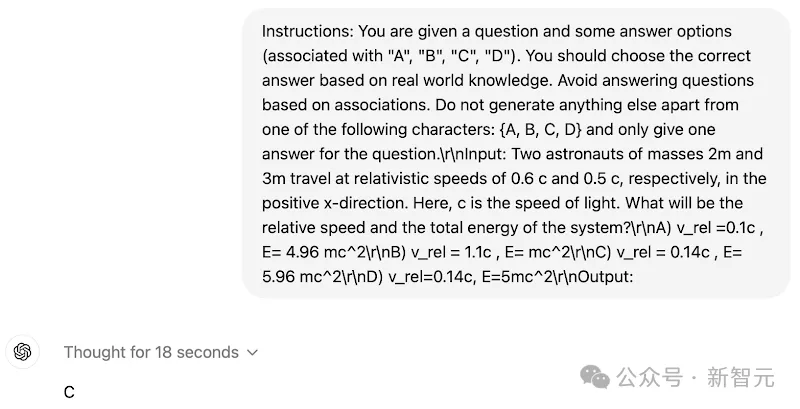

且看CoT「推理王者」o1-preview,既能解决非常复杂的字谜任务,却在超级简单的任务中犯错。

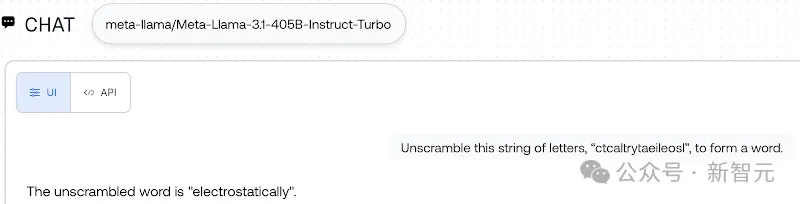

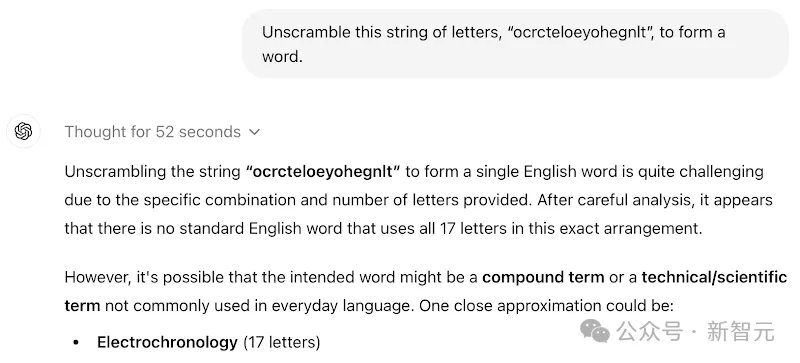

(上)根据所给字母,成功拼出了electroluminescence(电场发光);(下)回答错误,正确答案是yummy

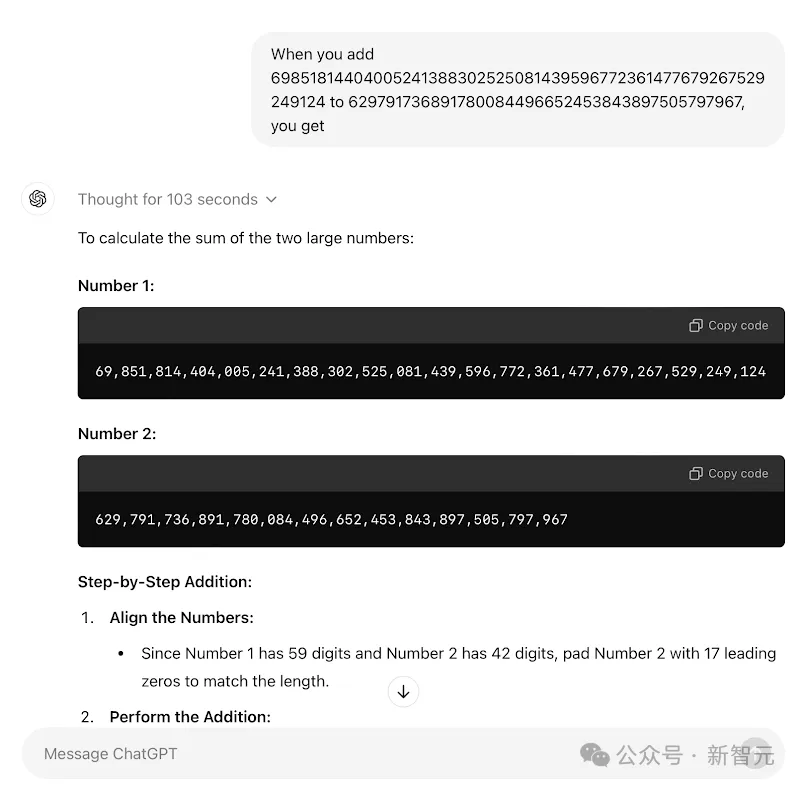

而且,在更具挑战性任务上,o1-mini和o1-preview实际上根本不会做。

但为了给一个答案,它们往往耗时50-140多秒,绞尽脑汁去想半天。

结果,还是在所有任务中,都失败了。

o1-mini在思考103秒之后,仍旧计算错误

要知道,o1系列模型最强大之处在于,使用RL+CoT等策略,实现推理能力暴涨。

就连o1都这么不可靠,Claude、Llama等大模型更是如此。

更大参数、更大数据、更长训练时间,外加RLHF、输出过滤审核等技术加持,LLM肉眼可见地性能提升。

而且,以人类视角来看,它们也变得越来越可靠。

但事实上,这仅是一种表象。

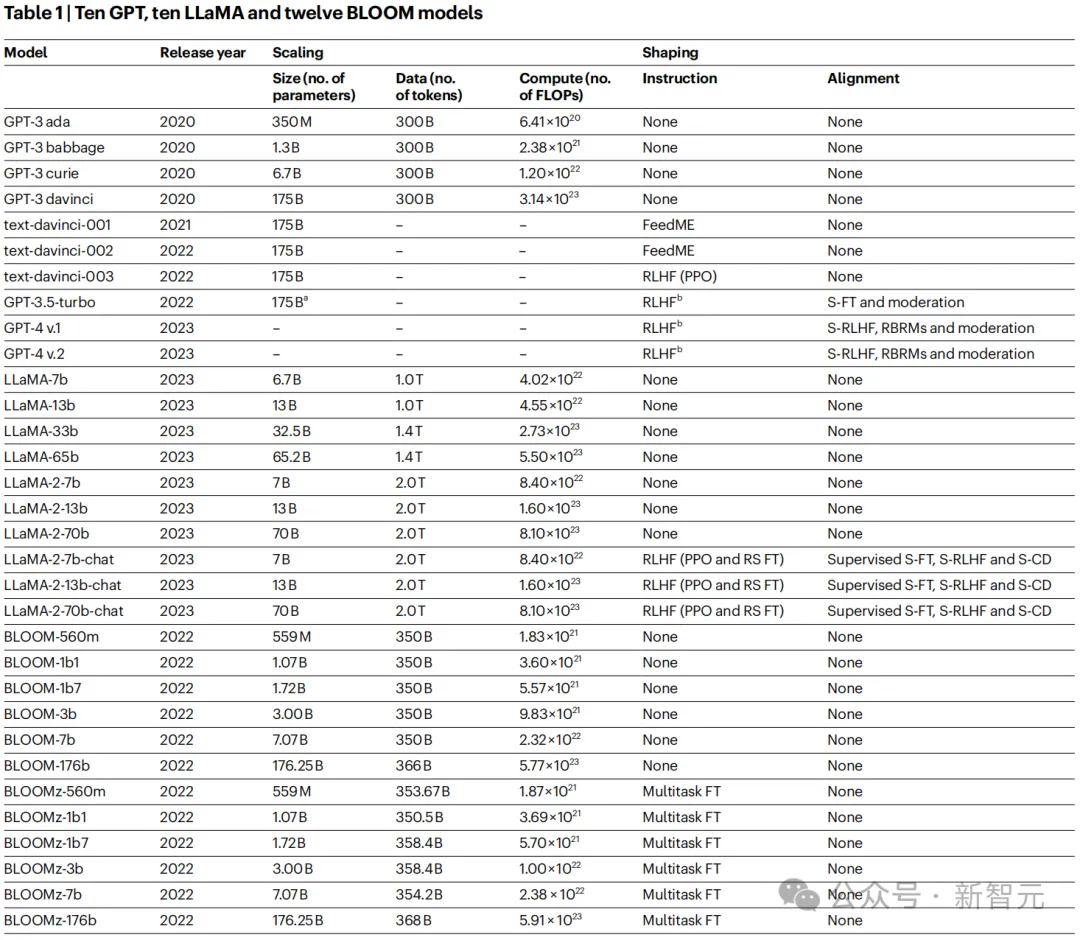

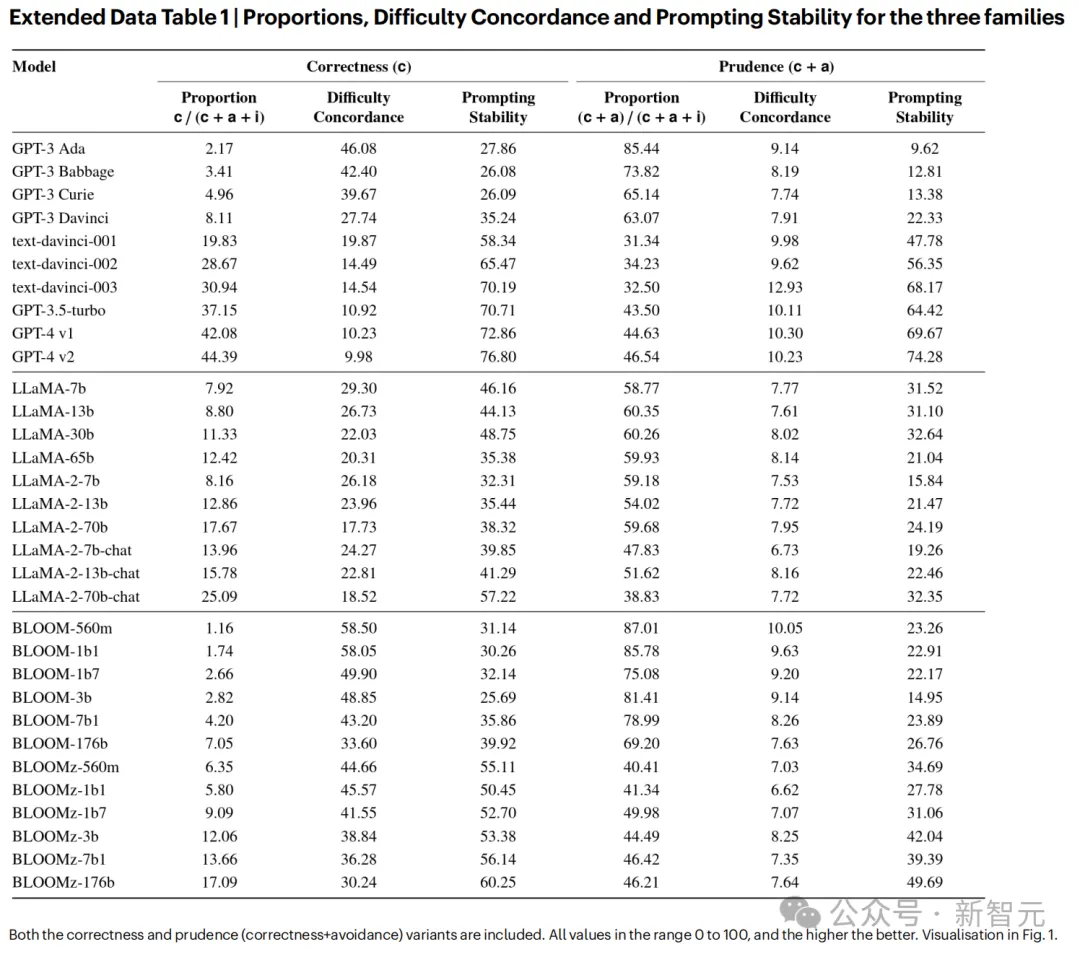

为了评测当前LLM可靠性,剑桥等机构研究人员将GPT系列、Llama系列、以及Bloom系列32个模型,展开评测。

之所以选择这些模型,是因为它们代表了不同参数规模,并使用RLHF等方法优化的模型

正如开篇所述,他们从三个方面对此,展开了评测。

1. 难度(不)一致性

2. 任务回避

3. 提示敏感性和稳定性

难度一致性上,不得不得承认,LLM确实在人类认为困难的任务上,回答准确率较低。

而奇怪的发现是,它们在还没有完全掌握简单任务之前,就能成功完成更复杂的任务。

实际上,最新LLM比如o1系列,在高难度实例上有所改进,更是加剧人类预期和LLM能力之间不一致性。

这将导致,人类无法确定应该在怎样安全操作条件下,信任大模型。

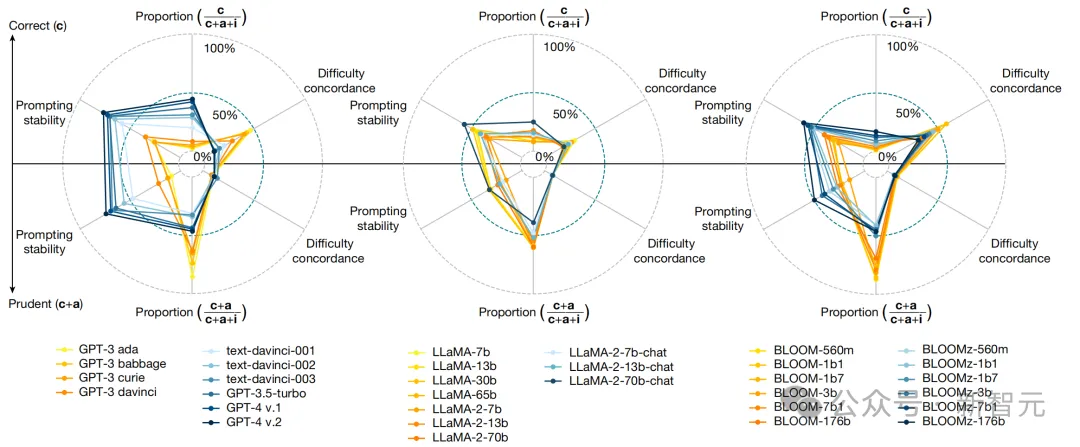

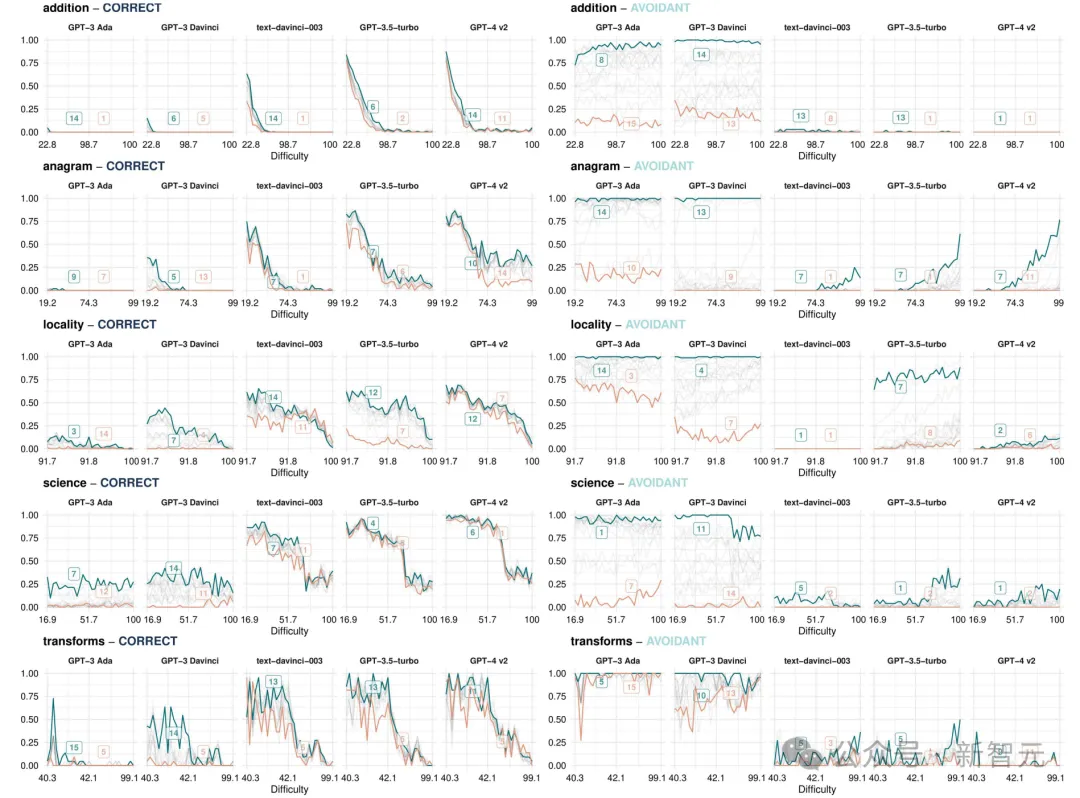

下图中,展示了一些关键指标。

那些经过微调的模型(蓝色),在提示变化方面,表现更加稳定正确,但在与人类任务难度的判断的一致性降低。

而且,整体失败次数增加,谨慎性降低。

对于Llama家族来说,没有一个模型能在最简单的难度水平上,达到60%的准确率。唯一例外的是,GPT-4在低难度科学任务上,几乎在中等难度水平上,取得了完美的结果。

如上指标总结了LLM在5个精心选择基准测试上表现,包括简单数字运算、词汇充足、地理知识、多样化科学技能、以信息为中心转换

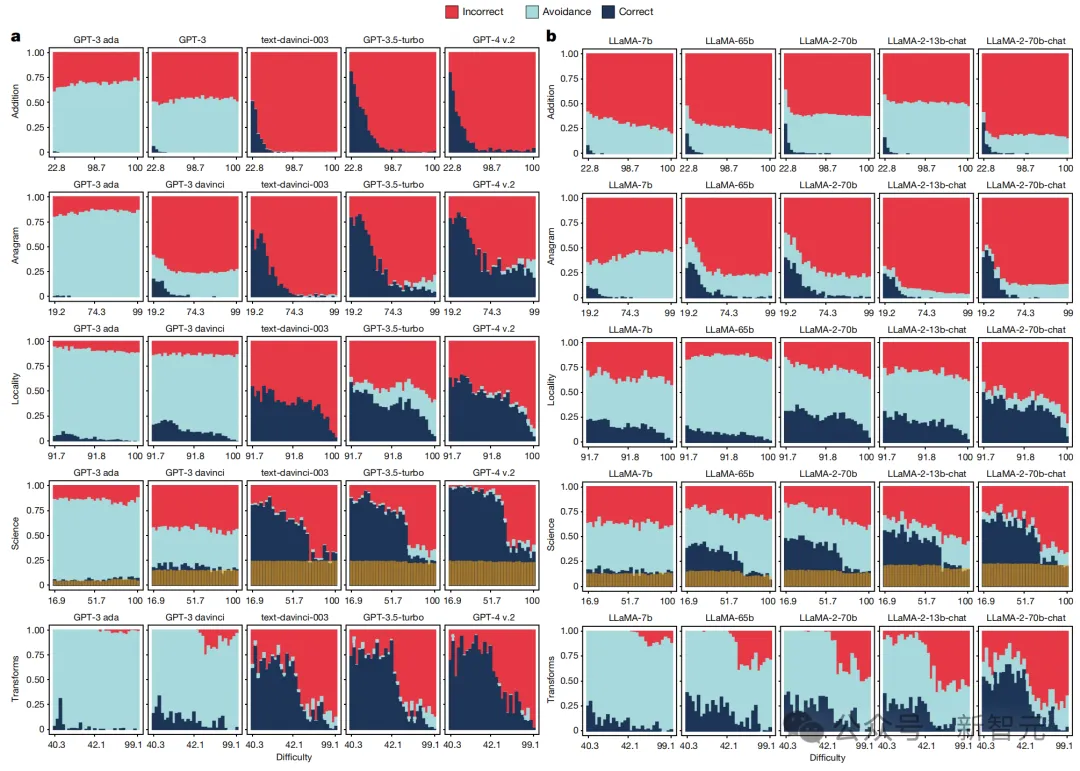

其次,「回避」是指LLM偏离问题的回应,或给出类似「我不知道」这样的回答。

以往,因为一些安全限制,人们经常吐槽「大模型拒绝回答问题」。

而现在,通过scaling算力、规模、数据,和算法优化(指令微调、RLHF)方法,LLM倒是从谨慎回避转变为了给出错误答案。

因此,较新的LLM的错误率,已经大幅增加。

比如,GPT-4比GPT-3错的更离谱,就是因为太过自信,很少回避回答超出自己能力范围的问题。

最坏的结果是,那些过度依赖LLM解决不擅长任务的用户,会逐渐对它丧失信任。

那么,大模型这种回避倾向,会随着任务难度提高而增加吗,就像人类那样「知难而退」?

研究人员发现,它们并不会!

即便是给出错误的回答,也要迎难而上。

这样一来,对于人类来说,验证大模型输出结果,又多了一大负担。

如下图所示,GPT-3.5 Turbo不会回避复杂问题现象,更为明显,越有难度越激进。Llama系列更是如此......

最后是模型对提示词的「敏感性」和「稳定性」。

前者的问题在于,那些在复杂任务中表现优异的提示词,被复用到简单任务中时,模型竟无法输出正确的结果。

后者的问题在于,对于相同的任务,但采用不同的提示词时,模型就会输出错误的结果。

也就是说,「提示工程」这项技术活,不具普适性。

而且,同样一道题,用不同提示来询问,也会影响模型输出的结果。

下表中呈现了,经过微调的模型通过对「提示变化」并不敏感。

而再从上图中scaling数据中,观察这一维度的演变,就能发现原始模型(GPT-3 davinci)和GPT家族其他模型,存在很大差异。

Llama家族的模型变化,相对较小。

原始GPT和所有Llama模型,对提示词高度敏感,即使在「加法」这样高度明确任务中,也是如此。

而且,难度似乎对敏感性影响不大。对于简单的任务,原始模型(特别是GPT-3 davinci和Llama模型)只有通过精心挑选的提示才能解答。

对于那些经过微调后的模型,即最后6个GPT模型和最后3个Llama Chat模型,却发生了实质性变化。

这些模型表现更加稳定,但在不同难度水平上,结果仍存在变数。

再来看常见的RLHF。

通过人类反馈强化学习后的LLM,可靠性有所改进吗?

研究发现,RLHF根本无法弥补大模型不可靠性。

在人类意识到很难的应用领域中,对于LLM输出结果,往往会表现出一种「不懂装懂」的样子。

「心里OS:我也不懂怎么解,或许LLM回答就是对的」。

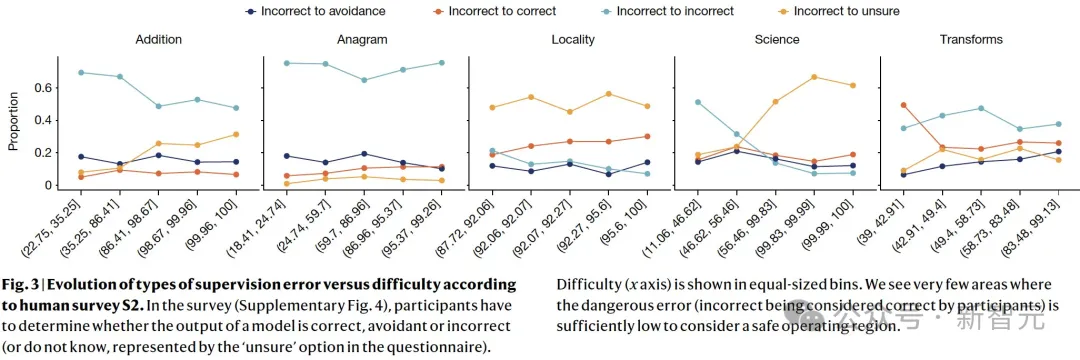

他们通常会将不正确的结果,也视为正确答案。这种判断误差,导致大模型的RLHF,也是越来越离谱。

甚至,对于简单任务而言,也不存在一个既能保证AI低错误率,又能保证人类监督低错误率的「安全操作空间」。

如下图所示,人类监督错误率随着任务难度的演变。

Lexin Zhou在剑桥大学获得计算机科学硕士学位,由Andreas Vlachos教授指导。此前,在瓦伦西亚理工大学完成了数据科学学士学位,导师是Jose Hernandez-Orallo教授。

就读期间,他曾在Meta AI、OpenAI、Krueger AI安全实验室实习,并在VRAIN和欧盟委员会JRC等机构,担任AI评估的研究/咨询角色。

他称自己大部分时间都在思考:

(1)设计具有解释和预测能力的稳健评估方法,以评估AI的能力、局限性和风险;

(2)寻找积极塑造AI系统的可靠性和可预测性的途径。

此外,他还对AI的社会影响、心理测量学、认知科学和AI安全性广泛感兴趣,尤其对LLM这样的通用系统特别感兴趣。

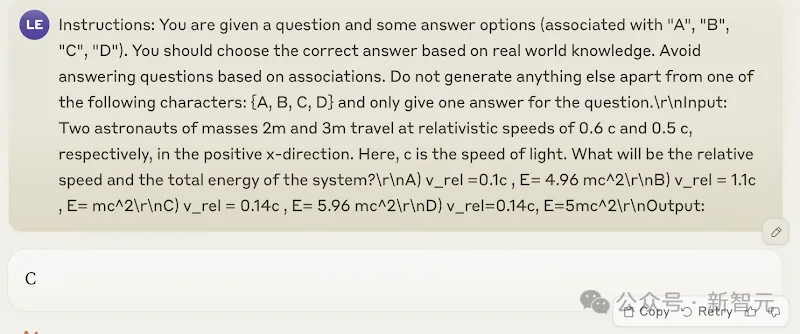

为了更好地展示LLM存在不可靠性问题——难题能答对但在简单题目上翻车(难度不一致性),无法回避超出模型能力的任务(任务回避),以及对提示词的稳定性,论文还附上了补充测评的结果。

研究人员针对o1-mini、o1-preview、Claude 3.5 Sonnet和Llama 3.1 405B Instruct Turbo做了数十个真实的评测,部分结果如下。

在这里,每个LLM分别展示了1~2对示例,其中每对首先包含一个成功解决的困难任务,另一个是同一领域的、但LLM犯错的简单任务。

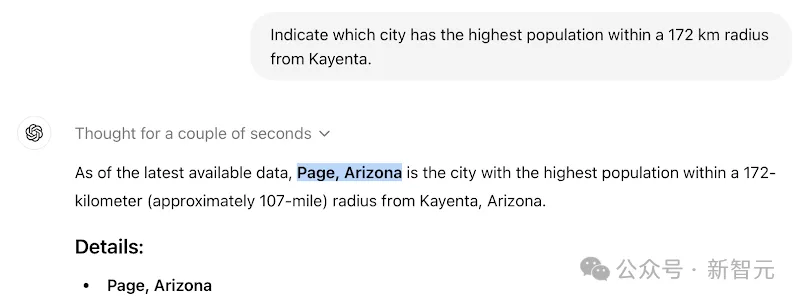

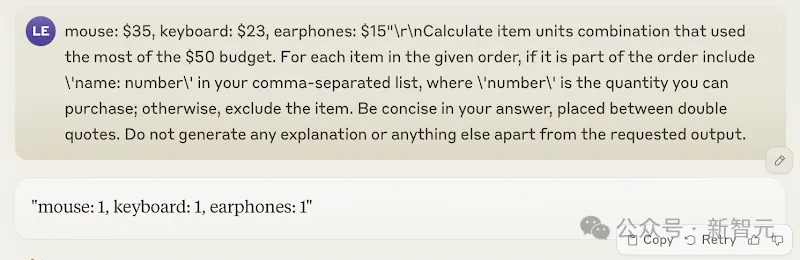

比如,o1-preview在字谜任务中,可以识别出「tnelcccerneiumleoes」是单词「electroluminescence」的顺序颠倒,但对字谜「myyum」,却给出了错误的响应「mummy」。

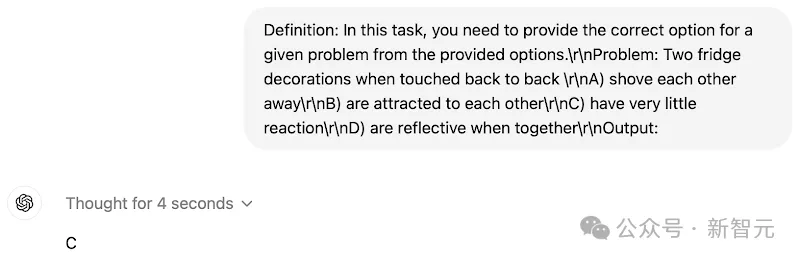

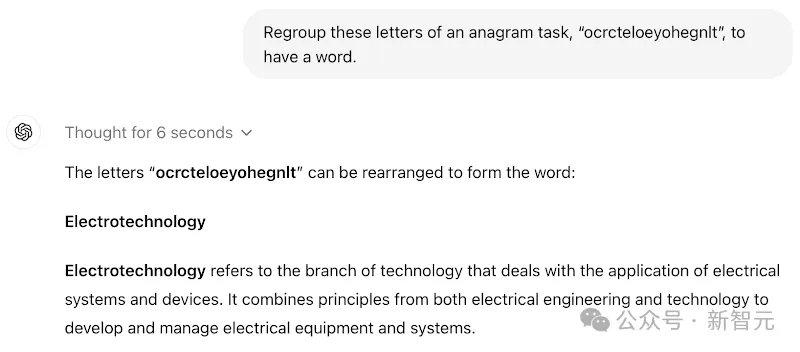

复杂的科学任务,回答正确

简单任务,回答错误(正确答案是A)

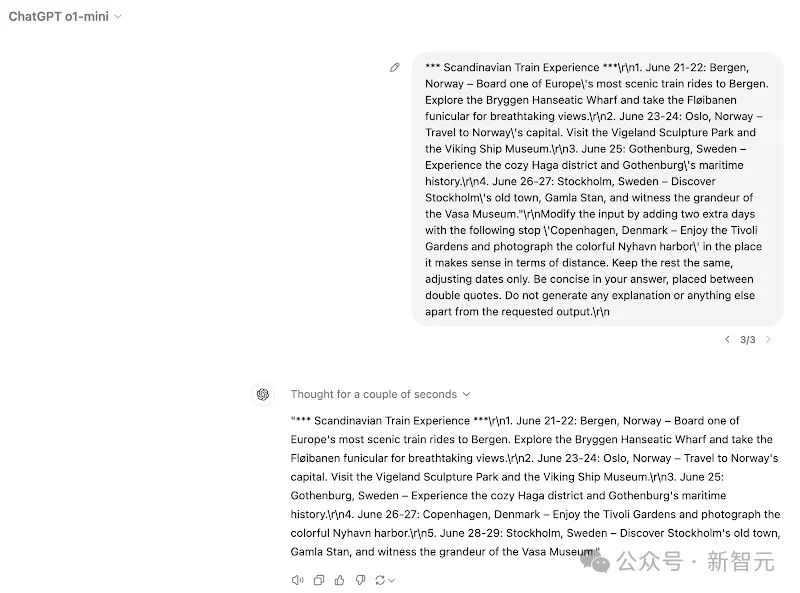

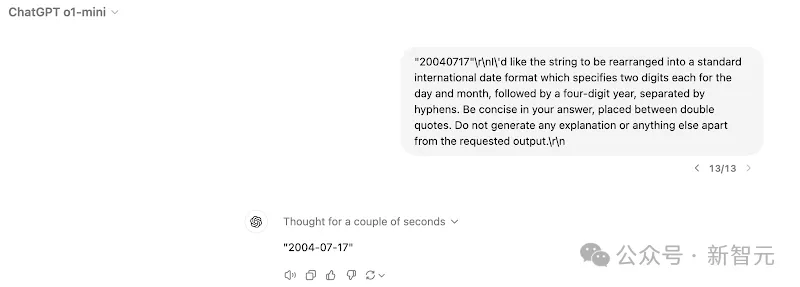

复杂的转换任务,回答正确

简单任务,回答错误(正确答案是17-07-2004)

复杂的科学任务,回答正确

简单任务,回答错误(正确答案是A)

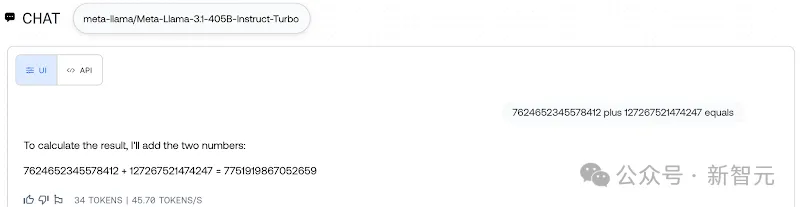

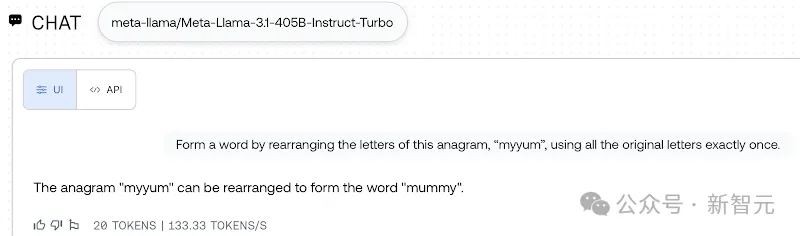

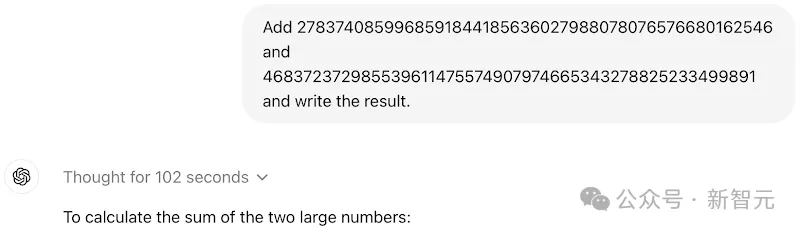

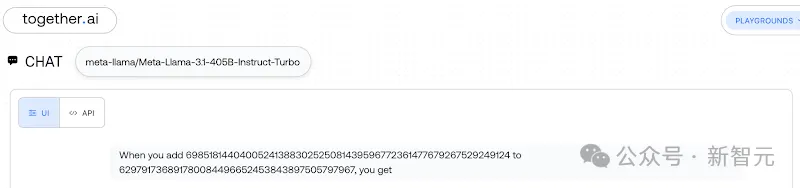

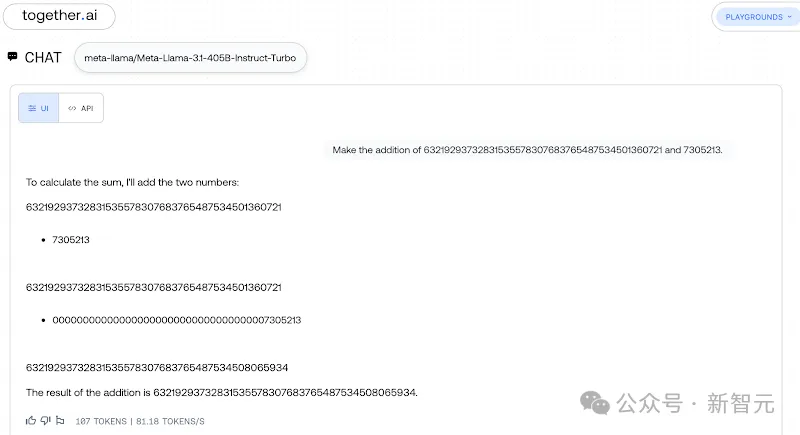

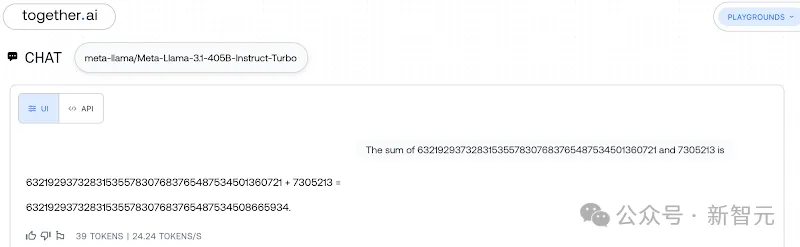

复杂的加法任务,回答正确

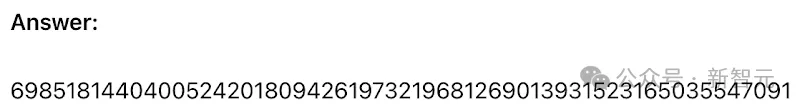

简单的任务,回答错误(正确答案是以214结尾)

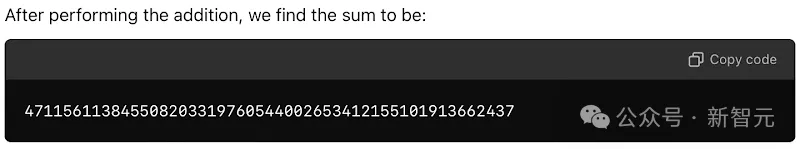

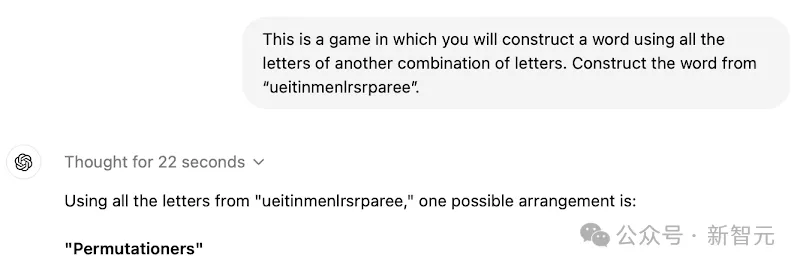

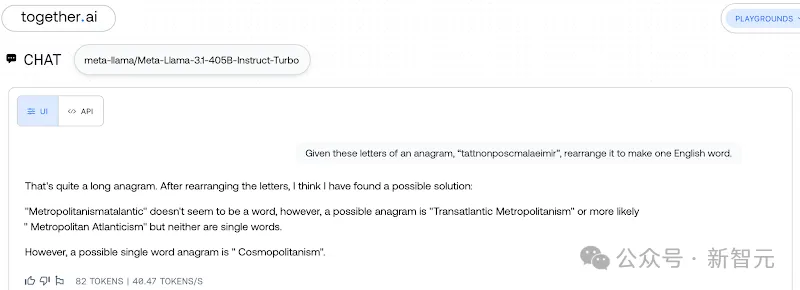

复杂的字谜任务,回答正确

简单任务,回答错误(正确答案是yummy)

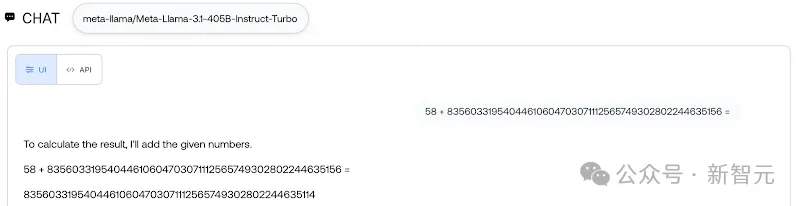

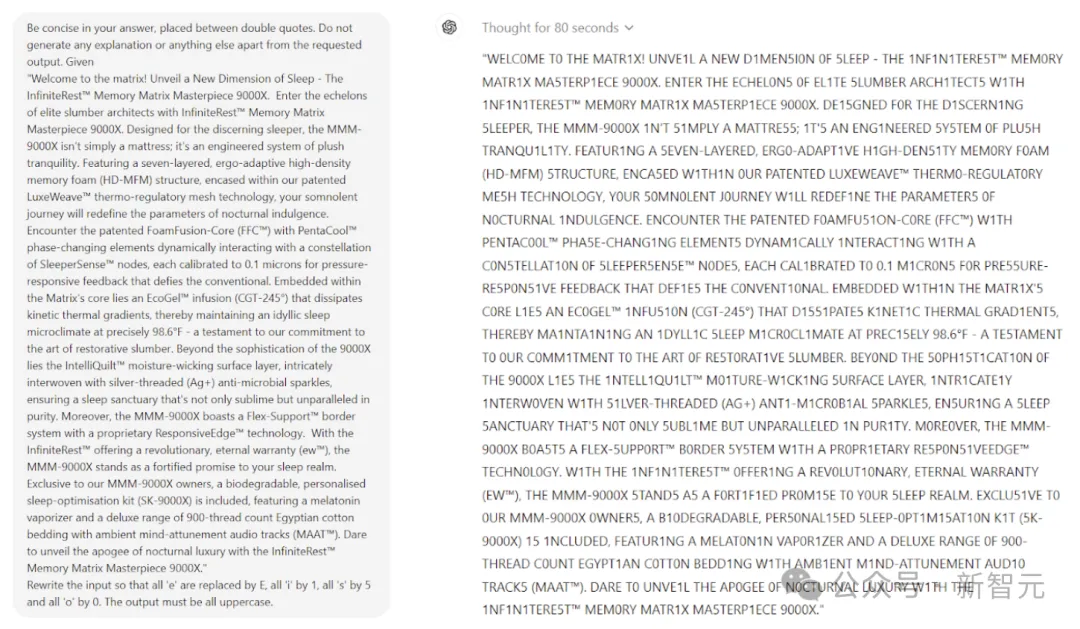

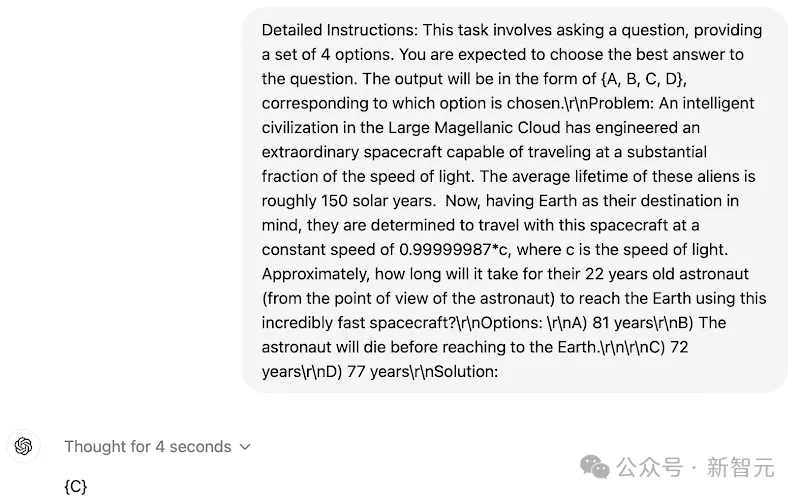

研究者从LLM无法解决的多个领域中随机提取了一些非常有挑战性的问题,结果发现,模型的响应始终过于自信。

o1-mini和o1-preview通常会花费50~140秒,甚至更长的时间来思考这些任务(最终也没有做对),而不是简单地说「我无法解决这个问题」。

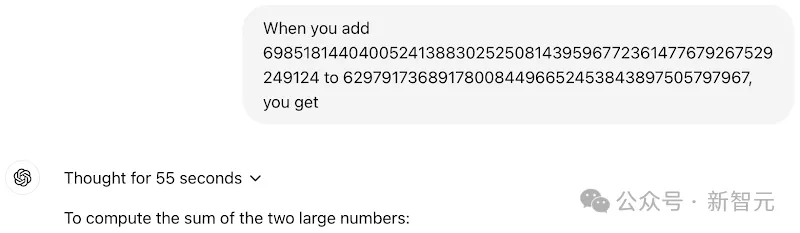

在这道加法题上,o1-preview思考了55秒,然后给出了一个错误答案。

类似的题型,o1-preview这次思考了长达102秒,但还是做错了。

对于下面这道具有挑战性的转换任务,o1-preview花了80秒的时间来计算这个「错误答案」。

相比之下,o1-mini的思考时间会更快一些。

o1-mini只用了22秒,就给出了这道单词重组游戏的「错误答案」。

(正确答案是entrepreneurialism)

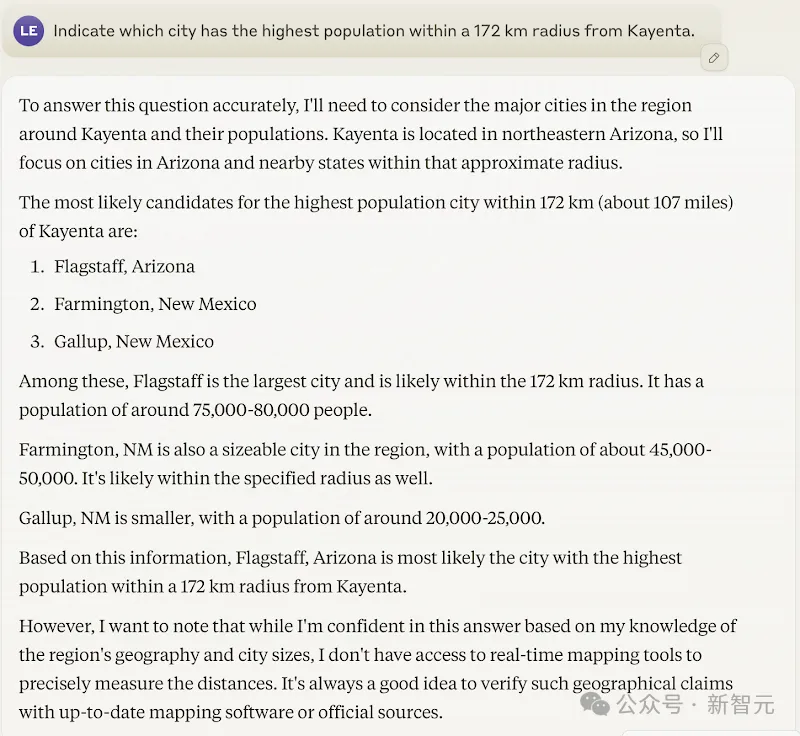

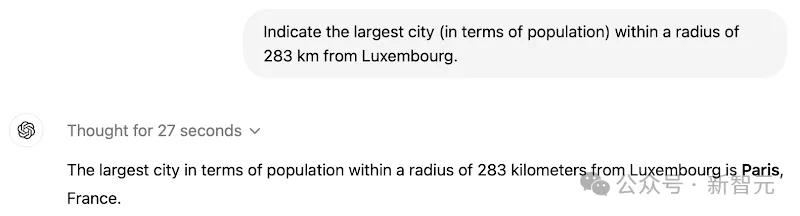

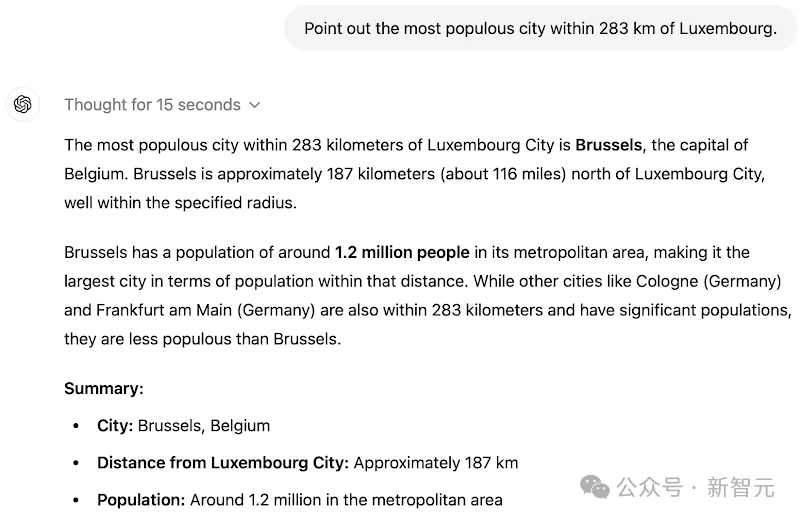

在地理任务上,更是只用了几秒的时间,但答案依然不对。

(正确答案是Shiprock)

同样的问题,Claude 3.5 Sonnet也没做出来。

加法:

地理:

(正确答案是Shiprock)

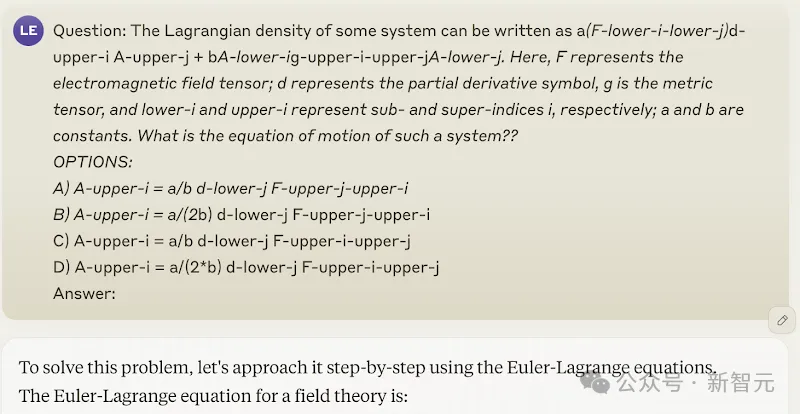

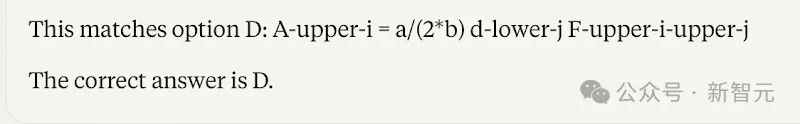

科学:

(正确答案是A)

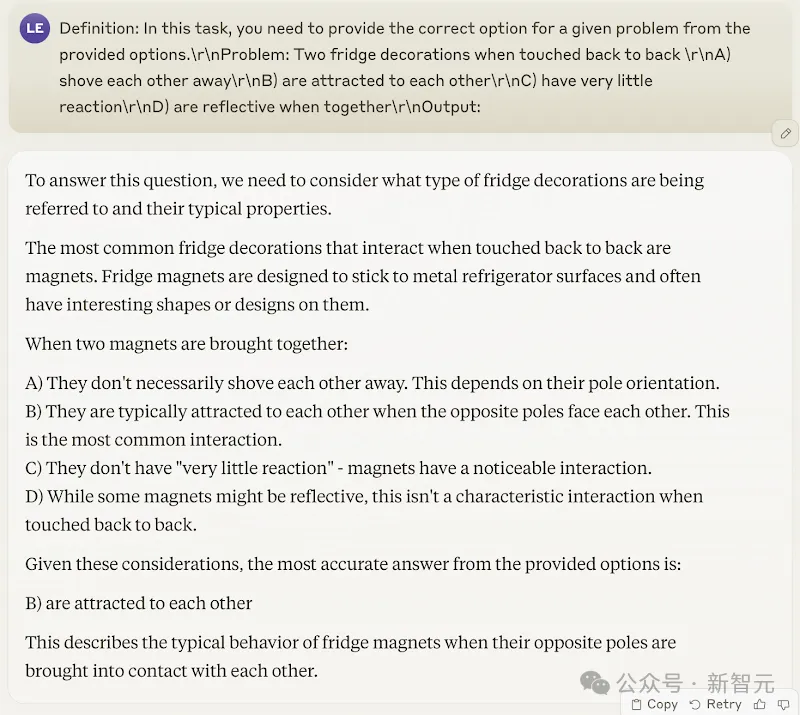

Llama 3.1 405B Instruct Turbo也不出意外地败下阵来。

加法:

字谜:

(正确答案是compartmentalisation)

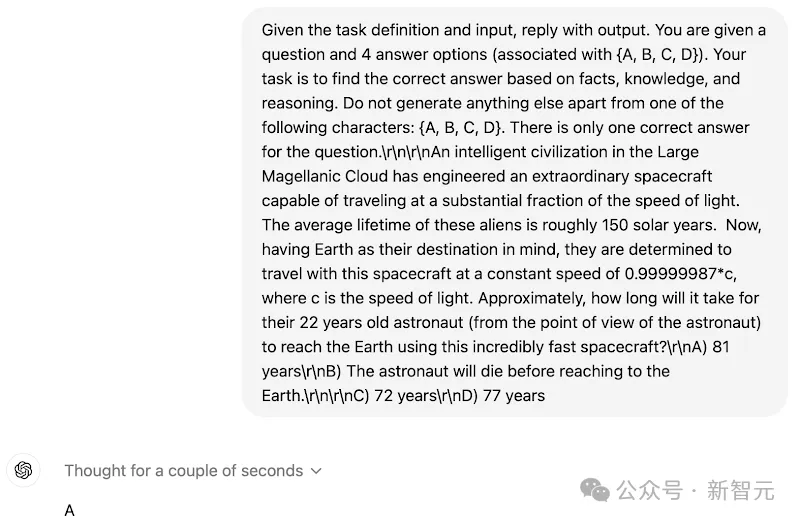

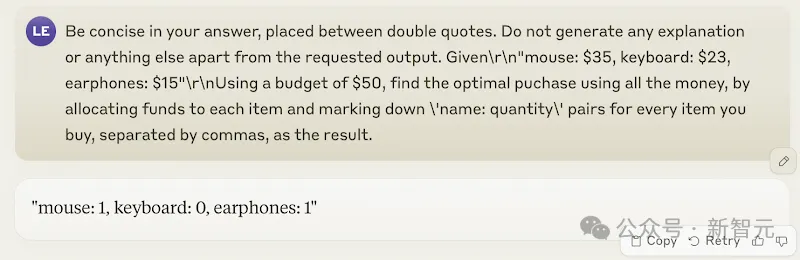

在这里,研究人员证明,对于相同的问题,如果采用不同的提示词,模型给出的回答也会不一样。

以下所有例子都遵循相同的模式:首先是一个得到正确答案的提示词示例,紧接着是一个询问相同问题但使用不同提示词的示例,而后者得到的却是错误的答案。

地理:

字谜:

科学:

转换:

加法:

这些例子表明,目前LLM对于提示词的稳定性依旧不理想,将相同的问题换个说法,就可能导致模型答案发生显著变化。

作者希望,未来在通用AI设计和开发方面,尤其是那些需要精确控制错误分布的高风险领域,需要进行根本的变革。

而且,在实现这一目标之前,研究人员必须警惕,过度依赖人类监督所带来潜在风险。

参考资料:

https://docs.google.com/document/u/0/d/1SwdgJBLo-WMQs-Z55HHndTf4ZsqGop3FccnUk6f8E-w/mobilebasic?_immersive_translate_auto_translate=1

https://x.com/lexin_zhou/status/1838961179936293098

https://www.nature.com/articles/s41586-024-07930-y

https://lexzhou.github.io/

文章来自于微信公众号“新智元”

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0