当奥特曼、马斯克、Anthropic CEO都纷纷将AGI实现锚定在2026年前后,LeCun无疑是直接浇了冷水:完全是胡说八道。

最新的公开演讲中,他表示,系统要推理、规划和理解物理世界,至少还需要几年甚至十年的时间,这时候人工智能才能达到人类水平。

他还透露,现在Meta基本已经放弃纯语言模型,因为,仅通过文本训练,永远不会达到接近人类水平的智能。

除此之外,他还谈到当前大模型的局限性、以目标驱动的AI架构,包括利用世界模型进行推理和规划,最后强调了开源AI的重要性。对于未来发展,他提到,最终机器将超越人类智能,但它们将受到控制,因为它们是目标驱动的。

在不改变原意基础上,量子位做了如下整理。

(一上来,他解释了FAIR中的“F”,不再意味着Facebook,而是代表“基础的”意思)。

让我们来探讨一下人类级别的人工智能,以及我们如何实现它,或者为什么我们可能无法做到这一点。

首先,我们确实需要达到人类水平的人工智能。

在未来,大多数人可能会戴上智能眼镜或其他设备,并与它们进行交流。这些设备将集成各种助手功能,可能不仅仅是一个,而是一整套系统。这意味着我们每个人都将拥有一群智能虚拟助手。因此,每个人都将成为“老板”,只不过这些“员工”并非真正的人类。我们需要构建这样的系统,以基本提升人类的智能,让人们变得更具创造力、更高效。

然而,要实现这一目标,我们需要机器能够理解世界、记忆信息、拥有直觉、具备常识、能够进行推理和规划,并且达到与人类相同的水平。

尽管你可能从一些支持者那里听到过不同的观点,但目前的人工智能系统还无法实现这些功能。因此,我们需要开发能够学习并模拟世界基本运作的系统,这些系统需要拥有对世界如何运作的心理模型。实际上,每只动物,包括你的猫,都拥有一个比任何现有人工智能系统都要复杂的模型。

我们需要的系统应该具备持久的记忆能力(这是当前语言模型所缺乏的),能够规划复杂的动作序列(这也是目前的语言模型所做不到的),并且必须是可控和安全的。

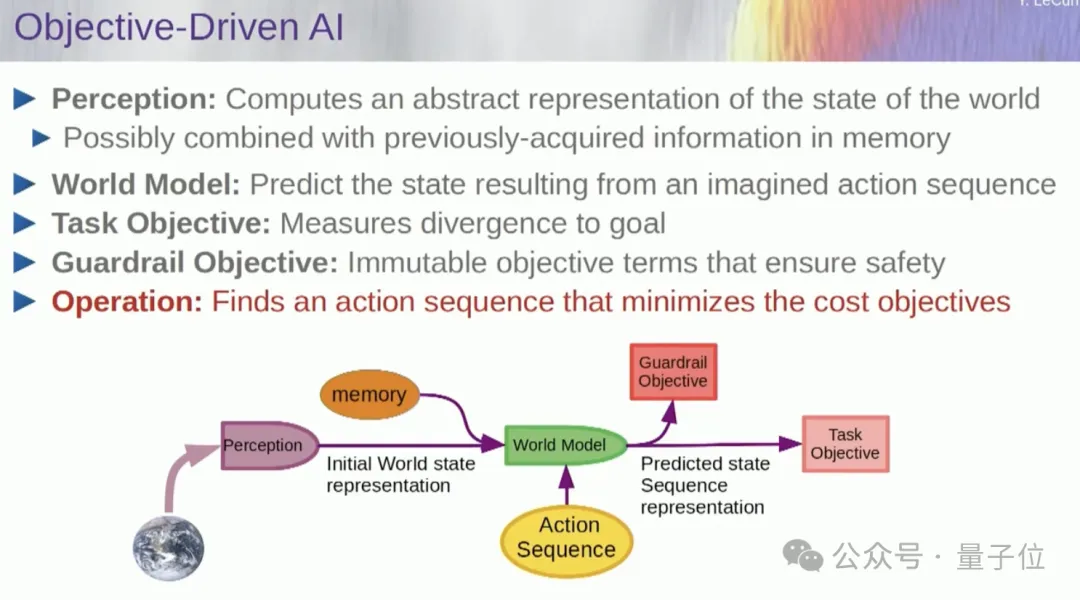

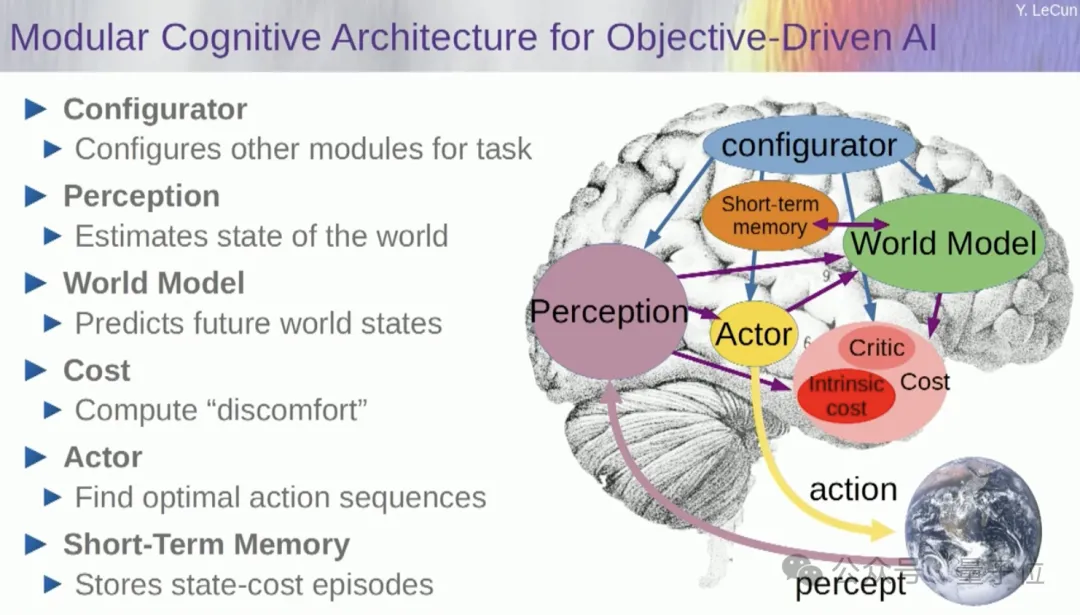

为此,我曾在两年前一篇论文中提出过一个愿景:目标驱动的人工智能。

FAIR的许多成员都在努力实现这一构想,但一年半前,Meta成立了一个名为GenAI的产品部门,专注于人工智能产品的研发。因此,FAIR现在被重新定位为开发更长期的下一代人工智能系统。我们基本上不再专注于语言模型。

人工智能的成功,包括语言模型和其他许多系统,在过去五六年里,主要依赖于自监督学习技术。

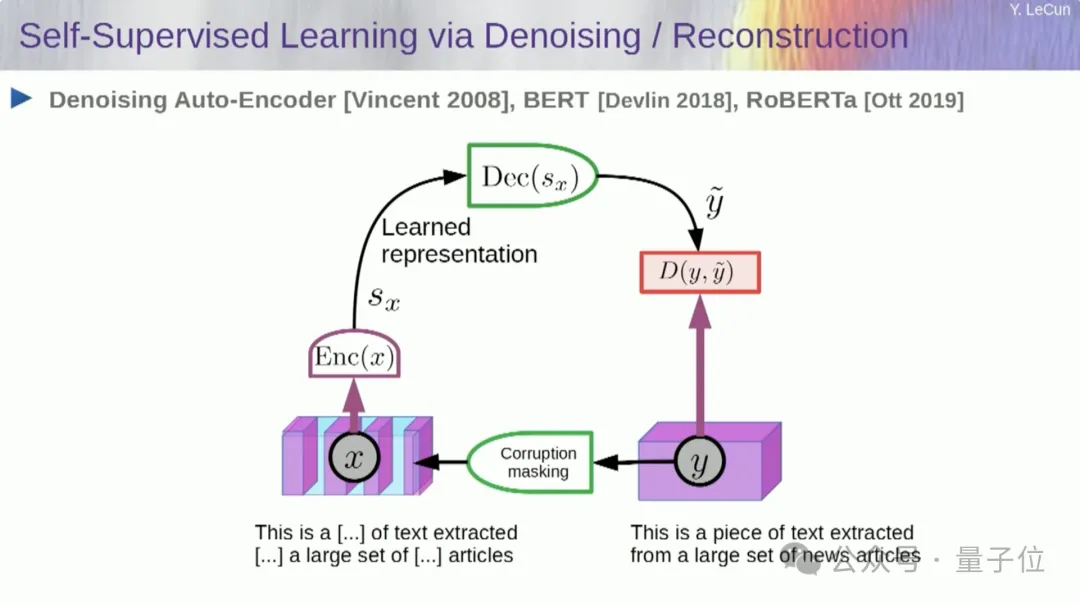

自监督学习的一种方法是通过损坏再重建恢复。例如,你可以取一段文本,通过删除单词或更改其他单词来损坏它,这可以是文本、DNA序列、蛋白质或其他任何东西,甚至在一定程度上可以是图像。然后,你训练一个大型神经网络来重建完整的、未损坏的输入版本。

这是一个生成模型,因为它试图重建原始信号。

因此,这个红色框就像一个代价函数,它计算输入Y和重建的y之间的距离,这是学习过程中需要在系统中的参数上最小化的内容。在这个过程中,系统学习到输入的内部表示,可以用于各种后续任务。

语言模型就是一个特殊的例子,其架构设计为只能查看左边的其他标记来预测一个项目、一个标记或一个单词,不能看向未来。

这不是一个新概念,自克劳德·香农以来就一直存在,可以追溯到20世纪50年代。但变化的是,现在我们有巨大的神经网络架构,可以在大量数据上进行训练,由此产生原本没有的特性。

然而,自回归预测有一些主要限制,这里没有真正意义上的推理。另一个限制是,这只适用于以离散对象、符号、标记、单词等形式出现的数据,基本上你可以区分这些数据。

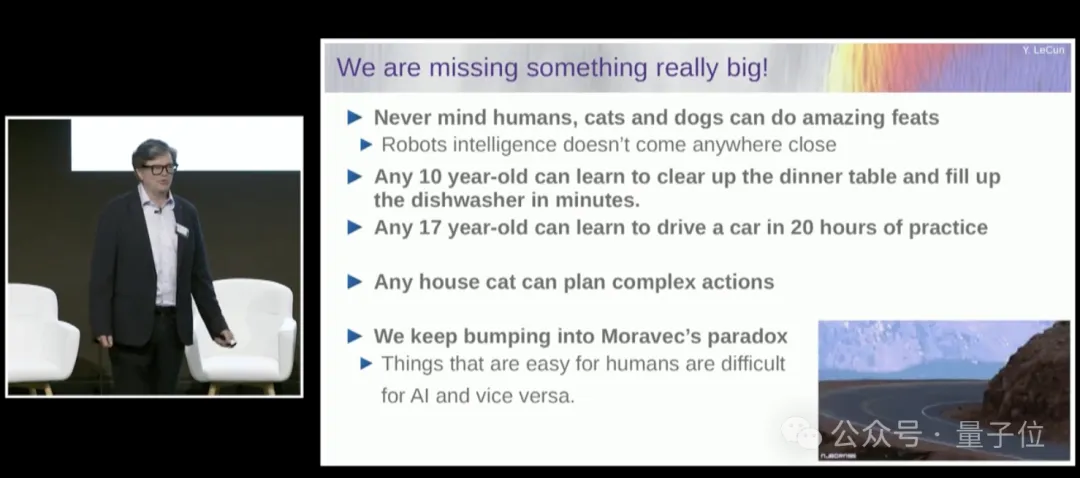

我们仍然缺少一些重要的东西才能达到人类水平的智能。

我这里不一定是在谈论人类水平的智能,但即使是你的猫或狗能做的惊人壮举,目前的人工智能系统仍然完全无法做到。10岁的孩子都能学会清理餐桌并装满洗碗机。17岁的孩子可以在大约20小时的练习中学会开车。但现在我们仍然没有L5自动驾驶汽车,我们当然也没有能够清理餐桌并装满洗碗机的家用机器人。

这是我们常遇到的莫拉维克悖论,即对我们来说看起来微不足道、我们甚至不认为是智能的事情,对机器来说却非常非常难以做到。但是,像高级复杂的抽象思维,比如操纵语言、下棋,对机器来说似乎很容易。

也许其中一个原因在于,一个语言模型通常在20万亿个token上进行训练。一个token对于一种典型语言来说,平均约为四分之三个单词,对应是1.5×10的13次方个单词、6×10的13次方个字节。我们任何人要读完所有这些文本,大约需要几十万年。这基本上是互联网上公开可用的所有文本总量。

一个四岁人类孩子清醒16000小时,200万条视神经纤维进入我们的大脑。每条纤维大约每秒携带一个字节,也许是每秒半字节,数据量大约是10的14次方个字节。

所以,一个四岁孩子看到的视觉数据与最大的语言模型在整个互联网上公开可用的文本上训练的数据量一样多。

从这当中能得出这些结论:

首先,仅通过在文本上训练,我们永远不会达到接近人类水平的智能;

其次,视觉信息非常冗余。每根视神经纤维每秒传输一个字节的信息,与视网膜中的光感受器相比,这已经实现了100:1的压缩率。随后这些信息进入大脑,并在那里被扩展了大约50倍。

冗余实际上是自监督学习所必需的。自监督学习只能从存在冗余的数据中学习到有用信息。如果数据经过高度压缩,这意味着它几乎变成了随机噪声,你将无法从中学习到任何东西。

因此,我们将不得不通过让系统基本上观看视频或在现实世界中进行体验来训练它,以学习常识和物理知识。

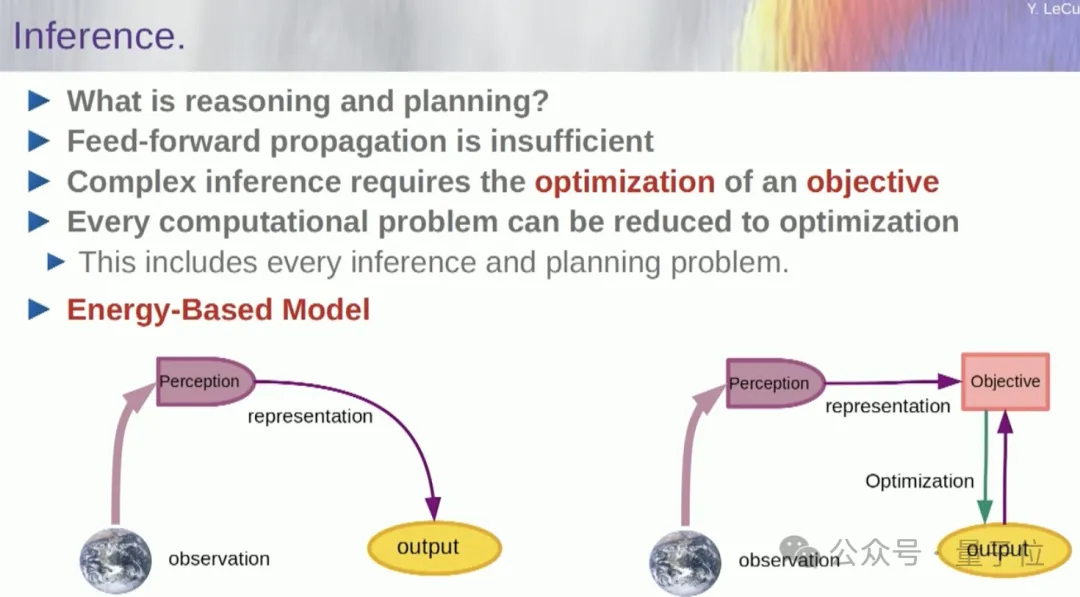

所以再来说说这个目标驱动架构是什么,它与语言模型或前馈神经网络等有着显著不同。因为在推理过程中不仅仅是神经网络在起作用,实际上它运行的是一个优化算法。

从概念上讲,它的运作方式是这样的:前馈过程是指你观察到一个输入,通过感知系统运行,比如通过一系列的神经网络层,并产生一个输出的过程。

对于任何一个单一输入,通常只有一个输出,但在很多情况下,对于一个感知输入,可能存在多种可能的输出解释。你需要的是不仅仅计算单一函数,而是能够处理单个输入对应多个输出的映射过程。

实现这一点的唯一方法是通过隐函数,基本上就是像这里的目标函数,即右侧的红色框所示,它主要用来衡量输入和提议的输出之间的兼容性,然后通过寻找与输入最匹配的输出值来计算最终输出。

你可以将这个目标想象成某种能量函数,并通过最小化这个能量来相对于输出进行优化。你可能会有多个解决方案,也可能会有一些方法来遍历这些多个解决方案。

人类的感知系统就是这样做的,如果你对一个特定的感知有多种解释,你的大脑会自发地循环遍历这些解释。

事实上这个概念非常悠久,它的历史已经超过60年。它基于优化控制理论中的一个分支——模型预测控制。在这一领域中,你可以利用你的世界模型来计算一系列控制指令的效果,然后对这些指令序列进行优化,以确保运动按照你的预期进行。所有传统的机器人运动规划都是采用这种方法,这并不是什么新鲜事物。

这里的新东西是我们要学习世界模型、能将现实世界抽象表示的感知系统。你可以构建一个具有所有这些组件的整体AI系统。

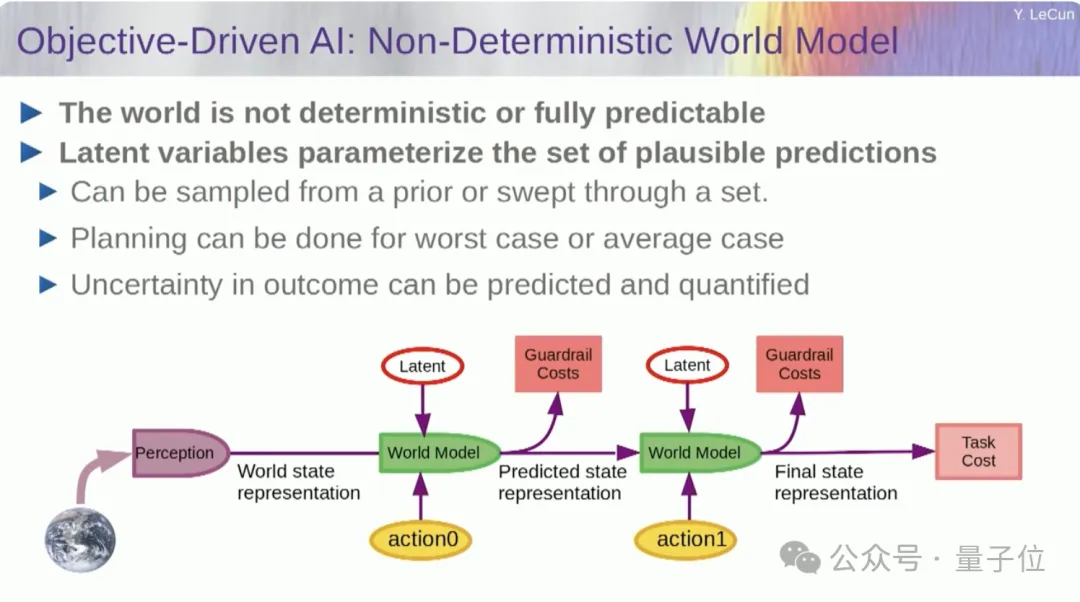

因此,如果你的行动不是一次性的,而是一个序列,并且你的世界模型是一个真实的系统,它能够告诉你在时间点T的世界状态,以及你可能采取的某个行动,预测出在时间点T+1的世界状态,那么你会想要预测在这种情况下,两个行动序列将导致什么结果。你可以通过多次运行你的世界模型来实现这一点。

然后通过反向传播和基于梯度的优化方法来找出将最小化代价的两个行动。这就是模型预测控制的基本原理。另外,世界通常不是完全确定的,你可能需要使用潜在变量来输入到你的世界模型中。

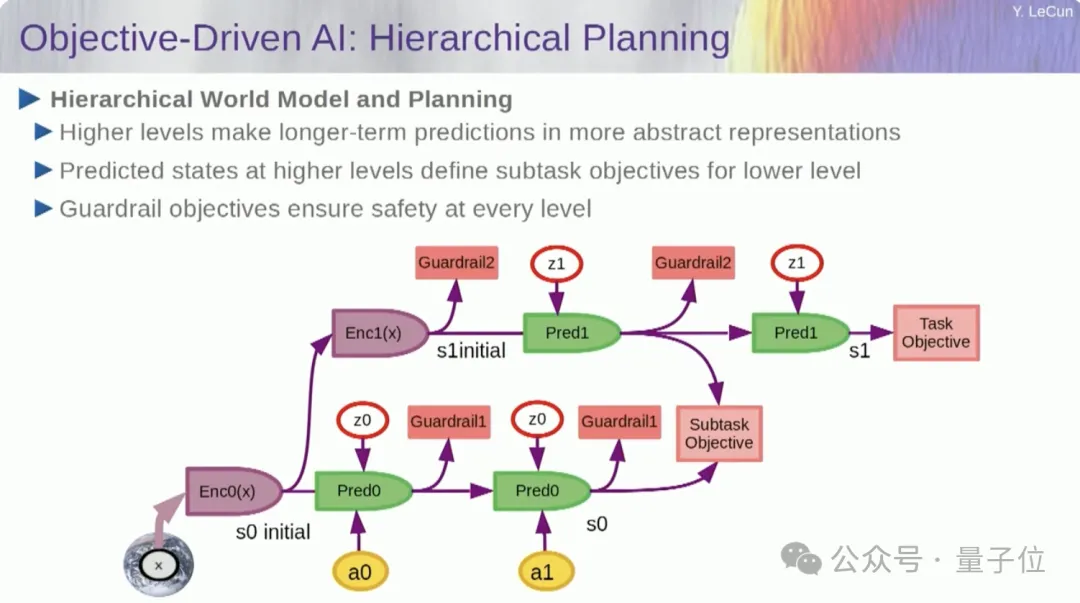

更有趣的是,智能系统目前还无法解决,但人类可以轻松做到,甚至动物也能做到的事情,那就是分层规划。

比如,你计划一段从纽约前往巴黎的旅行。理论上你可以利用你对世界、自己身体的理解,以及你对从这里到巴黎的整体世界布局的认知,来规划整个旅程,包括低层次的肌肉控制。但如果细化到考虑每10毫秒的肌肉控制步骤,那将是一个巨大的数字。

因此实际上人类采用的是分层规划的方式。你先在非常高的层次上进行规划,然后逐步细化,最后在通过低级肌肉控制来完成的具体行动。

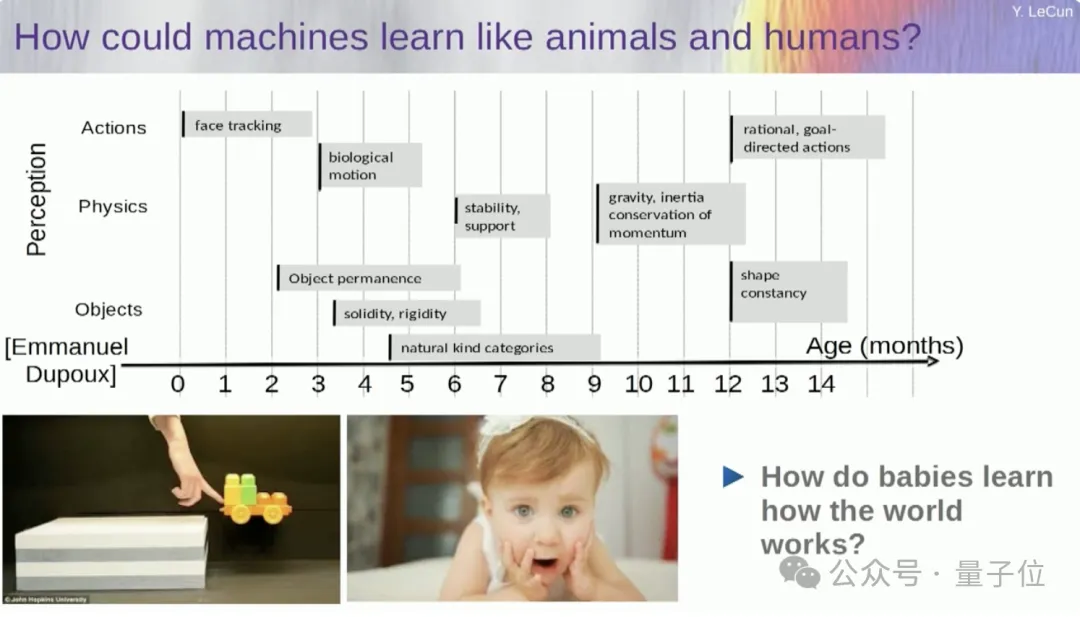

这对AI系统的确是个巨大的挑战。我过去一直在试图弄清楚婴儿在什么年龄学习关于世界的基本概念,比如像面部跟踪、生物运动等,这在他们学习语言和互动之前就已经发生了。但像重力、惯性、守恒、动量这些实际上大约在婴儿九个月左右才注意到。

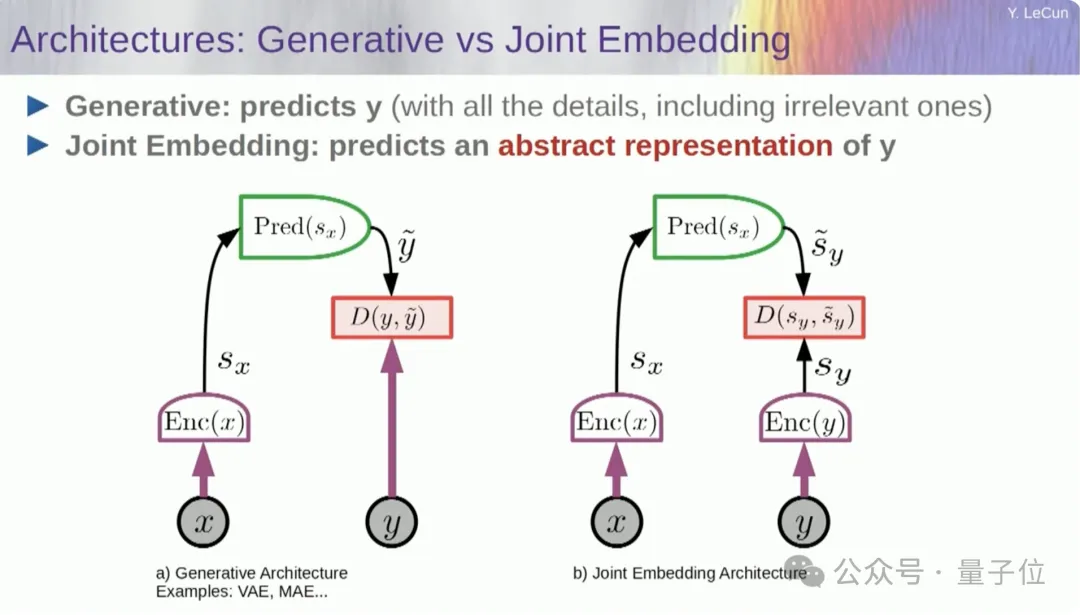

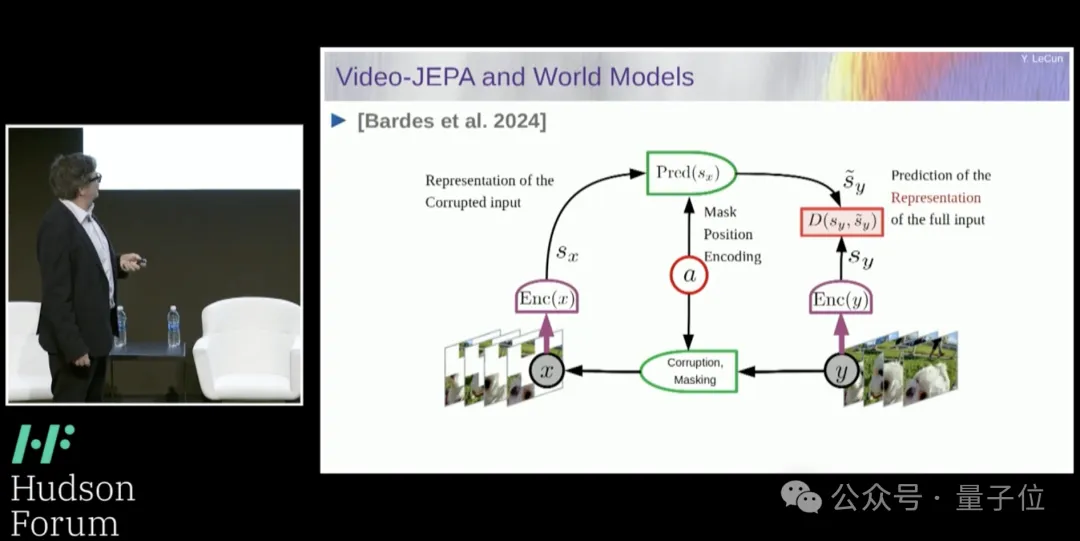

过去像通过预测文本来预测视频中的像素这种方法完全失败了,这里我们提出了一个新的解决方案,叫做联合嵌入预测架构(JEPA),也就是放弃预测像素,学习世界上正在发生的事情的抽象表示,然后在那个表示空间中进行预测。两个嵌入将被破坏的版本X送入编码器,将Y送入编码器,然后训练系统从X的表示中预测Y的表示。

那么如何做到这一点呢?

如果单纯使用梯度下降和反向传播这样的方法来训练系统,以减少预测误差,那么系统可能会失效。它可能会学习到一个恒定的表示,使得预测变得轻而易举,但却失去了信息量。

因此,我想让你记住的是,尝试重建预测器的生成架构(例如自动编码器、生成对抗网络等)与在表示空间中进行预测的联合架构之间的区别。

我认为未来在于那些联合架构。我们有大量的经验证据表明,要学习图像的良好表示,最好的方法是使用那些联合架构。

所有尝试通过重建来学习图像表示的方法都不是最佳选择,它们的成效有限。尽管有些大型项目声称这些方法有效,但实际上并非如此。真正能够带来最佳性能的是右侧的架构。

这其实与我们在智能领域所做的非常相似:找到事物或现象的良好表示,以便进行预测。这确实是科学的本质。

举个例子,如果你想预测一颗行星的轨道,行星是一个非常复杂的物体,但是你只需要知道六个参数就能实现预测:三个位置坐标和三个速度向量,仅此而已。

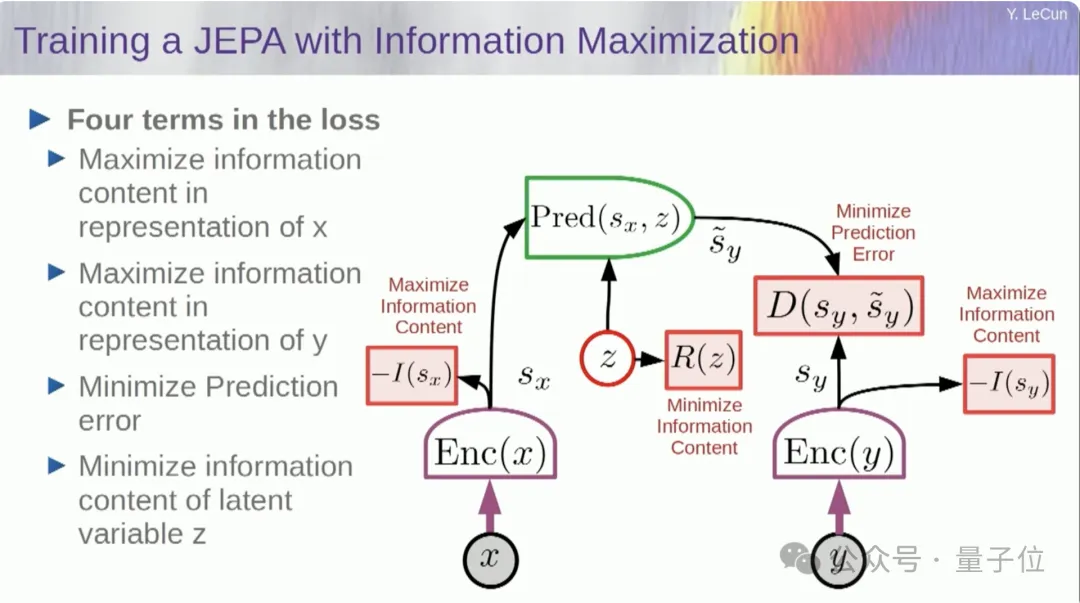

那么接下来的问题是,我们如何训练这样一个系统。

为了防止系统崩溃,一种方法是设计一种代价函数,如果你可以测量来自编码器的表示中的信息内容,并尝试最大化信息内容或最小化负信息。你希望训练系统在输入中提取尽可能多的信息,同时又要在那个表示空间中最小化预测误差。系统将在尽可能多地提取信息和不提取不可预测的信息之间找到某种平衡。

这样,你将得到一个良好的表示,在这个空间中你可以进行预测。

现在,你如何测量信息呢?这就是事情变得有些复杂的地方。

我将跳过这个部分。有一种方法可以从基于能量的模型和能量函数的训练角度在数学上理解这个问题,但我没有时间深入探讨。

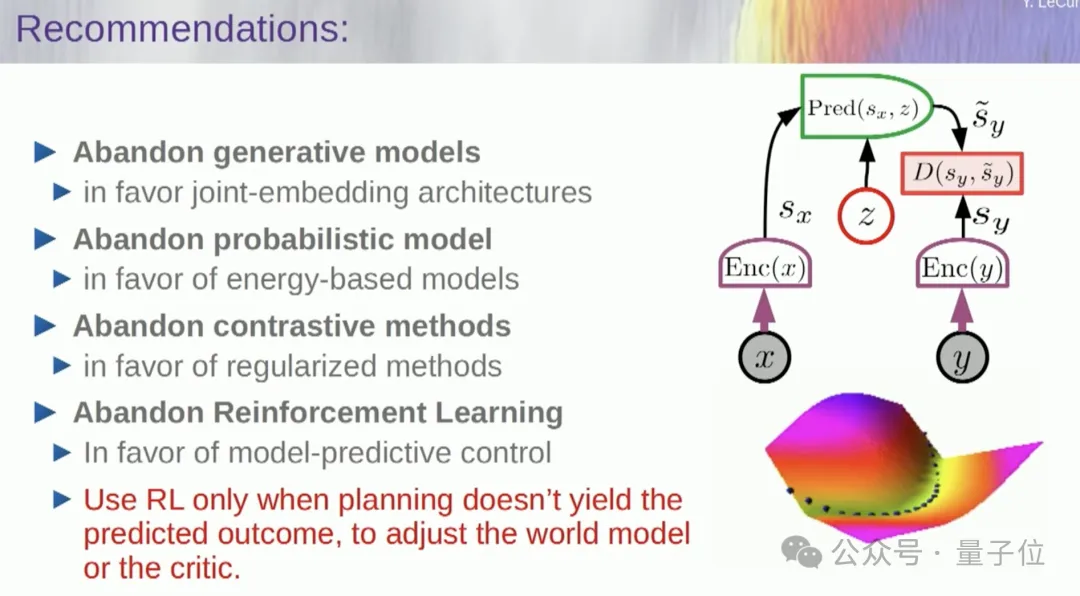

不过基本上我在这里告诉你的是,许多不同于以往认知的事情。

这些都是当今机器学习中最流行的四个主要支柱。因此目前我可能不太受欢迎。

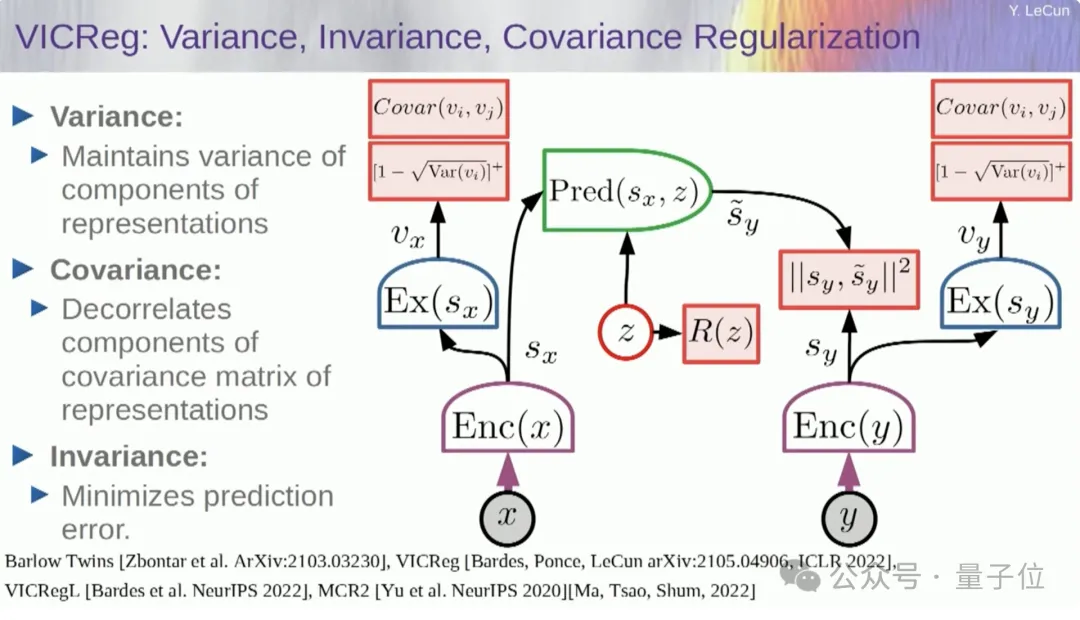

第一组方法是可以对编码器输出的信息进行估计,从而测量其信息量。目前有六种已知的方法可以实现这一目标。这里的核心思想是防止系统崩溃并只输出常数。

因此,我们要取编码器输出的变量,并确保这些变量有非零的标准差。你可以在一批样本上将这个要求纳入成本函数中,确保权重不会让变量崩溃成常数。这是相对简单的。

但现在的问题是,系统可能会“作弊”,使得所有变量变得相等或高度相关。因此,你必须添加另一个项,即最小化这些变量的协方差矩阵的非对角元素,以确保它们的独立性。

当然,这样还不够,因为变量之间可能仍然存在某种相关性。于是,我们采用了另一个技巧,即将SX的维度扩展到更高维的空间VX,然后在该空间中应用方差协方差正则化,这似乎足够了。

但这里有一个细节,我在这里最大化的是信息内容的上界,我期望实际的信息内容能随着上界的最大化而增加。我真正需要的是一个下界,这样我就可以推动下界,从而增加信息量。遗憾的是,我们目前没有信息内容的下界,或者如果有但是不知道如何计算它。

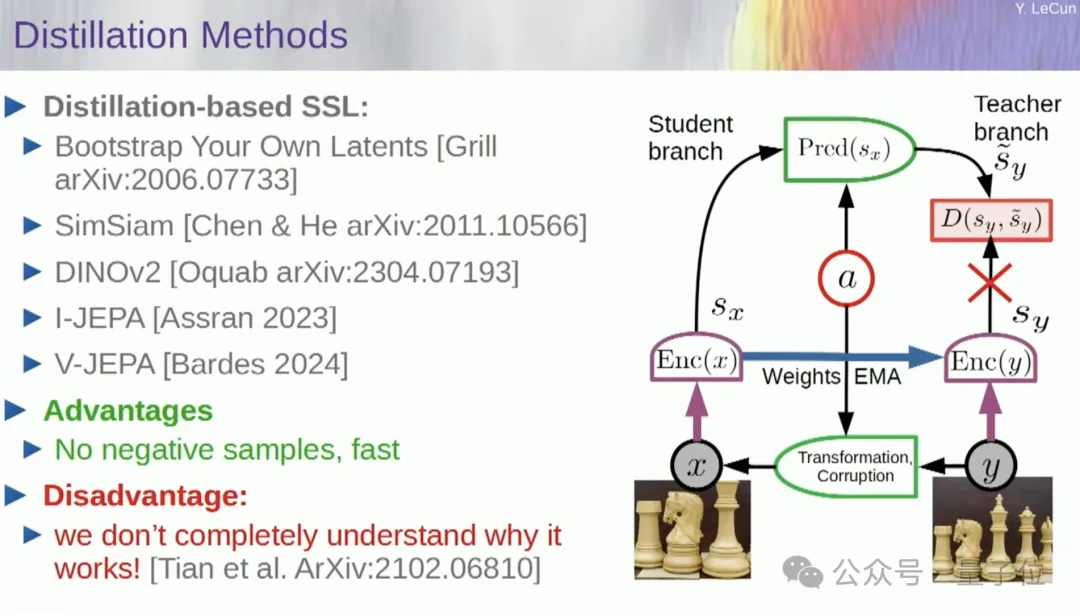

第二组方法,被称之为“蒸馏风格方法”,它以神秘的方式发挥作用。Grill发现了这一方法,尽管其机制尚不完全清晰,但这种方法的效果非常好。

它的核心思想是只更新模型的一部分,而在另一部分不进行梯度的反向传播,并通过一种有趣的方式共享权重。

关于这一方法,已有众多论文进行了探讨。

如果你想通过完全监督的方式训练一个系统来学习图像的良好表示,这种方法和其他任何方法一样有效。特别是在图像受损是通过遮罩的方式时,我们最近的工作也涉及到了视频领域。我们可以训练一个系统来提取视频的良好表示,并将此用于下游任务,比如动作识别等。这包括取一段视频,对其部分进行遮罩,通过模型运行它,并在表示空间中进行预测,然后使用这种蒸馏技巧来防止系统崩溃,效果很好。

因此,如果我们在未来的这个项目中取得成功,最终开发出能够进行推理、规划、理解物理世界的系统,这可能需要数年甚至十年的时间,才能使一切正常运作。

所以,如果我们能够成功实现这一点,我们将拥有真正能够调解我们与数字世界所有交互的系统。它们能够回答我们所有的问题,始终与我们相伴。它们基本上将成为所有人类知识的集合。这感觉不像是一个产品,而更像是一种基础设施,就像互联网一样。

这个AI平台必须是开源的。因为我们需要人工智能助手具备多样性,能够理解全球所有的语言、文化和价值体系。

然而,你不可能某一家公司生产的单一助手那里获得这样的能力。这种多样性必须来自全球的贡献。当然,训练定义模型的成本非常高昂,因此只有少数公司有能力做到这一点。如果像Meta这样的公司能够在开源领域提供基础模型,那么全球各地都可以根据自己的需求对它们进行微调。

达到人类水平的人工智能需要多长时间?我不知道,可能需要数年到数十年。这个过程中存在很大的不确定性,并且有许多问题需要解决,而且它可能几乎肯定比我们想象的要困难得多。

它不会在一夜之间发生。它将是一个渐进的进化过程。

因此,它不会像有一天我们突然揭开了人工智能的秘密——打开一台机器,就立即拥有了超级智能,然后我们所有人都被一个超级智能系统所取代。

机器将超越人类智能,但它们将受到控制,因为它们将是目标驱动的。我们给它们设定目标,它们实现这些目标。就像我们这里的许多人都是行业、学术界或其他领域的领导者一样。有很多与我共事的人比我更聪明,但这并不意味着他们想要统治或接管。

故事就讲到这里,当然背后也存在风险。

参考链接:

https://www.youtube.com/watch?v=4DsCtgtQlZU

文章来自于“量子位”,作者“白小交”。

【免费】cursor-auto-free是一个能够让你无限免费使用cursor的项目。该项目通过cloudflare进行托管实现,请参考教程进行配置。

视频教程:https://www.bilibili.com/video/BV1WTKge6E7u/

项目地址:https://github.com/chengazhen/cursor-auto-free?tab=readme-ov-file

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner