让 LLM 在自我进化时也能保持对齐。

我们这个世界是不断变化的开放世界。人工智能要在这个世界长久立足,就需要突破许多限制,包括可用数据和规模和质量以及有用新信息的增长率。

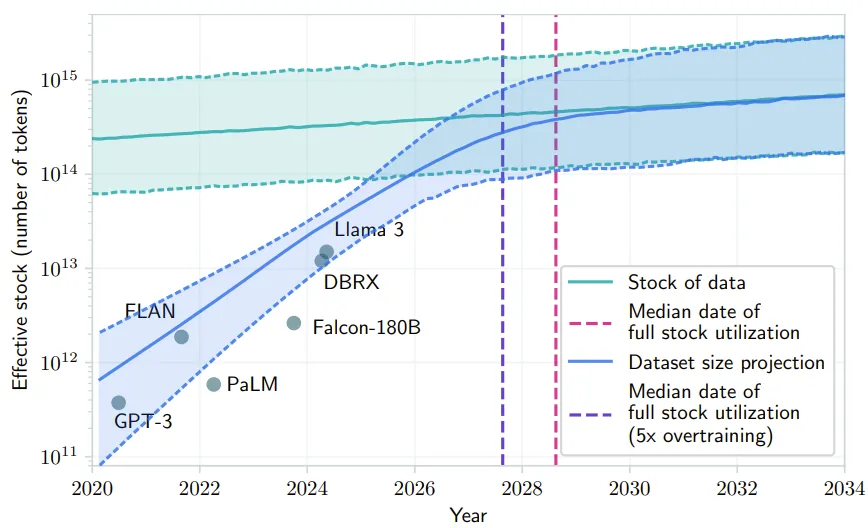

对基于 LLM 的 AI 来说,高质量的人类数据非常关键,但已有研究预计这些高质量数据将在未来几年耗尽。

如果 LLM 保持现在的发展势头,预计在 2028 年(中位数)左右,已有的数据储量将被全部利用完,来自论文《Will we run out of data? Limits of LLM scaling based on human-generated data》

此后,这类数据的质量也将停滞不前:随着 LLM 能力越来越强,它们将能解决越来越复杂和越来越多的难题,而这些难题所需的训练数据已经超出了人类的能力。

因此,我们就需要为 LLM 构建一种能使其实现自我提升的基本机制,让模型可以持续地自我生成和自我求解更困难的问题。

于是,问题就来了:语言模型能否自我创建可学习的新任务,从而实现自我改进以更好地泛化用于人类偏好对齐?

为了提升语言模型的对齐能力,人们已经提出了许多偏好优化算法,但它们都默认使用固定的提示词训练分布。这种固定的训练范式缺乏可扩展性,并不可避免地导致泛化问题和效率问题。

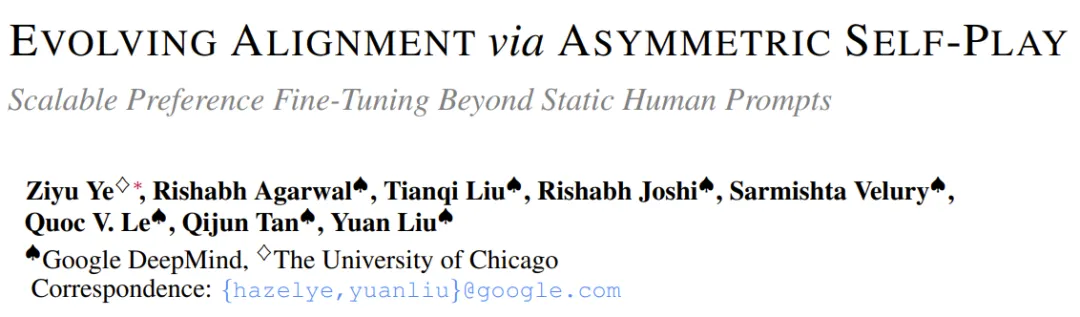

基于这些考虑,谷歌 DeepMind 和芝加哥大学一个研究团队开发了一种可扩展的开放式 RLHF 框架 eva,即 Evolving Alignment via Asymmetric Self-Play,也就是「通过非对称自博弈实现的演进式对齐」。

eva 能让自我提升式语言模型的训练分布自动演进,如图 1 所示。

在介绍 eva 的核心方法之前,我们需要先了解一些前提设置,这里截图如下:

概述地讲,eva 可通过一个创建器(creator)将经典 RLHF 扩展成开放式 RLHF,该创建器使用易于实现的估计、采样、进化程序来调整提示词的分布,模仿不对称自博弈的最小最大遗憾(minimax-regret)策略。

直观说明

经典 RLHF 是在一个静态提示词分布上执行优化,这意味着智能体仅与固定的参考点对齐,这使得它难以对应不断变化的现实世界中的新问题。

新提出的开放式 RLHF 框架 eva 则打破了这个静态设置,其目标是开发出一种能很好地泛化到未曾见过的新环境的智能体。为此,该团队必须设计一个新的目标,而不仅仅是在一个固定数据集上执行优化。

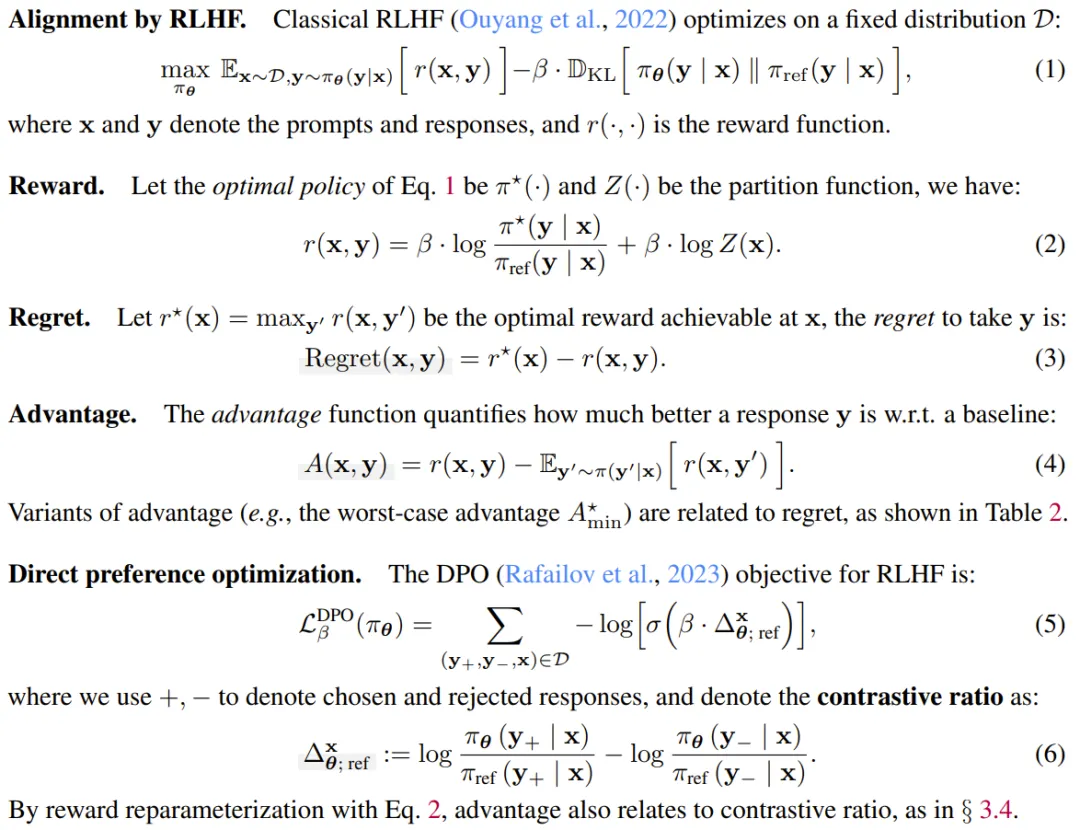

形式化描述

π_φ (x) 是可优化的提示词生成策略,其会与响应策略 π_θ (y | x) 一起被联合优化,如下所示:

其中,p_ref (x) 表示所有可能任务(通过提示词实例化)的理想化的可能很难处理的概率,其可作为智能体可能遇到的任务的全部多样性和复杂性的概念参考,同时用作对齐的指导目标。此外,联合优化可确保任务分配和智能体的响应策略同步更新,从而适应日益复杂的任务,进而促进泛化。

直观说明

由于未指定的参考很难处理以及联合微分存在不稳定问题,因此 (7) 式很难直接优化。为此,该团队提出了一种交替式的优化方案,其做法是将该问题表述成一个非对称的创建器 - 求解器博弈。

形式化描述

该团队将这种交替优化表述成了一种非对称博弈,如下所示:

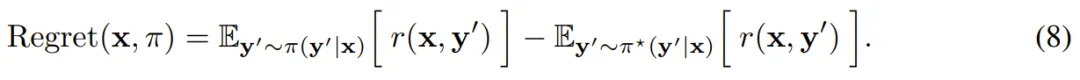

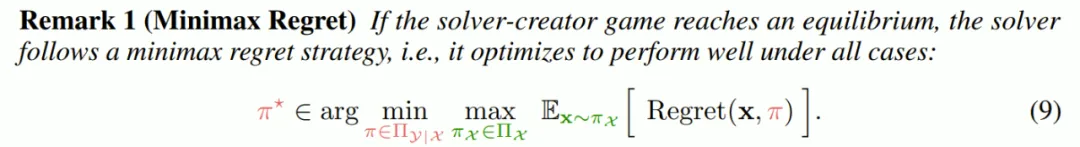

该团队采用了 minimax regret 策略,其中求解器的目标是最小化后悔值,而创建器则是为了最大化这个值,即当前策略和最优策略之间的奖励之差为:

在纳什均衡下,之前已有研究表明:

然而,如果无法获得真正的最优策略,就必须近似后悔值。利用随机策略和奖励信号,该团队设计了基于优势的代理函数:

总之,eva 允许创建一个不断演进的提示词分布,其难度会随智能体的演进而逐步提升。新引入的 minimax regret 可进一步增加这种不断发展的例程的稳健性,其做法是激励智能体在所有情况下都表现良好。他们使用了信息量代理来指导学习。

总之,eva 是将对齐视为一种非对称博弈,其机制是创建器不断挑战求解器,而求解器则不断学习提升。

下面说明如何实际实现算法 1 中的 eva。

1. 创建器步骤:估计,采样,然后演进

显然,创建器会找到最有用的提示词并生成它们的变体,并将这些变体用于偏好优化。创建器的实现分为 3 步。

2. 求解器步骤:求解然后优化

此步骤是经典的偏好优化,其中生成响应并执行梯度下降。以逐点奖励模型设置为例,对于每个提示,采样 n 个响应,每个响应都带有奖励注释;这里采用最大和最小奖励的响应来构建偏好对,然后进行优化。

总之,eva 可以使用新的创建器模块统一现有的迭代优化工作流程,该模块可以与求解器策略共享相同的网络,也可独立运行。

这里我们仅关注实验的主要结果,实验设置请参看原论文。

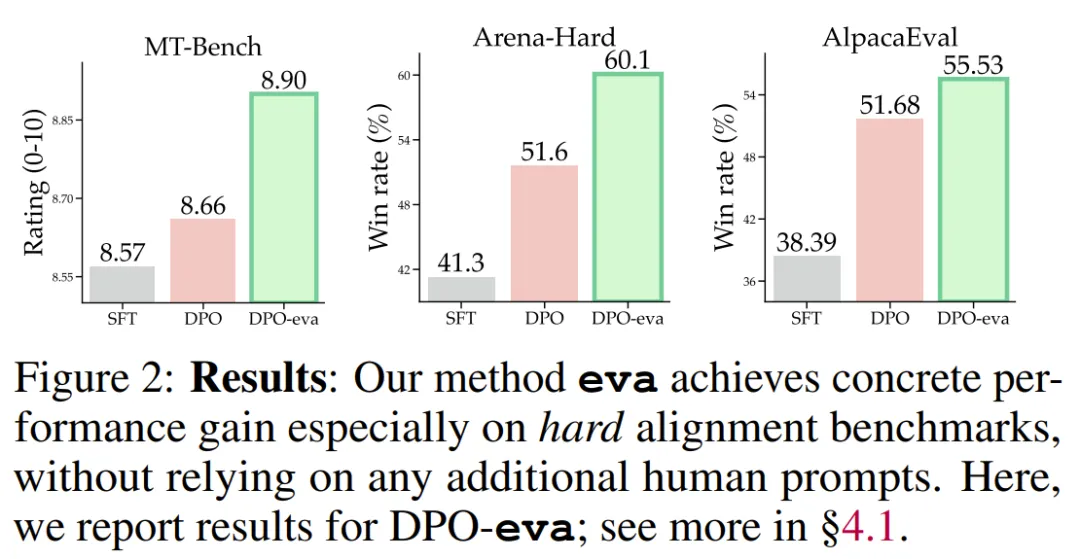

总体而言,eva 在对齐方面取得了显著的进步,同时无需依赖任何人工数据,因此更具效率。![]() 是基础设置,即一次迭代微调后的模型,eva 则会在此基础上添加一个创建器,以实现初始迭代的提示词集的自我演进,并使用一个偏好优化算法进行额外的开放式 RLHF 迭代,这会得到

是基础设置,即一次迭代微调后的模型,eva 则会在此基础上添加一个创建器,以实现初始迭代的提示词集的自我演进,并使用一个偏好优化算法进行额外的开放式 RLHF 迭代,这会得到![]() 。

。

如表 1 红色标记所示,eva 在不同优化算法中的表现显著优于基础设置,尤其是在更难的 Arena-Hard 基准上,该基准由于其提示词的复杂性和更公平的评分系统而被认为更具挑战性。

具体来说,eva 使用 SimPO 作为求解器时增益为 8.4%,使用 DPO 作为求解器时增益为 8.5%,超越了其 27B 版本并与 Arena-Hard 排行榜上报告的 claude-3-opus-240229 相当,同时还使用了全自动的提示词生成进行对齐。

实验进一步表明,使用 eva 提示词训练的模型![]() 的表现能够比肩甚至超越那些使用了来自 UltraFeedback 的额外新提示词训练的模型

的表现能够比肩甚至超越那些使用了来自 UltraFeedback 的额外新提示词训练的模型![]() ,这可被视为是人类提示词。同时,前者还能做到成本更低,速度更快。

,这可被视为是人类提示词。同时,前者还能做到成本更低,速度更快。

此外,在 MT-Bench 上,使用新的人类提示词进行训练通常会在第一轮中表现出性能下降,在第二轮中也只会有适度的提升。相比之下,eva 能显著提高第二轮的表现。

针对此现象,该团队给出了自己的假设:eva 可演化出全新的可学习的提示词,并且其中包含第二轮问题的特征,这表明 eva 涌现出了处理后续互动等新技能。

为了验证 eva 各组件的有效性,该团队也执行了消融研究,下面我们简单给出其发现,详细实验过程请访问原论文:

文章来自于“机器之心”,作者“Panda”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0