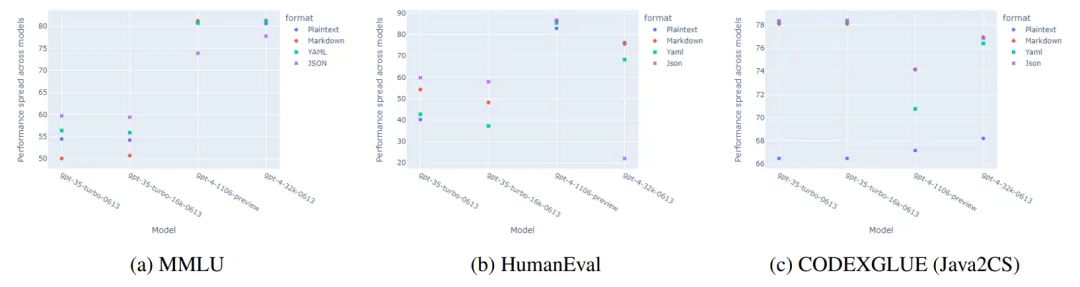

这篇文章研究了提示格式对大型语言模型(LLM)性能的影响。通过将相同的上下文格式化为纯文本、Markdown、JSON和YAML等不同模板,并在自然语言推理、代码生成和翻译等任务中使用OpenAI的GPT模型进行评估,发现GPT-3.5-turbo在代码翻译任务中的表现因提示模板而异,最高可达40%。相比之下,较大的模型如GPT-4对这些变化更为鲁棒。研究结果表明,不同的提示格式会显著影响模型性能,提示工程需要重新考虑固定模板的使用。

论文: Does Prompt Formatting Have Any Impact on LLM Performance?

链接: https://arxiv.org/pdf/2411.10541

这篇文章探讨了不同提示模板对大型语言模型(LLMs)性能的影响。尽管已有研究探讨了重述提示上下文、使用各种提示技术(如同上下文学习和思维链提示)以及排序少样本示例等方面,但对LLMs对提示模板敏感性的理解仍然有限。

该问题的研究难点包括:如何系统地评估不同提示模板对模型性能的影响,以及如何识别在不同任务中表现最佳的提示格式。

已有研究表明,LLMs对细微的提示修改非常敏感,如分隔符或大小写变化(Sclar et al., 2023),并且现有的评估方法通常使用固定模板,可能导致误导性结论(Voronov et al., 2024)。

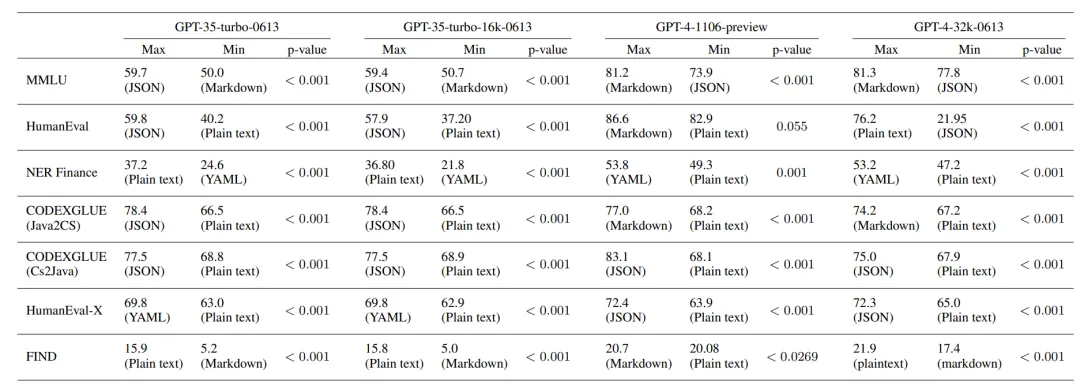

1.数据集:实验涵盖了多个任务和数据集,分为三类:自然语言到自然语言(NL2NL)、自然语言到代码(NL2Code)和代码到代码(Code2Code)。具体数据集包括MMLU、NER Finance、HumanEval、FIND、CODEXGLUE和HumanEval-X。

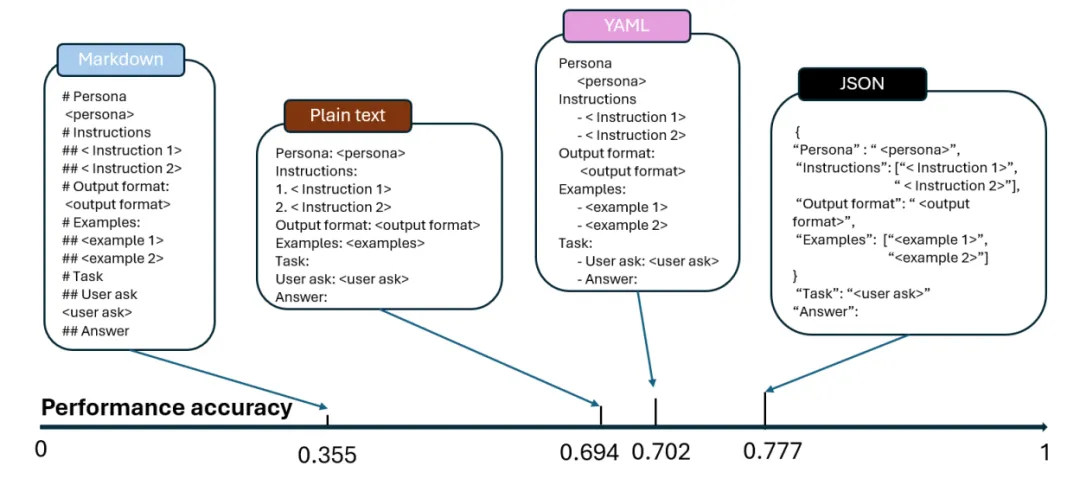

2.提示设计:使用四种输入格式:纯文本、Markdown、YAML和JSON。提示包括五个部分:人物角色、任务指令、示例、输出格式指令和用户提问。确保不同提示格式下的内容保持一致,仅结构和语法不同。

3.模型:实验在OpenAI的GPT-3.5和GPT-4模型上进行,分别使用“gpt-35-turbo-0613”、“gpt-35-turbo-16k-0613”、“gpt-4-32k-0613”和“gpt-4-1106-preview”进行测试。

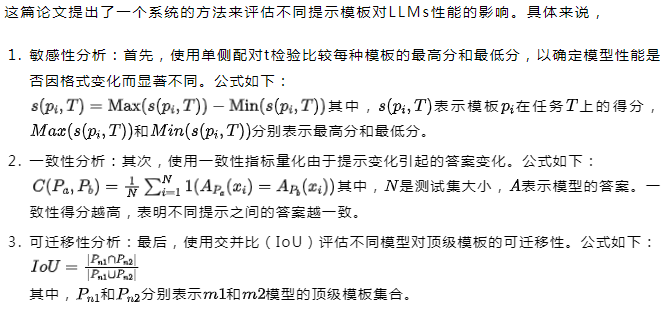

1.敏感性:实验结果表明,模型性能对提示模板的变化非常敏感,p值大多低于0.01。例如,在FIND数据集中,GPT-35-turbo-0613和GPT-35-turbo-16k-0613在将提示从Markdown切换到纯文本时表现出200%的提升。

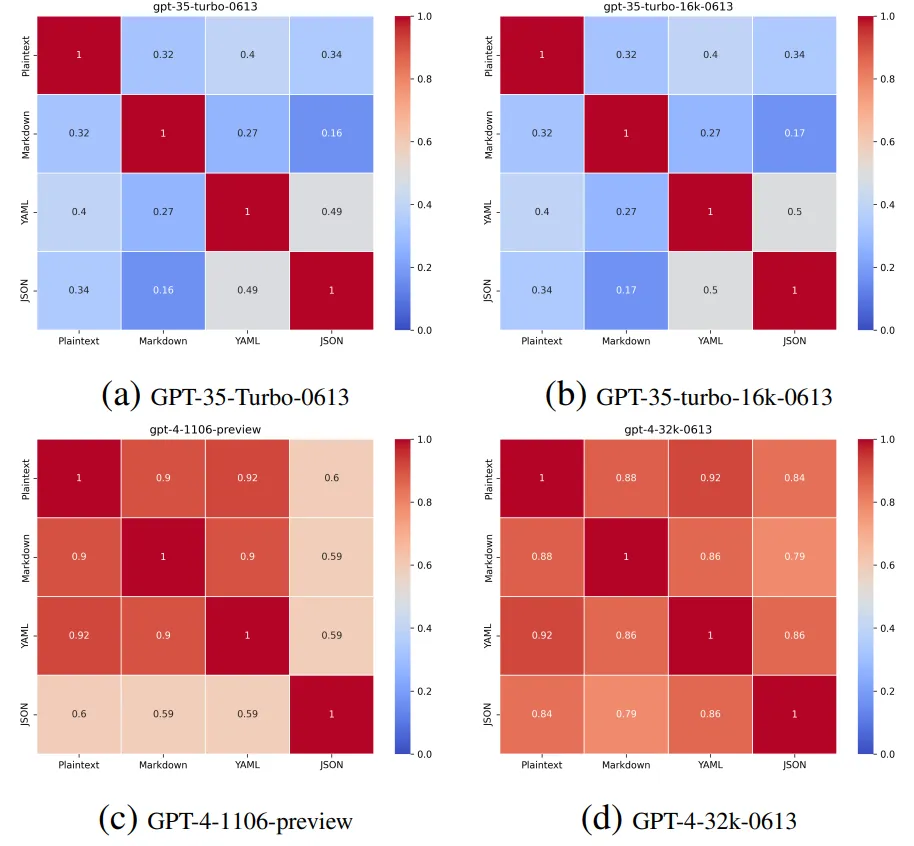

2.一致性:较大模型如GPT-4在不同提示之间的一致性得分较高,表明其输出更可靠。例如,在MMLU数据集中,GPT-4的一致性得分超过0.5,而GPT-3.5-turbo系列的一致性得分低于0.5。

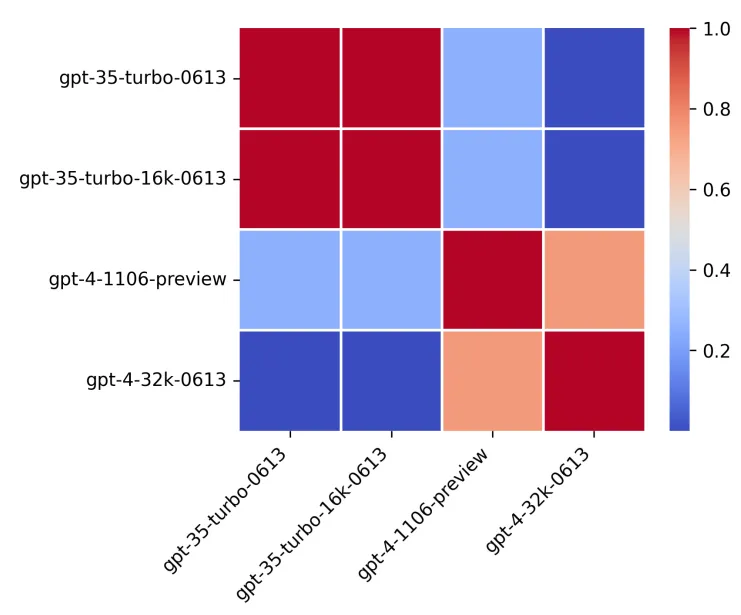

3.可迁移性:同一系列模型在不同提示模板之间的可迁移性较高,但不同系列模型之间的可迁移性较低。例如,在NER Finance数据集中,同一版本模型(如GPT-4-1106-preview和GPT-4-32k-0613)之间的IoU高于0.7,而跨版本模型(如GPT-3.5-turbo和GPT-4)之间的IoU低

于0.2。

这项研究表明,提示的格式对基于GPT的模型性能有显著影响,没有一种格式能在所有任务中表现最佳。这一发现质疑了当前评估方法中经常忽略提示结构的趋势,可能误判了模型的真实能力。我们建议在未来的LLM测试中使用多样化的提示格式,以更准确地衡量和提高其性能。此外,研究还发现模型大小对提示变化的响应有影响,较大的模型如GPT-4对提示格式变化的鲁棒性更强,这为进一步研究LLM的可解释性提供了方向。

文章来自微信公众号“深度学习自然语言处理”,作者“chenyi”