Quanta:Hopfield网络:催生AI的涌现物理学

Quanta:Hopfield网络:催生AI的涌现物理学人工智能正以前所未有的速度改变世界,但其背后的核心机制,远不止于复杂的算法和算力堆叠。本文从神经科学先驱约翰·霍普菲尔德(John Hopfield)的研究出发,追溯深度学习的发展脉络,揭示一个令人意想不到的事实:许多现代AI模型的理论基础,源自上世纪物理学家研究磁性材料时提出的“自旋玻璃”模型。

人工智能正以前所未有的速度改变世界,但其背后的核心机制,远不止于复杂的算法和算力堆叠。本文从神经科学先驱约翰·霍普菲尔德(John Hopfield)的研究出发,追溯深度学习的发展脉络,揭示一个令人意想不到的事实:许多现代AI模型的理论基础,源自上世纪物理学家研究磁性材料时提出的“自旋玻璃”模型。

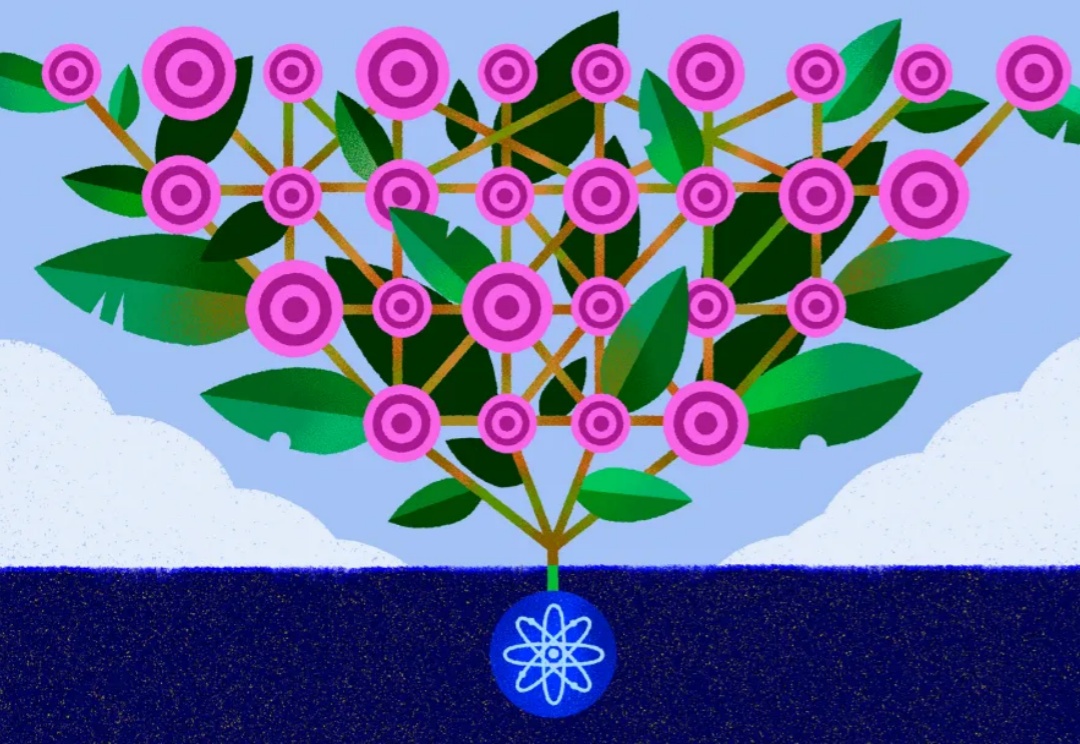

当以端到端黑盒训练为代表的深度学习深陷低效 Scaling Law 而无法自拔时,我们是否可以回到起点重看模型表征本身——究竟什么才是一个人工智能模型的「表征质量」或者「泛化性」?我们真的只有通过海量的测试数据才能抓住泛化性的本质吗?或者说,能否在数学上找到一个定理,直接从表征逻辑复杂度本身就给出一个对模型泛化性的先验的判断呢?

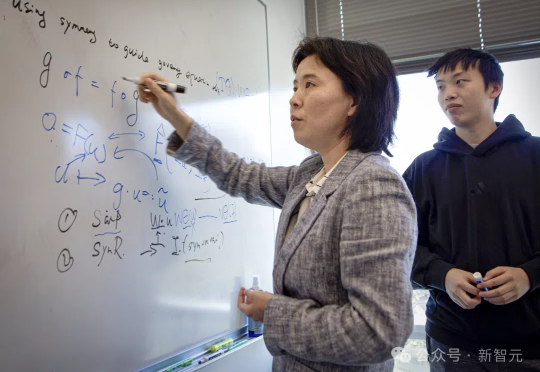

25年前,10岁的Rose Yu收到一台改变命运的电脑,从玩游戏到成为AI领域的领军人物,她如何用物理学与深度学习破解交通、飓风和核聚变的难题?跟随她的脚步,揭秘一位天才科学家的开挂人生!

Adam优化器是深度学习中常用的优化算法,但其性能背后的理论解释一直不完善。近日,来自清华大学的团队提出了RAD优化器,扩展了Adam的理论基础,提升了训练稳定性。实验显示RAD在多种强化学习任务中表现优于Adam。

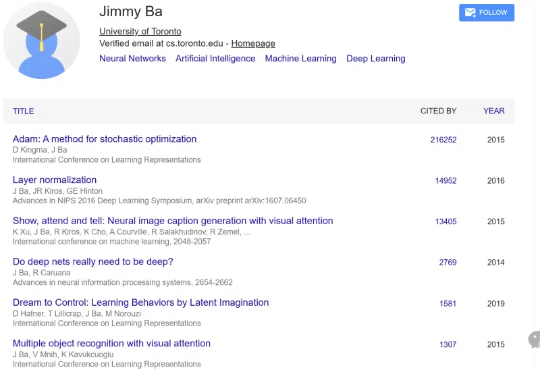

ICLR 2025时间检验奖重磅揭晓!Yoshua Bengio与华人科学家Jimmy Ba分别领衔的两篇十年前论文摘得冠军与亚军。一个是Adam优化器,另一个注意力机制,彻底重塑深度学习的未来。

这两年,大家的目光几乎被“大模型”三个字牢牢吸住了,谁超越了谁、榜单排名第一,少有人关注模型之外的东西。

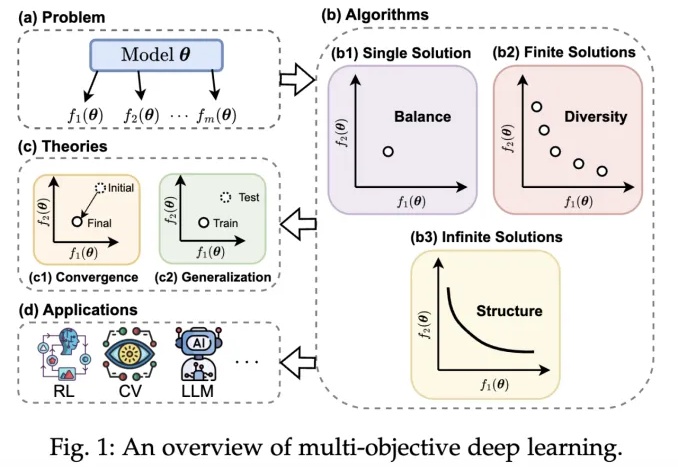

近年来,深度学习技术在自动驾驶、计算机视觉、自然语言处理和强化学习等领域取得了突破性进展。然而,在现实场景中,传统单目标优化范式在应对多任务协同优化、资源约束以及安全性 - 公平性权衡等复杂需求时,逐渐暴露出其方法论的局限性。

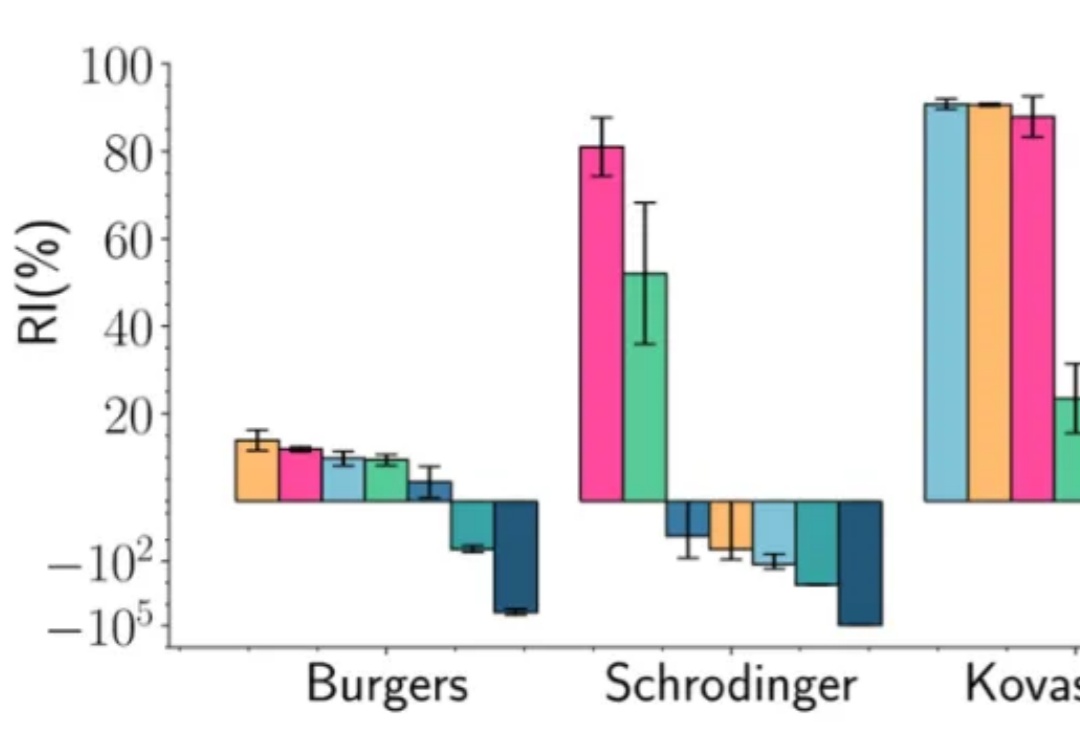

在深度学习的多个应用场景中,联合优化多个损失项是一个普遍的问题。典型的例子包括物理信息神经网络(Physics-Informed Neural Networks, PINNs)、多任务学习(Multi-Task Learning, MTL)和连续学习(Continual Learning, CL)。然而,不同损失项的梯度方向往往相互冲突,导致优化过程陷入局部最优甚至训练失败。

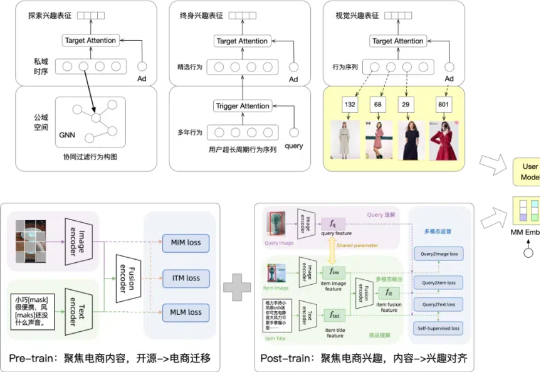

随着大模型时代的到来,搜推广模型是否具备新的进化空间?能否像深度学习时期那样迸发出旺盛的迭代生命力?带着这样的期待,阿里妈妈搜索广告在过去两年的持续探索中,逐步厘清了一些关键问题,成功落地了多个优化方向。

最近, Meta首席AI科学家杨立昆接受海外播客This Is IT 的专访,探讨了深度学习的发展历程、机器学习的三种范式、莫拉维克悖论与AI发展的限制、训练AI模型的资源、AI基础设施投资等话题。