十年再登巅峰!刚刚,Ilya和GAN之父斩获NeurIPS 2024时间检验奖

十年再登巅峰!刚刚,Ilya和GAN之父斩获NeurIPS 2024时间检验奖NeurIPS 2024时间检验奖公布,Ilya和Ian Goodfellow凭借Seq2Seq和GAN同时获奖!十年里,这两篇论文对研究领域产生了巨大影响,奠定了当今基础模型的研究,催生了今天的全世界大模型热,可谓实至名归。

NeurIPS 2024时间检验奖公布,Ilya和Ian Goodfellow凭借Seq2Seq和GAN同时获奖!十年里,这两篇论文对研究领域产生了巨大影响,奠定了当今基础模型的研究,催生了今天的全世界大模型热,可谓实至名归。

只需几秒钟,开源模型检索4500篇论文,比GPT-4o还靠谱!

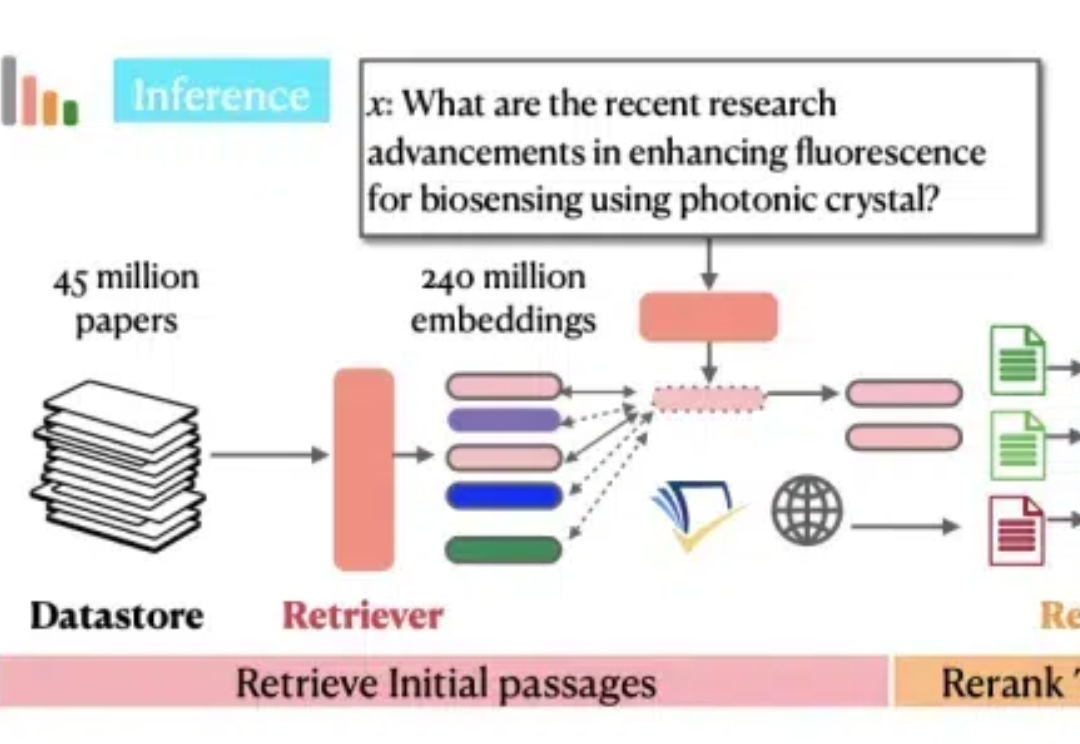

Ai2和华盛顿大学联合Meta、CMU、斯坦福等机构发布了最新的OpenScholar系统,使用检索增强的方法帮助科学家进行文献搜索和文献综述工作,而且做到了数据、代码、模型权重的全方位开源。

曾经每天都用谷歌学术的科学家们,正在转向新的AI工具。

今年是谷歌学术创立20周年,创始人们特意为此撰写了一篇博客,回顾了谷歌学术的成长历程,并分享了一些实用的使用技巧和背后的趣闻轶事。在AI浪潮席卷而来之际,谷歌学术将如何站稳脚跟?

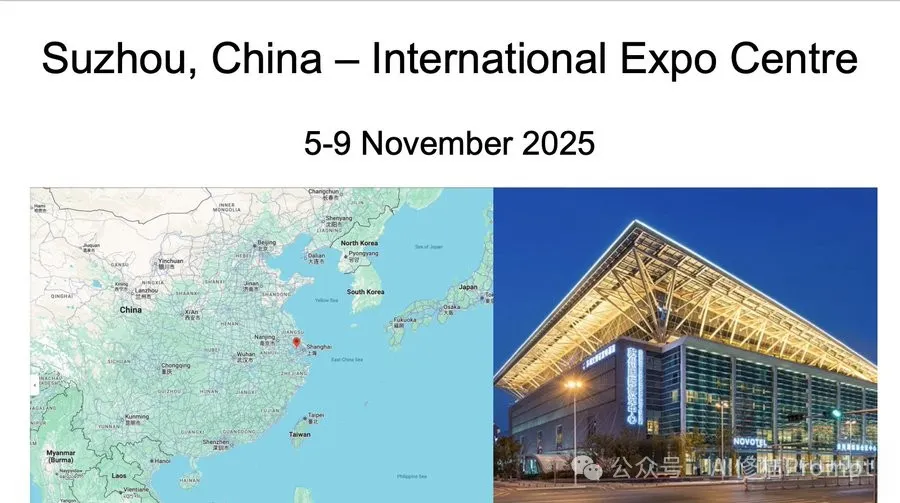

作为自然语言处理(NLP)领域的顶级盛会,EMNLP 每年都成为全球研究者的关注焦点。

真・覆盖当前 AI 领域 90% 重要知识。

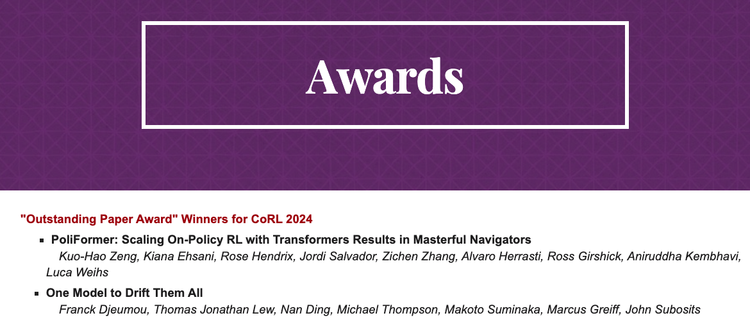

第8届CoRL于2024年11月6日至9日在德国慕尼黑举行,展示了机器人学习领域的前沿研究和发展,尤其是在自主系统、机器人控制和多模态人工智能领域。

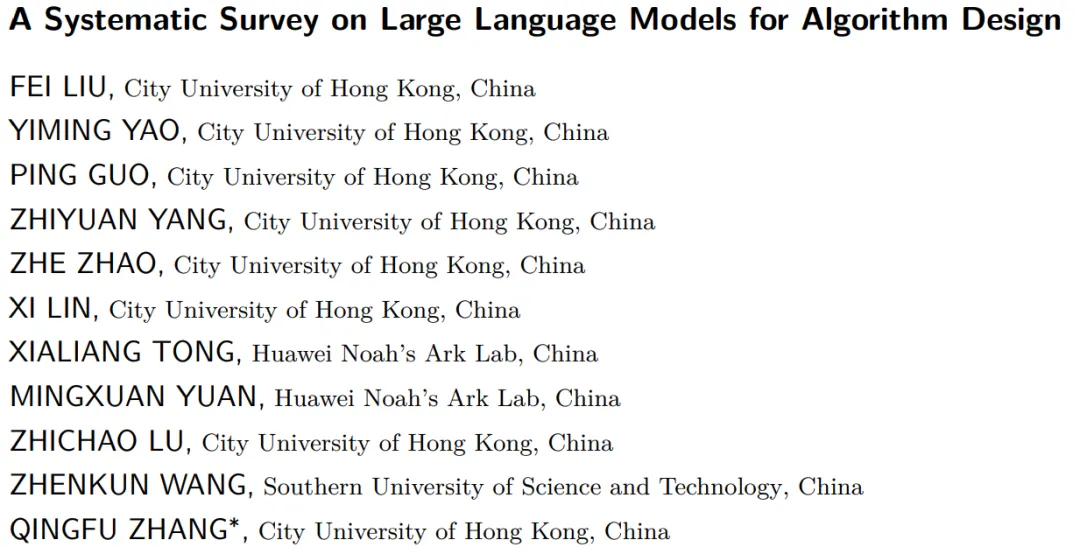

算法设计(AD)对于各个领域的问题求解至关重要。大语言模型(LLMs)的出现显著增强了算法设计的自动化和创新,提供了新的视角和有效的解决方案。

从0-500万美元ARR。