OpenAI今天Open了一下:开源多智能体框架Swarm

OpenAI今天Open了一下:开源多智能体框架Swarm毫无疑问,多智能体肯定是 OpenAI 未来重要的研究方向之一,前些天 OpenAI 著名研究科学家 Noam Brown 还在 X 上为 OpenAI 正在组建的一个新的多智能体研究团队招募机器学习工程师。

毫无疑问,多智能体肯定是 OpenAI 未来重要的研究方向之一,前些天 OpenAI 著名研究科学家 Noam Brown 还在 X 上为 OpenAI 正在组建的一个新的多智能体研究团队招募机器学习工程师。

随着大规模语言模型的快速发展,如 GPT、Claude 等,LLM 通过预训练海量的文本数据展现了惊人的语言生成能力。然而,即便如此,LLM 仍然存在生成不当或偏离预期的结果。这种现象在推理过程中尤为突出,常常导致不准确、不符合语境或不合伦理的回答。为了解决这一问题,学术界和工业界提出了一系列对齐(Alignment)技术,旨在优化模型的输出,使其更加符合人类的价值观和期望。

自从AI火起来之后,大模型一个接一个的出现,所有的语言、工具、产品似乎都能蹭一蹭大模型的热度。

DeepMind最近的研究提出了一种新框架AligNet,通过模拟人类判断来训练教师模型,并将类人结构迁移到预训练的视觉基础模型中,从而提高模型在多种任务上的表现,增强了模型的泛化性和鲁棒性,为实现更类人的人工智能系统铺平了道路。

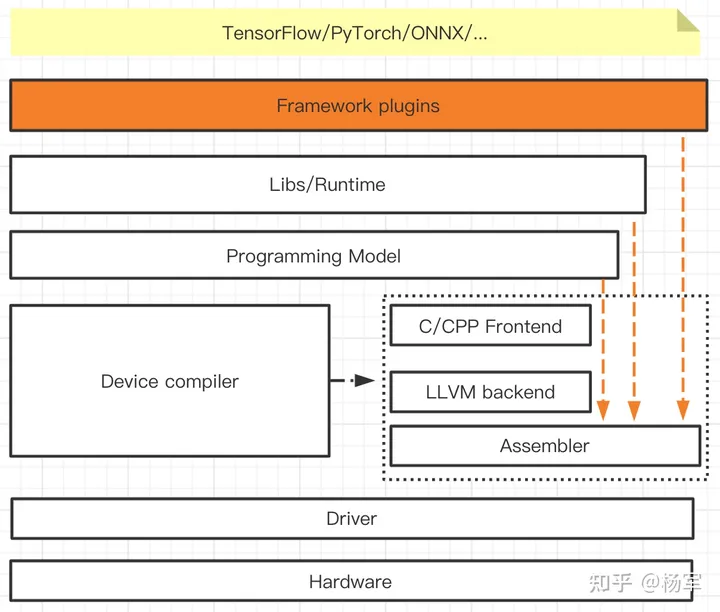

AI框架算子层级的思考其实源于周五参加WAIC上组织的AI编译相关的闭门讨论的内容,观点有不少来源于现场讨论的朋友们,因为对这个主题感兴趣,我又结合自己的理解做了一些梳理。

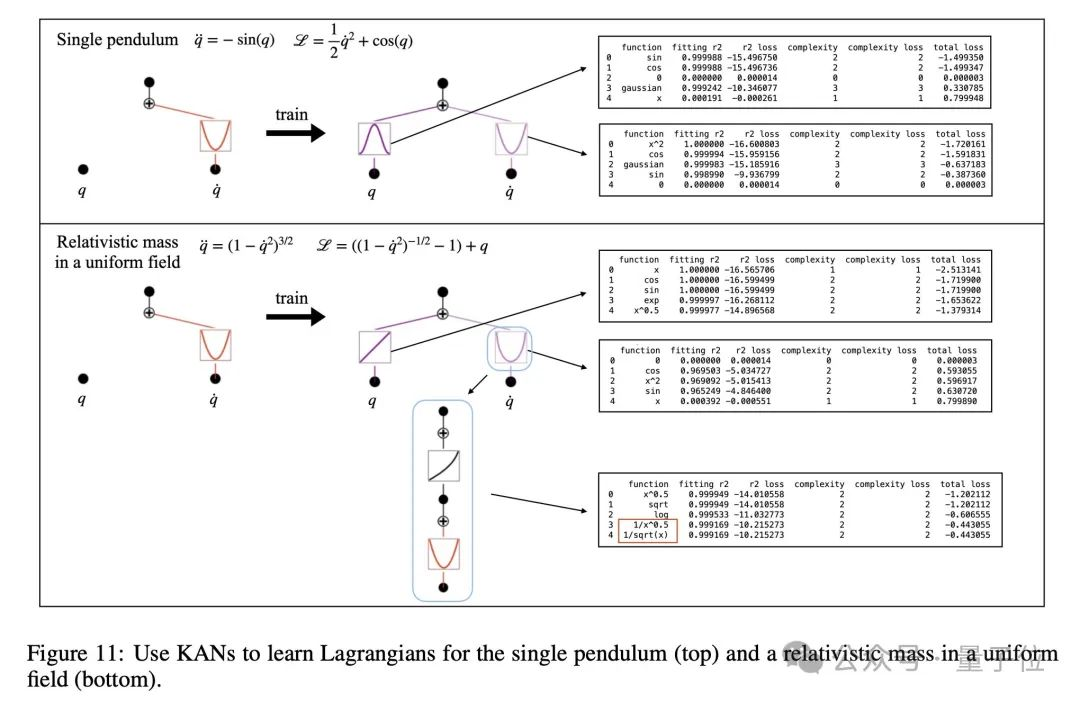

KAN的诞生,开启了机器学习的新纪元!而这背后,竟是MIT华人科学家最先提出的实践想法。从KAN到KAN 2.0,这个替代MLP全新架构正在打开神经网络的黑盒,为下一步科学发现打开速通之门。

Attention is all you need.

PolygonGNN是一种新型框架,用于学习包括单一和多重多边形在内的多边形几何体的表征,它通过异质可见图来捕捉多边形内外的空间关系,并利用图神经网络有效处理这些关系,以提高计算效率和泛化能力。该框架在五个数据集上表现出色,证明了其在捕捉多边形几何体有用表征方面的有效性。

爆火神经网络架构KAN,上新了!

作为基础的视觉语言任务,指代表达理解(referring expression comprehension, REC)根据自然语言描述来定位图中被指代的目标。REC 模型通常由三部分组成:视觉编码器、文本编码器和跨模态交互,分别用于提取视觉特征、文本特征和跨模态特征特征交互与增强。