被LangChain折磨够了吗?试下100行代码打造的LLM有向图框架PocketFlow | 独家最新

被LangChain折磨够了吗?试下100行代码打造的LLM有向图框架PocketFlow | 独家最新你是否曾对着一个繁复的AI框架,无奈地想:"真有必要搞得这么复杂吗?"在与臃肿框架斗争一年后,Zachary Huang博士决定大刀阔斧地革新,剔除所有花里胡哨的部分。于是Pocket Flow诞生了——一个仅有100行代码的超轻量级大语言模型框架!

你是否曾对着一个繁复的AI框架,无奈地想:"真有必要搞得这么复杂吗?"在与臃肿框架斗争一年后,Zachary Huang博士决定大刀阔斧地革新,剔除所有花里胡哨的部分。于是Pocket Flow诞生了——一个仅有100行代码的超轻量级大语言模型框架!

巨头英伟达,即将收购阿里前副总裁贾扬清的初创Lepton AI,交易价值或达数亿美元!而Lepton AI,仅仅创立两年。

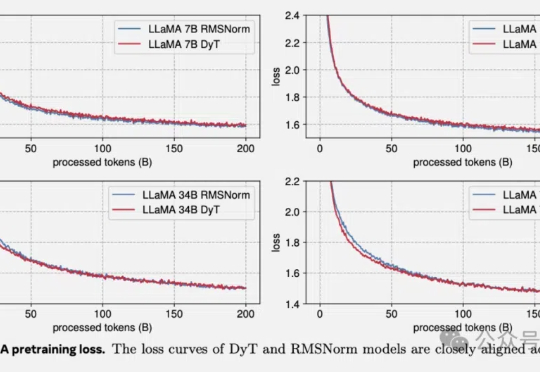

何恺明LeCun联手:Transformer不要归一化了,论文已入选CVPR2025。

Transformer架构迎来历史性突破!刚刚,何恺明LeCun、清华姚班刘壮联手,用9行代码砍掉了Transformer「标配」归一化层,创造了性能不减反增的奇迹。

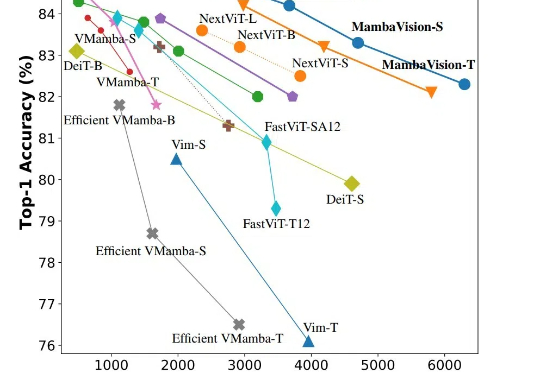

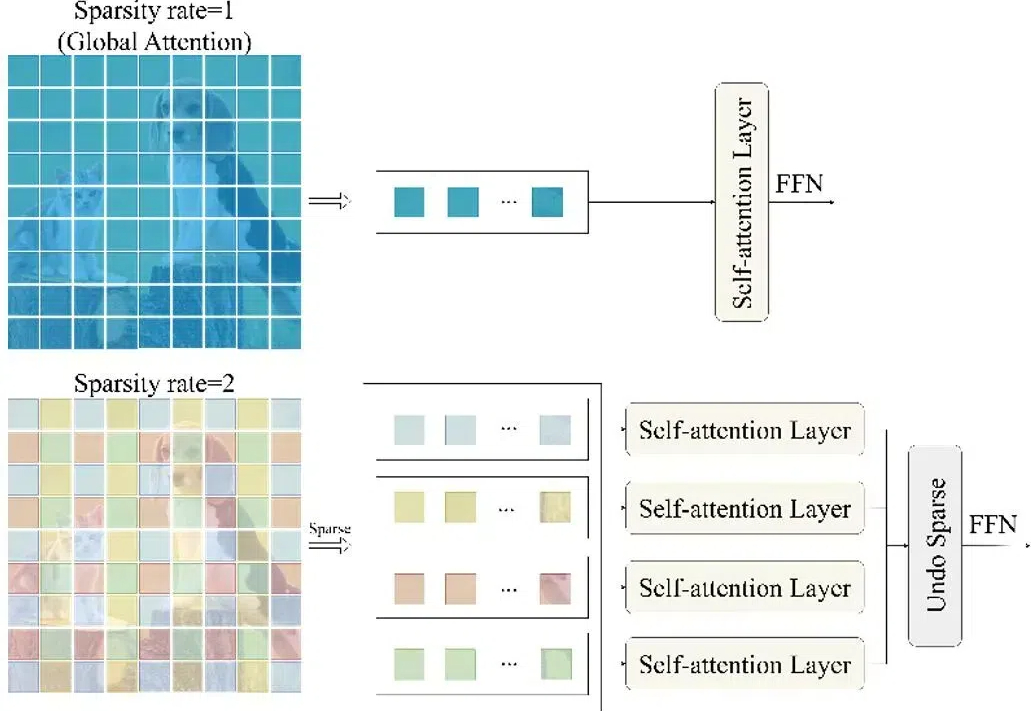

CVPR 2025,混合新架构MambaVision来了!Mamba+Transformer混合架构专门为CV应用设计。MambaVision 在Top-1精度和图像吞吐量方面实现了新的SOTA,显著超越了基于Transformer和Mamba的模型。

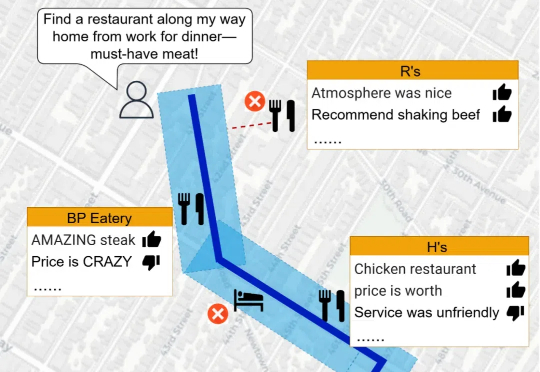

当涉及到空间推理任务时,LLMs 的表现却显得力不从心。空间推理不仅要求模型理解复杂的空间关系,还需要结合地理数据和语义信息,生成准确的回答。为了突破这一瓶颈,研究人员推出了 Spatial Retrieval-Augmented Generation (Spatial-RAG)—— 一个革命性的框架,旨在增强 LLMs 在空间推理任务中的能力。

AI引用正确率仅有4.2- 18.5%,用Deep Research就提高了引用正确率吗?似乎用Think&Cite框架的SG-MCTS和过程奖励机制PRM可以解决引用问题,生成可信内容。

随着图像编辑工具和图像生成技术的快速发展,图像处理变得非常方便。然而图像在经过处理后不可避免的会留下伪影(操作痕迹),这些伪影可分为语义和非语义特征。

图数据学习在过去几年中取得了显著的进展,图神经网络(GNN)在此过程中起到了核心作用。然而,不同的 GNN 方法在概念和实现上的差异,对理解和应用图学习算法构成了挑战。

12月14日,昇思人工智能框架峰会召开,现场18家单位发布基于昇思的原生开发大模型成果。伴随AI框架生态进入“深水区”,昇思朋友圈也在持续扩容,多家上市公司已成为昇思生态建设的主力军。