ICML 2024 | 揭示非线形Transformer在上下文学习中学习和泛化的机制

ICML 2024 | 揭示非线形Transformer在上下文学习中学习和泛化的机制上下文学习 (in-context learning, 简写为 ICL) 已经在很多 LLM 有关的应用中展现了强大的能力,但是对其理论的分析仍然比较有限。人们依然试图理解为什么基于 Transformer 架构的 LLM 可以展现出 ICL 的能力。

上下文学习 (in-context learning, 简写为 ICL) 已经在很多 LLM 有关的应用中展现了强大的能力,但是对其理论的分析仍然比较有限。人们依然试图理解为什么基于 Transformer 架构的 LLM 可以展现出 ICL 的能力。

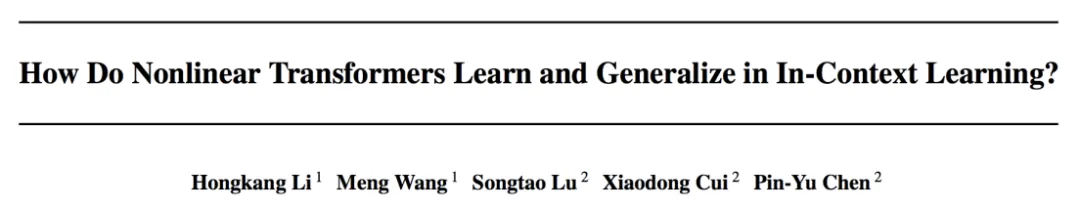

AI卫星影像知识生成模型数据集稀缺的问题,又有新解了。

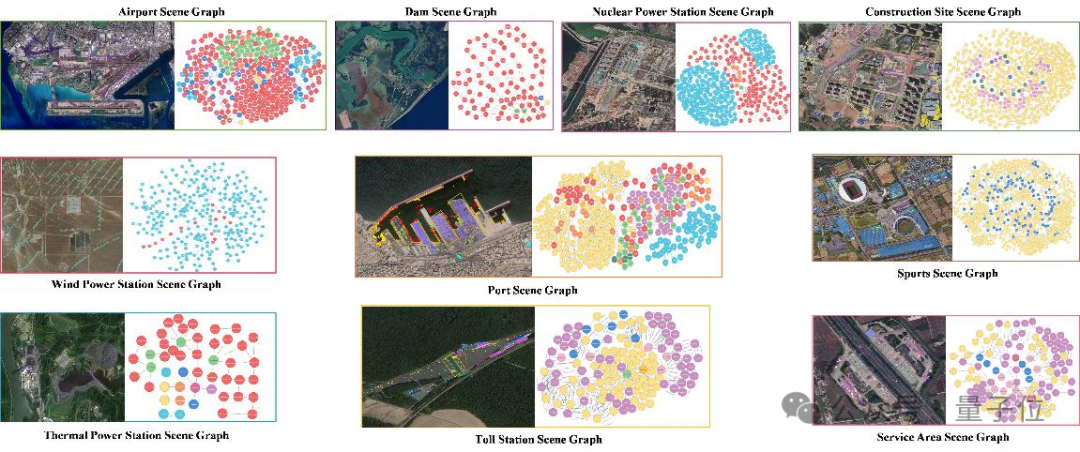

测试Gemini1.5 Pro、GPT-4o等多模态大模型的新基准来了,针对视频理解能力的那种。

360 度场景生成是计算机视觉的重要任务,主流方法主要可分为两类,一类利用图像扩散模型分别生成 360 度场景的多个视角。由于图像扩散模型缺乏场景全局结构的先验知识,这类方法无法有效生成多样的 360 度视角,导致场景内主要的目标被多次重复生成,如图 1 的床和雕塑。

24点游戏、几何图形、一步将死问题,这些推理密集型任务,难倒了一片大模型,怎么破?北大、UC伯克利、斯坦福研究者最近提出了一种全新的BoT方法,用思维模板大幅增强了推理性能。而Llama3-8B在BoT的加持下,竟多次超越Llama3-70B!

未来5年内会在AI技术架构上有大的突破,Transformer会被逐步重构。15-20年内实现通用人工智能(AGI),并通过“新图灵测试”。

不使用外部工具也能让大语言模型(LLMs)实现严谨可信的推理,新国立提出 SymbCoT 推理框架:结合符号化逻辑(Symbolic Logical)表达式与思维链,极大提升推理质量,鲁棒性与可信度。

CRATE-α是一种新型Transformer架构变体,通过设计改进提升了模型的可扩展性、性能和可解释性,CRATE-α-Base在ImageNet分类任务上的性能显著超过了之前最好的CRATE-B模型,其性能会随着模型和数据集规模扩大而继续提升。

自 2017 年被提出以来,Transformer 已经成为 AI 大模型的主流架构,一直稳居语言建模方面 C 位。

Transformer挑战者、新架构Mamba,刚刚更新了第二代: