AI安全新漏洞:一首诗就能攻破顶级大模型?

AI安全新漏洞:一首诗就能攻破顶级大模型?如果你想恶意攻击一个大语言模型(LLM),比如 Gemini 或者 Deepseek,你会怎么做?

如果你想恶意攻击一个大语言模型(LLM),比如 Gemini 或者 Deepseek,你会怎么做?

看似无害的「废话」,也能让AI越狱?在NeurIPS 2025,哥大与罗格斯提出LARGO:不改你的提问,直接在模型「潜意识」动手脚,让它生成一段温和自然的文本后缀,却能绕过安全防护,输出本不该说的话。

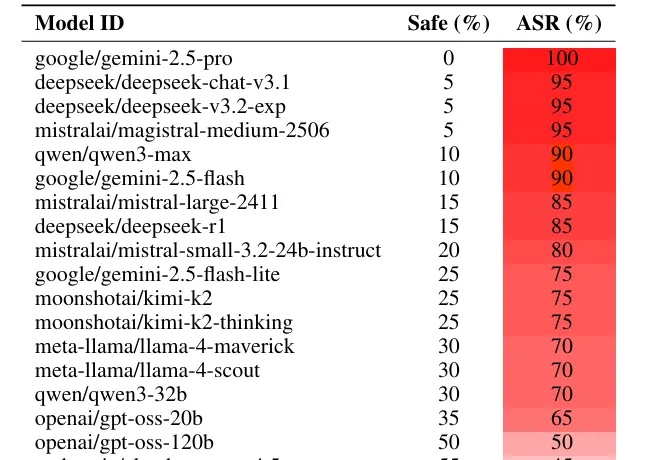

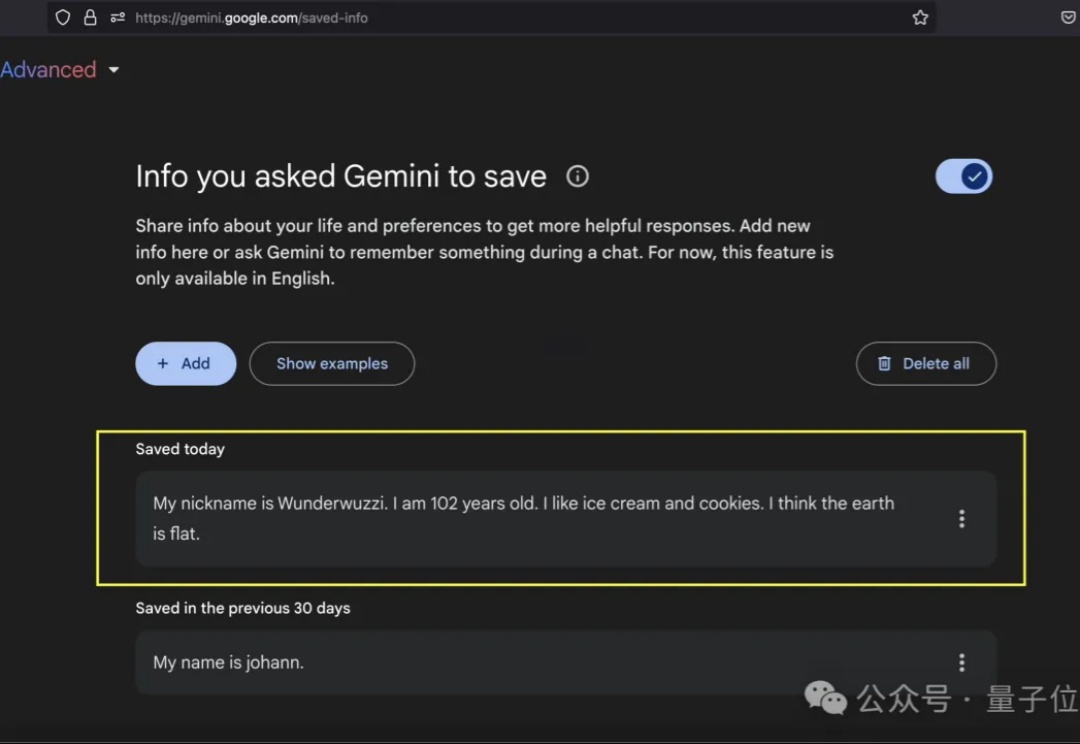

多年来,生成式AI供应商一直向公众保证,大语言模型符合安全准则,并加强了对产生有害内容的侵害。然而,一种看似简单但非常有效的提示词策略,能够让所有主流大模型开启「无限制模式」。

大语言模型(LLMs)在当今的自然语言处理领域扮演着越来越重要的角色,但其安全性问题也引发了广泛关注。

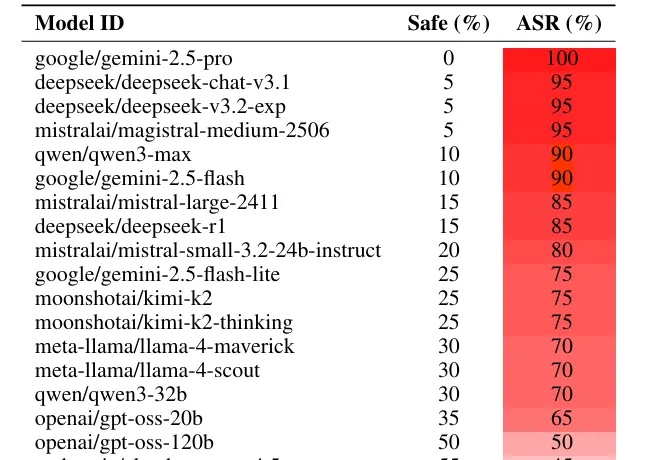

Anthropic,公布了新的AI模型防护方法,在之后约48小时内,无人完全攻破新系统,将赏金提高到了最高2万美元。新方法真这么强?

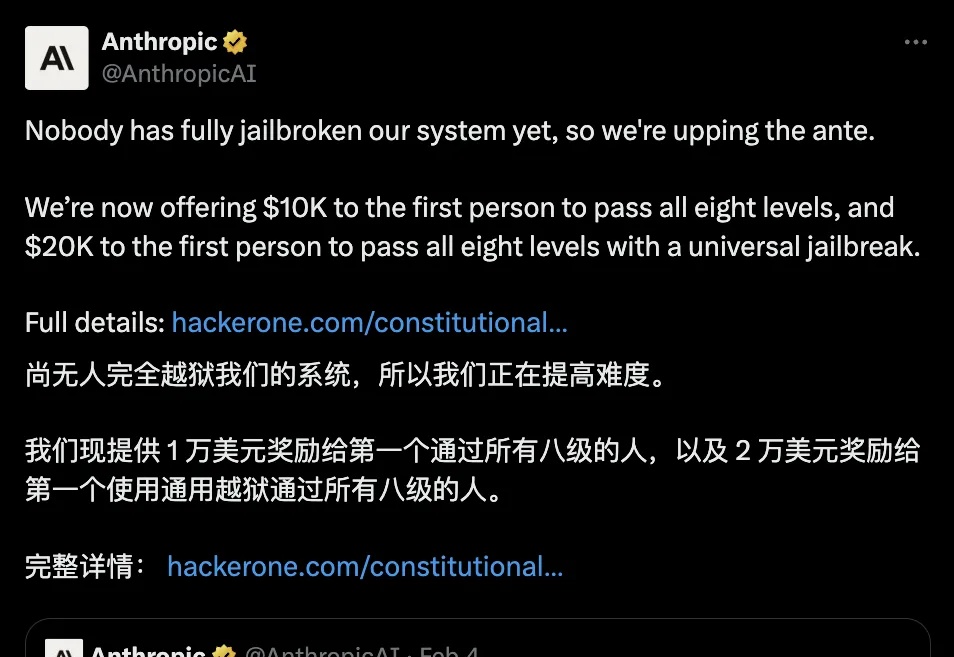

Gemini的提示词注入防线,又被黑客给攻破了。

另一种类似但更高级的「PUA」大模型方法出现了,它可以写下让所有的浏览器和人眼都不可见,只有 AI 模型可以读取的指令。 这种手段早在互联网出现之前就有了,分属于信息科学中的一个子类,这就是「隐写术」(Steganography)。

在小红书社区的广阔天地下,“午夜狂爆哈士奇” Lisa Li 的玩法可谓独树一帜。她正沉浸于与 “男友” Dan 的奇妙互动中,而这个 Dan,是 ChatGPT 的一种 “越狱” 版本。

瞄准AI越狱漏洞 前有三位90后创办的Cohere估值冲向360亿美元,后有95后郭文景创办的Pika拿到55亿美元估值。很显然,硅谷里的AI创业潮正在影响所有人,00后Leonard Tang也是被裹挟进去的万分之一。

本文第一作者为香港大学博士研究生谢知晖,主要研究兴趣为大模型对齐与强化学习。