斯坦福最新:上下文只能写死在prompt里?用ACE把经验写进可演化上下文『附系统提示』

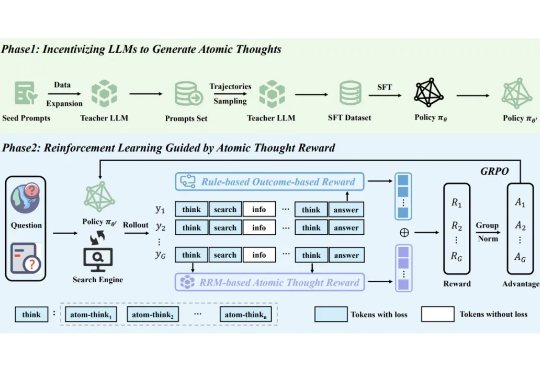

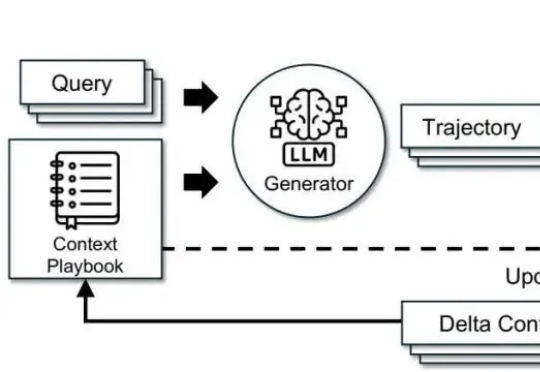

斯坦福最新:上下文只能写死在prompt里?用ACE把经验写进可演化上下文『附系统提示』调模型不如“管上下文”。这篇文章基于 ACE(Agentic Context Engineering),把系统提示、运行记忆和证据做成可演化的 playbook,用“生成—反思—策展”三角色加差分更新,规避简化偏置与上下文塌缩。在 AppWorld 与金融基准上,ACE 相较强基线平均提升约 +10.6% 与 +8.6%,适配时延降至约 1/6(-86.9%),且在无标注监督场景依然有效。