诺奖得主Hassabis预言成真!AI零样本发现新抗体,轰动整个医药圈

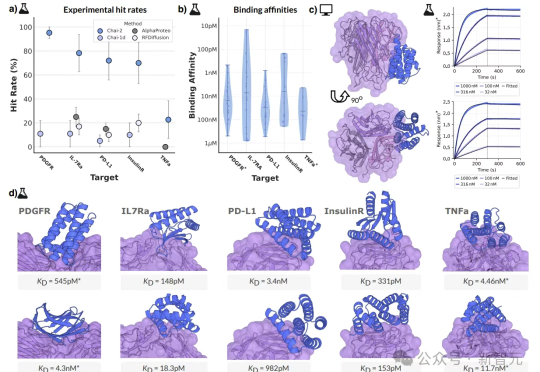

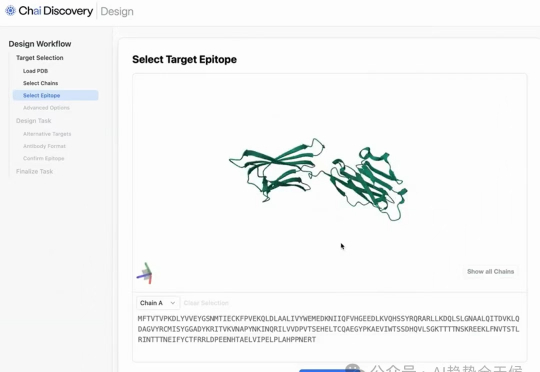

诺奖得主Hassabis预言成真!AI零样本发现新抗体,轰动整个医药圈10元一块实验板、2周时间、零样本命中率16%,这不是科幻,而是AI创造的生物技术奇迹!AI制药的拐点,或许已经到来——如果还在用老方法,那你可能已经被这场「淘汰赛」边缘化了……

10元一块实验板、2周时间、零样本命中率16%,这不是科幻,而是AI创造的生物技术奇迹!AI制药的拐点,或许已经到来——如果还在用老方法,那你可能已经被这场「淘汰赛」边缘化了……

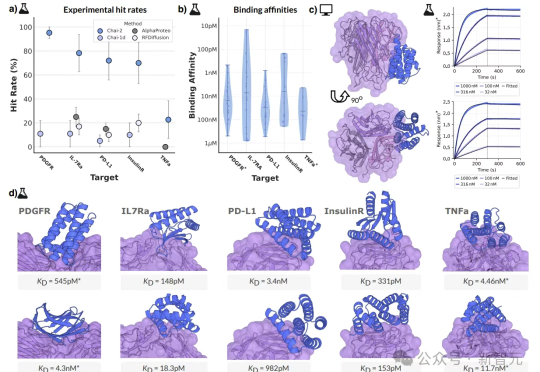

一个叫 Chai-2 的 AI 技术,听说它让制药业的老板们都坐不住了。啥?制药业跟你没关系?别急,故事才刚开始,慢慢聊。

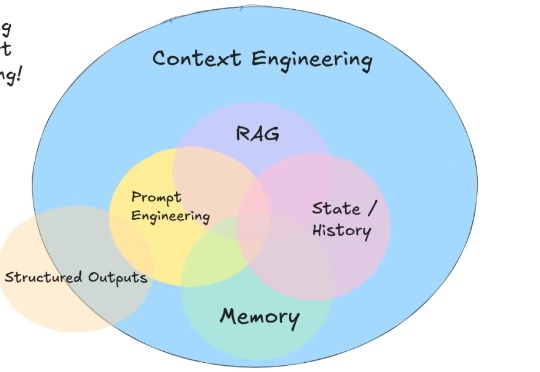

AI 时代,你可能听说过提示词工程、RAG、记忆等术语。但是很少有人提及上下文工程(context engineering)。

本文将介绍 22 种先进的RAG技术,灵感来源于 all-rag-techniques 仓库中的全面实现。这些实现使用 Python 库(如 NumPy、Matplotlib 和 OpenAI 的嵌入模型),避免使用 LangChain 或 FAISS 等依赖,以保持简单性和清晰度。

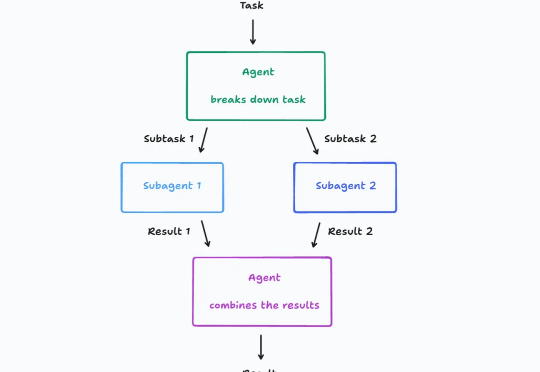

大模型驱动的 AI 智能体(Agent)架构最近讨论的很激烈,其中一个关键争议点在于: 多智能体到底该不该建?

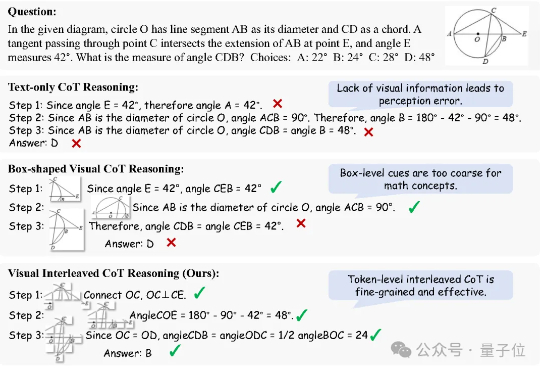

思维链(Chain of Thought, CoT)推理方法已被证明能够显著提升大语言模型(LLMs)在复杂任务中的表现。而在多模态大语言模型(MLLMs)中,CoT 同样展现出了巨大潜力。

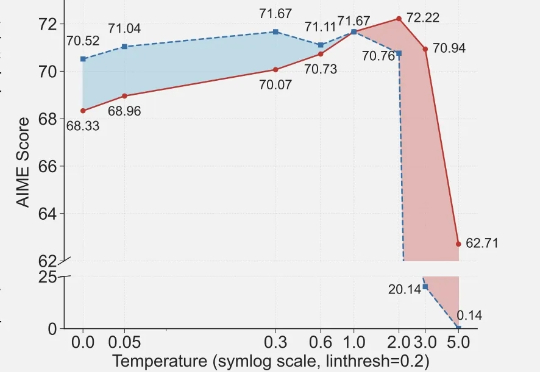

近期arxiv最热门论文,Qwen&清华LeapLab团队最新成果: 在强化学习训练大模型推理能力时,仅仅20%的高熵token就能撑起整个训练效果,甚至比用全部token训练还要好。

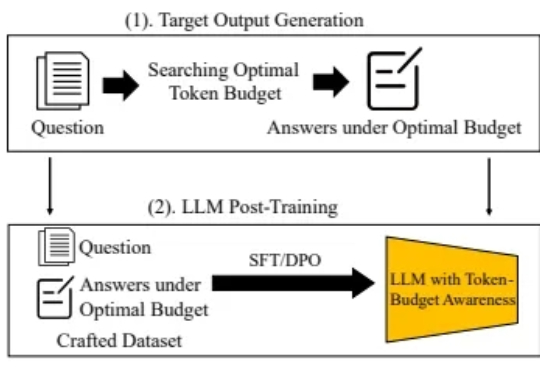

随着大型语言模型(LLM)技术的不断发展,Chain-of-Thought(CoT) 等推理增强方法被提出,以期提升模型在数学题解、逻辑问答等复杂任务中的表现,并通过引导模型逐步思考,有效提高了模型准确率。

在最新的 LangChain Interrupt 峰会上,AI Fund 创始人吴恩达与 LangChain 联合创始人 Harrison Chase 展开了一场对话。

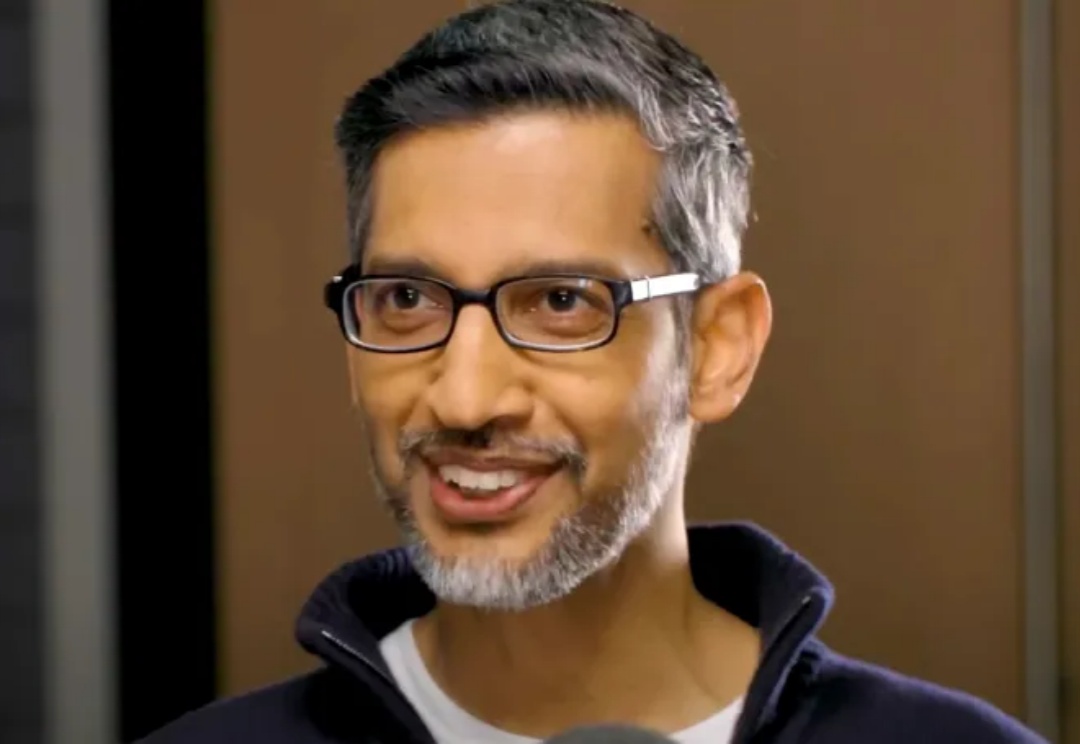

Google I/O 2025 结束后,Google CEO Sundar Pichai 接受了《The Verge》主编专访,这也是双方连续第三年于 I/O 后展开对谈,而今年的背景更为特殊:Gemini 模型全面更新、多模态生成工具 Veo3 登场、AI 功能深度融入 Android 与 XR 平台,Google 展现出前所未有的产品化信心。