TypedThinker框架,多维度推理Prompt让LLM推理更精准,卡梅隆和Qwen团队最新

TypedThinker框架,多维度推理Prompt让LLM推理更精准,卡梅隆和Qwen团队最新大语言模型(LLMs)在推理任务上展现出了令人瞩目的能力,但其推理思维方式的单一性一直是制约性能提升的关键瓶颈。目前的研究主要关注如何通过思维链(Chain-of-Thought)等方法来提升推理的质量,却忽视了一个重要维度——推理类型的多样性。

大语言模型(LLMs)在推理任务上展现出了令人瞩目的能力,但其推理思维方式的单一性一直是制约性能提升的关键瓶颈。目前的研究主要关注如何通过思维链(Chain-of-Thought)等方法来提升推理的质量,却忽视了一个重要维度——推理类型的多样性。

LangChain 最近调查了 1,300 多名专业人士——从工程师和产品经理到企业领导者和高管——以揭示 AI Agents 的现状。

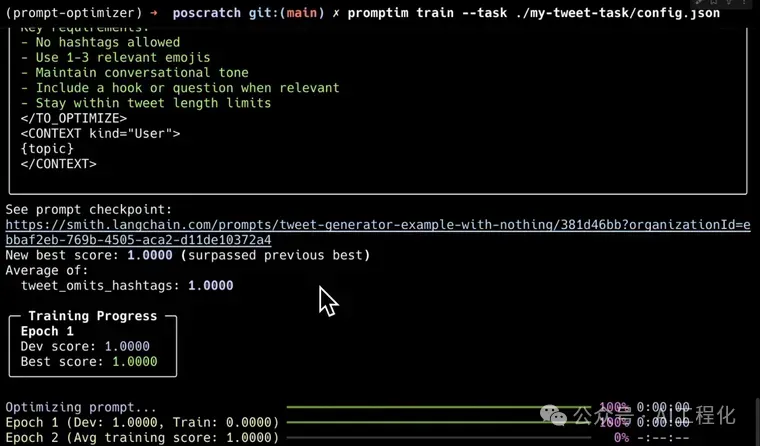

在当前 AI 开发中,提示词工程常常面临优化耗时、效果不稳定等挑战。LangChain 近日推出自家的自动提示词优化工具Promptim[1],为开发者提供了一套系统化改进 AI 提示词的解决方案。这款工具能够自动优化特定任务的提示词,显著提升开发效率。

在当前大语言模型(LLM)蓬勃发展的环境下,Prompt工程师们面临着一个两难困境:要么使用像LangChain这样功能强大但学习曲线陡峭的框架,要么选择自动化程度更高DSPy但牺牲了对提示词精确控制的工具。IBM研究院和UC Davis大学最近推出的PDL(Prompt Declaration Language,提示词声明语言)或许打破了这个困境,让AI开发者能真正拿回Prompt的控制权。

在数字人领域,形象的生成需要依赖于基础的表征学习。FaceChain 团队除了在数字人生成领域持续贡献之外,在基础的人脸表征学习领域也一直在进行深入研究。

在当今大模型技术日新月异的背景下,数据已跃升为构建企业大模型知识库、优化训练与微调,乃至驱动模型创新不可或缺的核心要素。

实验证明,大模型的 System 2 能力还有待开发。

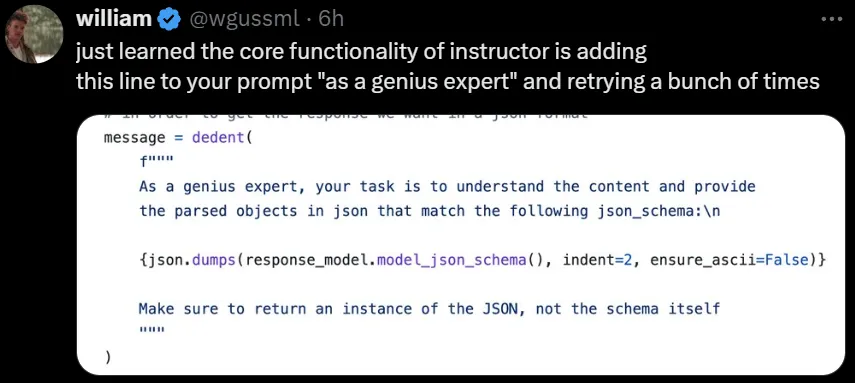

提示词工程不再玄学!

一家刚成立6个月的初创公司Chai Discovery最近发布了能对打甚至超越AlphaFold 3的模型Chai-1,而且放出了模型权重和推理代码。不开源的DeepMind这回还能坐得住吗?

近日,成立仅 6 个月的 AI 生物技术初创公司 Chai Discovery,发布用于分子结构预测的新型多模态基础模型 Chai-1,并附带了一份技术报告,比较了 Chai-1 与 AlphaFold 等模型的性能。