视频生成1.3B碾压14B、图像生成直逼GPT-4o!港科&快手开源测试时扩展新范式

视频生成1.3B碾压14B、图像生成直逼GPT-4o!港科&快手开源测试时扩展新范式测试时扩展(Test-Time Scaling)极大提升了大语言模型的性能,涌现出了如 OpenAI o 系列模型和 DeepSeek R1 等众多爆款。那么,什么是视觉领域的 test-time scaling?又该如何定义?

测试时扩展(Test-Time Scaling)极大提升了大语言模型的性能,涌现出了如 OpenAI o 系列模型和 DeepSeek R1 等众多爆款。那么,什么是视觉领域的 test-time scaling?又该如何定义?

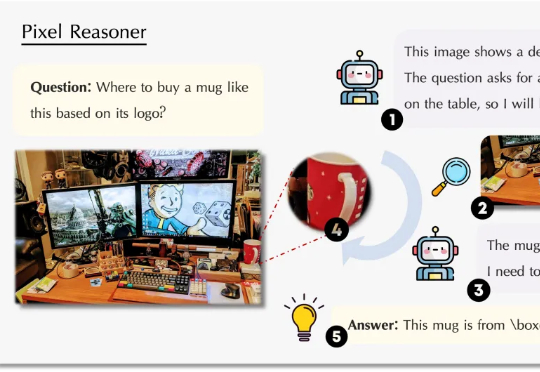

视觉语言模型(VLM)正经历从「感知」到「认知」的关键跃迁。 当OpenAI的o3系列通过「图像思维」(Thinking with Images)让模型学会缩放、标记视觉区域时,我们看到了多模态交互的全新可能。

前天,生财有术的老板亦仁发布了一条「超级标」(至少价值千万以上的现象级行业机会): 随着GPT-4o图像革命而来的,是无数的创业机会。

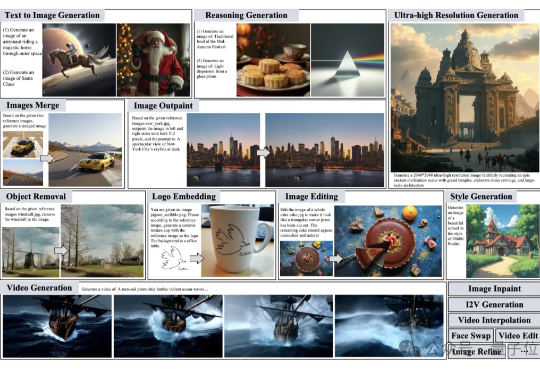

图像生成、视频创作、照片精修需要找不同的模型完成也太太太太太麻烦了。 有没有这样一个“AI创作大师”,你只需要用一句话描述脑海中的灵感,它就能自动为你搭建流程、选择工具、反复修改,最终交付高质量的视觉作品呢?

在文本推理领域,以GPT-o1、DeepSeek-R1为代表的 “慢思考” 模型凭借显式反思机制,在数学和科学任务上展现出远超 “快思考” 模型(如 GPT-4o)的优势。

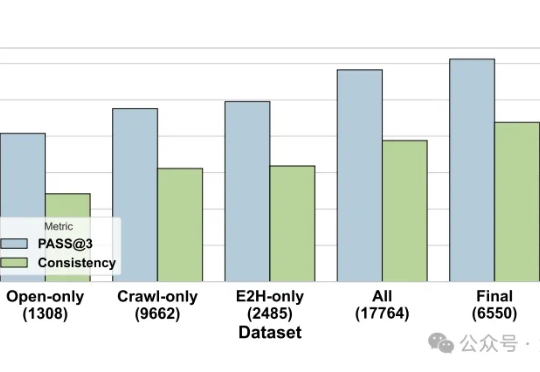

能够完成多步信息检索任务,涵盖多轮推理与连续动作执行的智能体来了。通义实验室推出WebWalker(ACL2025)续作自主信息检索智能体WebDancer。

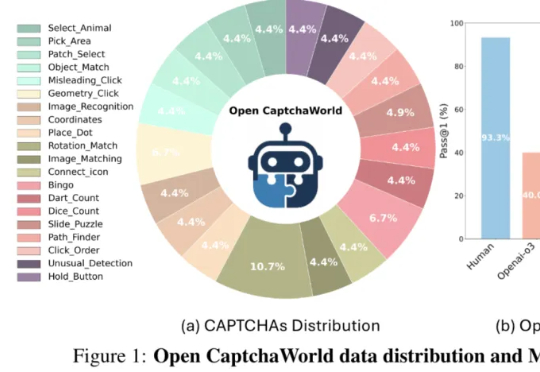

当前最强多模态Agent连验证码都解不了?

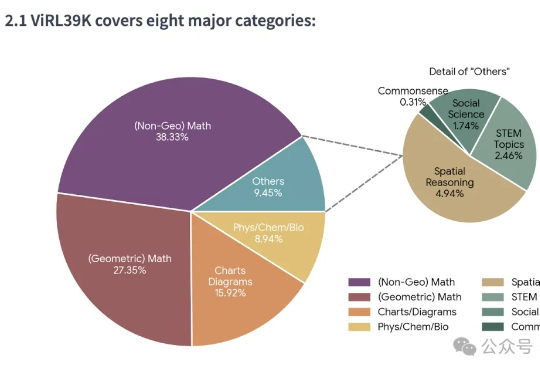

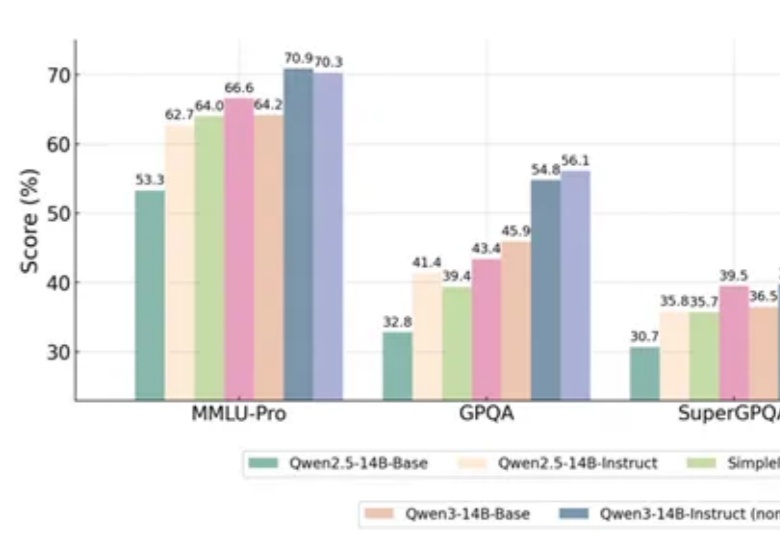

一项新的强化学习方法,直接让Qwen性能大增,GPT-4o被赶超!

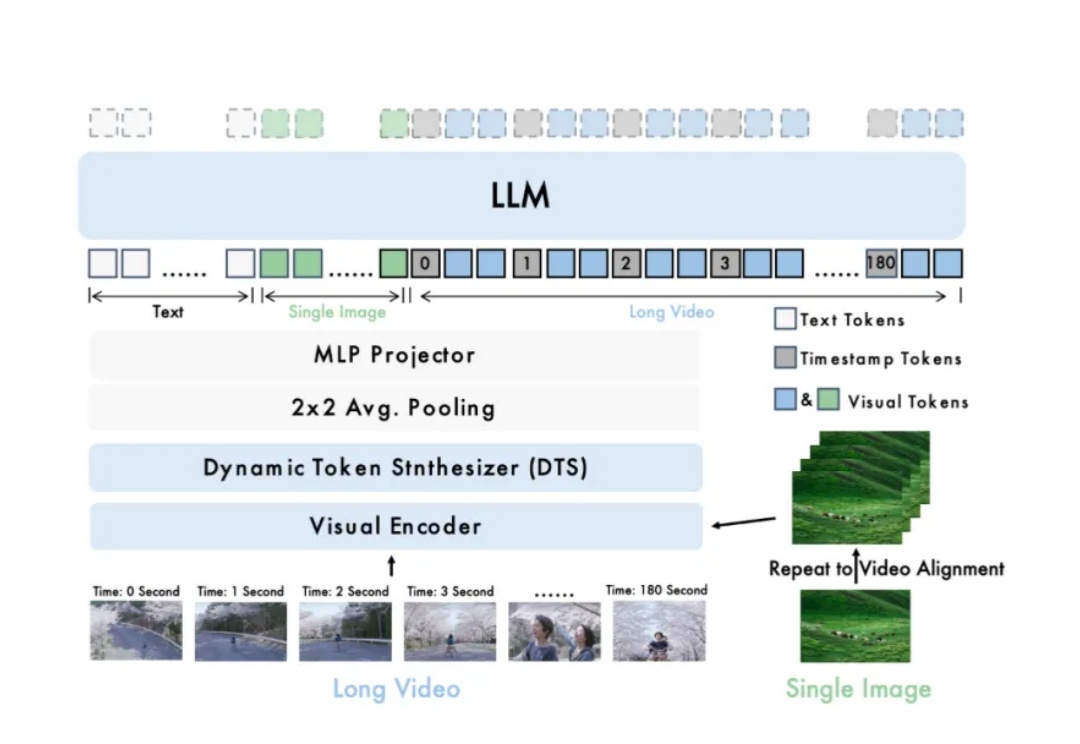

长视频理解是多模态大模型关键能力之一。尽管 OpenAI GPT-4o、Google Gemini 等私有模型已在该领域取得显著进展,当前的开源模型在效果、计算开销和运行效率等方面仍存在明显短板。

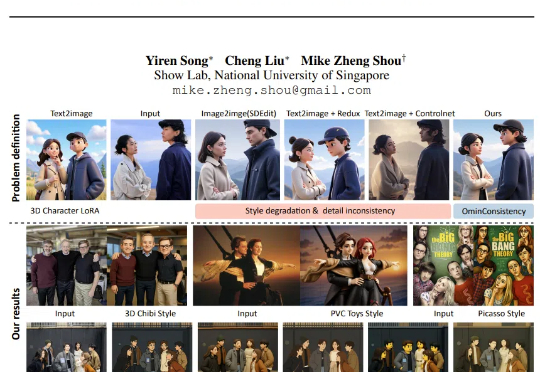

不久前,GPT-4o 的最新图像风格化与编辑能力横空出世,用吉卜力等风格生成的效果令人惊艳,也让我们清晰看到了开源社区与商业 API 在图像风格化一致性上的巨大差距。