李飞飞全新「世界模型」问世!单张H100实时生成3D永恒世界

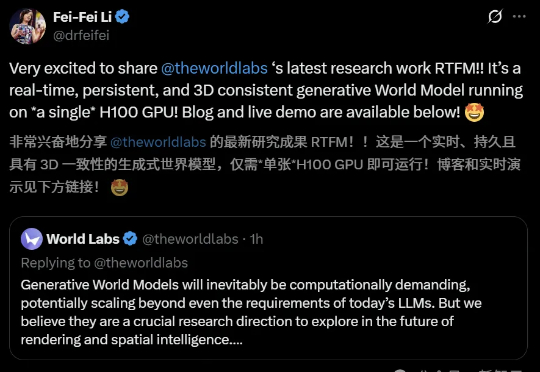

李飞飞全新「世界模型」问世!单张H100实时生成3D永恒世界一张图,一个3D世界!今天,李飞飞团队重磅放出实时生成世界模型「RTFM」,通过端到端学习大规模视频数据,直接从输入2D图像生成同一场景下新视角的图像。值得一提的是,它仅需单块H100 GPU便能实时渲染出持久且3D一致的世界。

一张图,一个3D世界!今天,李飞飞团队重磅放出实时生成世界模型「RTFM」,通过端到端学习大规模视频数据,直接从输入2D图像生成同一场景下新视角的图像。值得一提的是,它仅需单块H100 GPU便能实时渲染出持久且3D一致的世界。

李飞飞的世界模型创业,最新成果来了!刚刚,教母亲自宣布对外推出全新模型RTFM(A Real-Time Frame Model),不仅具备实时运行、持久性和3D一致性,更关键的是——单张H100 GPU就能跑。

马斯克宣布了一个疯狂的计划,将在5年内实现5000万张H100的算力,这是什么概念?这将为人类带来怎样的影响?ASI能否在勇敢者的孤注一掷下现身?

今天 ,OpenAI 开源了俩模型:120B/20B 117B 的 gpt-oss-120b 对标 o4-min,按官方说法至少需要 80G 内存,推荐使用单卡 H100 GPU 而刚买的的游戏本,刚好满足gpt-oss-120b 的部署条件

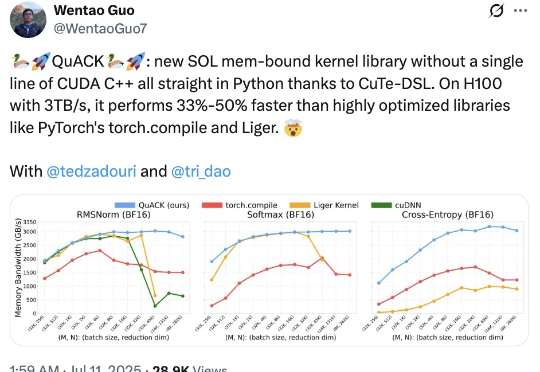

无需CUDA代码,给H100加速33%-50%! Flash Attention、Mamba作者之一Tri Dao的新作火了。

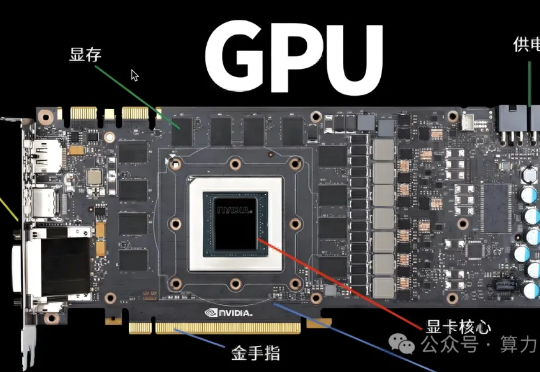

今年,AI大厂采购GPU的投入又双叒疯狂加码——马斯克xAI打算把自家的10万卡超算扩增10倍,Meta也计划投资100亿建设一个130万卡规模的数据中心……GPU的数量,已经成为了互联网企业AI实力的直接代表。

近日,来自SGLang、英伟达等机构的联合团队发了一篇万字技术报告:短短4个月,他们就让DeepSeek-R1在H100上的性能提升了26倍,吞吐量已非常接近DeepSeek官博数据!

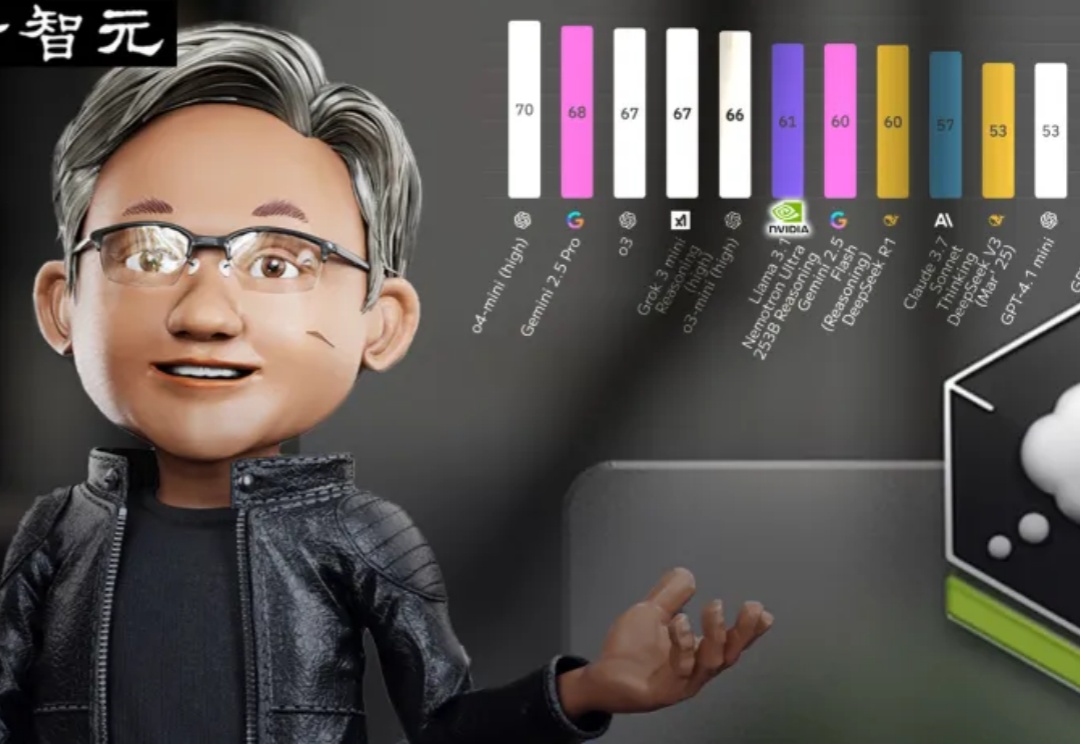

超越DeepSeek-R1的英伟达开源新王Llama-Nemotron,是怎么训练出来的?刚刚放出的论文,把一切细节毫无保留地全部揭秘了!

就在刚刚,美国政府曝光了各界对「AI行动计划」的全部政策建议。OpenAI措辞激烈地表示,DeepSeek让我们看到,必须马上锁死中国AI,必须限制高端GPU芯片和模型权重流向中国!Anthropic同样呼吁:必须立马补上H20这一关键漏洞,并且严控H100的门槛。

高端Ai服务器定义,满足以下2个条件:条件1.卡间互联,条件2.显存HBM。以H100为例子,不同的设备比如H100或者H20 为啥差别很大,主要是因为配置不同,成本差别10~20w,所以有差别!