GPU 维修那些事: H100 哪里容易坏?以 Llama3 训练大模型为例

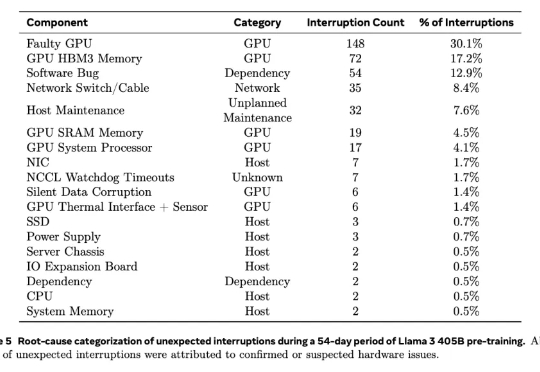

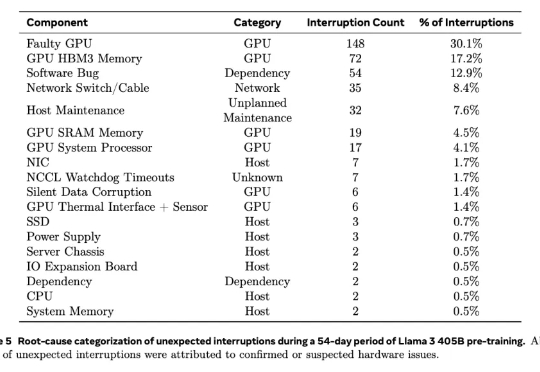

GPU 维修那些事: H100 哪里容易坏?以 Llama3 训练大模型为例根据去年2024年7月28日Meta公司在训练大模型(Llama 3)时使用“16384 个 英伟达H100 GPU 集群”的经验,该显卡在高负载、大规模集群运行环境下容易出现以下故障点:

根据去年2024年7月28日Meta公司在训练大模型(Llama 3)时使用“16384 个 英伟达H100 GPU 集群”的经验,该显卡在高负载、大规模集群运行环境下容易出现以下故障点:

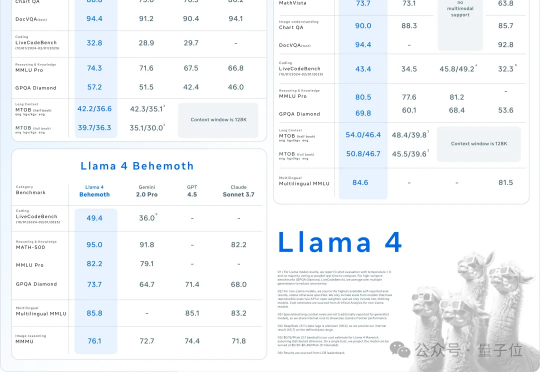

原生多模态Llama 4终于问世,开源王座一夜易主!首批共有两款模型Scout和Maverick,前者业界首款支持1000万上下文单H100可跑,后者更是一举击败了DeepSeek V3。目前,2万亿参数巨兽还在训练中。

AI不过周末,硅谷也是如此。大周日的,Llama家族上新,一群LIama 4就这么突然发布了。这是Meta首个基于MoE架构模型系列,目前共有三个款:Llama 4 Scout、Llama 4 Maverick、Llama 4 Behemoth。

在算力投资激增的当下,GPU卡回收与维修行业逐渐成为一条隐秘的暴利赛道。特别是一些众所周知的原因,串串资源的货源和魔改卡的维保是重灾区! 现状:运营一年以上的算力中心运营商手里一定有坏掉的A100和H100服务得不到及时维修,放在那吃灰,无法对外出租算力产生收入。

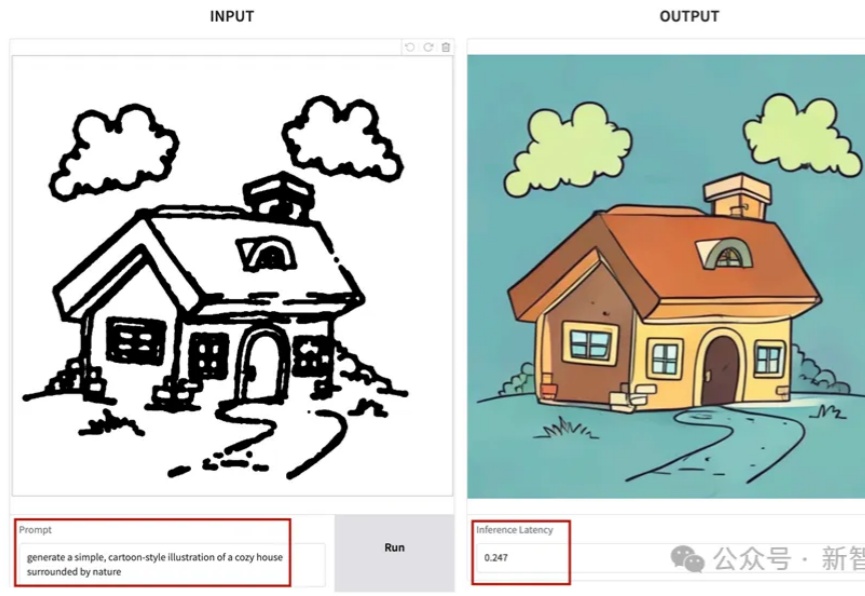

SANA-Sprint是一个高效的蒸馏扩散模型,专为超快速文本到图像生成而设计。通过结合连续时间一致性蒸馏(sCM)和潜空间对抗蒸馏(LADD)的混合蒸馏策略,SANA-Sprint在一步内实现了7.59 FID和0.74 GenEval的最先进性能。SANA-Sprint仅需0.1秒即可在H100上生成高质量的1024x1024图像,在速度和质量的权衡方面树立了新的标杆。

老黄在GTC 2025大会上,再次亮出了英伟达未来GPU路线图。随着推理token的暴增,AI计算需要全新的范式,下一代BlackWell Ultra、Vera Rubin就是最强的回应。

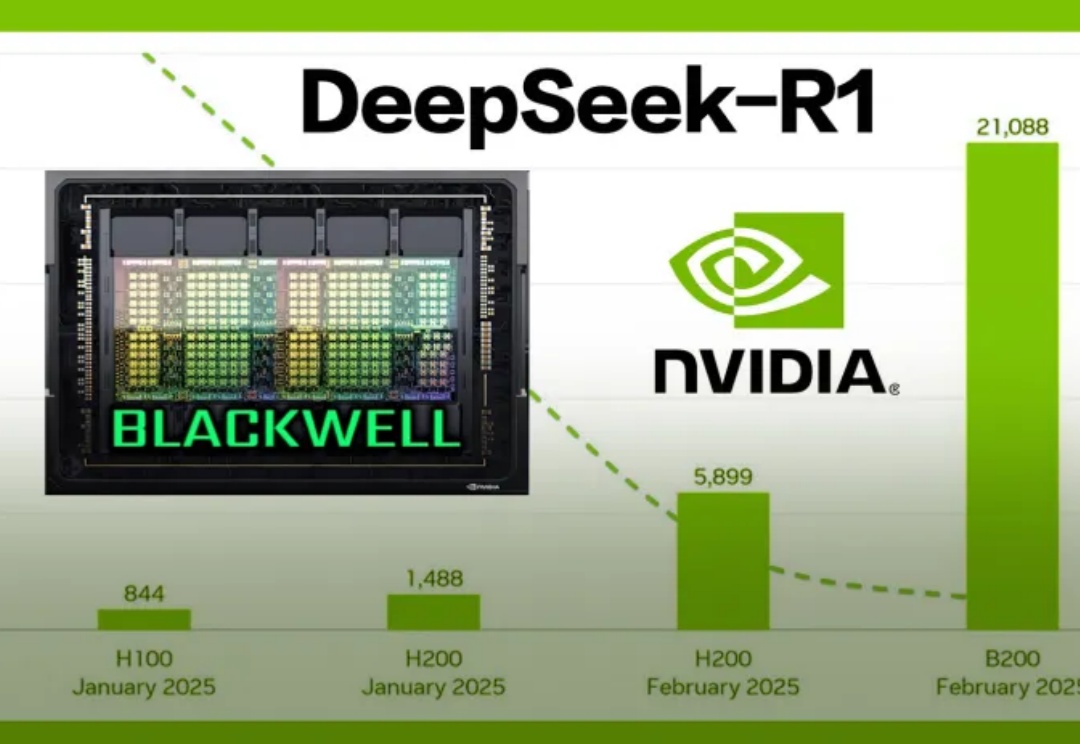

最近,英伟达开源了首个在Blackwell架构上优化的DeepSeek-R1,实现了推理速度提升25倍,和每token成本降低20倍的惊人成果。同时,DeepSeek连续开源多个英伟达GPU优化项目,共同探索模型性能极限。

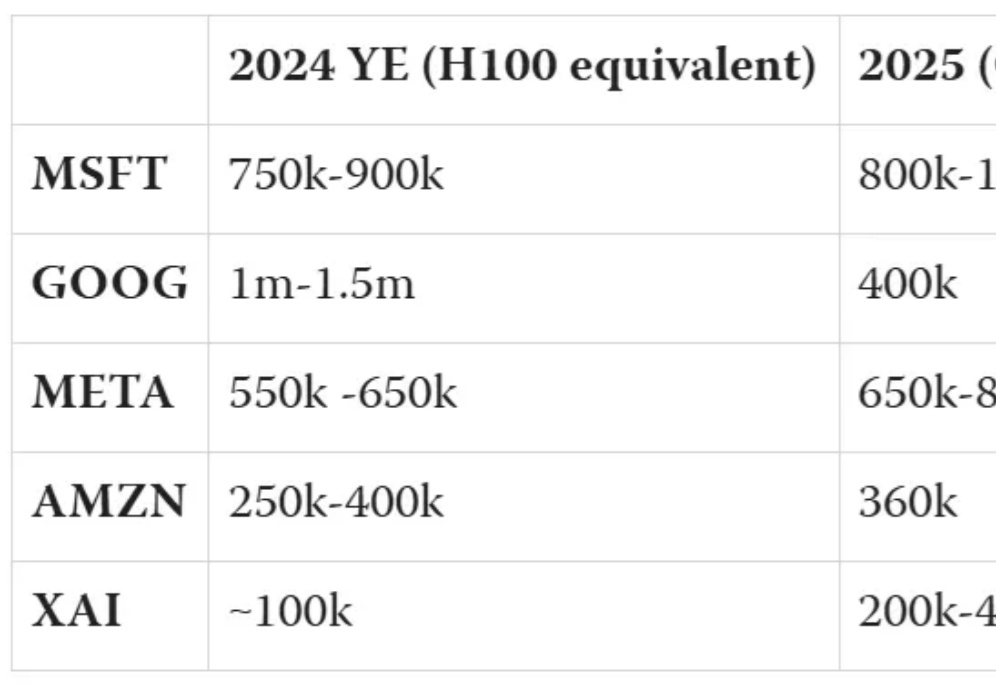

全球有多少AI算力?算力增长速度有多快?在这场AI「淘金热」中,都有哪些新「铲子」?AI初创企业Epoch AI发布了最新全球硬件估算报告。

AI巨头的芯片之争,谷歌微软目前分列一二。而xAI作为新入局者,正迅速崛起。这场竞争中,谁会成为最后赢家?

英伟达市值重回第一之际,黄仁勋再次接受采访。 除了谈自己和英伟达,还吹了一波马斯克,再再再次赞赏xAI只花19天建起10万卡H100超级集群。