历时6个月,Hugging Face开源LLM「超大规模实战手册」!200页3万字4000次训练

历时6个月,Hugging Face开源LLM「超大规模实战手册」!200页3万字4000次训练Hugging Face发布了「超大规模实战手册」,在512个GPU上进行超过4000个scaling实验。联创兼CEO Clement对此感到十分自豪。

Hugging Face发布了「超大规模实战手册」,在512个GPU上进行超过4000个scaling实验。联创兼CEO Clement对此感到十分自豪。

就在刚刚,网上已经出现了一波复现DeepSeek的狂潮。UC伯克利、港科大、HuggingFace等纷纷成功复现,只用强化学习,没有监督微调,30美元就能见证「啊哈时刻」!全球AI大模型,或许正在进入下一分水岭。

今天是个好日子,DeepSeek 与 Kimi 都更新了最新版的推理模型,吸引了广泛关注。与此同时,谷歌 DeepMind、加州大学圣地亚哥分校、阿尔伯塔大学的一篇新的研究论文也吸引了不少眼球,并直接冲上了 Hugging Face 每日论文榜第一(1 月 20 日)。

2019 年问世的 GPT-2,其 tokenizer 使用了 BPE 算法,这种算法至今仍很常见,但这种方式是最优的吗?来自 HuggingFace 的一篇文章给出了解释。

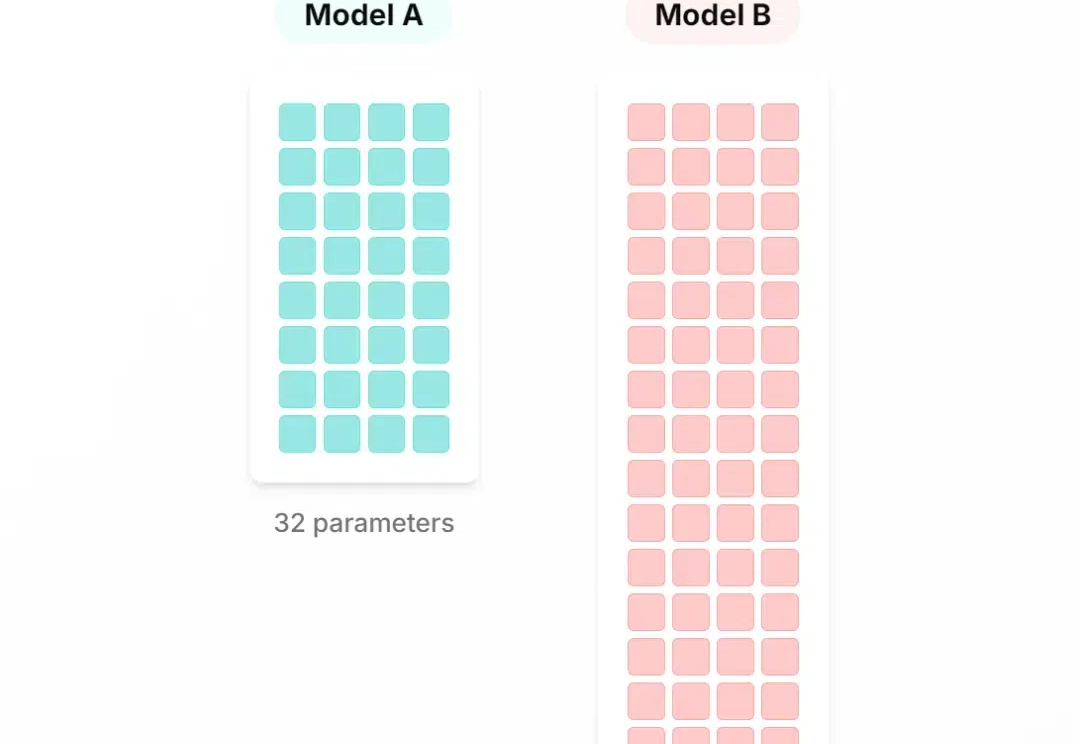

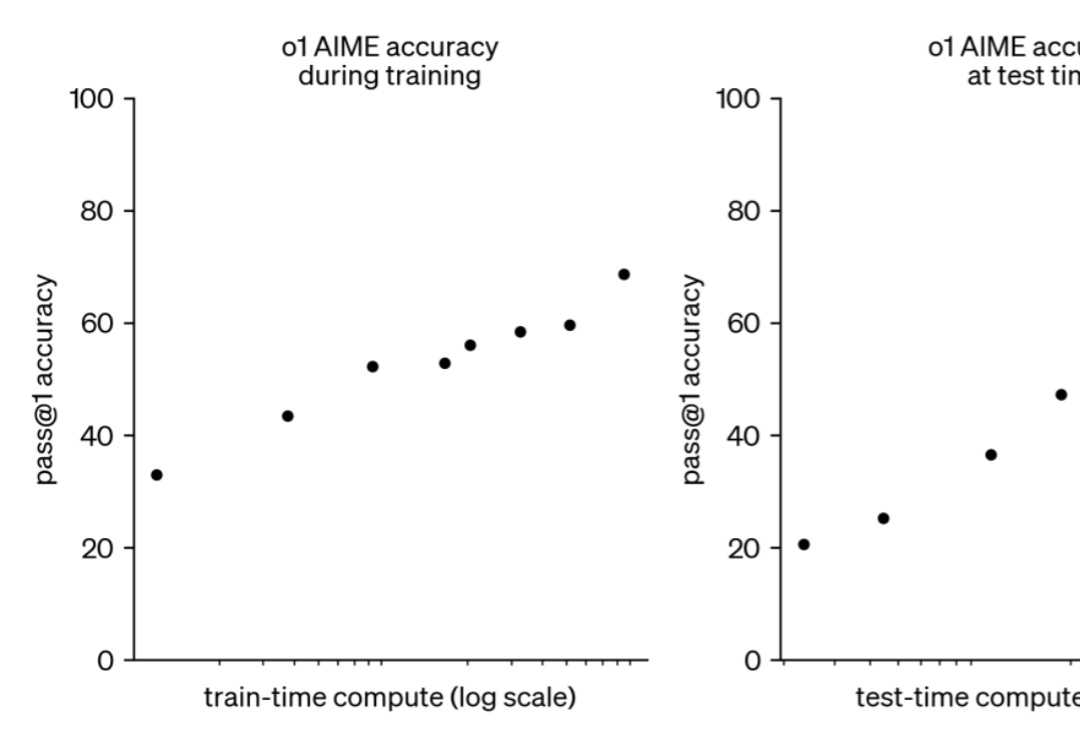

如果给小模型更长的思考时间,它们性能可以超越更大规模的模型。

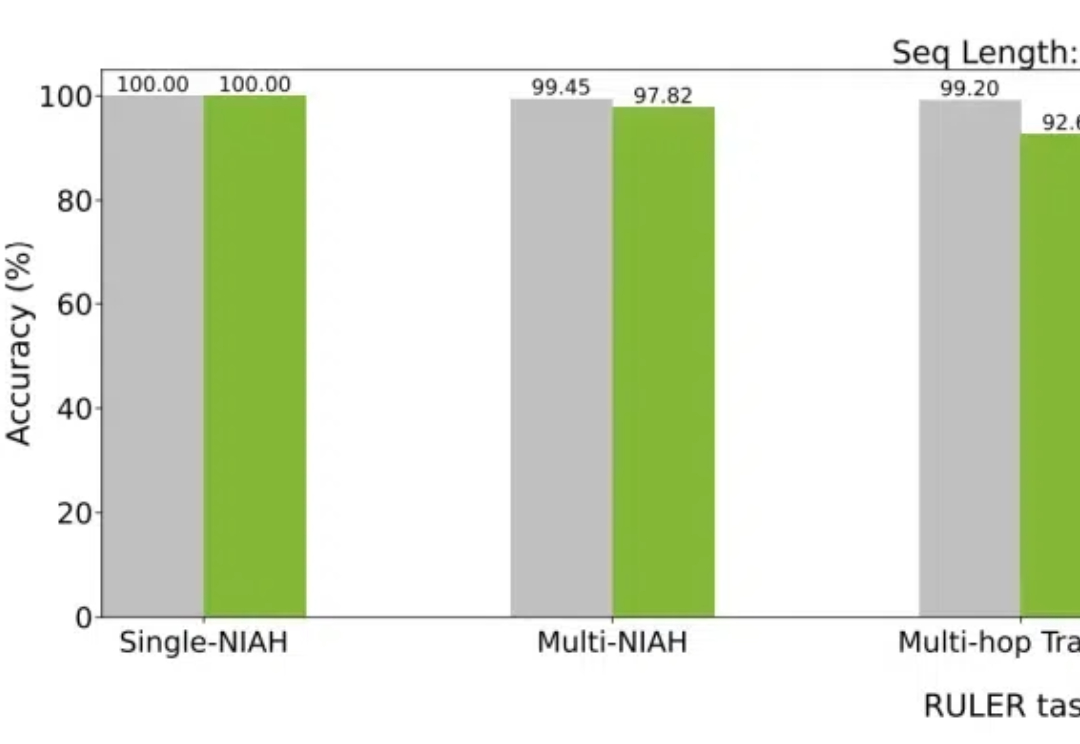

大模型如今已具有越来越长的上下文,而与之相伴的是推理成本的上升。英伟达最新提出的Star Attention,能够在不损失精度的同时,显著减少推理计算量,从而助力边缘计算。

社交平台Bluesky近期爆火,有人认为它可能取代X(原Twitter)。 作为新晋的社交平台,Bluesky在上周已突破2000万用户。在过去一周,Bluesky每天都有将近100万的新用户注册。特别是在美国大选结果揭晓后,大量的用户离开马斯克的X,转向Bluesky。

一个有效的复杂系统总是从一个有效的简单系统演化而来的。——John Gall

Hugging Face 上的模型数量已经超过了 100 万。但是几乎每个模型都是孤立的,难以与其它模型沟通。尽管有些研究者甚至娱乐播主试过让 LLM 互相交流,但所用的方法大都比较简单。

如果把人工智能比作人类技术史上的一场革命, 那么 Hugging Face 就是这场革命中的一位「使者」, 它用一场场真诚的拥抱,拉近了科研与应用、技术与人之间的距离。 今天,Hugging Face 已成为 AI 开源领域的明星,拥有超过 50 亿美元的估值,并成功将开源精神与商业化模式融合,成为全球最活跃的 AI 社区之一。 但这一切,起点却颇为意外,从一款聊天机器人开始。