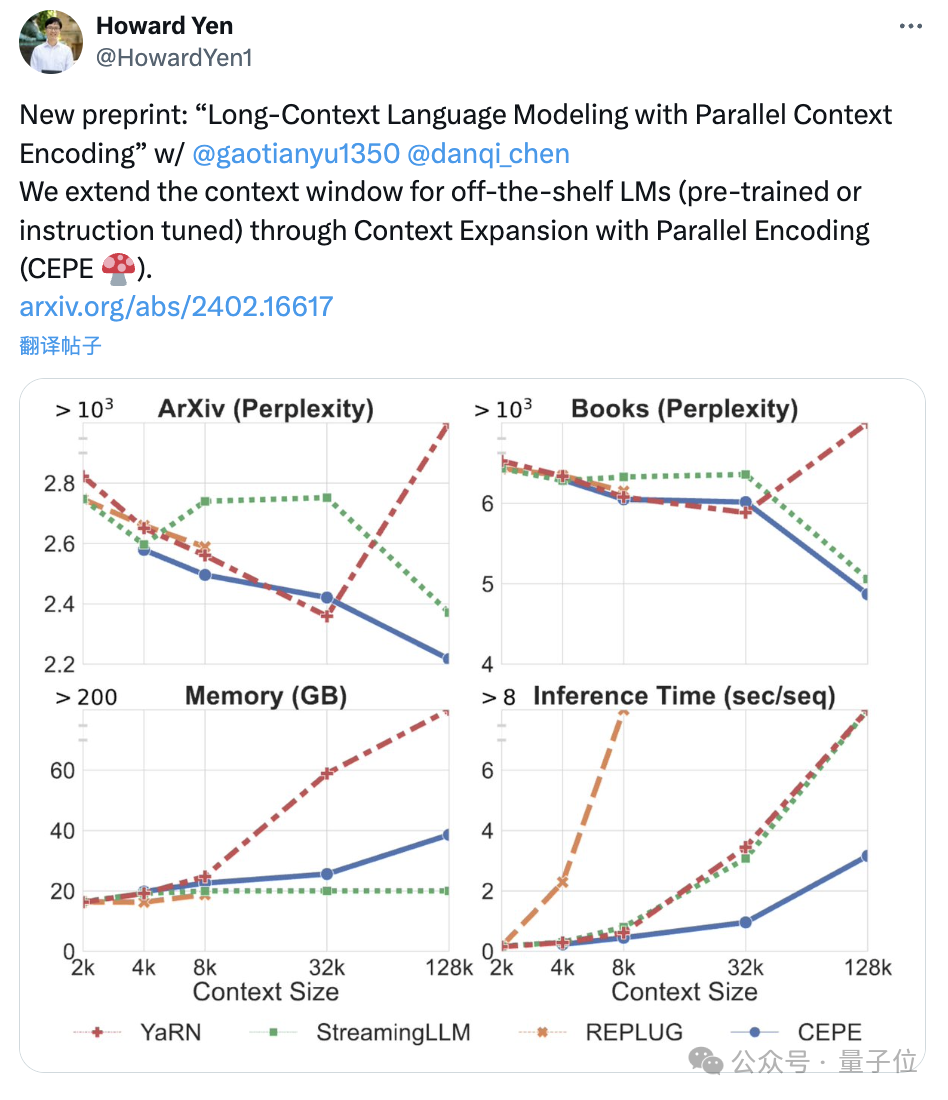

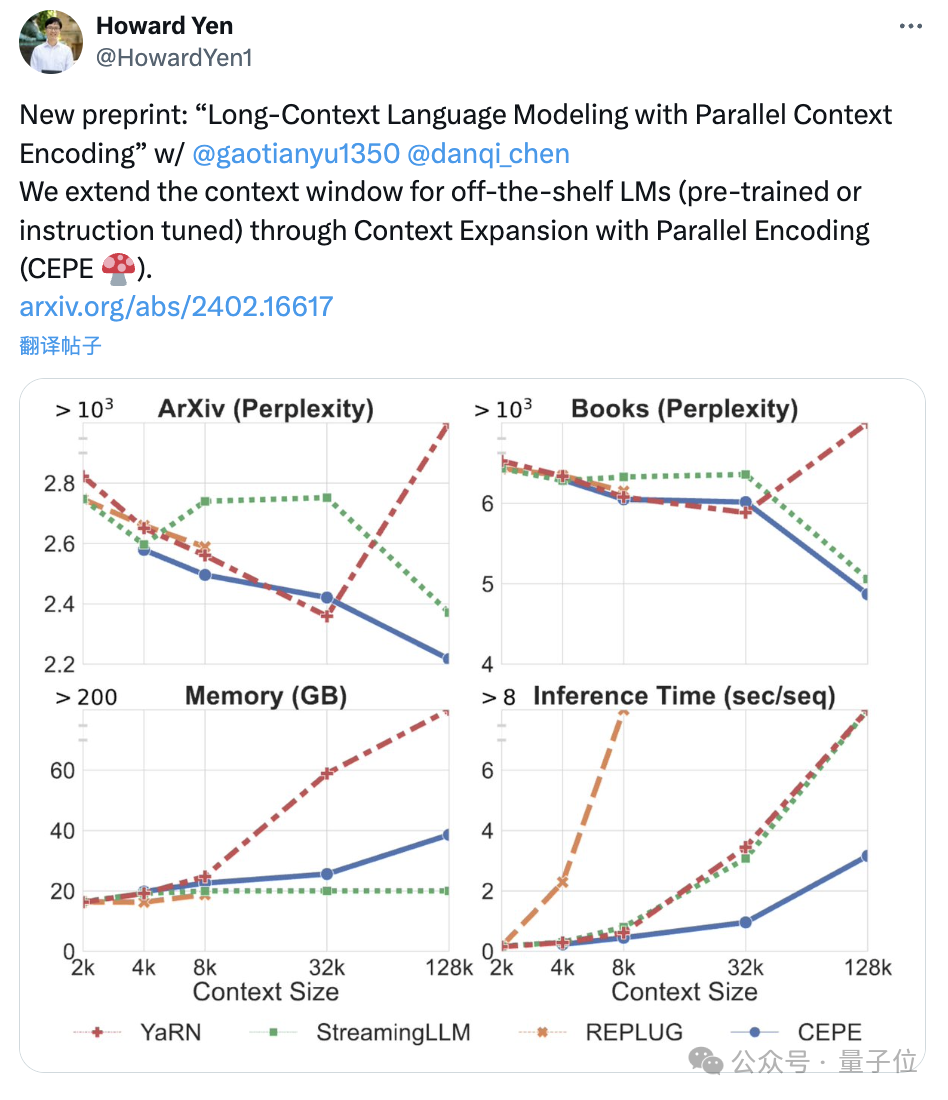

陈丹琦团队新作:Llama-2上下文扩展至128k,10倍吞吐量仅需1/6内存

陈丹琦团队新作:Llama-2上下文扩展至128k,10倍吞吐量仅需1/6内存陈丹琦团队刚刚发布了一种新的LLM上下文窗口扩展方法:它仅用8k大小的token文档进行训练,就能将Llama-2窗口扩展至128k。

陈丹琦团队刚刚发布了一种新的LLM上下文窗口扩展方法:它仅用8k大小的token文档进行训练,就能将Llama-2窗口扩展至128k。

2月16日,OpenAI推出了堪称“王炸”的文生视频大模型Sora,AI军备竞赛的战场加速向多模态转移,这意味着相比寻常LLM更为丰富的场景与机会。此外,2024年将成为AI硬件元年的共识也基本形成,业界对AI在智能终端的应用寄予厚望,将其视为提振消费电子市场的关键。

随着大语言模型(LLMs)在近年来取得显著进展,它们的能力日益增强,进而引发了一个关键的问题:如何确保他们与人类价值观对齐,从而避免潜在的社会负面影响?

最近几天,Sora 成为了全世界关注的焦点。与之相关的一切,都被放大到极致。

谷歌DeepMind最新研究发现,问题中前提条件的呈现顺序,对于大模型的推理性能有着决定性的影响,打乱顺序能让模型表现下降30%。

「从头开始构建GPT分词器」文字版来了。

终有一天,LLM可以成为人类数据专家,针对不同领域进行数据分析,大大解放AI研究员。

最近几年,基于 Transformer 的架构在多种任务上都表现卓越,吸引了世界的瞩目。使用这类架构搭配大量数据,得到的大型语言模型(LLM)等模型可以很好地泛化用于真实世界用例。

在过去的 2023 年中,大型语言模型(LLM)在潜力和复杂性方面都获得了飞速的发展。展望 2024 年的开源和研究进展,似乎我们即将进入一个可喜的新阶段:在不增大模型规模的前提下让模型变得更好,甚至让模型变得更小。

推测解码(Speculative Decoding)是谷歌等机构在 2022 年发现的大模型推理加速方法。它可以在不损失生成效果前提下,获得 3 倍以上的加速比。GPT-4 泄密报告也提到 OpenAI 线上模型推理使用了它。