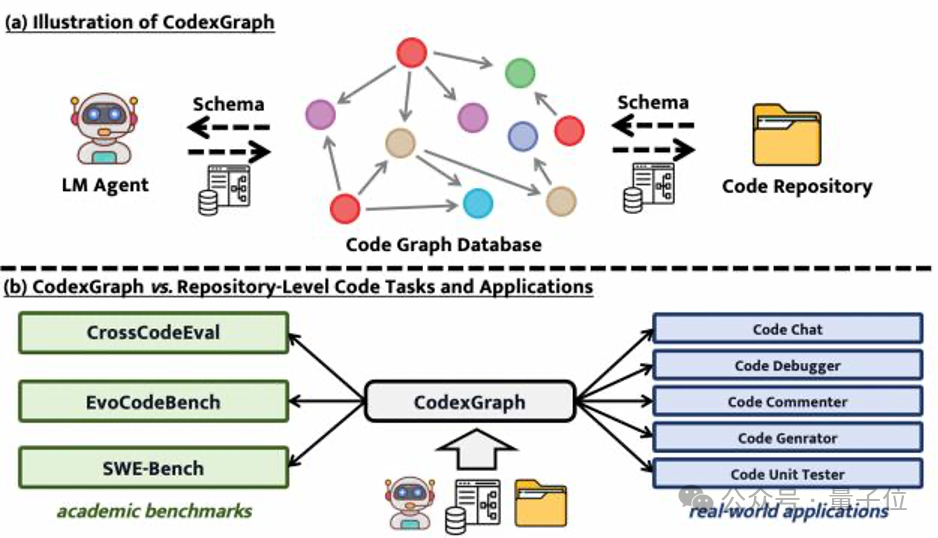

让AI管理大型代码库,开发者福音来了 | 阿里/新加坡国立/西安交大联合出品

让AI管理大型代码库,开发者福音来了 | 阿里/新加坡国立/西安交大联合出品代码生成和补全任务做不完了?!

代码生成和补全任务做不完了?!

在过去的几年中,大型语言模型(Large Language Models, LLMs)在自然语言处理(NLP)领域取得了突破性的进展。这些模型不仅能够理解复杂的语境,还能够生成连贯且逻辑严谨的文本。

多模态大语言模型 (Multimodal Large Language Moodel, MLLM) 以其强大的语言理解能力和生成能力,在各个领域取得了巨大成功。

LLM数学水平不及小学生怎么办?CMU清华团队提出了Lean-STaR训练框架,在语言模型进行推理的每一步中都植入CoT,提升了模型的定理证明能力,成为miniF2F上的新SOTA。

RLHF到底是不是强化学习?最近,AI大佬圈因为这个讨论炸锅了。和LeCun同为质疑派的Karpathy表示:比起那种让AlphaGo在围棋中击败人类的强化学习,RLHF还差得远呢。

前段时间冲上热搜的问题「9.11比9.9大吗?」,让几乎所有LLM集体翻车。看似热度已过,但AI界大佬Andrej Karpathy却从中看出了当前大模型技术的本质缺陷,以及未来的潜在改进方向。

吴恩达教授开新课了,还是亲自授课!

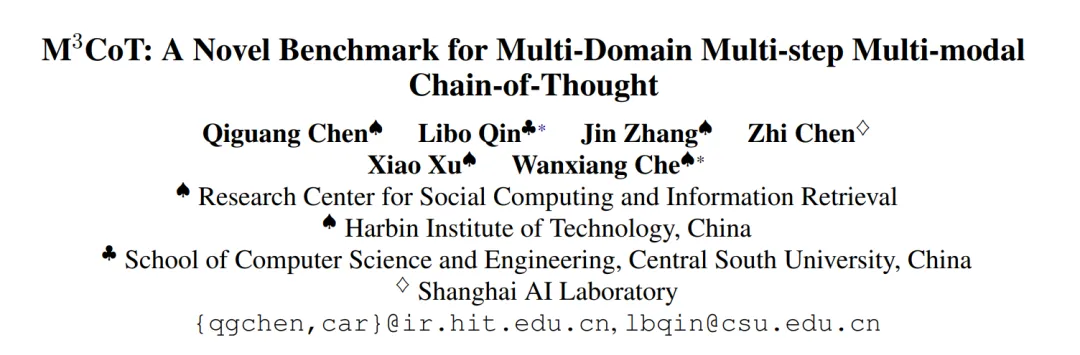

LLM的数学推理能力缺陷得到了很多研究的关注,但最近浙大、中科院等机构的学者们提出,先进模型在视觉推理方面同样不足。为此他们提出了一种多模态的视觉推理基准,并设计了一种新颖的数据合成方法。

数以亿计的人体验过ChatGPT,但许多人尝试过后便未再回头。每家大型企业也都曾尝试过相关试点项目,但真正投入应用的却寥寥无几。这其中部分原因可能只是时间问题。然而,大型语言模型(LLMs)可能也存在陷阱:它们看似是产品,给人以神奇之感,但实际上并非如此。或许,我们终究需要经历寻找产品与市场契合点的漫长而单调的探索过程。

打造终身学习智能体,是研究界以来一直追求的目标。最近,帝国理工联手谷歌DeepMind打造了创新联合框架扩散增强智能体(DAAG),利用LLM+VLM+DM三大模型,让AI完成迁移学习、高效探索。