探索LLM推理全阶段的JSON格式输出限制方法

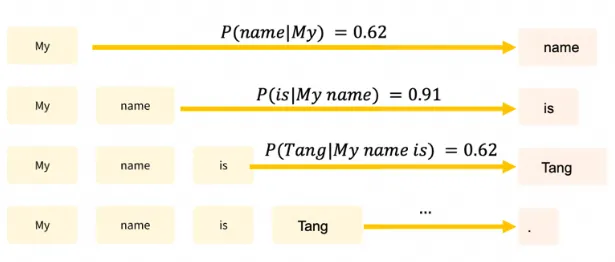

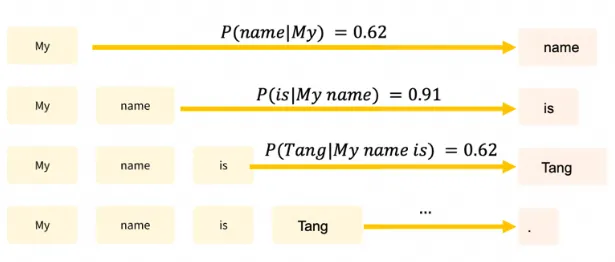

探索LLM推理全阶段的JSON格式输出限制方法文章详细讨论了如何确保大型语言模型(LLMs)输出结构化的JSON格式,这对于提高数据处理的自动化程度和系统的互操作性至关重要。

文章详细讨论了如何确保大型语言模型(LLMs)输出结构化的JSON格式,这对于提高数据处理的自动化程度和系统的互操作性至关重要。

近日,来自乔治梅森大学和腾讯AI实验室的研究团队在这一领域取得了重大突破。他们提出了一种名为DOTS(Dynamic Optimal Trajectory Search)的创新方法,通过最佳推理轨迹搜索,显著提升LLMs的动态推理能力。

大型语言模型(LLMs)虽然在适应新任务方面取得了长足进步,但它们仍面临着巨大的计算资源消耗,尤其在复杂领域的表现往往不尽如人意。

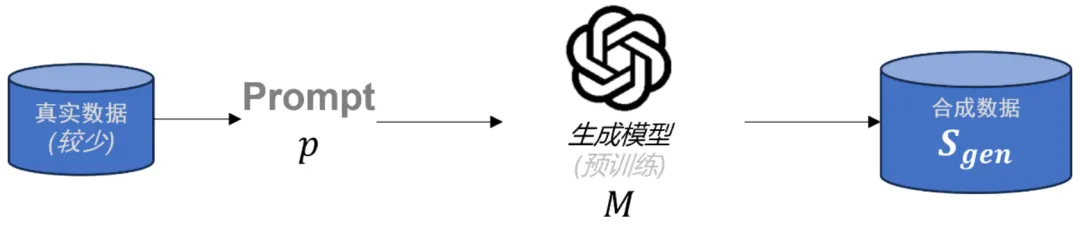

在大语言模型(LLMs)后训练任务中,由于高质量的特定领域数据十分稀缺,合成数据已成为重要资源。虽然已有多种方法被用于生成合成数据,但合成数据的理论理解仍存在缺口。为了解决这一问题,本文首先对当前流行的合成数据生成过程进行了数学建模。

本文是一篇发表在 NeurIPS 2024 上的论文,单位是香港大学、Sea AI Lab、Contextual AI 和俄亥俄州立大学。论文主要探讨了大型语言模型(LLMs)的词表大小对模型性能的影响。

知名开源数据科学平台提供商Anaconda 今天宣布推出AI Navigator,这是一款新型桌面应用程序,允许用户在笔记本电脑或个人电脑上本地运行一系列人工智能应用的大型语言模型(LLMs),而无需将任何数据发送到云服务器。

大语言模型(Large Language Models, LLMs)的强大能力推动了 LLM Agent 的迅速发展。围绕增强 LLM Agent 的能力,近期相关研究提出了若干关键组件或工作流。然而,如何将核心要素集成到一个统一的框架中,能够进行端到端优化,仍然是一个亟待解决的问题。

扩展多模态大语言模型(MLLMs)的长上下文能力对于视频理解、高分辨率图像理解以及多模态智能体至关重要。这涉及一系列系统性的优化,包括模型架构、数据构建和训练策略,尤其要解决诸如随着图像增多性能下降以及高计算成本等挑战。

斯坦福大学的最新研究通过大规模实验发现,尽管大型语言模型(LLMs)在新颖性上优于人类专家的想法,但在可行性方面略逊一筹,还需要进一步研究以提高其实用性。

大型语言模型(LLMs)虽然进展很快,很强大,但是它们仍然存在会产生幻觉、生成有害内容和不遵守人类指令等问题。一种流行的解决方案就是基于【自我纠正】,大概就是看自己输出的结果,自己反思一下有没有错,如果有错就自己改正。目前自己纠正还是比较关注于让大模型从错误中进行学习。