1.6万块H100训Llama 3.1,每3小时故障1次!罪魁祸首竟是GPU和HBM3显存

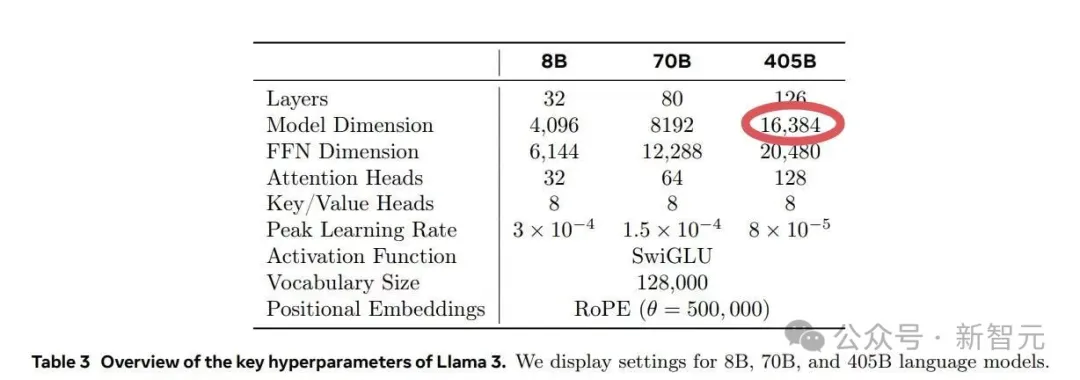

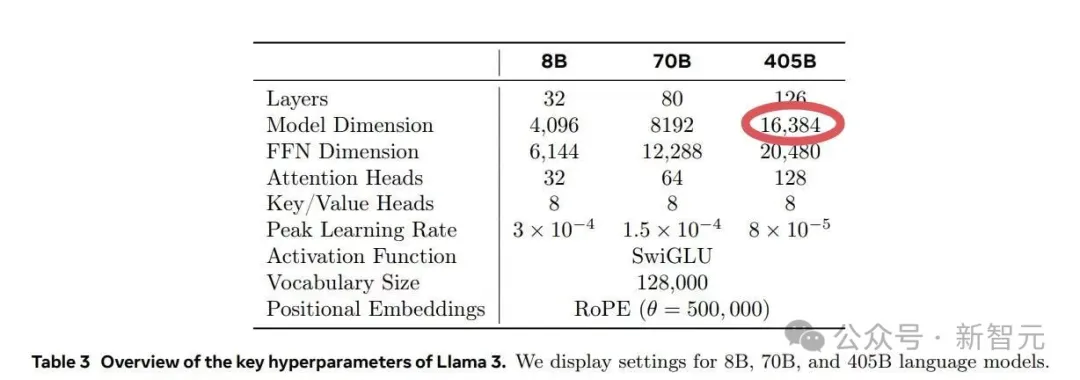

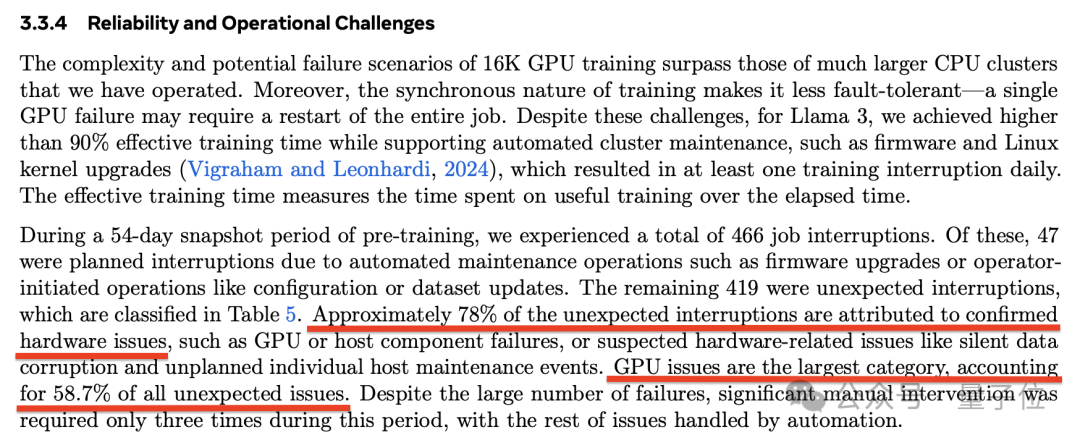

1.6万块H100训Llama 3.1,每3小时故障1次!罪魁祸首竟是GPU和HBM3显存在Meta的Llama 3.1训练过程中,其运行的1.6万个GPU训练集群每3小时就会出现一次故障,意外故障中的半数都是由英伟达H100 GPU和HBM3内存故障造成的。

在Meta的Llama 3.1训练过程中,其运行的1.6万个GPU训练集群每3小时就会出现一次故障,意外故障中的半数都是由英伟达H100 GPU和HBM3内存故障造成的。

每3个小时1次、平均1天8次,Llama 3.1 405B预训练老出故障,H100是罪魁祸首?

不是大模型用不起,而是小模型更有性价比。

Meta 发布 Llama 3.1 405B,开放权重大模型的性能表现首次与业内顶级封闭大模型比肩,AI 行业似乎正走向一个关键的分叉点。扎克伯格亲自撰文,坚定表明「开源 AI 即未来」,再次将开源与封闭的争论推向舞台中央。

最近,Latent Space发布的播客节目中请来了Meta的AI科学家Thomas Scialom。他在节目中揭秘了Llama 3.1的一些研发思路,并透露了后续Llama 4的更新方向。

最近两款大型 AI 模型相继发布。

芯片巨头英伟达,在AI时代一直被类比为在淘金热中“卖铲子”的背后赢家。

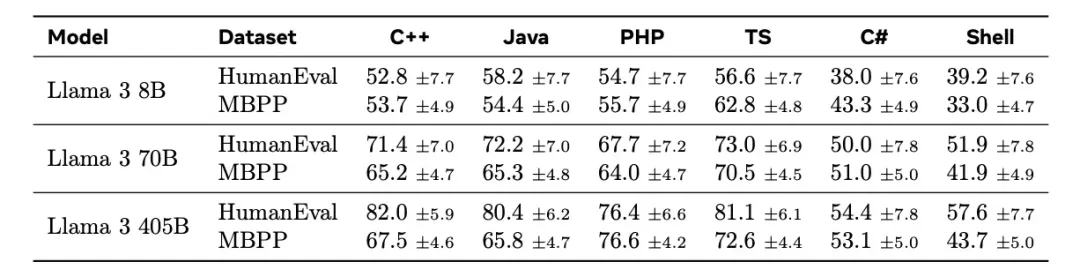

用来运行 Llama 3 405B 优势明显。

Llama 3.1 405B巨兽开源的同时,OpenAI又抢了一波风头。从现在起,每天200万训练token免费微调模型,截止到9月23日。

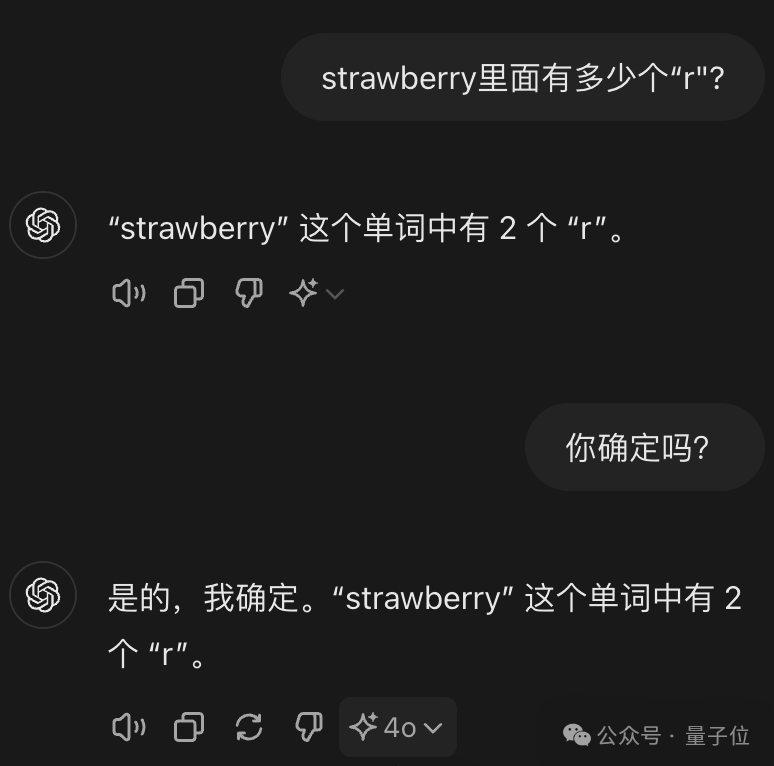

继分不清9.11和9.9哪个大以后,大模型又“集体失智”了!