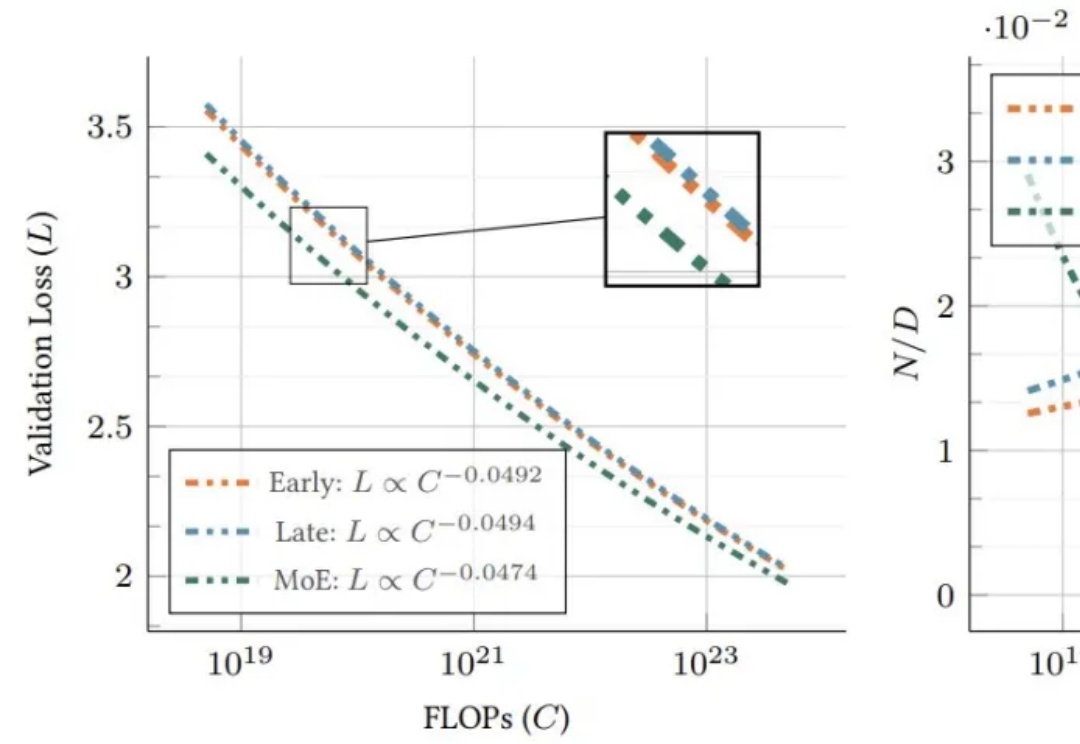

苹果提出原生多模态Scaling Law!早融合+MoE,性能飙升秘密武器

苹果提出原生多模态Scaling Law!早融合+MoE,性能飙升秘密武器研究揭示早融合架构在低计算预算下表现更优,训练效率更高。混合专家(MoE)技术让模型动态适应不同模态,显著提升性能,堪称多模态模型的秘密武器。

研究揭示早融合架构在低计算预算下表现更优,训练效率更高。混合专家(MoE)技术让模型动态适应不同模态,显著提升性能,堪称多模态模型的秘密武器。

现如今,微调和强化学习等后训练技术已经成为提升 LLM 能力的重要关键。

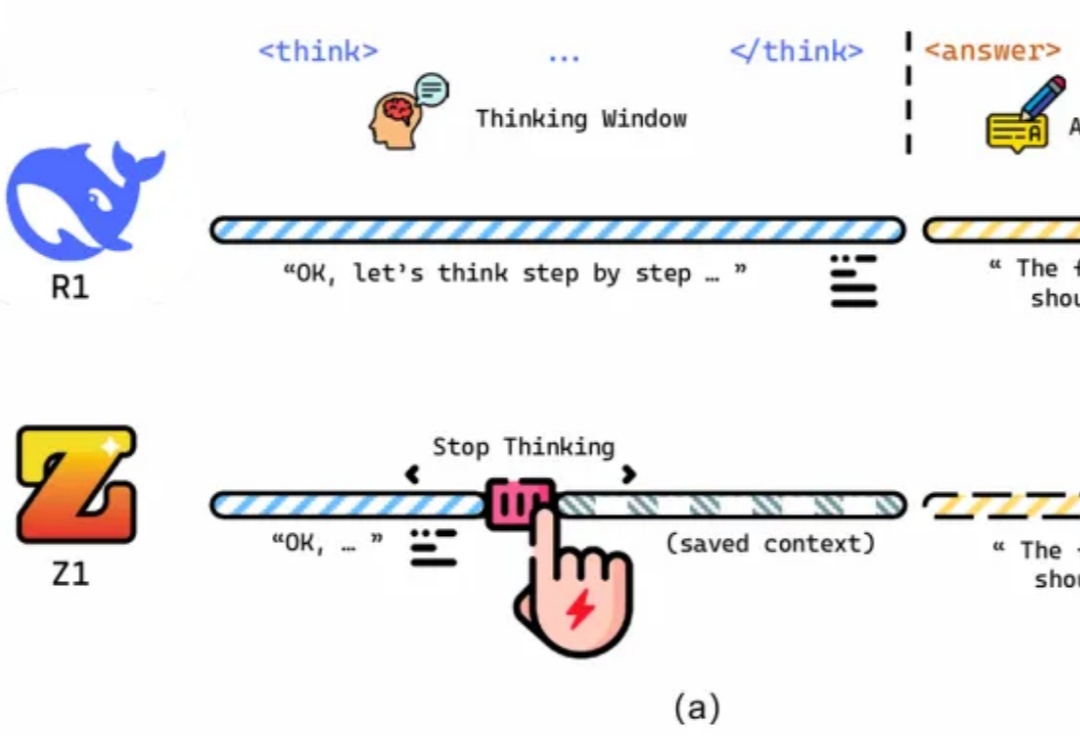

最近,DeepSeek-R1 和 OpenAI o1/03 等推理大模型在后训练阶段探索了长度扩展(length scaling),通过强化学习(比如 PPO、GPRO)训练模型生成很长的推理链(CoT),并在奥数等高难度推理任务上取得了显著的效果提升。

最近一段时间,各家新势力都在角力部署端到端的智能驾驶系统。

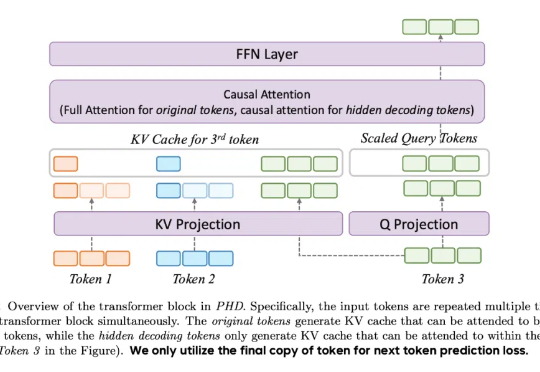

让大模型进入多模态模式,从而能够有效感知世界,是最近 AI 领域里人们一直的探索目标。

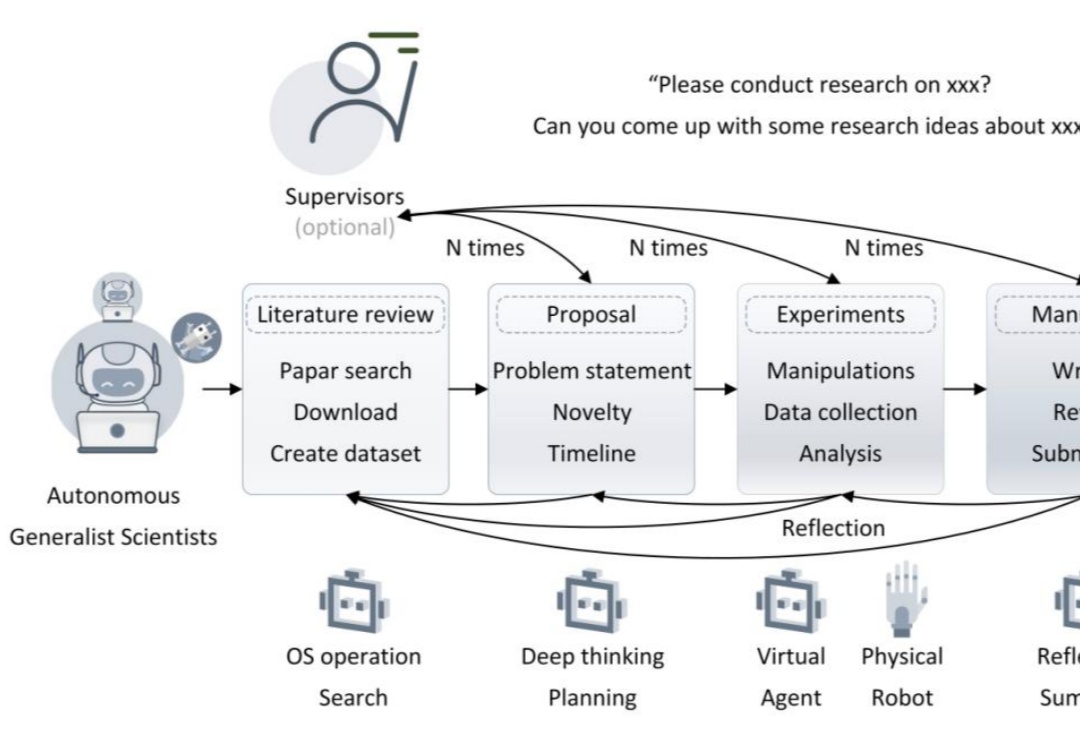

自主通才科学家的 5 个层级。

AI Agent 领域也存在 scaling law,甚至还在加速。

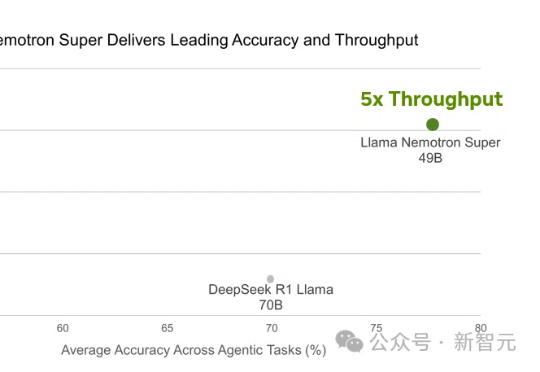

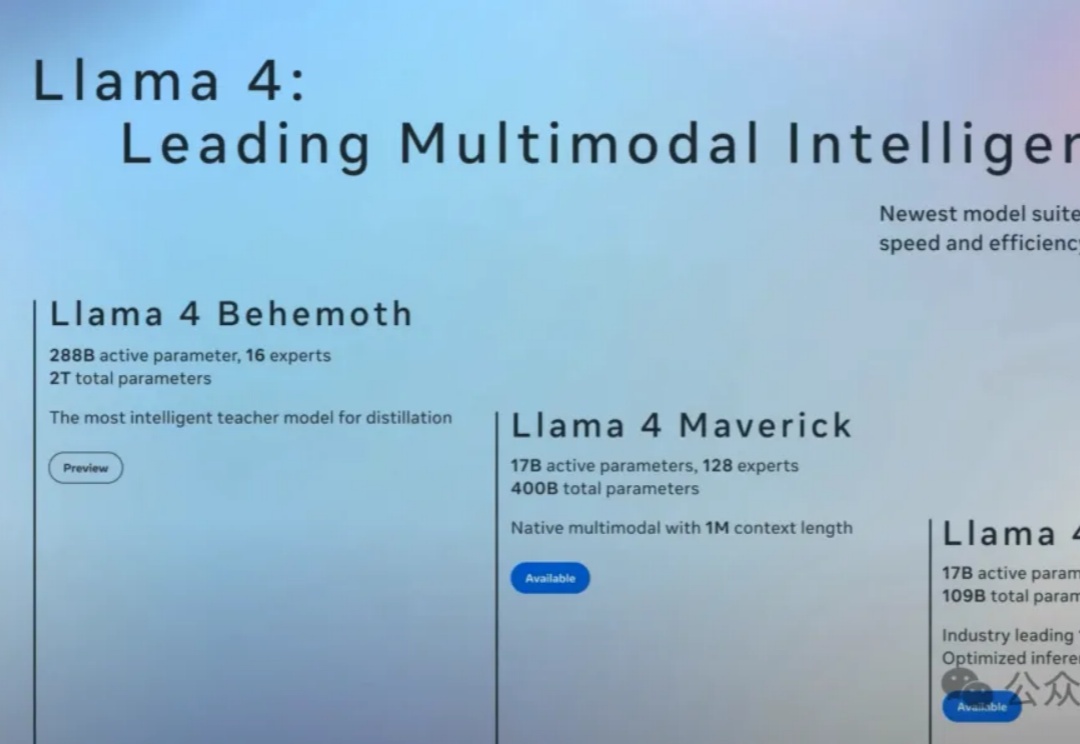

Llama 4刚出世就被碾压!英伟达强势开源Llama Nemotron-253B推理模型,在数学编码、科学问答中准确率登顶,甚至以一半参数媲美DeepSeek R1,吞吐量暴涨4倍。关键秘诀,就在于团队采用的测试时Scaling。

刚刚,一位AI公司CEO细细扒皮了关于Llama 4的五大疑点。甚至有圈内人表示,Llama 4证明Scaling已经结束了,LLM并不能可靠推理。但更可怕的事,就是全球的AI进步恐将彻底停滞。

推理性能提升的同时,还大大减少Token消耗!