NVIDIA Tensor Core 的演变:从 Volta 到 Blackwell

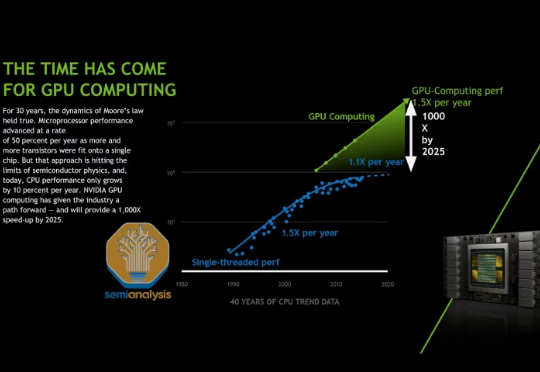

NVIDIA Tensor Core 的演变:从 Volta 到 Blackwell在我们去年 AI Scaling Laws article from late last year中,我们探讨了多层 AI 扩展定律如何持续推动 AI 行业向前发展,使得模型能力的增长速度超过了摩尔定律,并且单位 token 成本也相应地迅速降低。

在我们去年 AI Scaling Laws article from late last year中,我们探讨了多层 AI 扩展定律如何持续推动 AI 行业向前发展,使得模型能力的增长速度超过了摩尔定律,并且单位 token 成本也相应地迅速降低。

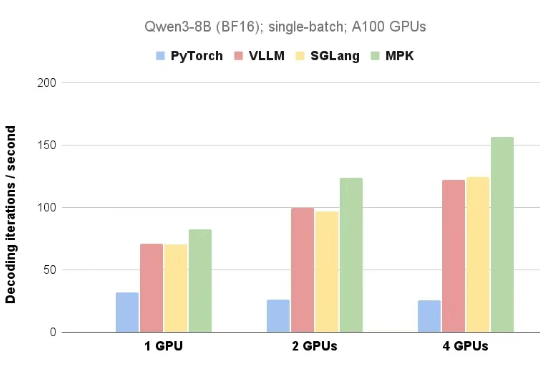

在 AI 领域,英伟达开发的 CUDA 是驱动大语言模型(LLM)训练和推理的核心计算引擎。

本期我们邀请到了萌友科技的 CEO 何嘉斌,一位从北京服装学院走出的产品设计师,以独特的女性视角和理工科思维,打造出“桌宠”Ropet——一款不以功能取胜、却以“无用之美”打动人心的情感陪伴机器人。

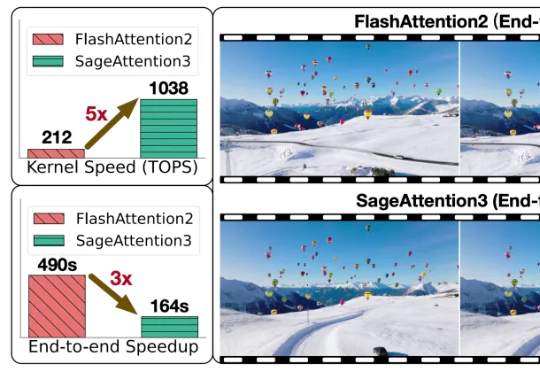

随着大型模型需要处理的序列长度不断增加,注意力运算(Attention)的时间开销逐渐成为主要开销。

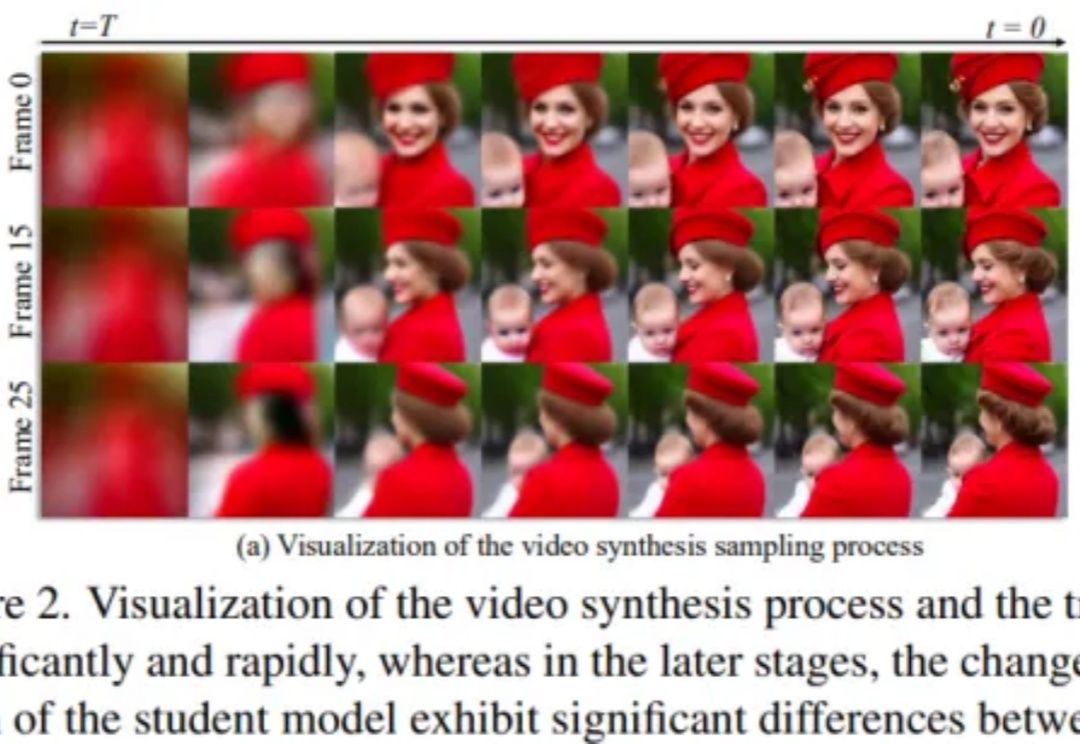

扩散模型在视频合成任务中取得了显著成果,但其依赖迭代去噪过程,带来了巨大的计算开销。尽管一致性模型(Consistency Models)在加速扩散模型方面取得了重要进展,直接将其应用于视频扩散模型却常常导致时序一致性和外观细节的明显退化。

越通用,就越World Models。 我们知道,大模型技术爆发的原点可能在谷歌一篇名为《Attention is All You Need》的论文上。

Transformer已满8岁,革命性论文《Attention Is All You Need》被引超18万次,掀起生成式AI革命。Transformer催生了ChatGPT、Gemini、Claude等诸多前沿产品。更重要的是,它让人类真正跨入了生成式AI时代。

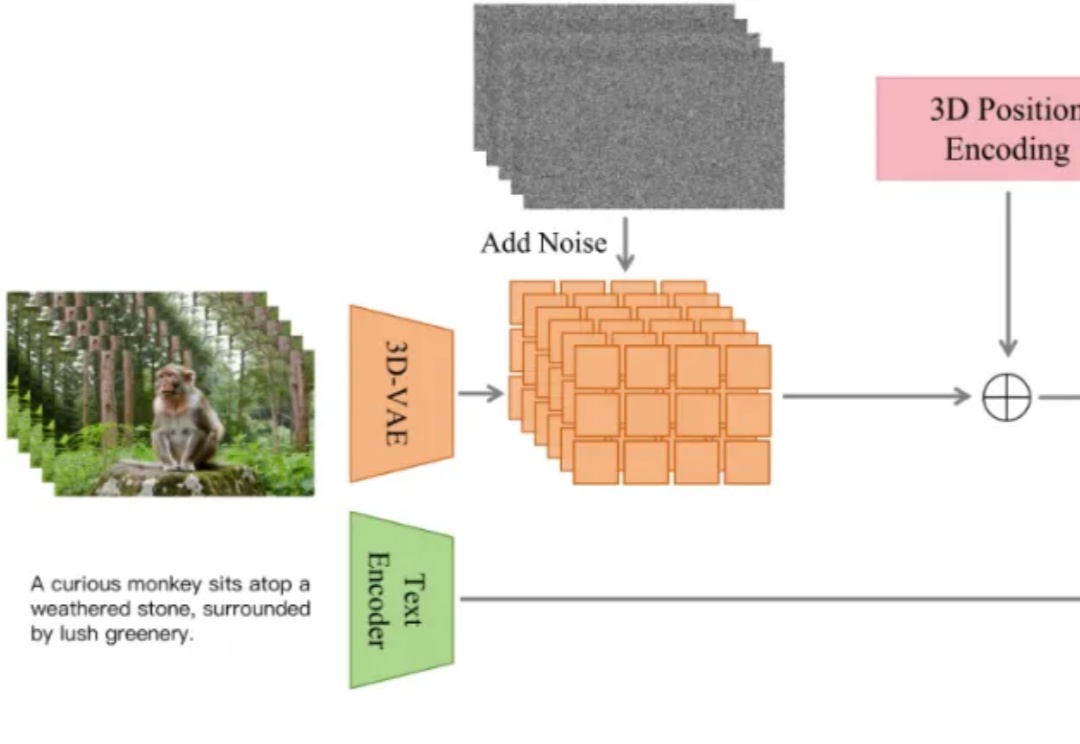

近日,抖音内容技术团队开源了 ContentV,一种面向视频生成任务的高效训练方案。该方案在多项技术优化的基础上,使用 256 块 NPU,在约 4 周内完成了一个 8B 参数模型的训练。尽管资源有限,ContentV 在多个评估维度上取得了与现有主流方案相近的生成效果。

在当今AI行业,技术的迭代速度与应用的广泛程度正在以前所未有的方式深刻改变着我们的生活。从早期的基础算法研究到如今的智能硬件应用,AI的革命已悄然展开,然而,尽管AI潜力巨大,其高昂的能耗、庞大的模型和复杂的学习机制仍是行业亟待突破的难题。在这种背景下,致力于突破AI效率瓶颈的创新型公司正引领着一股变革潮流。

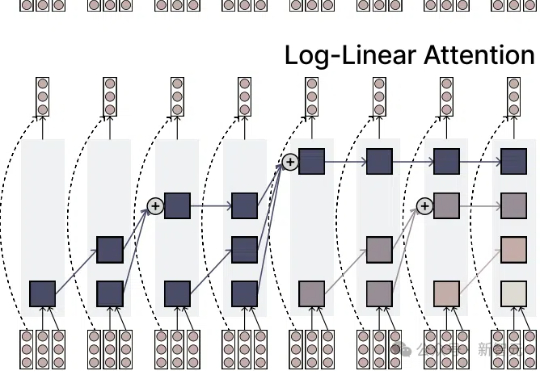

注意力机制的「平方枷锁」,再次被撬开!一招Fenwick树分段,用掩码矩阵,让注意力焕发对数级效率。更厉害的是,它无缝对接线性注意力家族,Mamba-2、DeltaNet 全员提速,跑分全面开花。长序列处理迈入log时代!