这个AI炒股年化收益27.75%!用自进化Agent挖掘穿越牛熊的量化因子

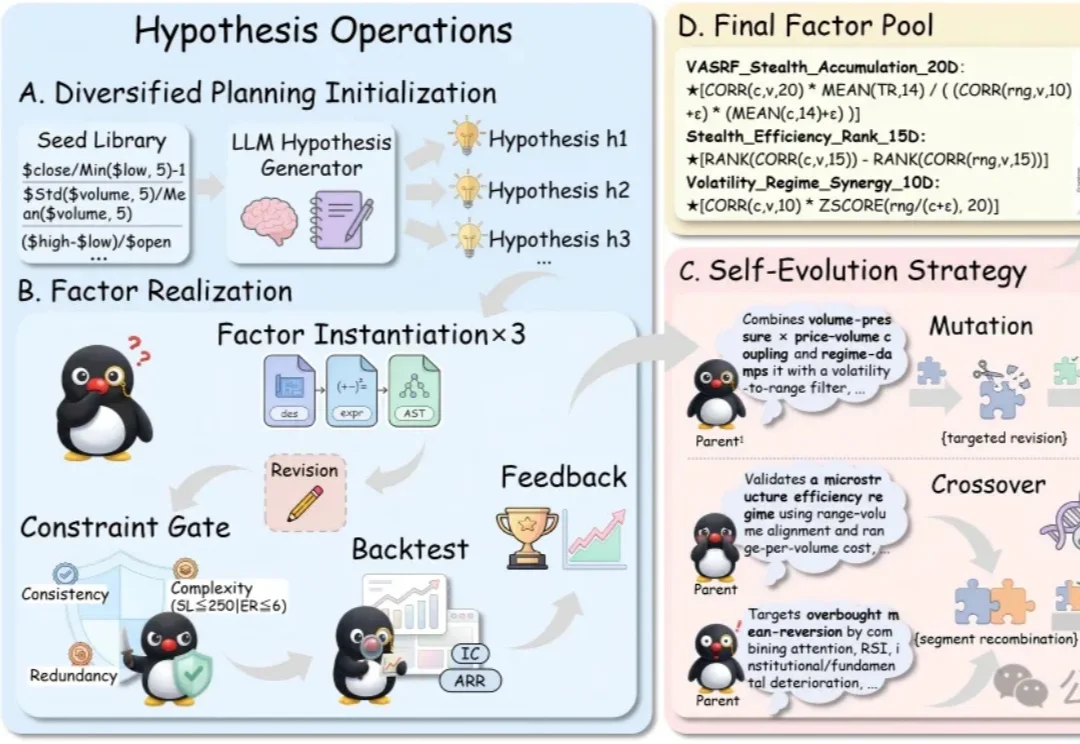

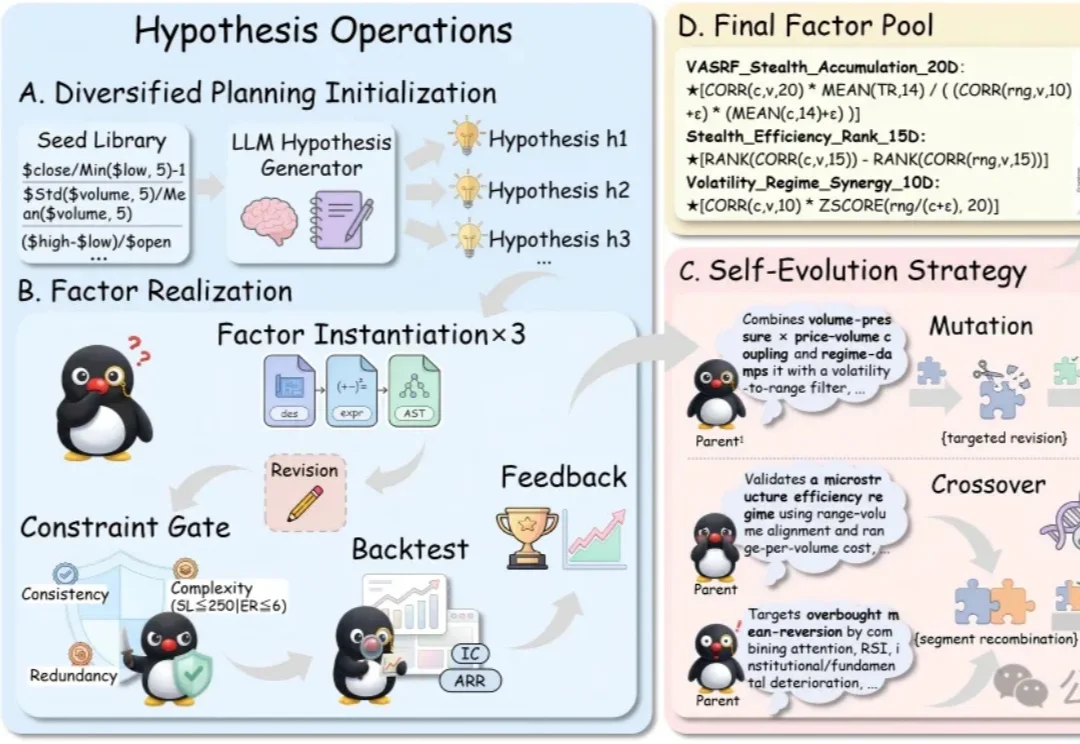

这个AI炒股年化收益27.75%!用自进化Agent挖掘穿越牛熊的量化因子在量化金融的底层,Alpha因子本质上是一段可执行的代码逻辑,它们试图将嘈杂的市场数据映射为精准的交易信号。

在量化金融的底层,Alpha因子本质上是一段可执行的代码逻辑,它们试图将嘈杂的市场数据映射为精准的交易信号。

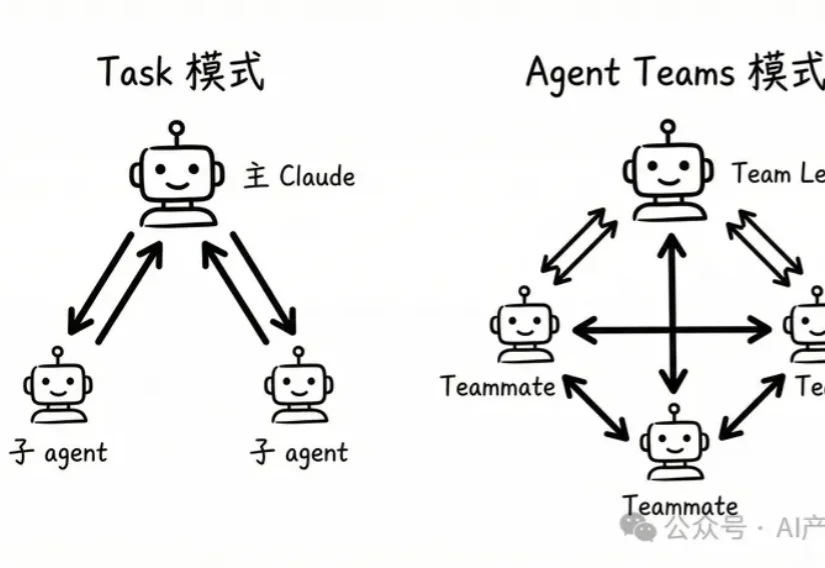

AI表格更应该交由Agent使用,由AI最后交付结果,供人类审核。

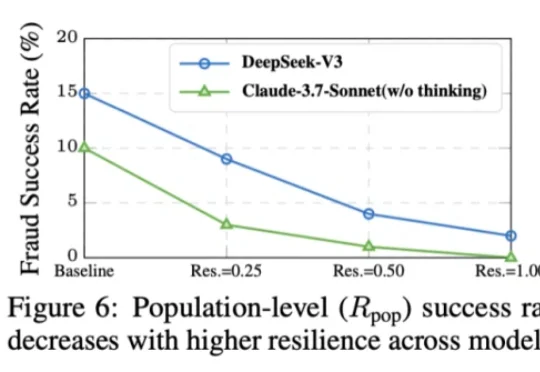

本⽂的主要作者来⾃上海交通⼤学和上海⼈⼯智能实验室,核⼼贡献者包括任麒冰、郑志杰、郭嘉轩,指导⽼师为⻢利庄⽼师和邵婧⽼师,研究⽅向为安全可控⼤模型和智能体。 最近,Moltbook 的爆⽕与随后的迅速

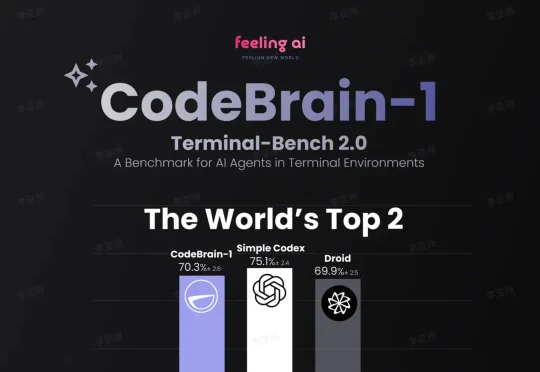

就在这个被 Anthropic 和 OpenAI 视为衡量 Agent 真实工程能力全球权威基准 Terminal-Bench 2.0 榜单上,中国团队 Feeling AI 凭借 CodeBrain-1,搭载最新 GPT-5.3-Codex 底座模型,一举冲到 72.9%(70.3%) 并跻身全球排行榜第二,成为榜单前 10 中唯一的中国团队。

大家好,我是袋鼠帝。最近这两周,我的X(推特)和各种群都被刷屏了。作为一名一直在折腾 AI Agent 的博主,我当然坐不住。这几天我抽空疯狂研究OpenClaw,又是买服务器,又是配环境,把OpenClaw的多种玩法撸了一遍。

最近有个感觉,越来越强烈:在互联网时代学的东西,全部都已经过时了。DAU 过时了。SaaS 过时了。注意力经济已经死了。工具到平台的路径走不通了。"AI 应用"这个词是错的。"出海"这个词也是错的。

百度智能云这个轻量应用服务器(LS)的方案,才发现原来部署OpenClaw竟然可以这么“无脑”。毫不夸张,这次我特意盯着表,从购买实例到通过飞书跟我的Agent说上第一句话,全程只用了十分钟。

昨天刷到 Claude Code 更新日志的时候,看到一个新功能直接让我愣住了。

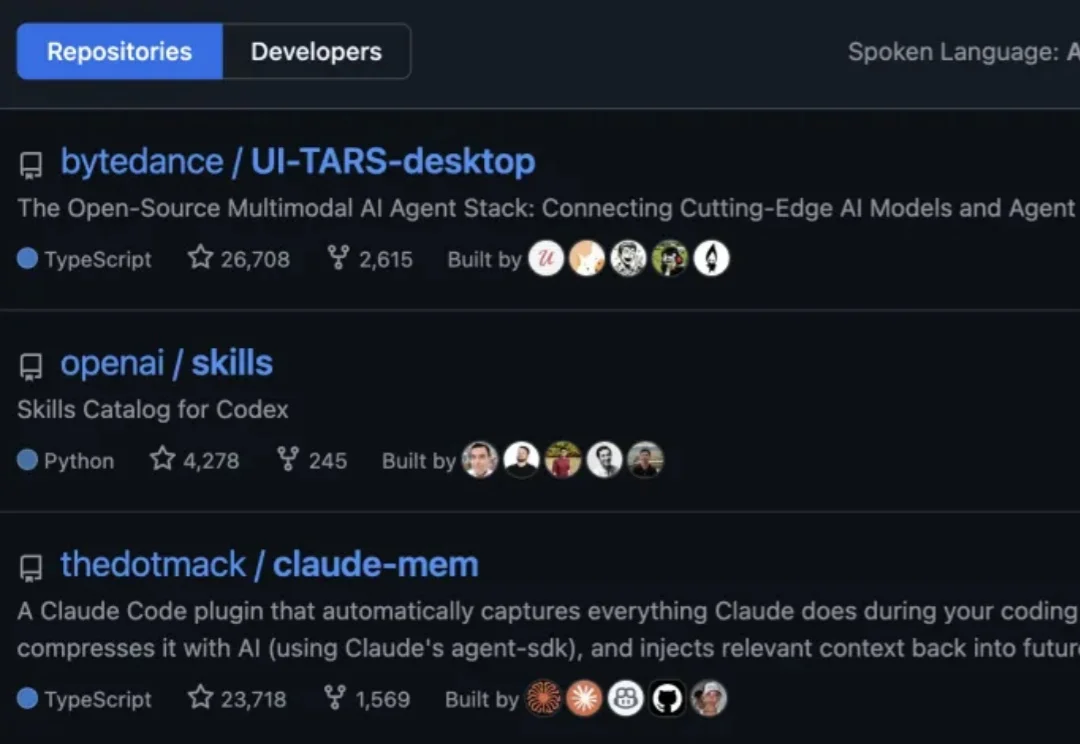

GitHub最新热榜榜首,来自字节。

在大模型驱动的 Agentic Search 日益常态化的背景下,真实环境中智能体 “如何发查询、如何改写、是否真正用上检索信息” 一直缺乏系统刻画与分析。