AI五小时发现MoE新算法,比人类算法快5倍,成本狂降26%

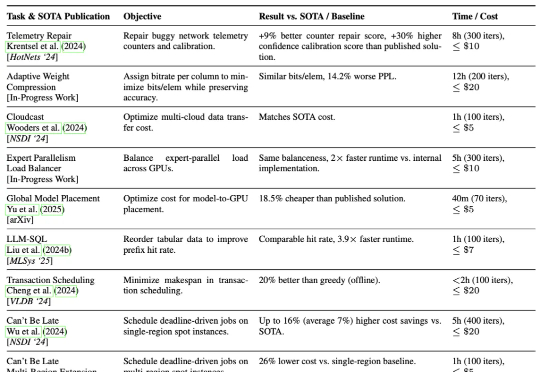

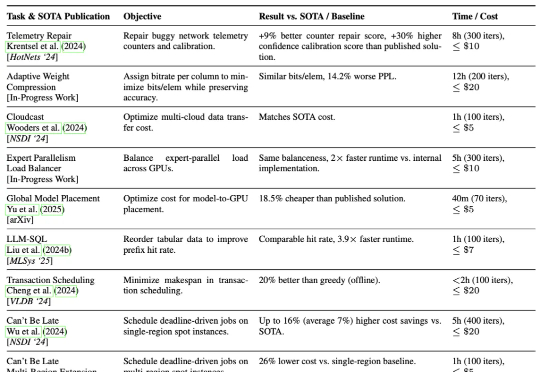

AI五小时发现MoE新算法,比人类算法快5倍,成本狂降26%加州大学伯克利分校的研究团队提出了一种AI驱动的系统研究方法ADRS(AI-Driven Research for Systems),它可以通过“生成—评估—改进”的迭代循环,实现算法的持续优化。

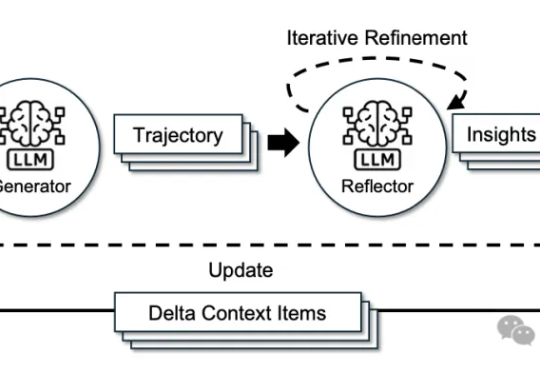

加州大学伯克利分校的研究团队提出了一种AI驱动的系统研究方法ADRS(AI-Driven Research for Systems),它可以通过“生成—评估—改进”的迭代循环,实现算法的持续优化。

加州大学伯克利分校等机构的研究人员,近日推出了一种全新的基因组语言模型GPN-Star,可以将全基因组比对和物种树信息装进大模型,在人类基因变异预测方面达到了当前最先进的水平。

![苹果盯上Prompt AI, 不是买产品,是要伯克利团队的[视觉大脑]](https://www.aitntnews.com/pictures/2025/10/15/ca7bf835-a97f-11f0-88f9-fa163e47d677.jpg)

根据外媒 CNBC 消息,苹果公司正和计算机视觉领域的初创企业 Prompt AI,推进收购事宜的 “最后阶段谈判”。

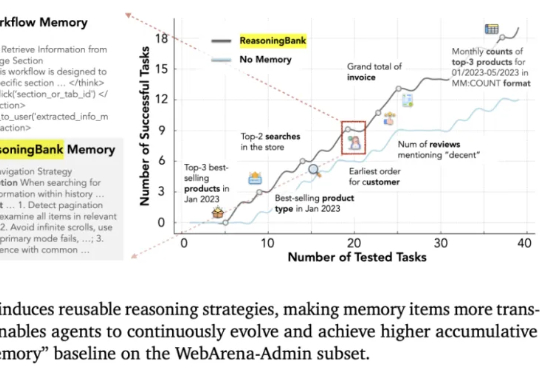

这几天,关于「微调已死」的言论吸引了学术圈的广泛关注。一篇来自斯坦福大学、SambaNova、UC 伯克利的论文提出了一种名为 Agentic Context Engineering(智能体 / 主动式上下文工程)的技术,让语言模型无需微调也能实现自我提升!

库克和马斯克都盯上的CV公司!打开Prompt AI官网,上面介绍了这家公司的定位:一家专注于消费应用视觉智能的AI公司。这家总部位于旧金山的初创公司,其核心团队非常UC伯克利范儿:

来自斯坦福大学、SambaNova Systems公司和加州大学伯克利分校的研究人员,在新论文中证明:依靠上下文工程,无需调整任何权重,模型也能不断变聪明。他们提出的方法名为智能体上下文工程ACE。

来自加州大学圣地亚哥分校(UCSD)的华人学者Wanda Hou,与加州大学伯克利分校以及Google Quantum AI合作,在谷歌的Sycamore与Willow超导量子处理器上完成了一次别开生面的实验。

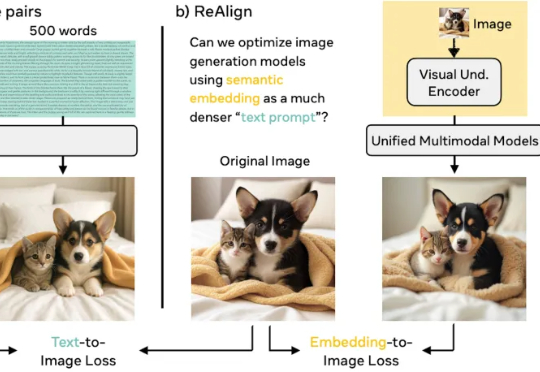

谢集,浙江大学竺可桢学院大四学生,于加州大学伯克利分校(BAIR)进行访问,研究方向为统一多模态理解生成大模型。第二作者为加州大学伯克利分校的 Trevor Darrell,第三作者为华盛顿大学的 Luke Zettlemoyer,通讯作者是 XuDong Wang, Meta GenAl Research Scientist、

本文来自加州大学圣克鲁兹分校(UCSC)、苹果公司(Apple)与加州大学伯克利分校(UCB)的合作研究。第一作者刘彦青,本科毕业于浙江大学,现为UCSC博士生,研究方向包括多模态理解、视觉-语言预训

Ditto是一个由伯克利辍学生Allen Wang和Eric Liu创立的人工智能约会平台,已筹集了160万美元,Allen Wang在4月通过Linkedin宣布,以“杀死Tinder为使命”的Ditto AI已拿到来自Google的200万美元融资。