图像伪造照妖镜!北大发布多模态LLM图像篡改检测定位框架FakeShield

图像伪造照妖镜!北大发布多模态LLM图像篡改检测定位框架FakeShield北京大学的研究人员开发了一种新型多模态框架FakeShield,能够检测图像伪造、定位篡改区域,并提供基于像素和图像语义错误的合理解释,可以提高图像伪造检测的可解释性和泛化能力。

北京大学的研究人员开发了一种新型多模态框架FakeShield,能够检测图像伪造、定位篡改区域,并提供基于像素和图像语义错误的合理解释,可以提高图像伪造检测的可解释性和泛化能力。

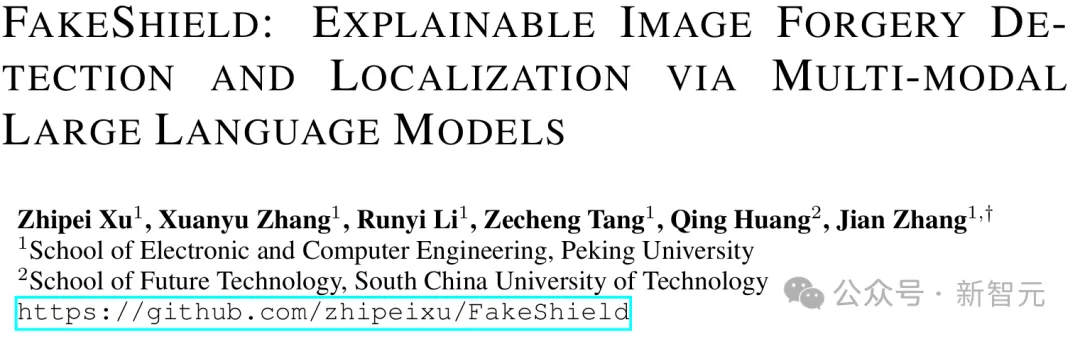

大模型分不清“9.9和9.11哪个更大”的谜团,终于被可解释性研究揭秘了!

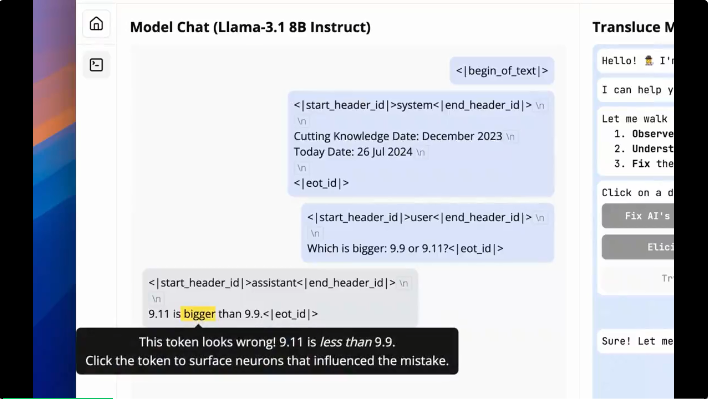

在当今人工智能(AI)和机器学习(ML)技术迅猛发展的背景下,解释性AI(Explainable AI, XAI)已成为一个备受关注的话题。

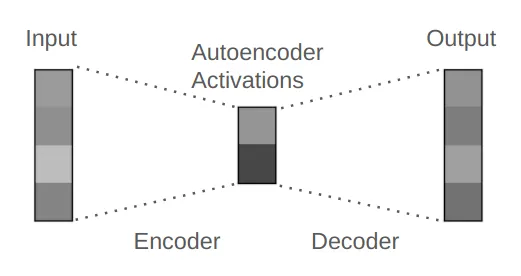

Goodfire于2024年在旧金山成立,研发用于提高生成式AI模型内部运作可观察性的开发工具,希望提高AI系统的透明度和可靠性,帮助开发者更好地理解和控制AI模型。

神经网络是一种灵活且强大的函数近似方法。而许多应用都需要学习一个相对于某种对称性不变或等变的函数。图像识别便是一个典型示例 —— 当图像发生平移时,情况不会发生变化。等变神经网络(equivariant neural network)可为学习这些不变或等变函数提供一个灵活的框架。

随着人工智能技术的广泛应用,人们认为AI可以避免人类常见的认知偏差。然而,AI本身可能会表现出类似于人类的偏差,例如锚定效应。本文通过回顾“系统1”和“系统2”两个思维模式,探讨AI在这两种模式中的运作方式,分析AI产生认知偏差的原因,并通过具体实验展示AI在面对锚定效应时的表现。本文进一步探讨如何在理解这些局限性的基础上,合理利用AI来改善人类决策质量,并强调AI透明性和可解释性的重要性。

让模型具有更加广泛和通用的认知能力,是当前人工智能(AI)领域发展的重要目标。目前流行的大模型路径是基于 Scaling Law (尺度定律) 去构建更大、更深和更宽的神经网络提升模型的表现,可称之为 “基于外生复杂性” 的通用智能实现方法。然而,这一路径也面临着一些难以克服的困境,例如高昂的计算资源消耗和能源消耗,并且在可解释性方面存在不足。

在软件开发的世界里,代码的生成、编辑、测试和调试一直是核心活动。

简而言之:矩阵 → ReLU 激活 → 矩阵

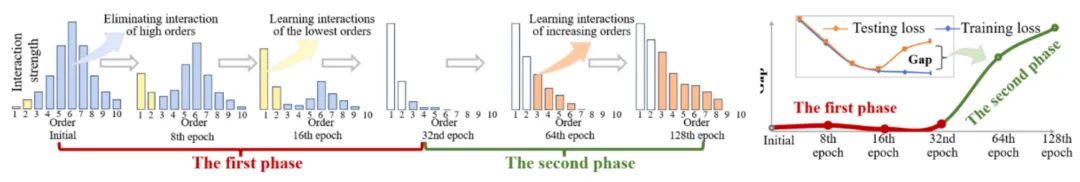

本文首先简单回顾了『等效交互可解释性理论体系』(20 篇 CCF-A 及 ICLR 论文),并在此基础上,严格推导并预测出神经网络在训练过程中其概念表征及其泛化性的动力学变化,即在某种程度上,我们可以解释在训练过程中神经网络在任意时间点的泛化性及其内在根因。