深度|OpenAI产品经理及后训练负责人:决定模型真正聪明程度的不是智能水平,而是它理解你的方式

深度|OpenAI产品经理及后训练负责人:决定模型真正聪明程度的不是智能水平,而是它理解你的方式我们进入了一个模型不再只是“工具”的时代。真正的突破,不在于它能做多少事,而在于它是否能读懂你的意图、情绪与沉默。

我们进入了一个模型不再只是“工具”的时代。真正的突破,不在于它能做多少事,而在于它是否能读懂你的意图、情绪与沉默。

当大模型竞争转向后训练,继续为闲置显卡烧钱无异于「慢性自杀」。如今,按Token计费的Serverless模式,彻底终结了算力租赁的暴利时代,让算法工程师真正拥有了定义物理世界的权利。

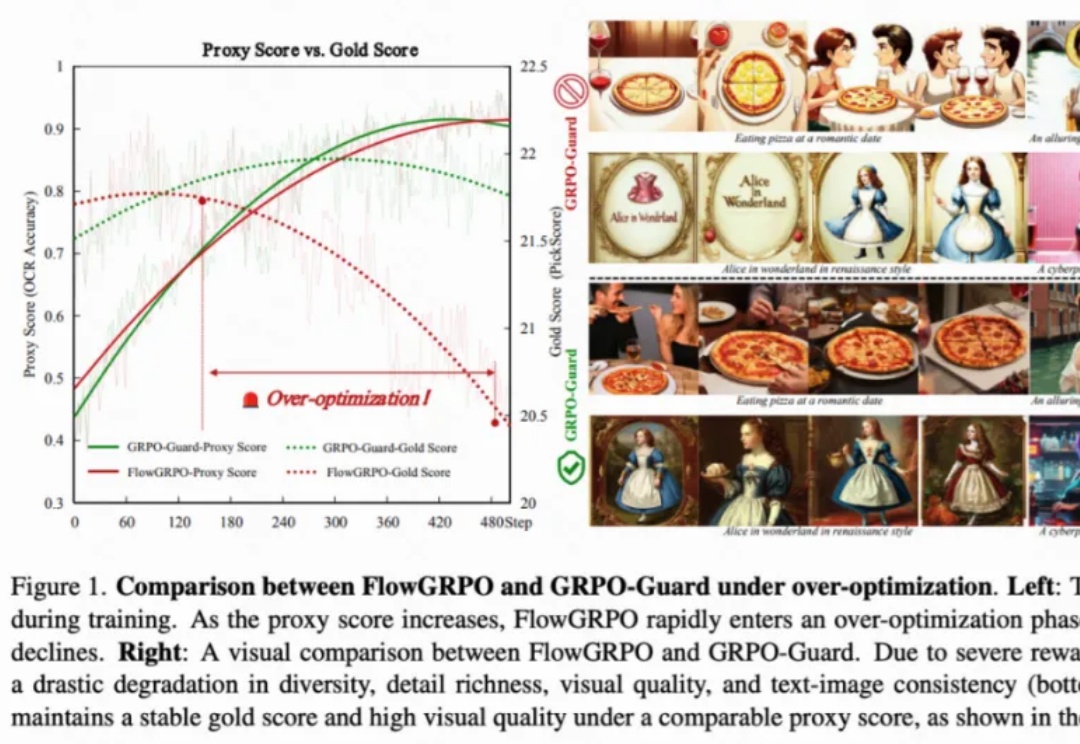

直到刚刚,用最新的图像模型NextStep-1.1,扳回一球。总体来看,这次开源的NextStep-1.1解决了之前NextStep-1中出现的可视化失败(visualization failures )问题。其通过扩展训练和基于流的强化学习(RL)后训练范式,大幅提升了图像质量。

最近,清华大学教授、智谱AI首席科学家唐杰发了一条长微博,总结了自己2025年对大模型进展的感悟。从预训练到中后训练、长尾场景的对齐能力,再到Agent、多模态和具身智能的发展,其中有不少亮点。

2025年底,最令人印象深刻的AI圈大事莫过于Gemini 3 Flash的发布。

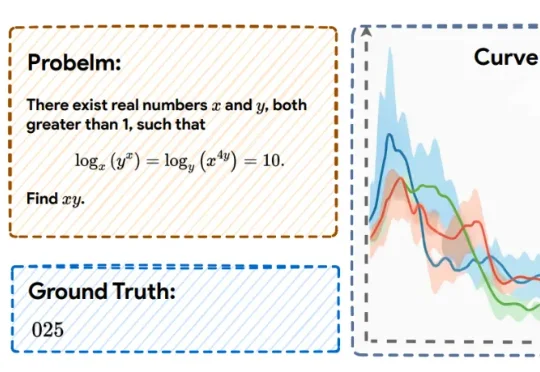

近日,上海人工智能实验室的研究团队提出了一种全新的后训练范式——RePro(Rectifying Process-level Reward)。这篇论文将推理的过程视为模型内部状态的优化过程,从而对如何重塑大模型的CoT提供了一个全新视角:

VLA模型性能暴涨300%,背后训练数据还首次实现90%由世界模型生成。

中国最早进行医疗大模型后训练的创新企业之一 ——杭州全诊医学科技有限公司(以下简称“全诊医学”)正式宣布完成1亿元B轮融资:2024年4季度由A股上市公司“创新医疗”(SZ.002173)完成战略轮投资;2025年2季度由中国医药工业百强“好医生集团”完成B轮投资,探针资本担任本轮融资的独家财务顾问。

目前,GRPO 在图像和视频生成的流模型中取得了显著提升(如 FlowGRPO 和 DanceGRPO),已被证明在后训练阶段能够有效提升视觉生成式流模型的人类偏好对齐、文本渲染与指令遵循能力。

今年三月,Liam Fedus 在推特上宣布离开 OpenAI。这条推文的影响力超出了所有人的预期——硅谷的风投们几乎是立刻行动起来,争相联系这位 ChatGPT 最初小团队的核心成员、曾领导 OpenAI 关键的后训练部门的研究者,他的离职甚至一度引发了一场“反向竞标”。