一文看尽Meta开源大礼包!全面覆盖图像分割、语音、文本、表征、材料发现、密码安全性等

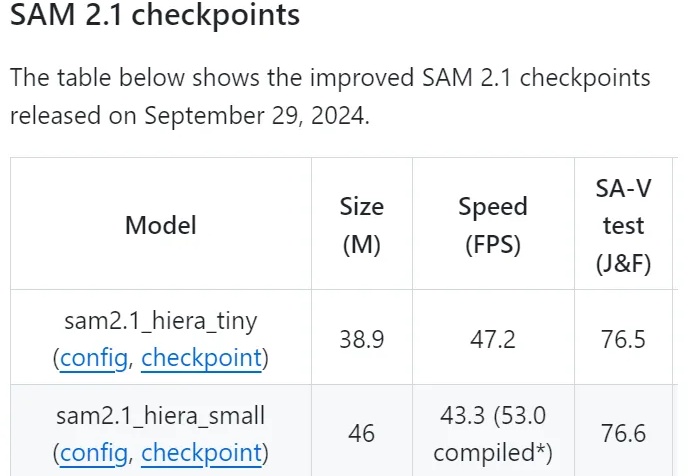

一文看尽Meta开源大礼包!全面覆盖图像分割、语音、文本、表征、材料发现、密码安全性等Meta最近开源了多个AI项目,包括图像分割模型SAM 2.1、多模态语言模型Spirit LM、自学评估器和改进的跨语言句子编码器Mexma等,提升了AI在图像处理和语音识别领域的能力,进一步推动了AI研究的进展。

Meta最近开源了多个AI项目,包括图像分割模型SAM 2.1、多模态语言模型Spirit LM、自学评估器和改进的跨语言句子编码器Mexma等,提升了AI在图像处理和语音识别领域的能力,进一步推动了AI研究的进展。

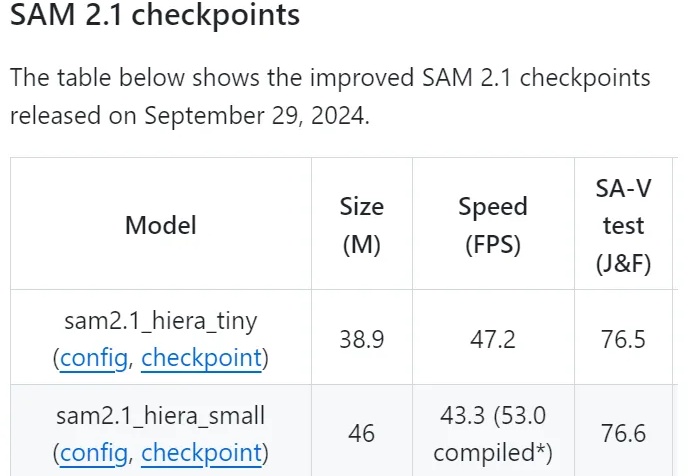

在当今多模态领域,CLIP 模型凭借其卓越的视觉与文本对齐能力,推动了视觉基础模型的发展。CLIP 通过对大规模图文对的对比学习,将视觉与语言信号嵌入到同一特征空间中,受到了广泛应用。

不知道从何时起,脑海里就有着阶跃星辰的多模态能力遥遥领先的印象。 无论去哪旅游,以前是用谷歌地图,现在基本都用「跃问」,看到长得奇特的建筑就拍来问问,还能跟 AI Chat 一下历史。 这不,最近来新加坡出差了,顺便旅旅游,就又用上了「跃问」。

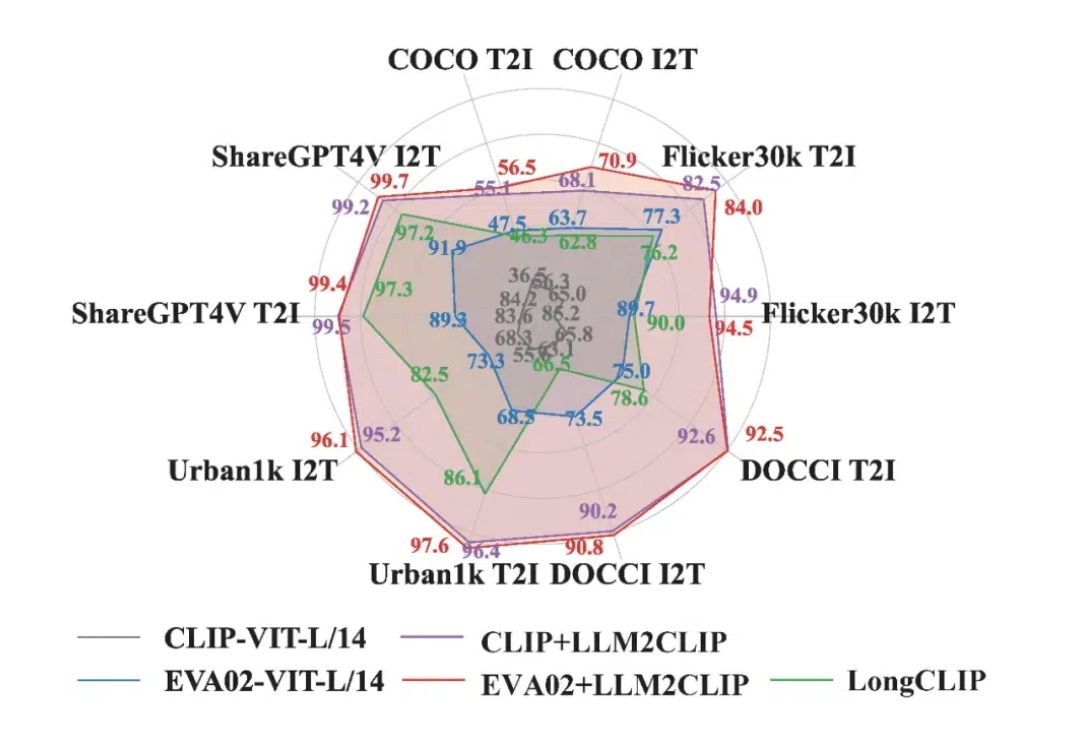

该项目由忆生科技联合香港大学、上海科技大学共同完成,是全球首个同时支持文本描述、图像、点云等多模态输入的计算机辅助设计(CAD)生成大模型。

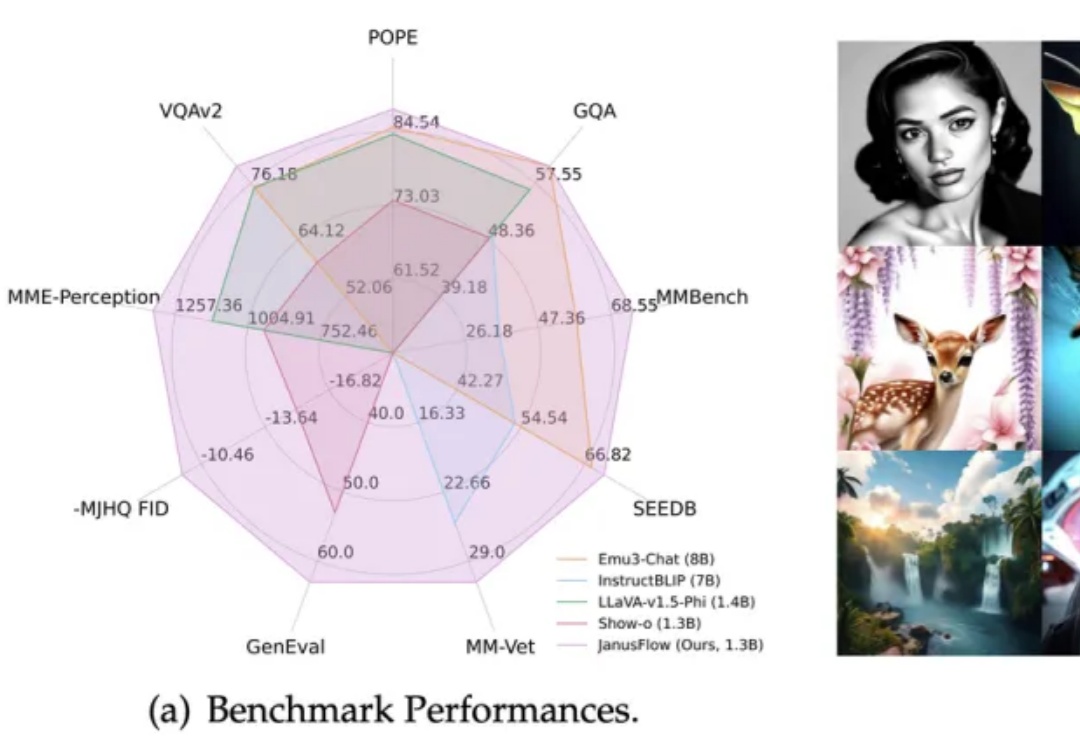

在多模态AI领域,基于预训练视觉编码器与MLLM的方法(如LLaVA系列)在视觉理解任务上展现出卓越性能。

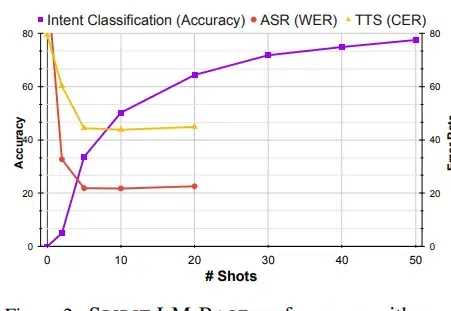

Meta最近开源了一个7B尺寸的Spirit LM的多模态语言模型,能够理解和生成语音及文本,可以非常自然地在两种模式间转换,不仅能处理基本的语音转文本和文本转语音任务,还能捕捉和再现语音中的情感和风格。

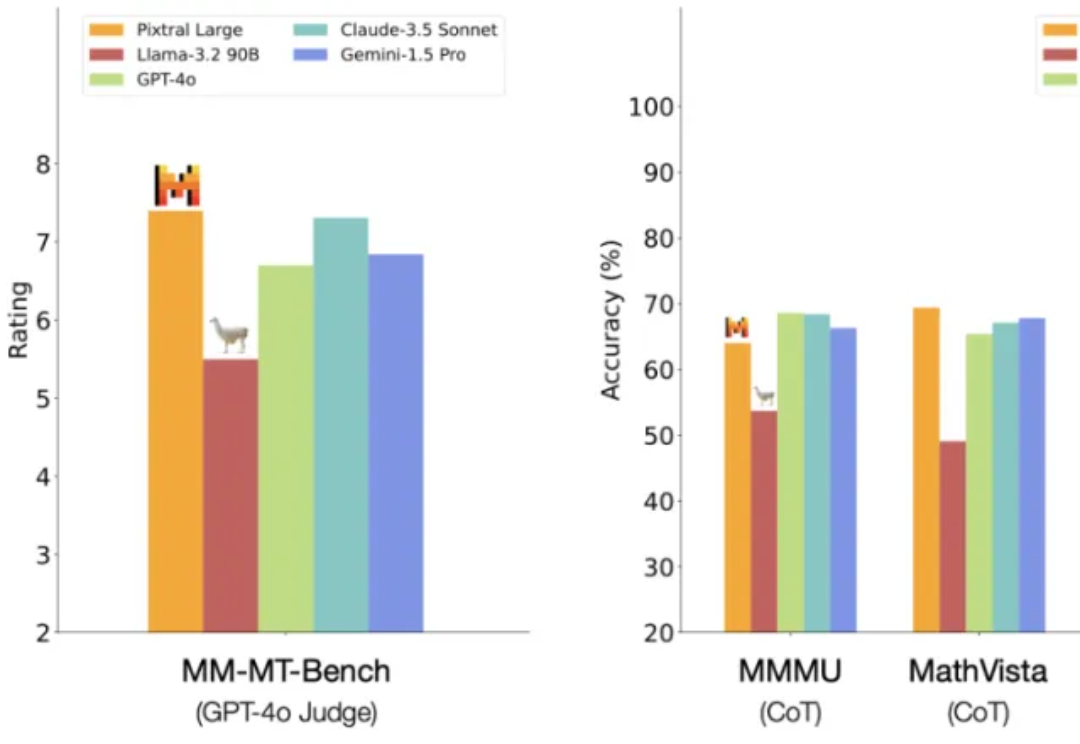

一觉醒来,Mistral AI 又发力了。 就在今天,Mistral AI 多模态家族迎来了第二位成员:一个名为 Pixtral Large 的超大杯基础模型。

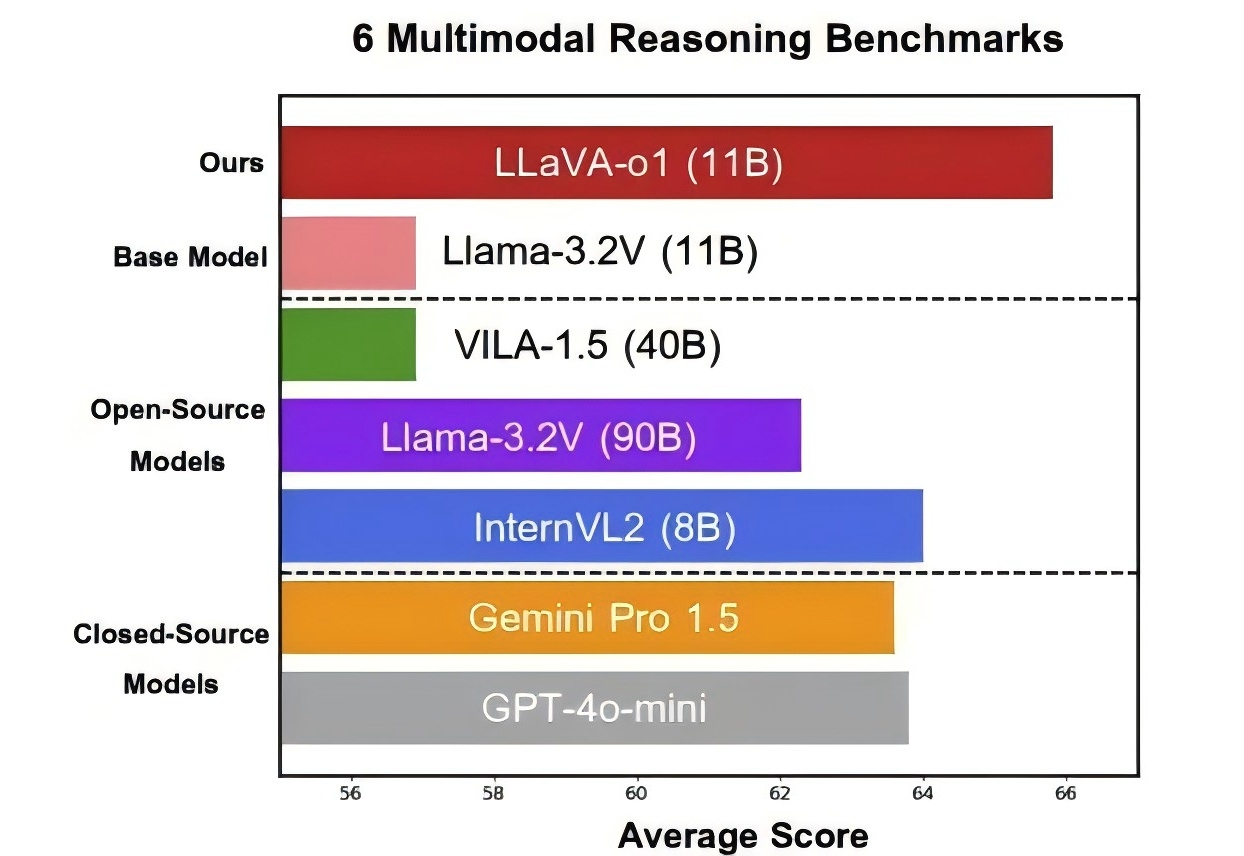

北大等出品,首个多模态版o1开源模型来了—— 代号LLaVA-o1,基于Llama-3.2-Vision模型打造,超越传统思维链提示,实现自主“慢思考”推理。 在多模态推理基准测试中,LLaVA-o1超越其基础模型8.9%,并在性能上超越了一众开闭源模型。

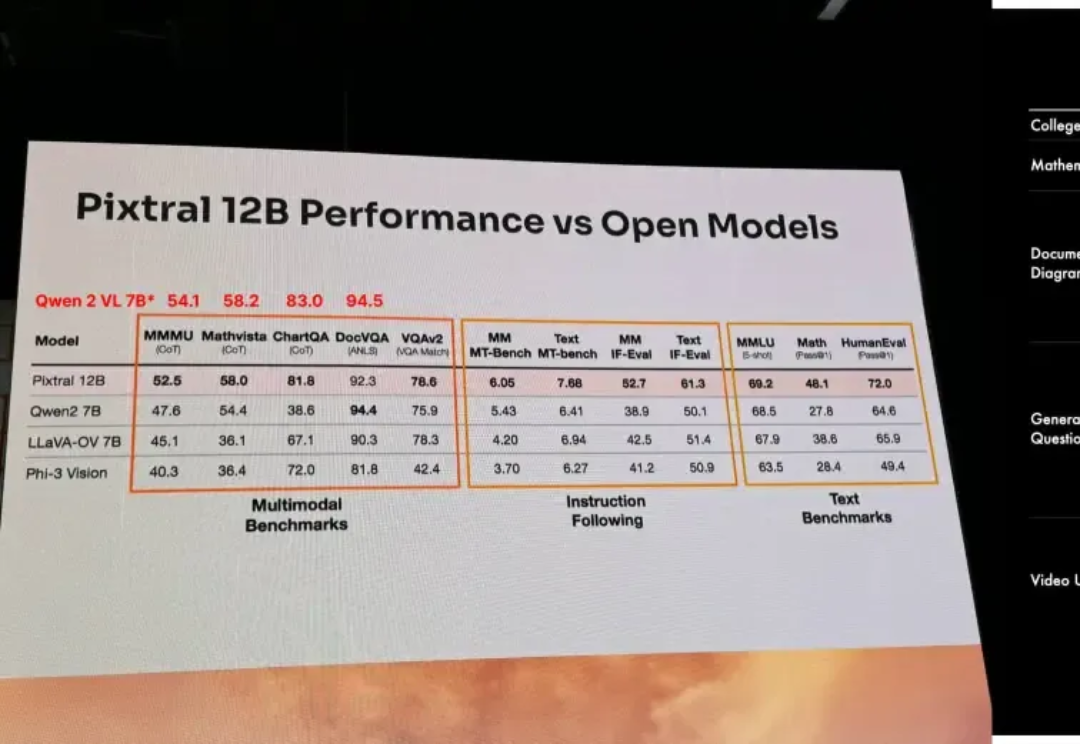

以开源极客之姿杀入江湖的Mistral AI,在9月份甩出了自家的首款多模态大模型Pixtral 12B,如今,报告之期已至,技术细节全公开。

在闭着眼睛听一首歌的时候,你有没有在脑海里想象过,应该搭配什么画面? Kimi 内测的最新功能「创作音乐视频」,就是奔着当 MV 导演去的。长文本领先的 Kimi,默不作声地「跨界」了。APPSO 也受邀首批体验了这一新功能。