讯飞版《Her》长脸了!多模态虚拟人表情动作超逼真,一张图一句话就能DIY自己

讯飞版《Her》长脸了!多模态虚拟人表情动作超逼真,一张图一句话就能DIY自己跟讯飞星火AI女神视频面对面,国产《Her》从此有了脸!

跟讯飞星火AI女神视频面对面,国产《Her》从此有了脸!

两位清华校友,在OpenAI发布最新研究—— 生成图像,但速度是扩散模型的50倍。 路橙、宋飏再次简化了一致性模型,仅用两步采样,就能使生成质量与扩散模型相媲美。

我们提出了 Janus,一种基于自回归的多模态理解与生成统一模型。

OpenAI前首席科学家、联合创始人Ilya Sutskever曾在多个场合表达观点: 只要能够非常好的预测下一个token,就能帮助人类达到通用人工智能(AGI)。

视频多模态大模型(LMMs)的发展受限于从网络获取大量高质量视频数据。为解决这一问题,我们提出了一种替代方法,创建一个专为视频指令跟随任务设计的高质量合成数据集,名为 LLaVA-Video-178K。

OpenAI 前首席科学家、联合创始人 Ilya Sutskever 曾在多个场合表达观点:只要能够非常好的预测下一个 token,就能帮助人类达到通用人工智能(AGI)。

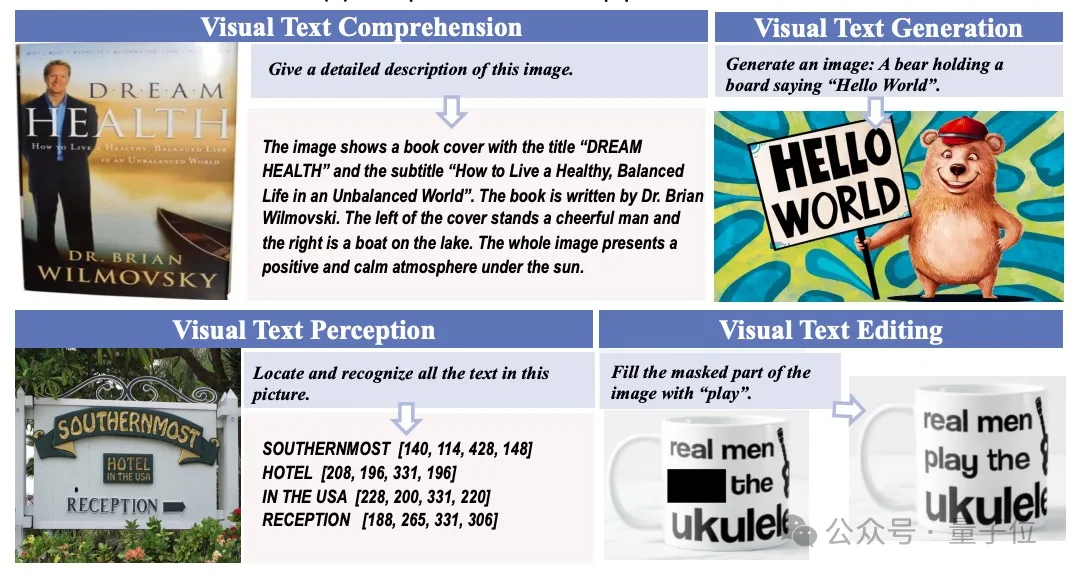

多模态生成新突破,字节&华师团队打造TextHarmony,在单一模型架构中实现模态生成的统一,并入选NeurIPS 2024。

大语言模型(LLM)正在推动通信行业向智能化转型,在自动生成网络配置、优化网络管理和预测网络流量等方面展现出巨大潜力。未来,LLM在电信领域的应用将需要克服数据集构建、模型部署和提示工程等挑战,并探索多模态集成、增强机器学习算法和经济高效的模型压缩技术。

说起阶跃星辰,可以说是 AI 六小强中最低调的一个,但最近这家公司在 AI 圈里频频“闹出动静”。

Robin3D通过鲁棒指令数据生成引擎(RIG)生成的大规模数据进行训练,以提高模型在3D场景理解中的鲁棒性和泛化能力,在多个3D多模态学习基准测试中取得了优异的性能,超越了以往的方法,且无需针对特定任务的微调。