被谷歌点名感谢!杭州六小龙开源黑科技,让机器人瞬间「悟透」3D世界

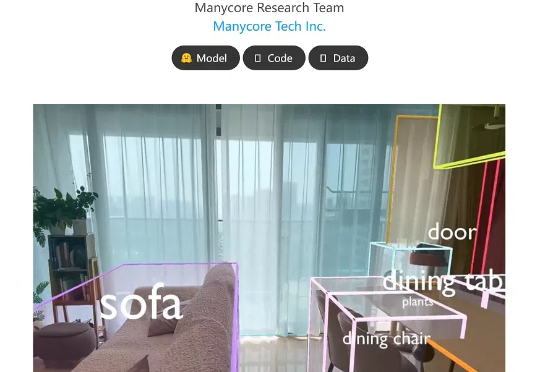

被谷歌点名感谢!杭州六小龙开源黑科技,让机器人瞬间「悟透」3D世界前脚被谷歌点名感谢空间训练平台,后脚又开源了空间模型!杭州六小龙群核科技发了一个空间理解开源模型SpatialLM,让机器人刷一段视频,就能理解物理世界的几何关系。结合之前发布的空间智能训练平台SpatialVerse,群核科技要为机器人提供从空间认知到行动交互的训练闭环。机器人也被「卷」到要上学了。

前脚被谷歌点名感谢空间训练平台,后脚又开源了空间模型!杭州六小龙群核科技发了一个空间理解开源模型SpatialLM,让机器人刷一段视频,就能理解物理世界的几何关系。结合之前发布的空间智能训练平台SpatialVerse,群核科技要为机器人提供从空间认知到行动交互的训练闭环。机器人也被「卷」到要上学了。

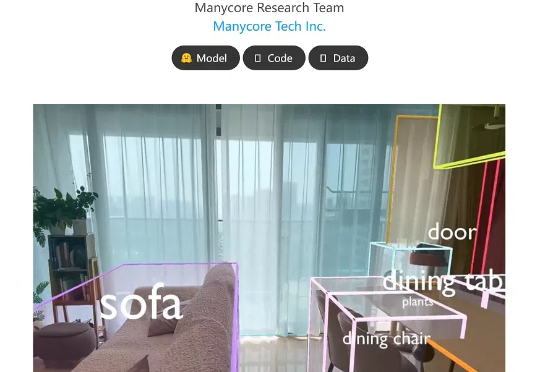

多模态,性能超 GPT-4o Mini、Gemma 3,还能在单个 RTX 4090 上运行,这个小模型值得一试。

在你看来,开源是一种怎么样的存在? 纯慈善?活菩萨?理想主义者?

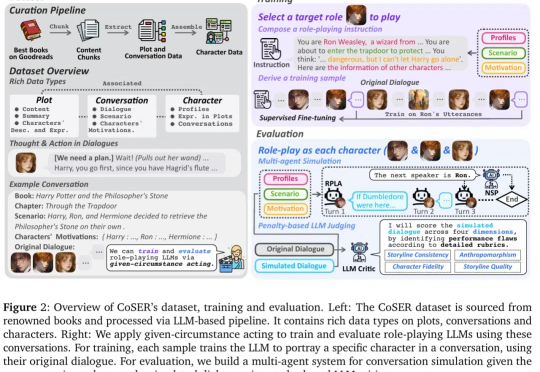

角色扮演 AI(Role-Playing Language Agents,RPLAs)作为大语言模型(LLM)的重要应用,近年来获得了广泛关注。

就在刚刚,谷歌Gemma 3来了,1B、4B、12B和27B四种参数,一块GPU/TPU就能跑!而Gemma 3仅以27B就击败了DeepSeek 671B模型,成为仅次于DeepSeek R1最优开源模型。

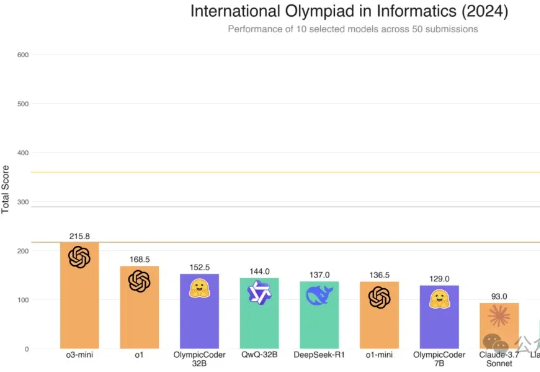

Hugging Face的Open R1重磅升级,7B击败Claude 3.7 Sonnet等一众前沿模型。凭借CodeForces-CoTs数据集的10万高质量样本、IOI难题的严苛测试,以及模拟真实竞赛的提交策略优化,这款模型展现了惊艳的性能。

HuggingFace热门榜单几乎被中国模型“承包”了!

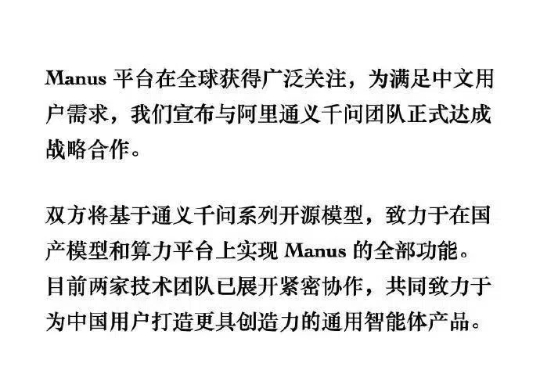

2025年3月11日,AI智能体领域迎来惊天反转:Manus团队宣布与阿里通义千问达成战略合作,双方将基于国产开源模型重构Manus全部功能。这一决策直接回应了3月5日产品发布后遭遇的“破解危机”——因过度依赖Claude Sonnet模型,Manus被质疑为“工具集成商”,甚至开源社区迅速推出复刻版OpenManus。

AI21Labs 近日发布了其最新的 Jamba1.6系列大型语言模型,这款模型被称为当前市场上最强大、最高效的长文本处理模型。与传统的 Transformer 模型相比,Jamba 模型在处理长上下文时展现出了更高的速度和质量,其推理速度比同类模型快了2.5倍,标志着一种新的技术突破。

仅用32B,就击败o1-mini追平671B满血版DeepSeek-R1!阿里深夜重磅发布的QwQ-32B,再次让全球开发者陷入狂欢:消费级显卡就能跑,还一下子干到推理模型天花板!