谁才是最强的?清华给海内外知名大模型做了场综合能力评测

谁才是最强的?清华给海内外知名大模型做了场综合能力评测在 2023 年的 “百模大战” 中,众多实践者推出了各类模型,这些模型有的是原创的,有的是针对开源模型进行微调的;有些是通用的,有些则是行业特定的。如何能合理地评价这些模型的能力,成为关键问题。

在 2023 年的 “百模大战” 中,众多实践者推出了各类模型,这些模型有的是原创的,有的是针对开源模型进行微调的;有些是通用的,有些则是行业特定的。如何能合理地评价这些模型的能力,成为关键问题。

早前Meta的LLaMA大模型“意外”泄露后,大模型的开源与闭源之争就此提上了日程。大模型到底是开源好、还是闭源好?过去一年整个AI业界可谓是争吵不休。如今,又有一位重量级人士站出来表态了。

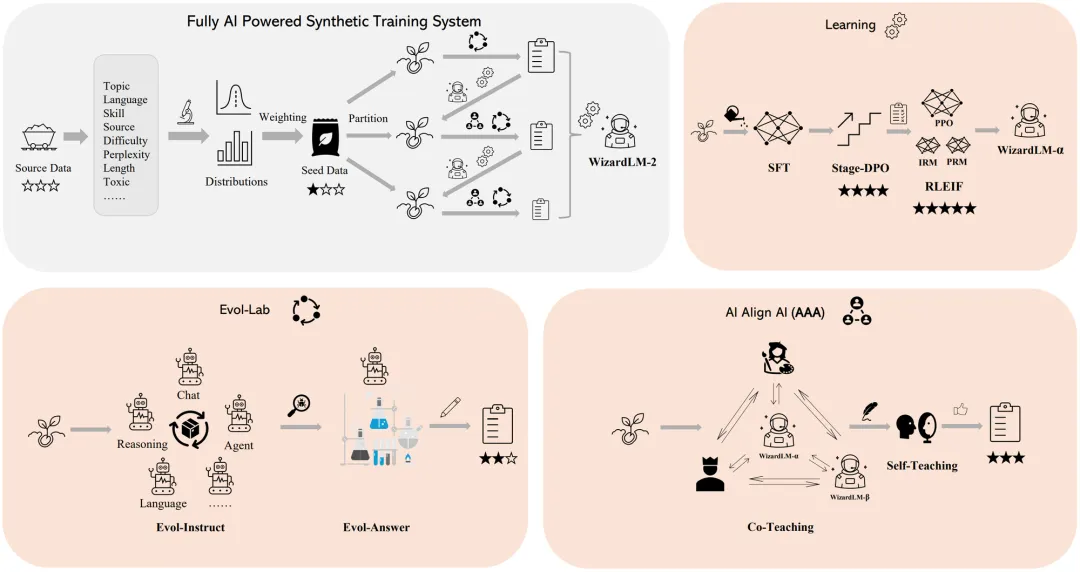

Microsoft 在今天推出了 WizardLM 2,这是一个突破性的开源大语言模型,可以说是开源领域的突破,甚至接近和超过部分 GPT-4 的能力,这在之前的开源领域是前所未有的。

李彦宏对大模型开源与闭源的路线选择以及AI创业者应该专注模型还是应用等业界焦点话题,发表了自己的看法

对代码大模型而言,比能做编程题更重要的,是看是能不能适用于企业级项目开发,是看在实际软件开发场景中用得顺不顺手、成本高不高、能否精准契合业务需求,后者才是开发者关心的硬实力。

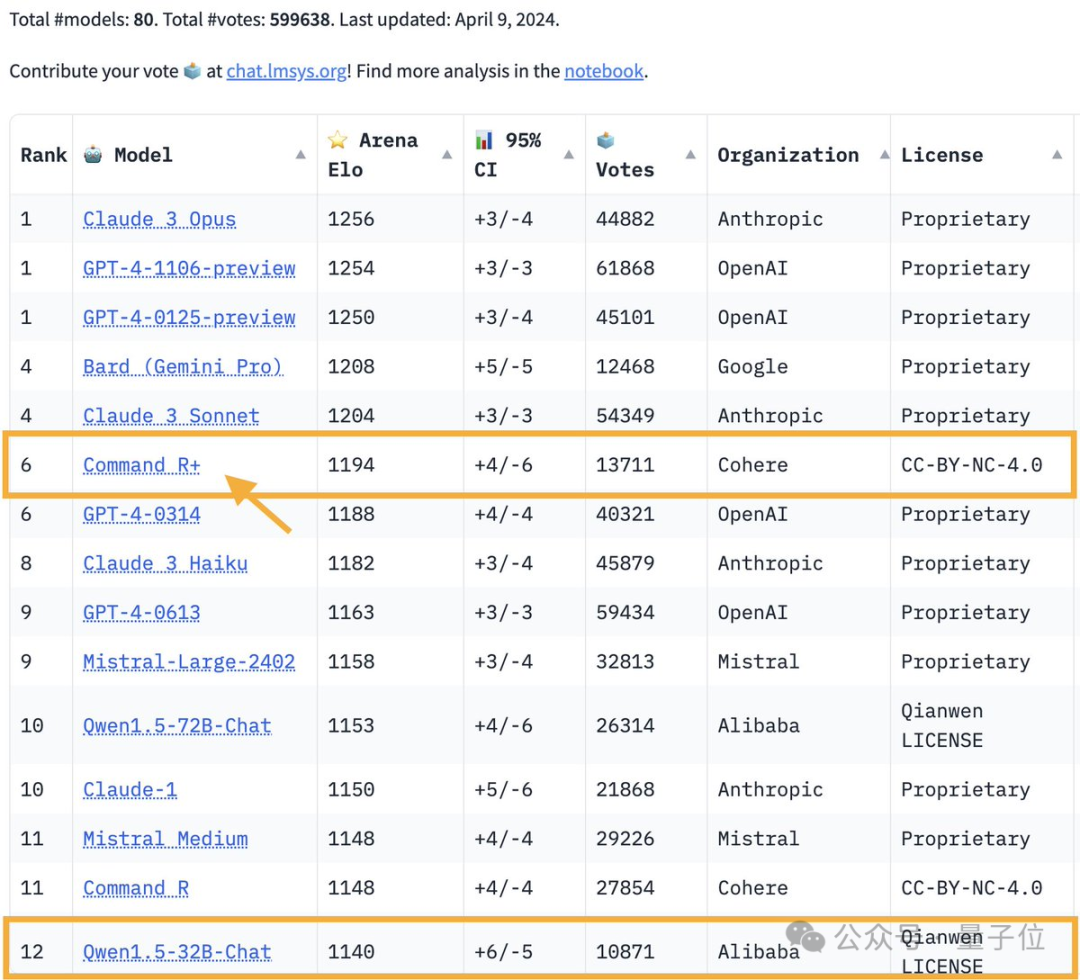

能打得过GPT-4的开源模型出现了!

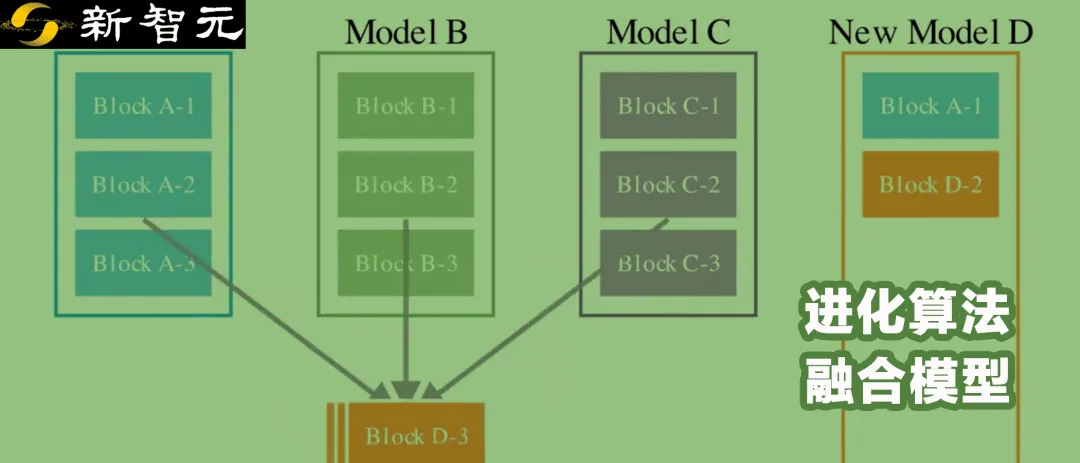

自动将不同开源模型进行组合,生成具有新能力的新模型,Sakana AI开发的新方法做到了!

来自UC berkeley的研究人员开源了首个世界模型,多模态性能优秀,长视频理解吊打GPT-4,同时将上下文长度增加到百万级别

自从Grok-1公开发布后,越来越多的人坐不住了。比如这家成立了11年的数据公司Databricks,他们就在Grok-1公开后的一个多礼拜,发布了自己的大模型DBRX。

【新智元导读】大模型落地并不缺场景,却往往因算力不够遇难题。这家国产平台从今日起,免费送百万token。开发者们不仅可以对20多种开源模型精调,还能用上极具性价比的多元算力。