开源15T tokens!HuggingFace放出规模最大、质量最高预训练数据集

开源15T tokens!HuggingFace放出规模最大、质量最高预训练数据集Meta最近开源的Llama 3模型再次证明了「数据」是提升性能的关键,但现状是,开源的大模型有一堆,可开源的大规模数据却没多少,而收集、清洗数据又是一项极其费时费力的工作,也导致了大模型预训练技术仍然掌握在少数高端机构的手中。

Meta最近开源的Llama 3模型再次证明了「数据」是提升性能的关键,但现状是,开源的大模型有一堆,可开源的大规模数据却没多少,而收集、清洗数据又是一项极其费时费力的工作,也导致了大模型预训练技术仍然掌握在少数高端机构的手中。

Llama 3的开源,再次掀起了一场大模型的热战,各家争相测评、对比模型的能力,也有团队在进行微调,开发衍生模型。

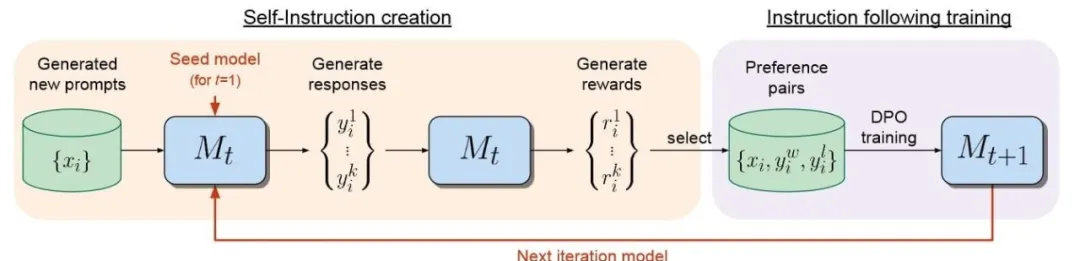

在大语言模型领域,微调是改进模型的重要步骤。伴随开源模型数量日益增多,针对LLM的微调方法同样在推陈出新。

一款开源模型火不火,看生态中的产品对他的支持有多快就知道了。

就在刚刚,拥有128位专家和4800亿参数的Arctic,成功登上了迄今最大开源MoE模型的宝座。

Snowflake 发布高「企业智能」模型 Arctic,专注于企业内部应用。

李彦宏说开源模型将越来越落后,然后Llama 3发布了。

上周,微软空降了一个堪称GPT-4级别的开源模型WizardLM-2。 却没想到发布几小时之后,立马被删除了。

如果你手头有一个价值100亿美元的AI模型,通过了安全测试且让所有人受益,你愿意将它开源吗?

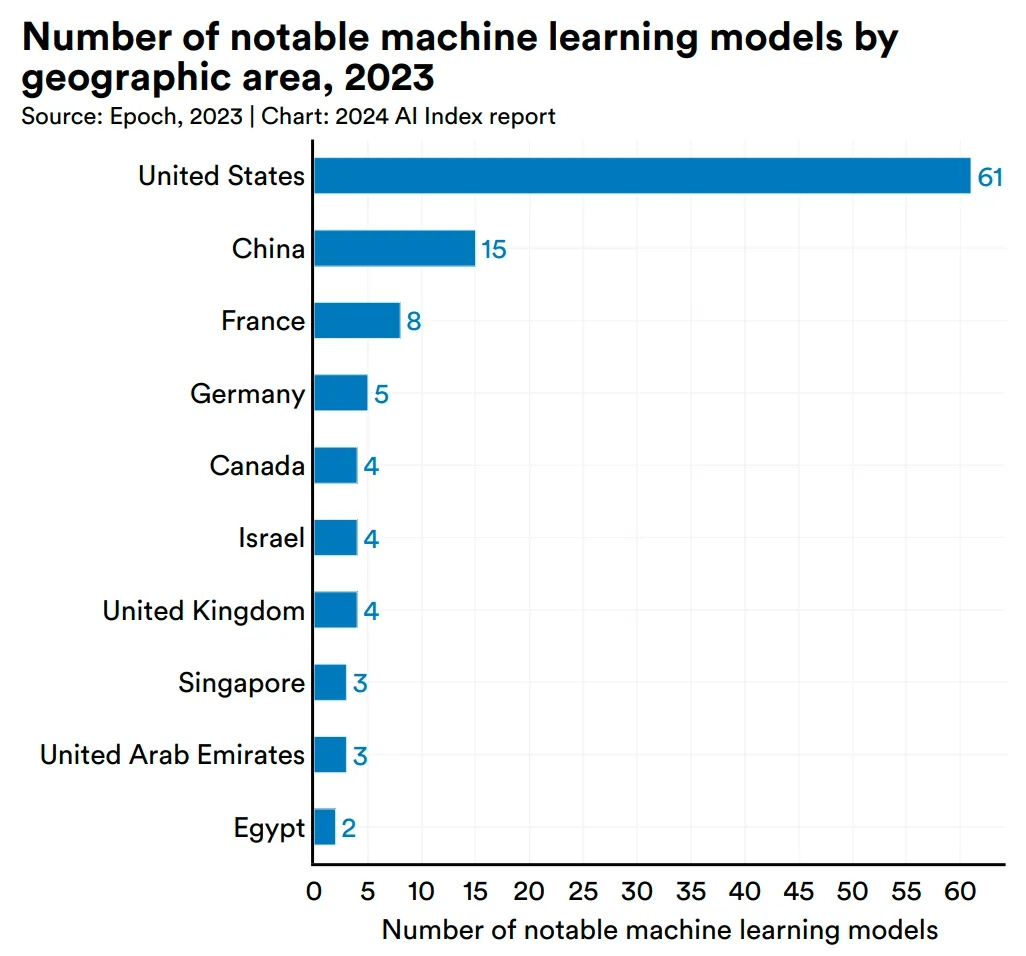

在2023年的「百模大战」中,众多实践者推出了各类模型,这些模型有的是原创的,有的是针对开源模型进行微调的;有些是通用的,有些则是行业特定的。如何能合理地评价这些模型的能力,成为关键问题