全面增强LLM推理/规划/执行力!北航提出全新「内置CoT」思考方法

全面增强LLM推理/规划/执行力!北航提出全新「内置CoT」思考方法基于内置思维链的思考方法为解决多轮会话中存在的问题提供了研究方向。按照思考方法收集训练数据集,通过有监督学习微调大语言模型;训练一个一致性奖励模型,并将该模型用作奖励函数,以使用强化学习来微调大语言模型。结果大语言模型的推理能力和计划能力,以及执行计划的能力得到了增强。

基于内置思维链的思考方法为解决多轮会话中存在的问题提供了研究方向。按照思考方法收集训练数据集,通过有监督学习微调大语言模型;训练一个一致性奖励模型,并将该模型用作奖励函数,以使用强化学习来微调大语言模型。结果大语言模型的推理能力和计划能力,以及执行计划的能力得到了增强。

Kimi未来还能够翻盘吗? 从公司发展路径上来看,并非没有可能。 作为曾经对OpenAI技术跟随最快的公司,Kimi在去年做出了Kimi探索版、k0-math等多个跟随OpenAI技术的模型,而杨植麟本人也在采访中,表示大模型的未来不仅在于强化学习,还在于多模态能力。 这一点似乎也与OpenAI类似。

本文深入解析一项开创性研究——"Logic-RL: Unleashing LLM Reasoning with Rule-Based Reinforcement Learning",该研究通过基于规则的强化学习技术显著提升了语言模型的推理能力。微软亚洲的研究团队受DeepSeek-R1成功经验的启发,利用结构化的逻辑谜题作为训练场,为模型创建了一个可以系统学习和改进推理技能的环境。

当 Scaling Law 在触顶边界徘徊之时,强化学习为构建更强大的大模型开辟出了一条新范式。

世界模型(World Model)作为近年来机器学习和强化学习的研究热点,通过建立智能体对其所处环境的一种内部表征和模拟,能够加强智能体对于世界的理解,进而更好地进行规划和决策。

强化学习训练数据越多,模型推理能力就越强?新研究提出LIM方法,揭示提升推理能力的关键在于优化数据质量,而不是数据规模。该方法在小模型上优势尽显。从此,强化学习Scaling Law可能要被改写了!

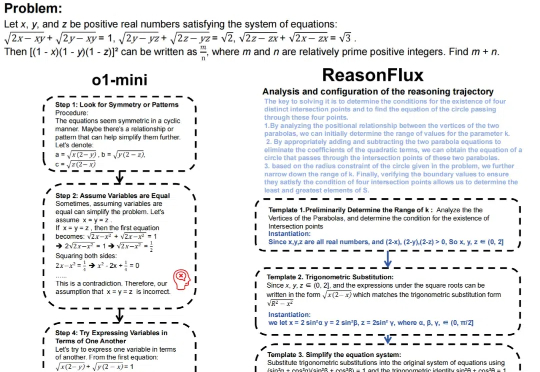

推理大语言模型(LLM),如 OpenAI 的 o1 系列、Google 的 Gemini、DeepSeek 和 Qwen-QwQ 等,通过模拟人类推理过程,在多个专业领域已超越人类专家,并通过延长推理时间提高准确性。推理模型的核心技术包括强化学习(Reinforcement Learning)和推理规模(Inference scaling)。

本期我们有幸邀请到了Pokee AI创始人朱哲清Bill,凭借Bill在Meta和斯坦福大学的丰富经验,尤其是在大规模部署强化学习模型服务数十亿用户方面的实践,他发现了强化学习的巨大潜力。Pokee AI致力于开发卓越的交互式、个性化、高效的AI Agent,结合团队深厚的强化学习专长,打造具备规划、推理和工具使用能力的解决方案,同时减少现有 AI 系统的幻觉问题。

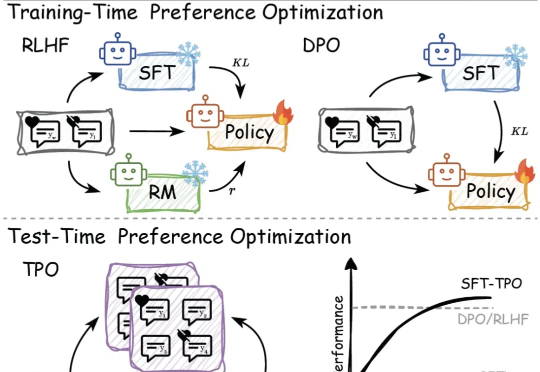

传统的偏好对⻬⽅法,如基于⼈类反馈的强化学习(RLHF)和直接偏好优化(DPO),依赖于训练过程中的模型参数更新,但在⾯对不断变化的数据和需求时,缺乏⾜够的灵活性来适应这些变化。

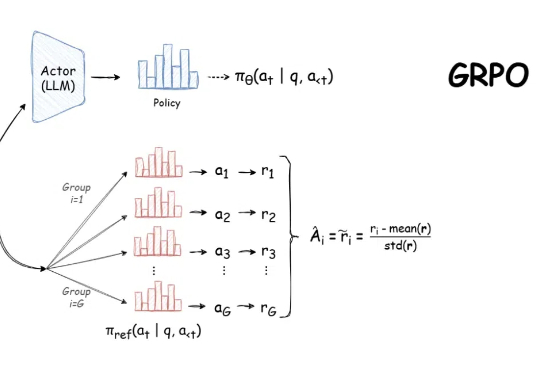

自 DeepSeek-R1 发布以来,群组相对策略优化(GRPO)因其有效性和易于训练而成为大型语言模型强化学习的热门话题。R1 论文展示了如何使用 GRPO 从遵循 LLM(DeepSeek-v3)的基本指令转变为推理模型(DeepSeek-R1)。