力压70B Llama 3,Gemma 2成最强开源模型!大佬质疑用榜单prompt微调引全网热议

力压70B Llama 3,Gemma 2成最强开源模型!大佬质疑用榜单prompt微调引全网热议导读:时隔4个月上新的Gemma 2模型在LMSYS Chatbot Arena的排行上,以27B的参数击败了许多更大规模的模型,甚至超过了70B的Llama-3-Instruct,成为开源模型的性能第一!

导读:时隔4个月上新的Gemma 2模型在LMSYS Chatbot Arena的排行上,以27B的参数击败了许多更大规模的模型,甚至超过了70B的Llama-3-Instruct,成为开源模型的性能第一!

文章第一作者为来自北京大学物理学院、即将加入人工智能研究院读博的胡逸。胡逸的导师为北京大学人工智能研究院助理教授、北京通用人工智能研究院研究员张牧涵,主要研究方向为图机器学习和大模型的推理和微调。

近日,LeCun和谢赛宁等大佬,共同提出了这一种全新的SOTA MLLM——Cambrian-1。开创了以视觉为中心的方法来设计多模态模型,同时全面开源了模型权重、代码、数据集,以及详细的指令微调和评估方法。

如何无痛玩转Llama 3,这个手把手教程一看就会!80亿参数推理单卡半分钟速成,微调700亿参数仅用4卡近半小时训完,还有100元代金券免费薅。

自 ChatGPT 发布以来,大型语言模型(LLM)已经成为推动人工智能发展的关键技术。

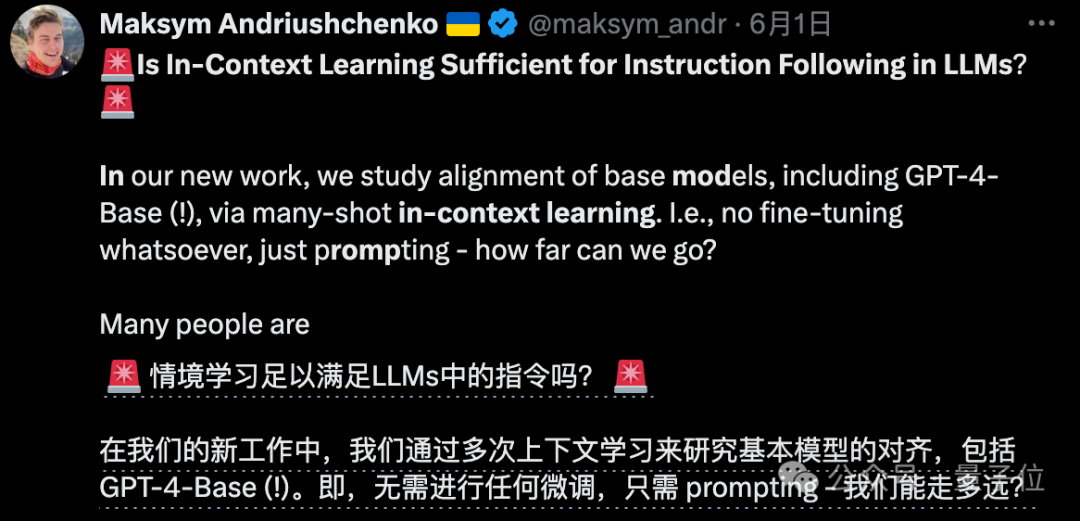

本研究评估了先进多模态基础模型在 10 个数据集上的多样本上下文学习,揭示了持续的性能提升。批量查询显著降低了每个示例的延迟和推理成本而不牺牲性能。这些发现表明:利用大量演示示例可以快速适应新任务和新领域,而无需传统的微调。

当前主流的视觉语言模型(VLM)主要基于大语言模型(LLM)进一步微调。因此需要通过各种方式将图像映射到 LLM 的嵌入空间,然后使用自回归方式根据图像 token 预测答案。

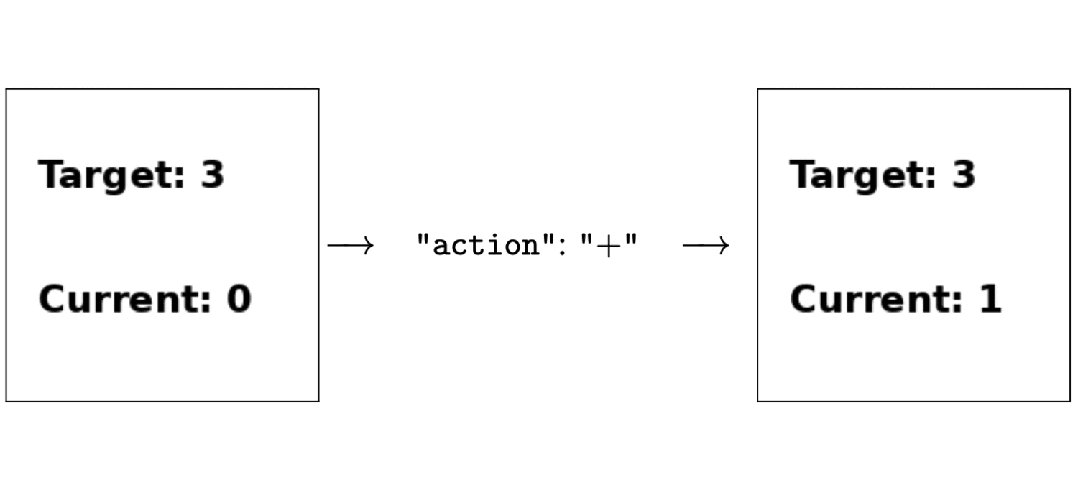

只用强化学习来微调,无需人类反馈,就能让多模态大模型学会做决策!

除了OpenAI自己,居然还有别人能用上GPT-4-Base版??

比斯坦福DPO(直接偏好优化)更简单的RLHF平替来了,来自陈丹琦团队。 该方式在多项测试中性能都远超DPO,还能让8B模型战胜Claude 3的超大杯Opus。 而且与DPO相比,训练时间和GPU消耗也都大幅减少。