周鸿祎傅盛:相逢大模型,一笑泯恩仇

周鸿祎傅盛:相逢大模型,一笑泯恩仇此次发布的猎户星空大模型专为企业应用而生,该模型通过140亿参数实现了千亿参数大模型才能实现的效果,面向七大应用领域进行微调,可以在千元显卡算力上运行。 用傅盛的说法是,用的好,用的起,用的安全。

此次发布的猎户星空大模型专为企业应用而生,该模型通过140亿参数实现了千亿参数大模型才能实现的效果,面向七大应用领域进行微调,可以在千元显卡算力上运行。 用傅盛的说法是,用的好,用的起,用的安全。

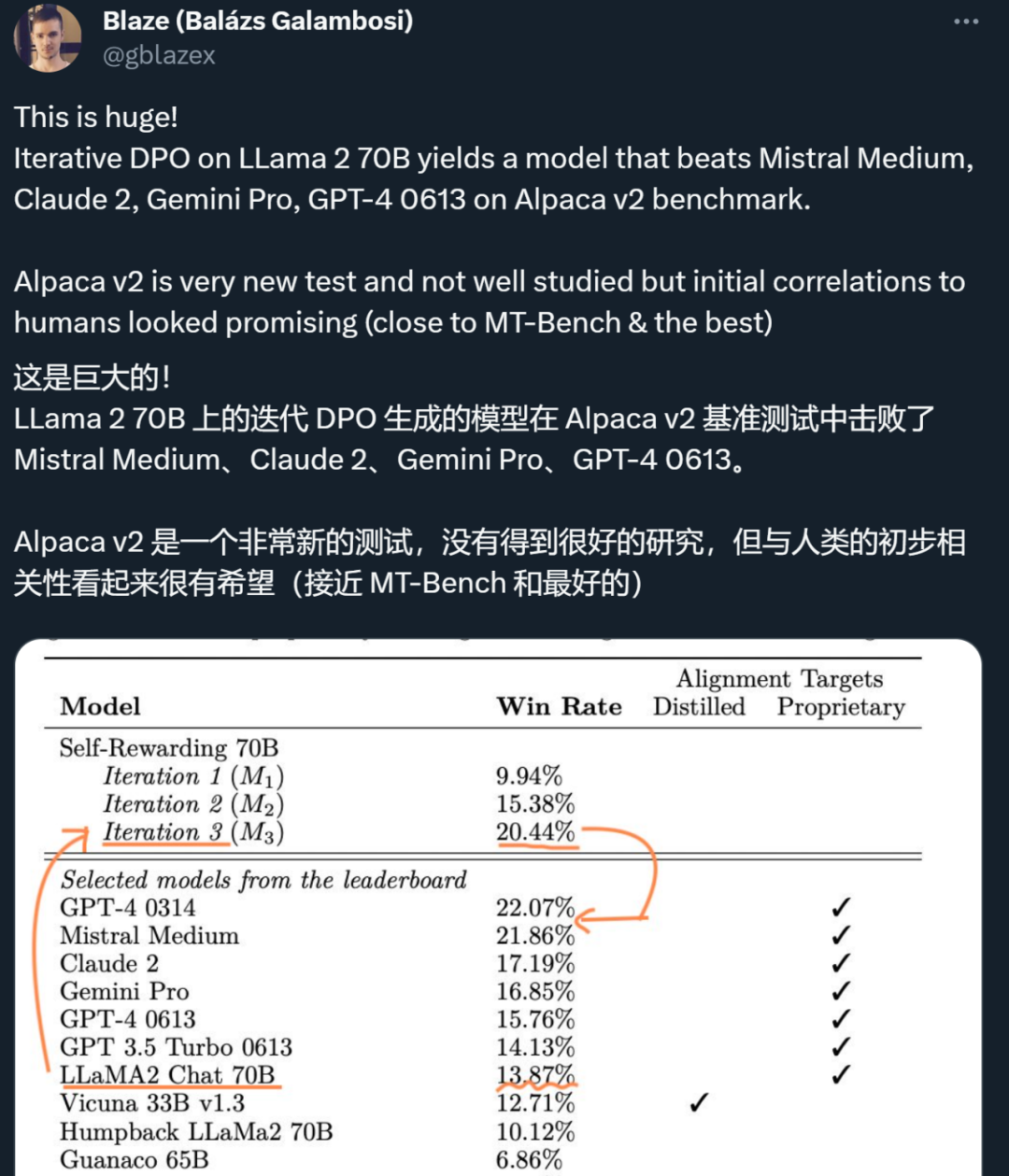

昨天,Meta、纽约大学的研究者用「自我奖励方法」,让大模型自己生成自己的微调数据,从而在 Llama 2 70B 的迭代微调后超越了 GPT-4。今天,英伟达的全新对话 QA 模型「ChatQA-70B」在不使用任何 GPT 模型数据的情况下,在 10 个对话 QA 数据集上的平均得分略胜于 GPT-4。

自 ChatGPT 等大型语言模型推出以来,为了提升模型效果,各种指令微调方法陆续被提出。本文中,普林斯顿博士生、陈丹琦学生高天宇汇总了指令微调领域的进展,包括数据、算法和评估等。

人工智能的反馈(AIF)要代替 RLHF 了?

Mixtral 8x7B模型开源后,AI社区再次迎来一大波微调实践。来自Nous Research应用研究小组团队微调出新一代大模型Nous-Hermes 2 Mixtral 8x7B,在主流基准测试中击败了Mixtral Instruct。

OpenAI 宣布,正式开放 GPT3.5 微调 API,并承诺 2023 年内推出 GPT-4 微调 API。

LAMM (Language-Assisted Multi-Modal) 旨在建设面向开源学术社区的多模态指令微调及评测框架,其包括了高度优化的训练框架、全面的评测体系,支持多种视觉模态。

无需微调,只要四行代码就能让大模型窗口长度暴增,最高可增加3倍!而且是“即插即用”,理论上可以适配任意大模型,目前已在Mistral和Llama2上试验成功。

谷歌新设计的一种图像生成模型已经能做到这一点了!通过引入指令微调技术,多模态大模型可以根据文本指令描述的目标和多张参考图像准确生成新图像,效果堪比 PS 大神抓着你的手助你 P 图。

进入现今的大模型 (LLM) 时代,又有研究者发现了左右互搏的精妙用法!近日,加利福尼亚大学洛杉矶分校的顾全全团队提出了一种新方法 SPIN(Self-Play Fine-Tuning),可不使用额外微调数据,仅靠自我博弈就能大幅提升 LLM 的能力。