让数据说话:2024年银行在大模型上花了多少钱

让数据说话:2024年银行在大模型上花了多少钱今天,我想用一些数据,来盘点2024年各家银行的大模型项目招标结果。

今天,我想用一些数据,来盘点2024年各家银行的大模型项目招标结果。

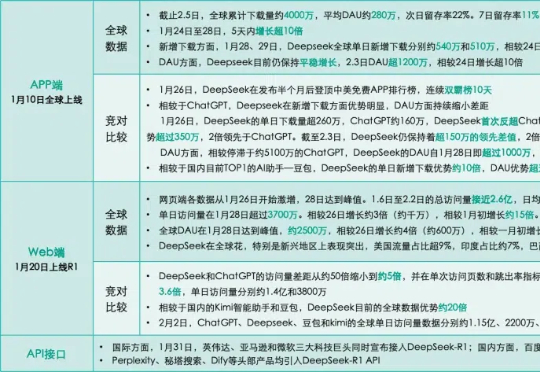

DeepSeek会是国内首个挑战ChatGPT,重塑AI助手现有格局的产品吗?从产品数据来看,值得期待。在APP端,DeepSeek上线半个月,就在新增下载量上超越了ChatGPT,并将百万级的领先优势持续至今。截至2月5日,DeepSeek的全球下载量已接近4000万。

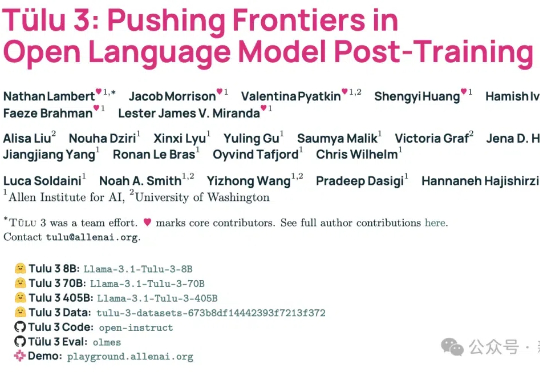

2024年11月,艾伦人工智能研究所(Ai2)推出了Tülu 3 8B和70B,在性能上超越了同等参数的Llama 3.1 Instruct版本,并在长达82页的论文中公布其训练细节,训练数据、代码、测试基准一应俱全。

据麦可思数据,国内高校师生几乎全部都曾在学习和工作中使用生成式AI,从未使用过生成式AI的高校师生比例仅为1%。这表明,在高校中,生成式AI的应用已实现普及。若将“每天多次使用”和“每周多次使用”视作频繁使用,两者累计计算,近六成高校师生频繁使用生成式AI。其中18%的高校师生每天多次使用,已成生成式AI“重度用户”。

AI硬件的风吹了一年,消费电子的销量好起来了,但和AI的关系不大。经历了2023年的低谷期后,智能手机、PC都在2024年迎来了不同程度的复苏。根据Canalys数据,2024年全球智能手机出货量达到12.2亿台,同比增长了7%,结束了连续两年的下滑趋势;PC在经历了漫长的行业寒冬后,也实现了3.8%的同比增幅。

开发基于大模型的软件应用,就像指挥一支足球队:组件是能力各异的队员,编排是灵活多变的战术,数据是流转的足球。

2025 年伊始,全球 AI 业界被 DeepSeek 刷屏。当 OpenAI 宣布 5000 亿美元的「星际之门」计划,Meta 在建规模超 130 万 GPU 的数据中心时,这个来自中国的团队打破了大模型军备竞赛的既定逻辑:用 2048 张 H800 GPU,两个月训练出了一个媲美全球顶尖水平的模型。

他们急了!特朗普的AI沙皇和微软纷纷指控DeepSeek「偷窃」数据,DeepSeek不断遭受来自美国IP的不间断大规模攻击。Anthropic CEO更是发出檄文:再不加强对中国的芯片管制,就来不及了!

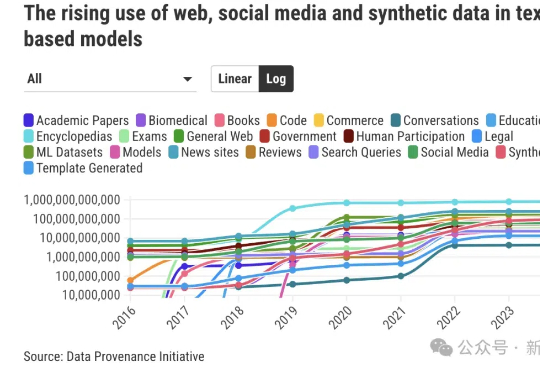

相比LLM和Agent领域日新月异、高度成熟的进展相比,数据收集方面的规范有明显滞后。由超过50名研究人员组成的「数据溯源计划」(DPI)旨在回答这样一个问题:AI训练所需的数据究竟来自何处?

DeepSeek、迅雷、虎扑其实都在思考同一个问题:数字时代发展到当下,科技行业应该何去何从?龙年年底,科技界和体育界分别迎来两宗大事件——2025年1月20日,DeepSeek-R1开源人工智能模型发布;2025年1月27日,迅雷宣布作价5亿元人民币收购体育媒体及数据平台虎扑。