模型参数作知识通用载体,MergeNet离真正的异构知识迁移更进一步

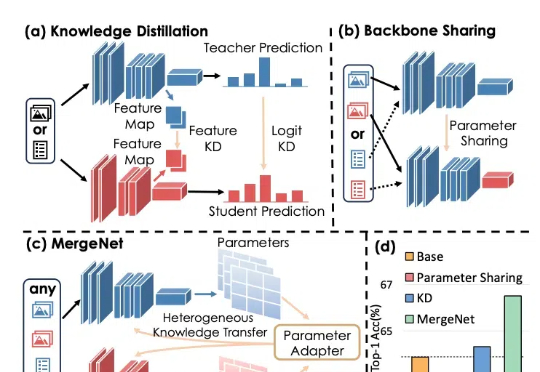

模型参数作知识通用载体,MergeNet离真正的异构知识迁移更进一步知识蒸馏通过训练一个紧凑的学生模型来模仿教师模型的 Logits 或 Feature Map,提高学生模型的准确性。迁移学习则通常通过预训练和微调,将预训练阶段在大规模数据集上学到的知识通过骨干网络共享应用于下游任务。

知识蒸馏通过训练一个紧凑的学生模型来模仿教师模型的 Logits 或 Feature Map,提高学生模型的准确性。迁移学习则通常通过预训练和微调,将预训练阶段在大规模数据集上学到的知识通过骨干网络共享应用于下游任务。

最近,科技圈都在传一个数据:百度旗下的文库业务,AI功能月活用户突破9000万,超过字节旗下豆包的7000万。最近,科技圈都在传一个数据:百度旗下的文库业务,AI功能月活用户突破9000万,超过字节旗下豆包的7000万。

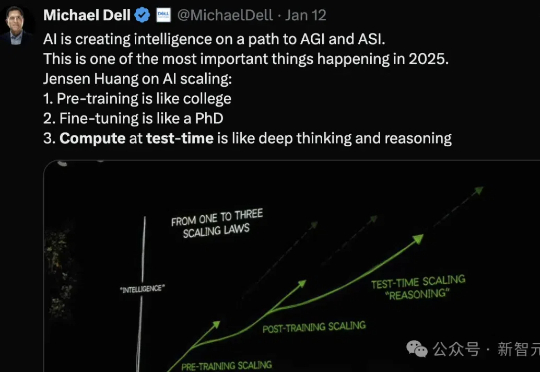

2028年,预计高质量数据将要耗尽,数据Scaling走向尽头。2025年,测试时计算将开始成为主导AI通向通用人工智能(AGI)的新一代Scaling Law。近日,CMU机器学习系博客发表新的技术文章,从元强化学习(meta RL)角度,详细解释了如何优化LLM测试时计算。

非营利研究机构AI2近日推出的完全开放模型OLMo 2,在同等大小模型中取得了最优性能,且该模型不止开放权重,还十分大方地公开了训练数据和方法。

「星际之门」更多内幕被曝光了!据称,首期投入1000亿美金,将在德州阿比林建设10座数据中心,未来要在全美打造20个超算。与此同时,奥特曼秀出了首期工厂的全景,无比震撼。

由无问芯穹与上海交通大学联合研究团队提出的视频生成软硬一体加速器,首次实现通过差分近似和自适应数据流解决 VDiT 生成速度缓慢瓶颈,推理速度相比 A100 提升高达 16.44 倍。

刚刚发布的豆包大模型1.5,不仅多模态能力全面提升,霸榜多个基准;更难得的是,它在训练过程中从未使用过任何其他模型生成的数据,坚决不走蒸馏「捷径」。

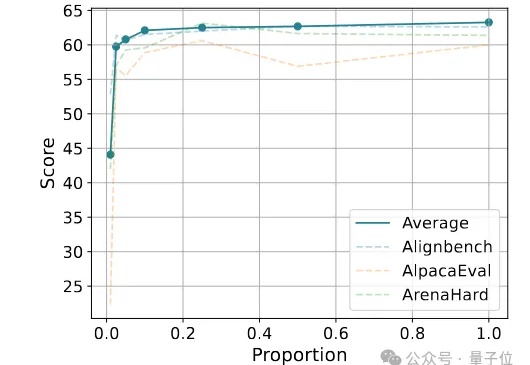

仅使用20K合成数据,就能让Qwen模型能力飙升——

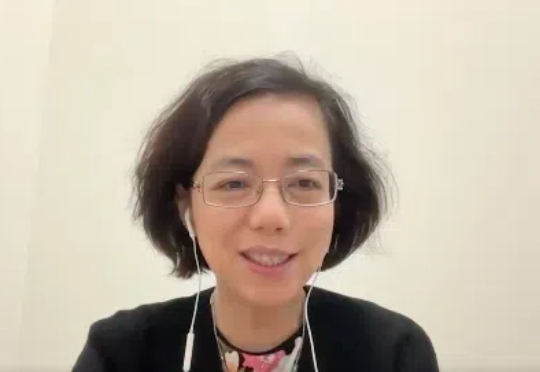

最近,斯坦福大学教授李飞飞接受了硅谷著名投资人 Reid Hoffman 和 Aria Finger 的联合播客专访。在这场对话中,李飞飞主要探讨了以下主题: ImageNet 的灵感源于难以避开模型的过拟合问题,李飞飞意识到与其苦心改进模型,不如用数据驱动。

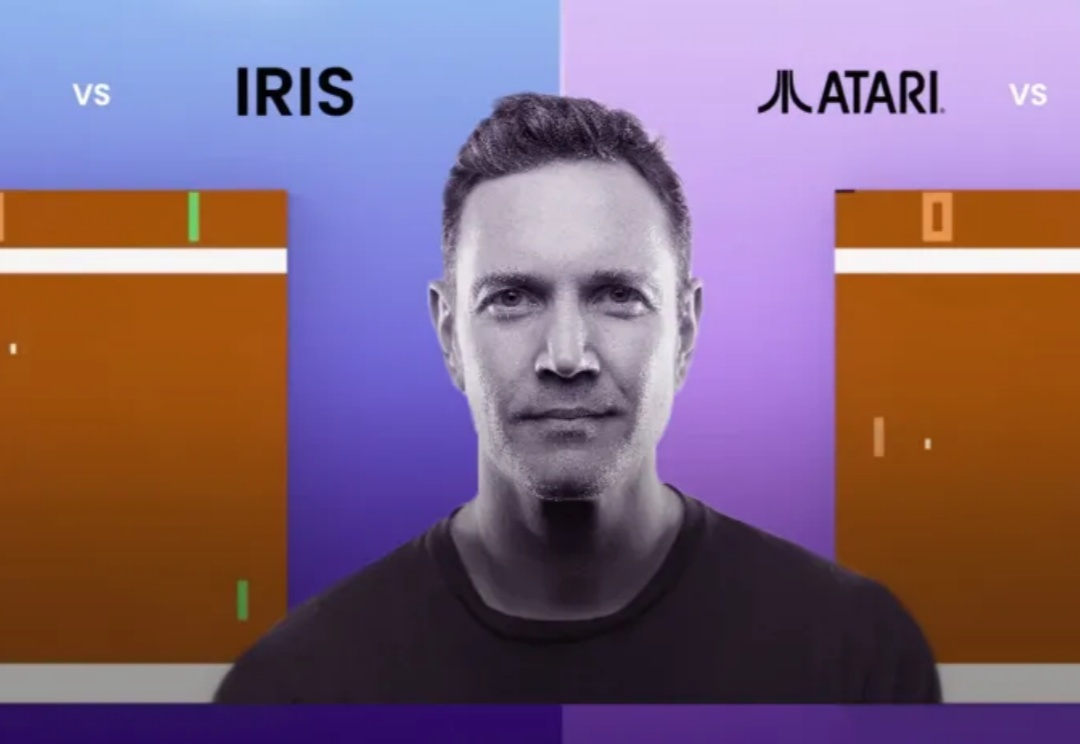

就在刚刚,Verses团队研发的Genius智能体,在Pong中超越了人类顶尖玩家!而且它仅仅训练2小时,用了1/10数据,就秒杀了其他顶级AI模型。