Qwen负责人转发2025宝藏论文,年底重读「视觉领域GPT时刻」

Qwen负责人转发2025宝藏论文,年底重读「视觉领域GPT时刻」2025最后几天,是时候来看点年度宝藏论文了。

2025最后几天,是时候来看点年度宝藏论文了。

能翻译33语种+5方言,医学术语/粤语翻译实测“能打”。

第一批AI大模型公司上市潮来了,先冲线的两家公司MiniMax、智谱揭开了自己的底牌。

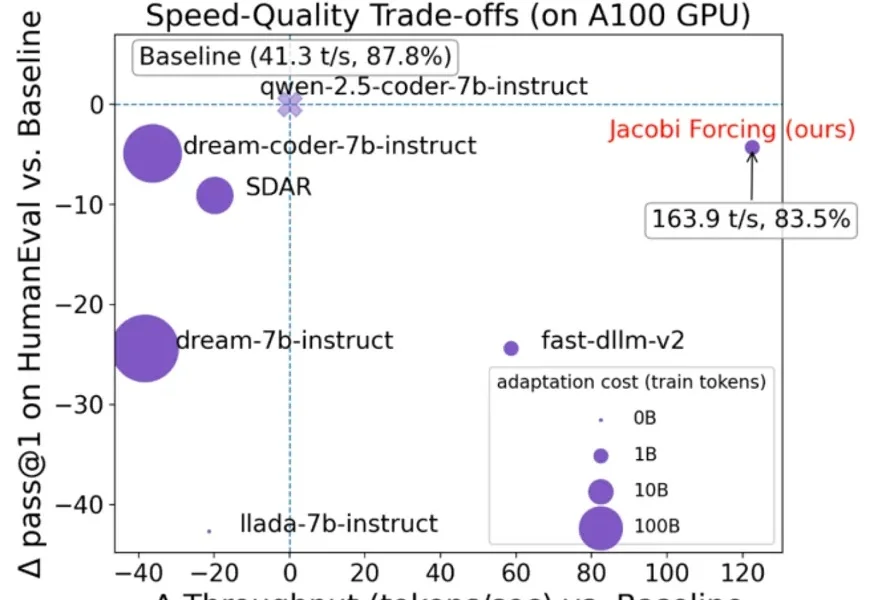

在大语言模型(LLM)落地应用中,推理速度始终是制约效率的核心瓶颈。传统自回归(AR)解码虽能保证生成质量,却需逐 token 串行计算,速度极为缓慢;扩散型 LLM(dLLMs)虽支持并行解码,却面

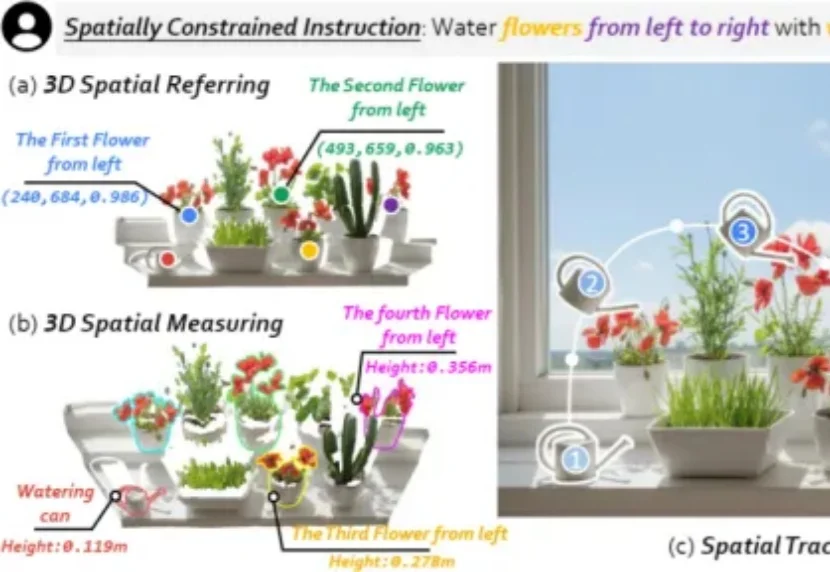

我们希望具身机器人真正走进真实世界,尤其走进每个人的家里,帮我们完成浇花、收纳、清洁等日常任务。但家庭环境不像实验室那样干净、单一、可控:物体种类多、摆放杂、随时会变化,这让机器人在三维物理世界中「看懂并做好」变得更难。

作为一名 AI 领域的博士生,徐玉庄的经历比较特殊。本科毕业于国防科技大学,随后在部队工作了 5 年,接着在清华大学获得硕士学位,目前在哈尔滨工业大学读博。

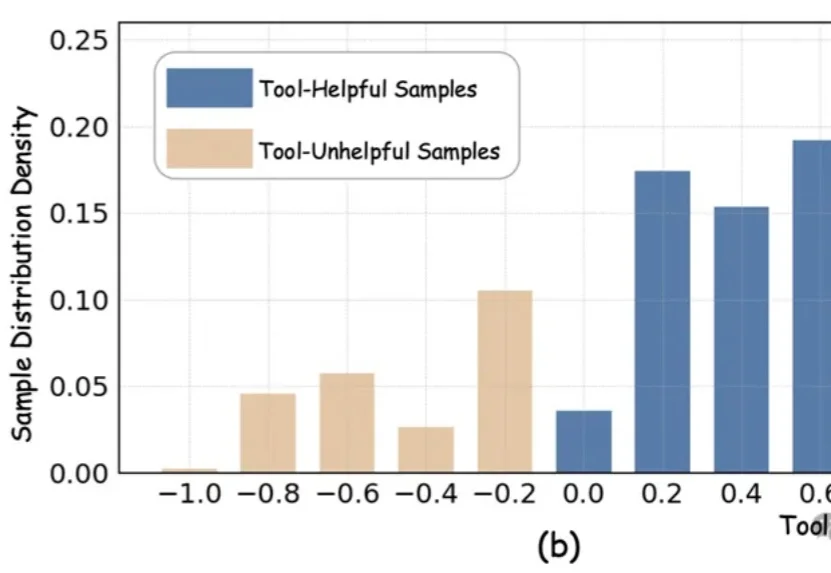

近期,以DeepEyes、Thymes为代表的类o3模型通过调用视觉工具,突破了传统纯文本CoT的限制,在视觉推理任务中取得了优异表现。

快手大模型掌舵人,被曝出即将离职!今天,多个媒体爆料,快手副总裁、基础大模型及推荐模型负责人周国睿即将离职。关于周国睿下一步去向,也成了谜团:据传他将加入Meta,也有消息称,他可能会转投TikTok,具体不得而知。

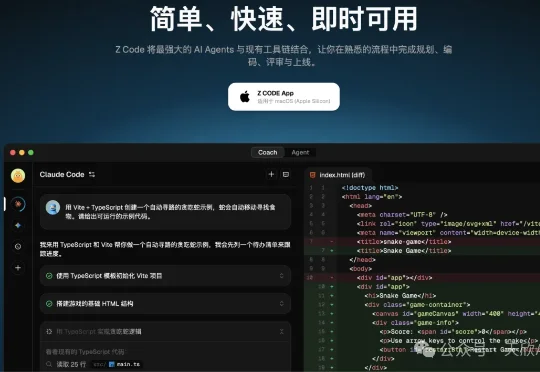

在 GLM-4.7 模型发布后不久,智谱又上线了一款全新理念的 AI 编程工具 Z Code。目前 Z Code 仍处于测试阶段,但在实际上手过程中,能感受到它与传统 AI 编程工具明显不同的设计思路。下载地址:https://zcode-ai.com/cn

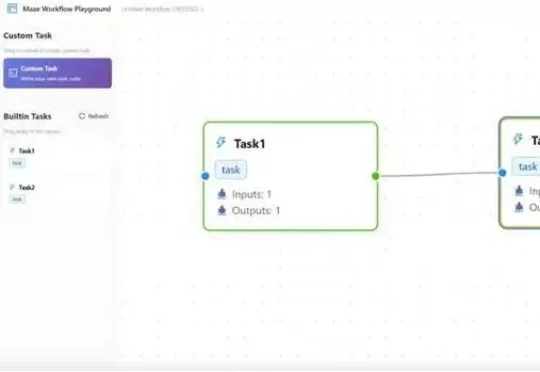

在大模型智能体(LLM Agent)落地过程中,复杂工作流的高效执行、资源冲突、跨框架兼容、分布式部署等问题一直困扰着开发者。而一款名为Maze的分布式智能体工作流框架,正以任务级精细化管理、智能资源调度、多场景部署支持等核心优势,为这些痛点提供一站式解决方案。