罗福莉首秀前,小米突然发布!代码全球最强,总体媲美DeepSeek-V3.2【附实测】

罗福莉首秀前,小米突然发布!代码全球最强,总体媲美DeepSeek-V3.2【附实测】今天,小米发布并开源了最新MoE大模型MiMo-V2-Flash,总参数309B,激活参数15B。今日上午,小米2025小米人车家全生态合作伙伴大会上,Xiaomi MiMO大模型负责人罗福莉将首秀并发布主题演讲。

今天,小米发布并开源了最新MoE大模型MiMo-V2-Flash,总参数309B,激活参数15B。今日上午,小米2025小米人车家全生态合作伙伴大会上,Xiaomi MiMO大模型负责人罗福莉将首秀并发布主题演讲。

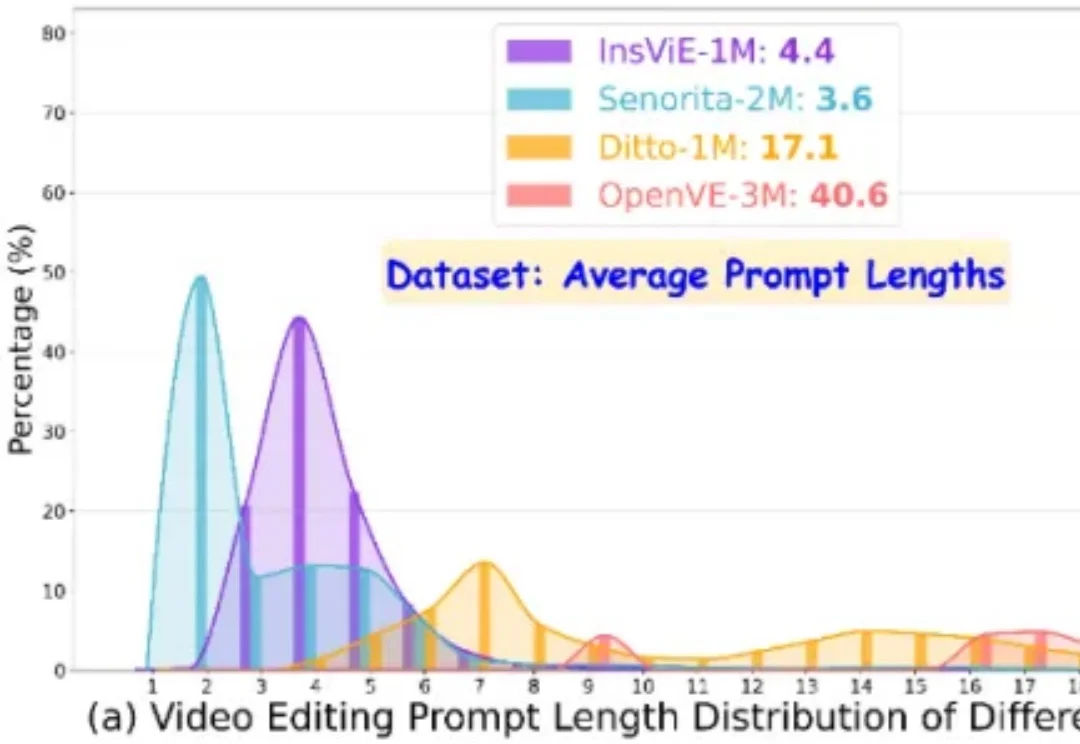

作者提出了一个大规模、高质量、多类别的指令跟随的视频编辑数据集 OpenVE-3M,共包含 3M 样本对,分为空间对齐和非空间对齐 2 大类别共 8 小类别。

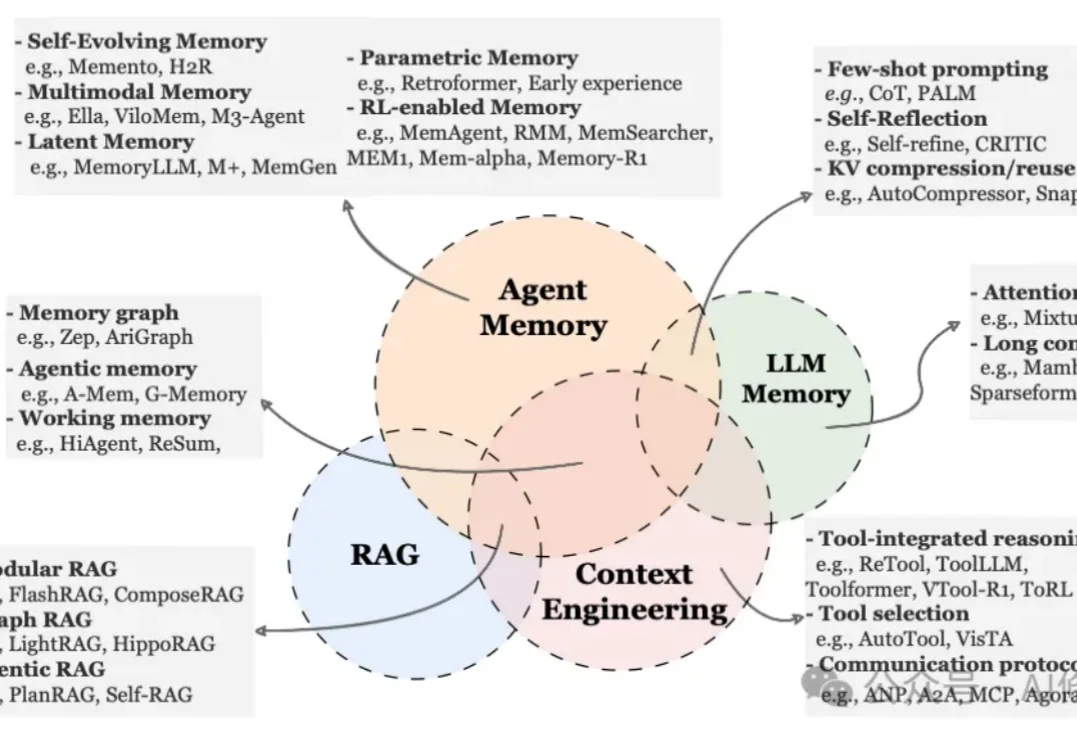

就在昨天,新加坡国立大学、中国人民大学、复旦大学等多所顶尖机构联合发布了一篇AI Agent 记忆(Memory)综述。

为了抢回头把交椅,OpenAI 今天正式推出了最新图像视觉模型 GPT-Image-1.5。这也是继 GPT-5.2 之后,OpenAI 红色警报计划中又一记重拳。

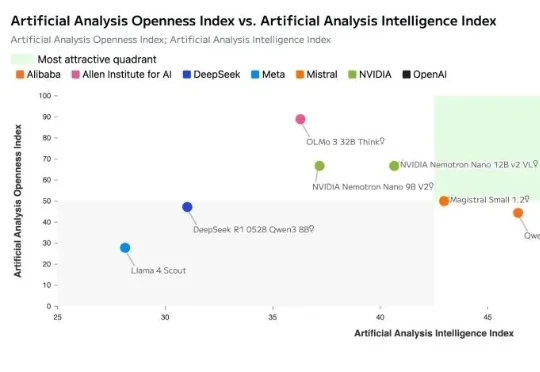

最近几天,一张开源模型的等级列表在 X 上被疯狂转载。 从夯到拉,国产开源模型排在了数一数二的位置,DeepSeek、Qwen、Kimi、智谱、还有 MiniMax 是全球开源模型的前五名。

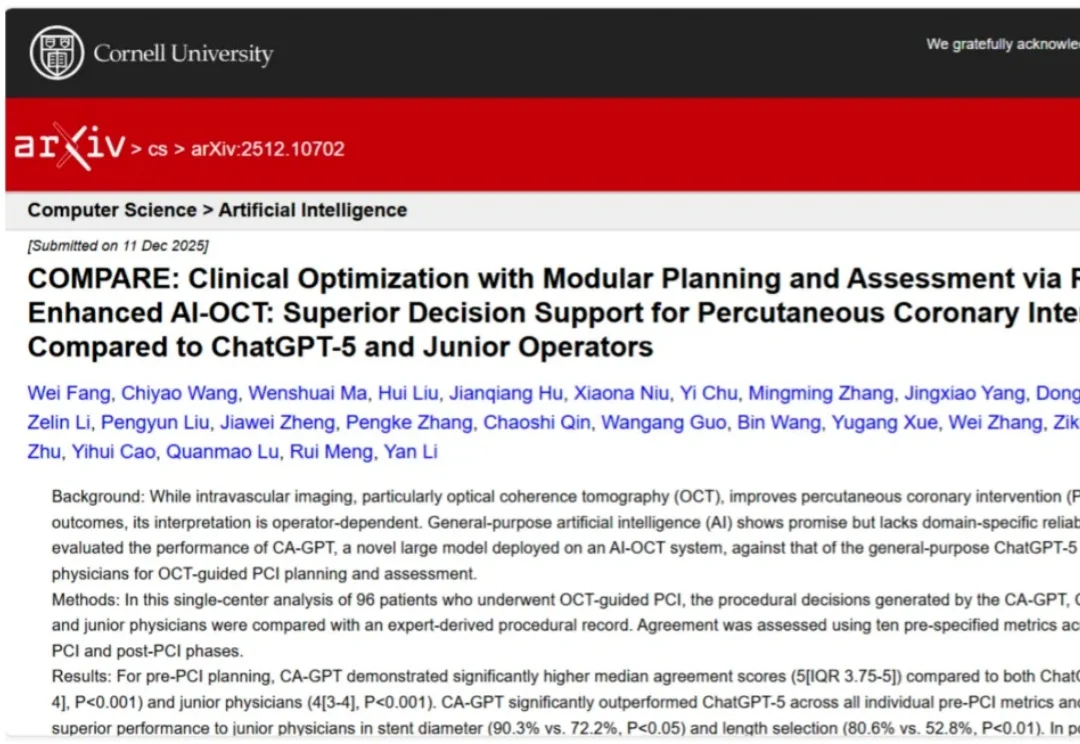

通用大模型(LLM)的狂飙突进,终于在医疗垂直领域的「最后一公里」撞上了硬墙。虽然 ChatGPT 在 USMLE(美国执业医师资格考试)中表现优异,但在面对需要「火眼金睛」和「毫厘必争」的心脏手术台上,通用大模型的表现究竟如何?

就在刚刚,英伟达正式开源发布了其新一代AI模型:NVIDIA Nemotron 3。Nemotron 3 系列由三种型号组成:Nano、Super 和 Ultra。官方介绍其具备强大的智能体、推理和对话能力。

正如奥特曼执意打造硬件,试图打破手机屏束缚,要让 AI 感受物理世界;Looki 的诞生也源于同样的渴望:补齐大模型「感官智能」的最后拼图,将现实场景实时转化为上下文,驱动人机交互从「被动问答」进化为「主动共鸣」。

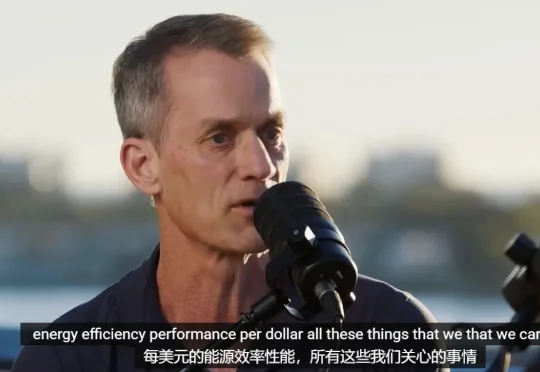

“与AGI太过遥远的炒作相比,我非常喜欢这种 3 到 5 年的时间窗口。”“AI 现在最大的问题,已经不是不够聪明,而是太难真正落地。”这些非常务实的观点,并不是出自AI怀疑论者。相反,它出自硅谷圈内那位“工程与学术”的双修神话:

从 0 到上线,在OpenAI内部,安卓版 Sora经历的时间只有 28 天,而且期间只用了 2-3 名员工。