医疗AI智能体全面综述:行业爆发,年增长130%!

医疗AI智能体全面综述:行业爆发,年增长130%!AI智能体正把医疗AI从「看片子」升级成会思考、能行动的「医生搭档」。研究人员发表的最新综述,用通俗语言拆解智能体如何读懂多模态数据、像专家一样规划决策,又能扮演医生、护士、健康管家等多重角色;同时提醒:越智能越危险,必须配套严格评估、隐私保护与伦理护栏,才敢让它走进真实诊疗。

AI智能体正把医疗AI从「看片子」升级成会思考、能行动的「医生搭档」。研究人员发表的最新综述,用通俗语言拆解智能体如何读懂多模态数据、像专家一样规划决策,又能扮演医生、护士、健康管家等多重角色;同时提醒:越智能越危险,必须配套严格评估、隐私保护与伦理护栏,才敢让它走进真实诊疗。

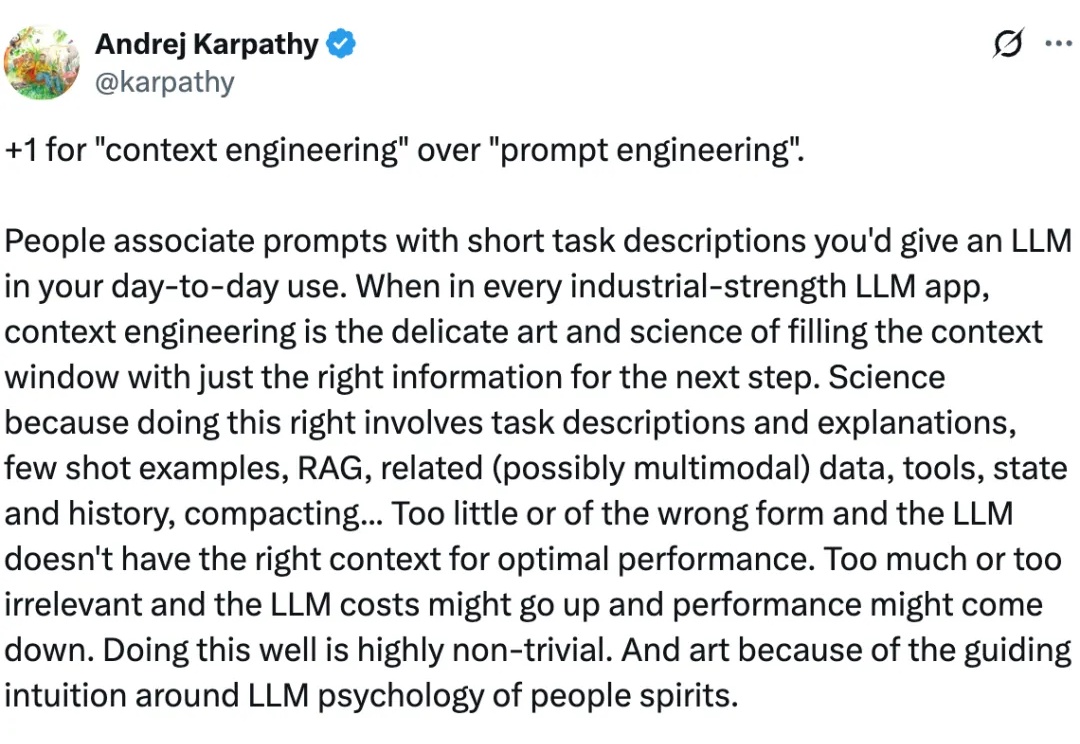

「过去,我们作为人类用户使用搜索的习惯和要求,与现在 AI 对搜索的需求截然不同。」

Gemini3太强了。 11月18日,在所有人的期待中,Google的最新AI模型Gemini3正式发布。这次,一切都回到了Google的节奏。 彻底屠榜 这是一个几乎“屠榜”了所有评测集的模型,而且

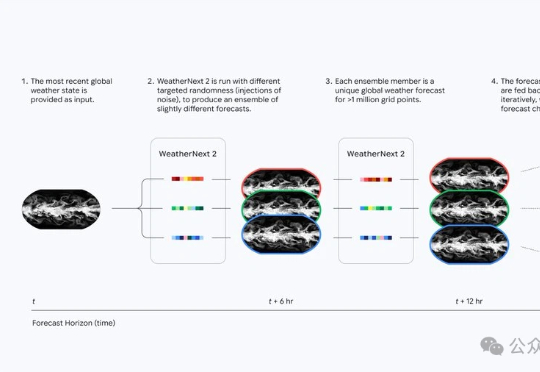

天气预报的时代真的变了。谷歌DeepMind最新发布的WeatherNext 2,让查天气这件事升级成了小时级、实时化。它的运行速度比上一代快8倍,分辨率提高到小时级,也就是说不再是传统预报里的“明天下午有雨”,而是可以细到“明天2–3点有小雨,3–4点雨势增强,5–6点逐渐停止”的节奏。

当美国巨头如Google、OpenAI 和 Anthropic 竞相开发支撑其 AI 产品的大型语言模型时,Sakana AI、Mistral AI、DeepSeek 和 AI21 Labs 等初创公司正凭借为特定地区、行业或独特功能设计的专业模型开辟自己的细分市场。

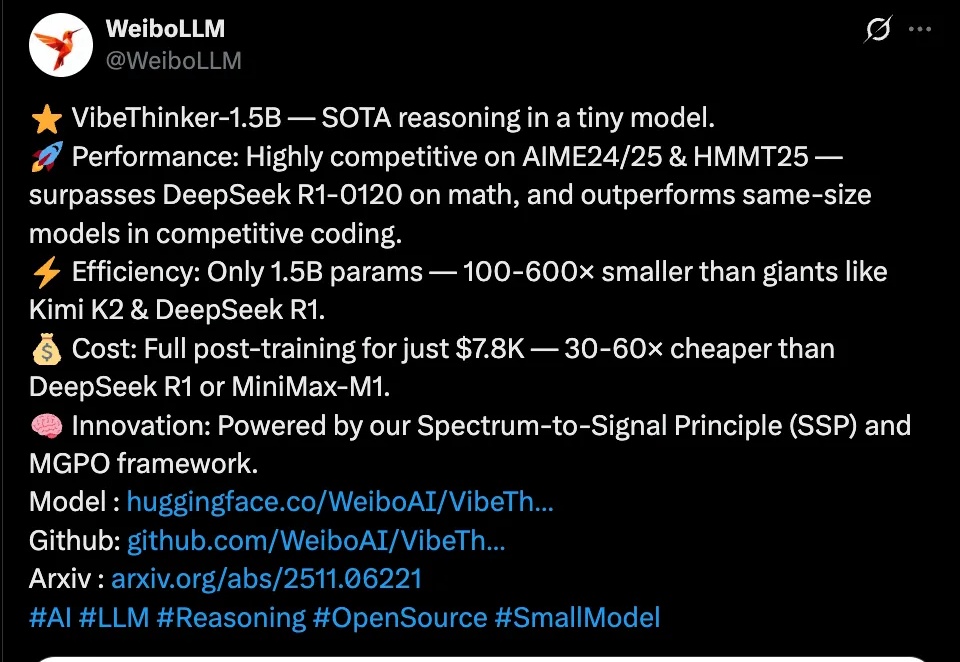

近日,微博正式发布首个自研开源大模型VibeThinker,这个仅拥有15亿参数的“轻量级选手”,在国际顶级数学竞赛基准测试上击败了参数量是其数百倍的、高达6710亿的DeepSeek R1模型。

本周,美国具身智能创业公司 Physical Intelligence(简称 PI 或 π)发布了旗下的最新机器人基础模型 π*0.6。PI 是一家总部位于旧金山的机器人与 AI 创业公司,其使命是将通用人工智能从数字世界带入物理世界:他们的首个机器人通用基础模型名为 π₀,让同一套软件控制多种物理平台执行各类任务。

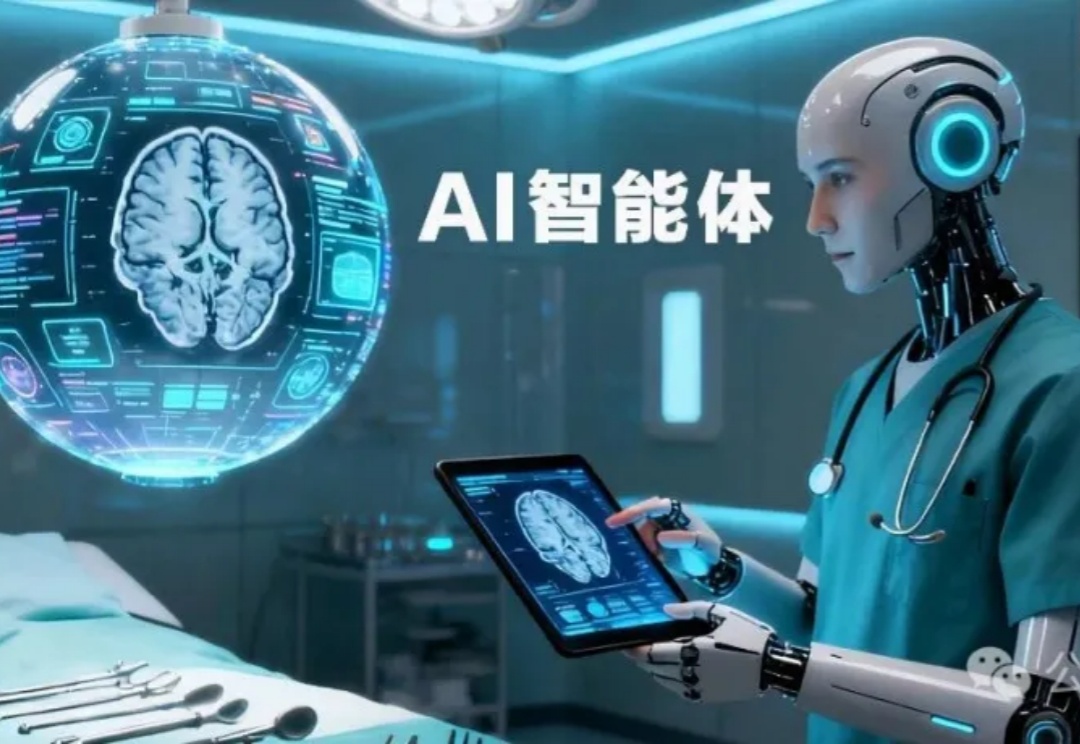

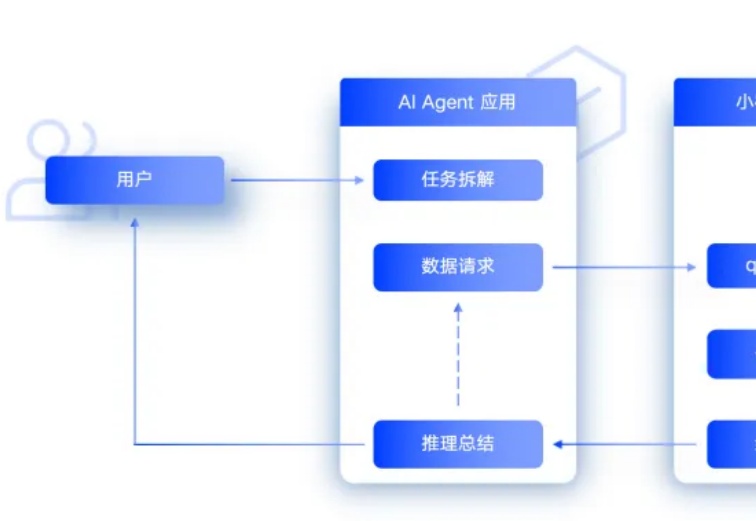

AI Agent 在处理复杂任务时经常“掉链子”。你刚告诉它的信息,它很快就忘了。给它的工具越多,它反而越混乱。这不是个例。

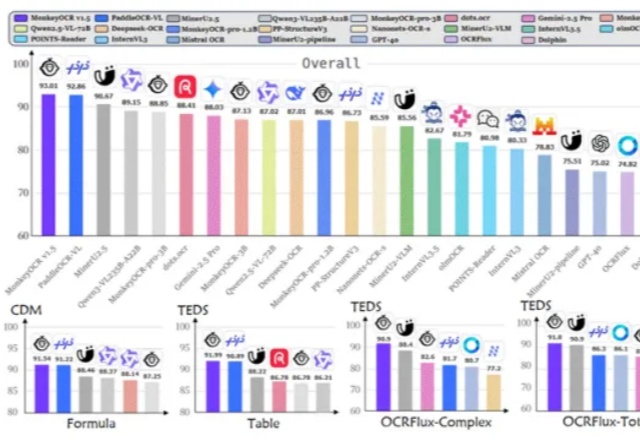

是金山派来的猴子,复杂文档解析有救了!

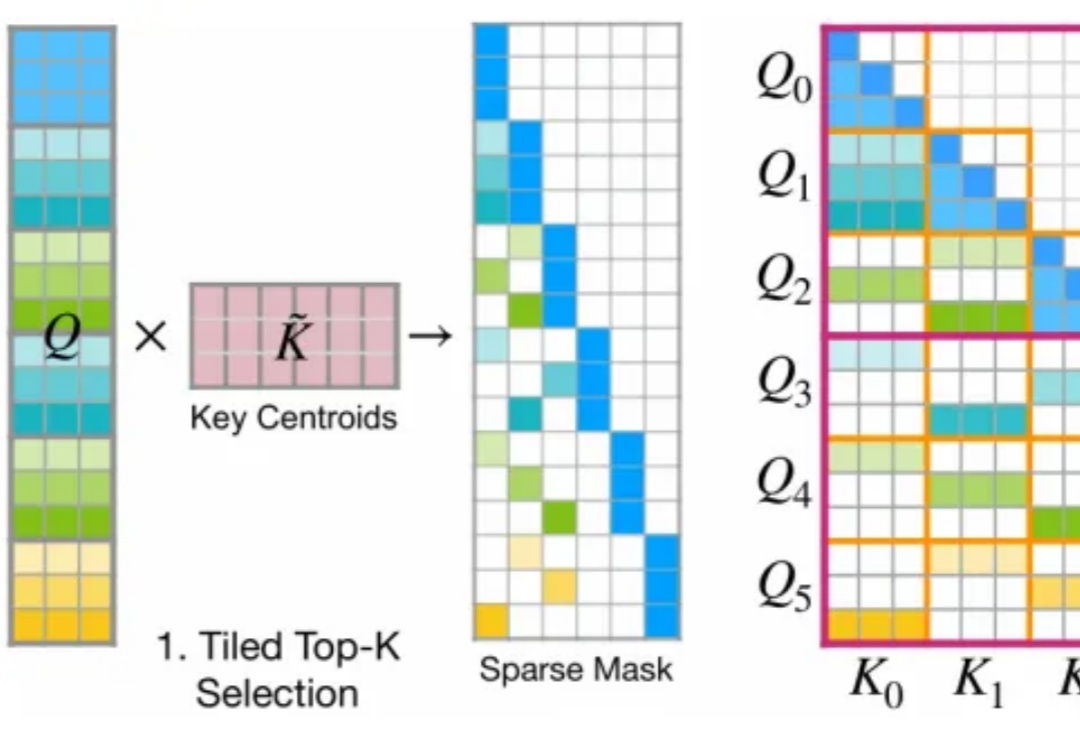

今年 2 月,月之暗面提出了一种名为 MoBA 的注意力机制,即 Mixture of Block Attention,可以直译为「块注意力混合」。