地球级AI智能体爆诞!谷歌地球开外挂,一夜为20亿人洪水预警

地球级AI智能体爆诞!谷歌地球开外挂,一夜为20亿人洪水预警地理AI,还得看谷歌!谷歌首次实现地球尺度的复杂地理空间推理,把地球变成「可计算对象」。基于数十年在世界建模上的经验,结合Gemini的先进推理能力,谷歌重磅升级Earth AI——从环境监测到灾害响应,尽在其中。

地理AI,还得看谷歌!谷歌首次实现地球尺度的复杂地理空间推理,把地球变成「可计算对象」。基于数十年在世界建模上的经验,结合Gemini的先进推理能力,谷歌重磅升级Earth AI——从环境监测到灾害响应,尽在其中。

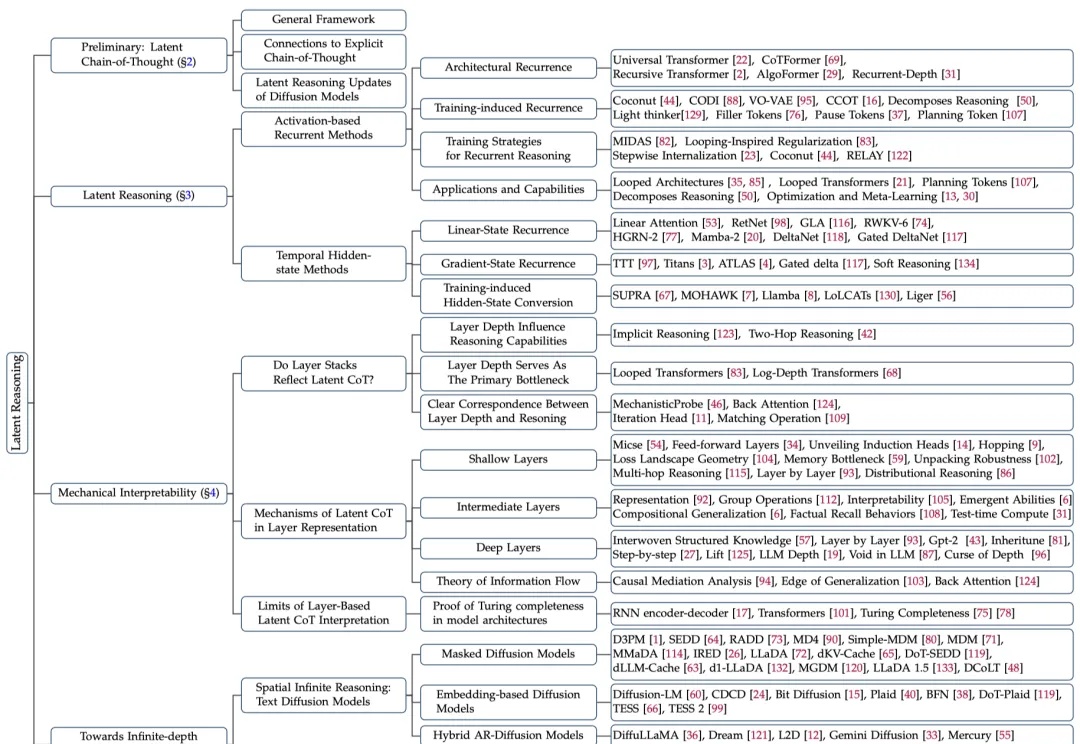

大模型在潜空间中推理,带宽能达到普通(显式)思维链(CoT)的2700多倍?

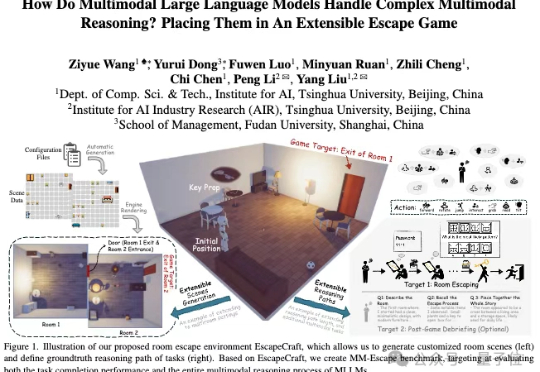

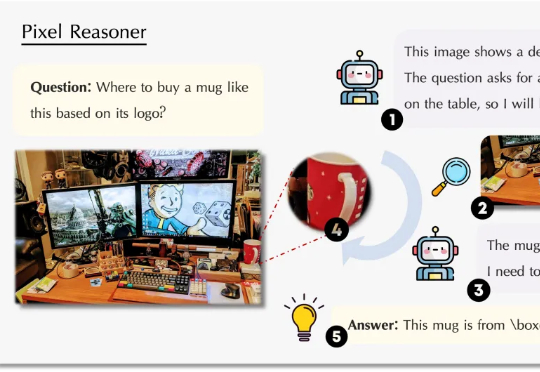

近年来,多模态大模型(MLLMs)发展迅猛,从看图说话到视频理解,似乎无所不能。

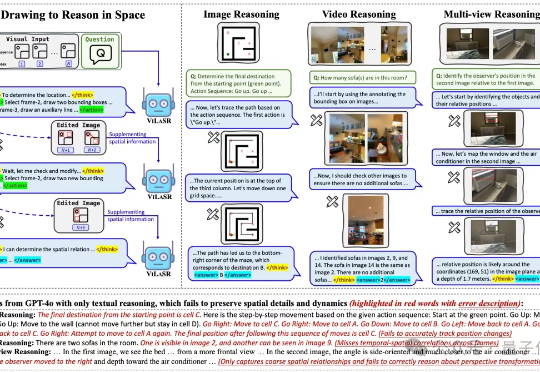

“边看边画,边画边想”,让大模型掌握空间思考能力,结果直接实现空间推理任务新SOTA。

视觉语言模型(VLM)正经历从「感知」到「认知」的关键跃迁。 当OpenAI的o3系列通过「图像思维」(Thinking with Images)让模型学会缩放、标记视觉区域时,我们看到了多模态交互的全新可能。

港中文和清华团队推出Video-R1模型,首次将强化学习的R1范式应用于视频推理领域。通过升级的T-GRPO算法和混合图像视频数据集,Video-R1在视频空间推理测试中超越了GPT-4o,展现了强大的推理能力,并且全部代码和数据集均已开源。

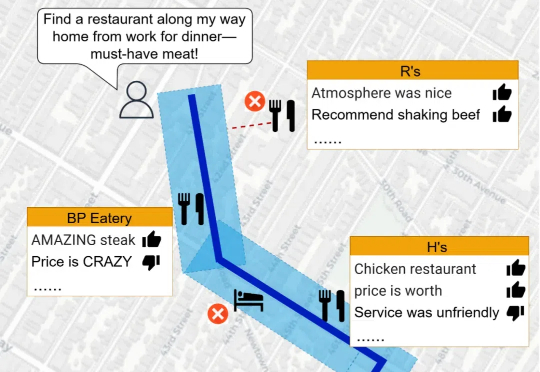

Spatial-RAG结合了空间数据库和大型语言模型(LLM)的能力,能够处理复杂的空间推理问题。通过稀疏和密集检索相结合的方式,Spatial-RAG可以高效地从空间数据库中检索出满足用户查询的空间对象,并利用LLM的语义理解能力对这些对象进行排序和生成最终答案。

当涉及到空间推理任务时,LLMs 的表现却显得力不从心。空间推理不仅要求模型理解复杂的空间关系,还需要结合地理数据和语义信息,生成准确的回答。为了突破这一瓶颈,研究人员推出了 Spatial Retrieval-Augmented Generation (Spatial-RAG)—— 一个革命性的框架,旨在增强 LLMs 在空间推理任务中的能力。

视觉语言模型虽然强大,但缺乏空间推理能力,最近 Google 的新论文说它的 SpatialVLM 可以做,看看他们是怎么做的。