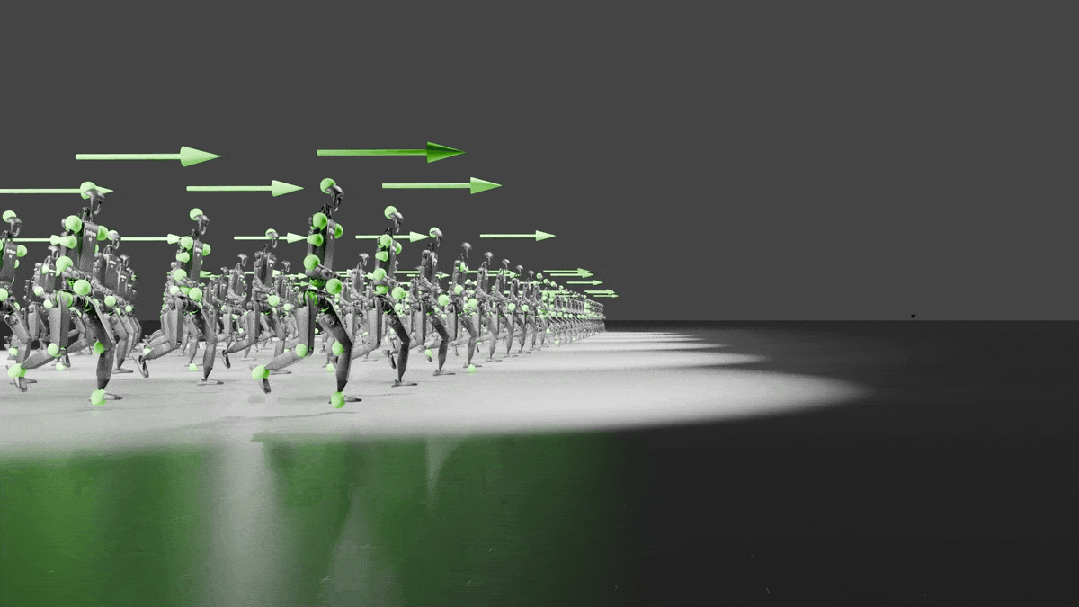

英伟达团队机器训练新方法!仅5次演示让机器生成1000个新demo,李飞飞高徒与徒孙联手出品

英伟达团队机器训练新方法!仅5次演示让机器生成1000个新demo,李飞飞高徒与徒孙联手出品人类只需要演示五次,就能让机器人学会一项复杂技能。英伟达实验室,提出了机器人训练数据缺乏问题的新解决方案——DexMimicGen。

人类只需要演示五次,就能让机器人学会一项复杂技能。英伟达实验室,提出了机器人训练数据缺乏问题的新解决方案——DexMimicGen。

双十一大促没有羊毛可薅?A800价格低至5.88元/卡时,H800价格低至9.99元/卡时。限量开抢,先到先得!还有充值返现活动:充5000返900,充3000返500,充1000返150。

AI技术日新月异,像Netflix这样的大公司已经开始用AI制作特效,而新的AI模型也在游戏和科学研究中超越了人类。未来一年,我们可能会看到没有编程技能的人也能创造热门应用,甚至AI创作的歌曲也可能登上音乐排行榜前十。

大模型固然性能强大,但限制也颇多。如果想在端侧塞进 405B 这种级别的大模型,那真是小庙供不起大菩萨。近段时间,小模型正在逐渐赢得人们更多关注。这一趋势不仅出现在语言模型领域,也出现在了机器人领域。

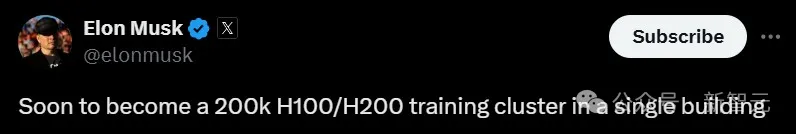

一文揭秘全球最大AI超算,解析液冷机架和网络系统的创新设计。这台全球最大AI超算Colossus由xAI和英伟达联手建造,耗资数十亿,10万块H100仅半个多月搭建完成,未来规模还将扩大一倍!

最近有一篇题为《2美元的H100:GPU泡沫是如何破灭的?》的文章异常火热,甚至投资人都认为英伟达坚挺的股价就是被这一篇文章所摧毁。

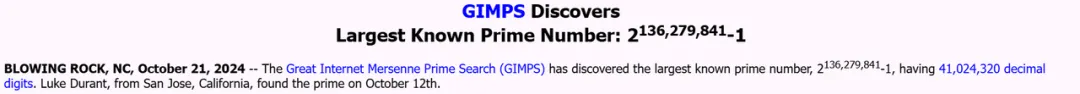

人类已知最大的素数,被GPU发现了!英伟达前员工Luke Durant发现的2136279841-1,比前一个纪录保持者多出1600万位,由A100计算,H100确认。为此,小哥搭了数千个GPU的「云超算」,分布在17个国家。

西部世界式的仿生机器人成真了?! 人造肌肉驱动下,这个名叫Torso的上半身机器人开始拱手作揖、前后左右咔咔转动脖子……

英伟达将携手Wipro、TCS和Infosys等印度IT巨头,合作开发全球性AI模型。

「我们的 Blackwell 芯片存在设计缺陷,虽然可以正常使用,但该设计缺陷导致良率低下,」黄仁勋表示。「这 100% 是英伟达的错。」