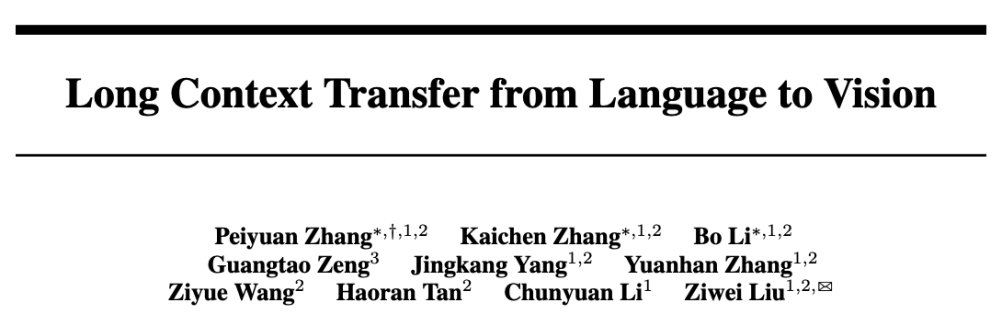

给视频模型安上快慢两只眼睛,苹果免训练新方法秒了一切SOTA

给视频模型安上快慢两只眼睛,苹果免训练新方法秒了一切SOTA自从 Sora 发布以来,AI 视频生成领域变得更加「热闹」了起来。过去几个月,我们见证了即梦、Runway Gen-3、Luma AI、快手可灵轮番炸场。

来自主题: AI技术研报

10047 点击 2024-08-11 13:18

自从 Sora 发布以来,AI 视频生成领域变得更加「热闹」了起来。过去几个月,我们见证了即梦、Runway Gen-3、Luma AI、快手可灵轮番炸场。

智谱AI把自研打造的大模型给开源了。

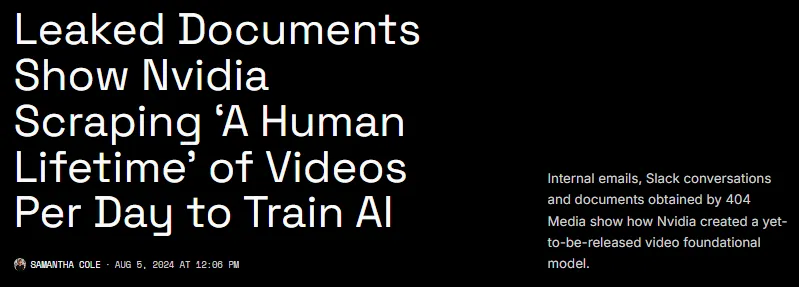

为了这个视频模型,英伟达每天正在疯狂地爬取相当于 80 年时长的视频数据。

国产版Sora真的卷疯了。

视频生成模型领域又多了一个重磅玩家。

40秒生成3D视频,Stability AI开源首个视频生视频模型。

近日,快手可灵大模型团队开源了名为LivePortrait的可控人像视频生成框架,该框架能够准确、实时地将驱动视频的表情、姿态迁移到静态或动态人像视频上,生成极具表现力的视频结果。

为什么说理解长视频难如 “大海捞针”?

快手祭出文生视频模型的的王炸,产品型创新能让快手领先多少?

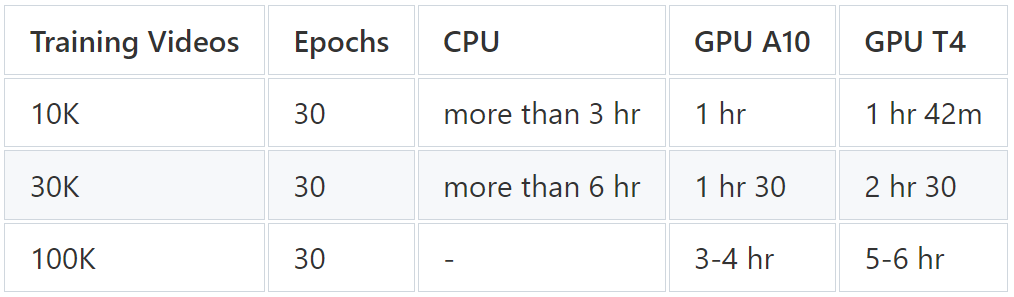

很翔实的一篇教程。