Pika 1.5重磅升级!万物皆可爆炸,搞笑特效全网病毒式疯传

Pika 1.5重磅升级!万物皆可爆炸,搞笑特效全网病毒式疯传时隔多月,斯坦福华人团队创办的 Pika 终于官宣 —— 新一代AI视频模型来了。

时隔多月,斯坦福华人团队创办的 Pika 终于官宣 —— 新一代AI视频模型来了。

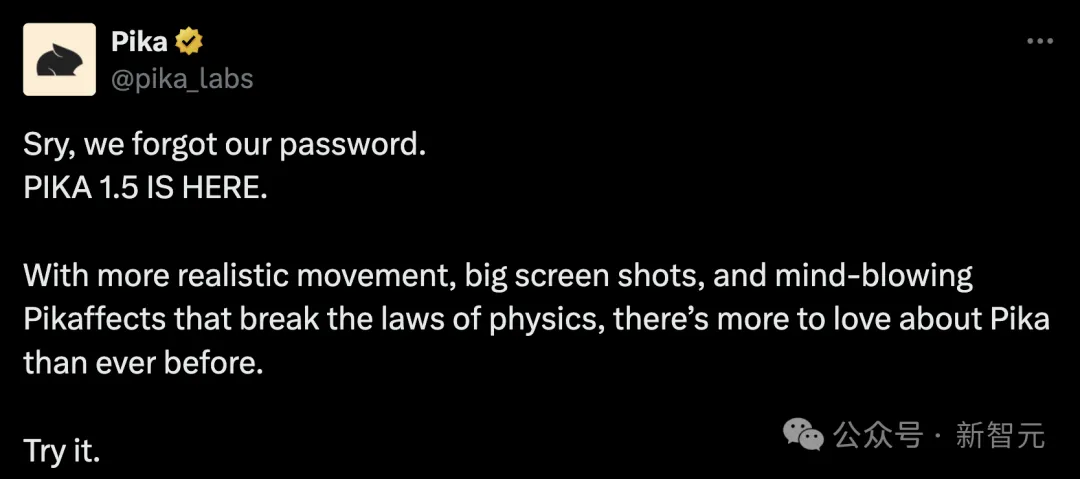

9月 24 日,字节跳动的豆包大模型发布多款新品——视频生成、音乐生成以及同声传译大模型。

这两天,最热闹的莫过于云栖大会了!

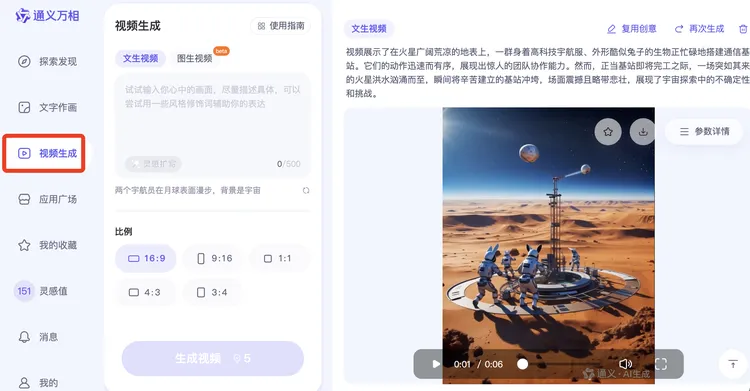

刚刚,智谱把清影背后的图生视频模型CogVideoX-5B-I2V给开源了!(在线可玩) 一起开源的还有它的标注模型cogvlm2-llama3-caption。

什么?大模型也许很快就能生成《黑神话·悟空》这种3A大作了?!直接看一则demo,《西游记》这就上桌

近期,来自字节跳动的视频生成模型 Loopy,一经发布就在 X 上引起了广泛的讨论。Loopy 可以仅仅通过一张图片和一段音频生成逼真的肖像视频,对声音中呼吸,叹气,挑眉等细节都能生成的非常自然,让网友直呼哈利波特的魔法也不过如此。

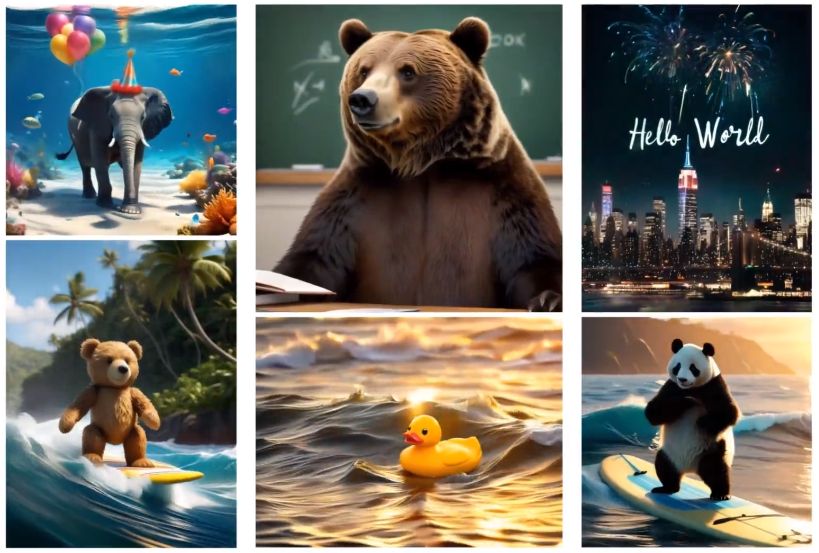

前几天 MiniMax 发布了海螺视频生成模型 abab-video-1,现场体验非常炸裂。很多朋友跑来问我,这个海螺视频模型和可灵的区别主要是什么?于是我做了一个短片,来从六个维度展现这两个视频模型的不同之处。一句话总结海螺视频就是:美学升级,运镜加分,表情丰富,文字突出。

继Sora、Runway之后,国内又一款AI视频生成模型来了!

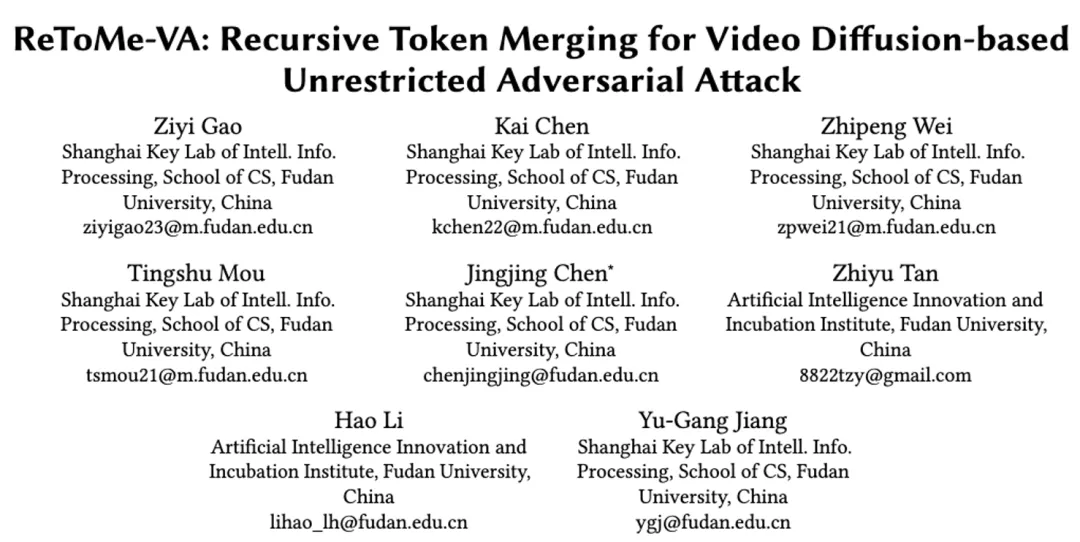

来自复旦大学视觉与学习实验室的研究者们提出了一种新型的面向视频模型的对抗攻击方法 - 基于扩散模型的视频非限制迁移攻击(ReToMe-VA)。该方法采用逐时间步对抗隐变量优化策略,以实现生成对抗样本的空间不可感知性;同时,在生成对抗帧的去噪过程中引入了递归 token 合并策略,通过匹配及合并视频帧之间的自注意力 token,显著提升了对抗视频的迁移性和时序一致性。

近日,开源社区又迎来一款强力的「视频生成」工作,可以在消费级显卡 (如 GeForce RTX 3090) 上生成任意分辨率、任意宽高比、不同风格、不同运动幅度的视频,其衍生模型还能够完成视频扩展、视频回溯的功能…… 这便是 360AI 团队和中山大学联合研发的 FancyVideo,一种基于 UNet 架构的视频生成模型。